Intelligenza Artificiale

Alterazione delle emozioni nelle riprese video con l'intelligenza artificiale

Ricercatori provenienti da Grecia e Regno Unito hanno sviluppato un nuovo approccio di apprendimento profondo per modificare le espressioni e l'umore apparente delle persone nelle riprese video, preservando la fedeltà dei loro movimenti delle labbra all'audio originale in un modo che i tentativi precedenti non sono stati in grado di eguagliare .

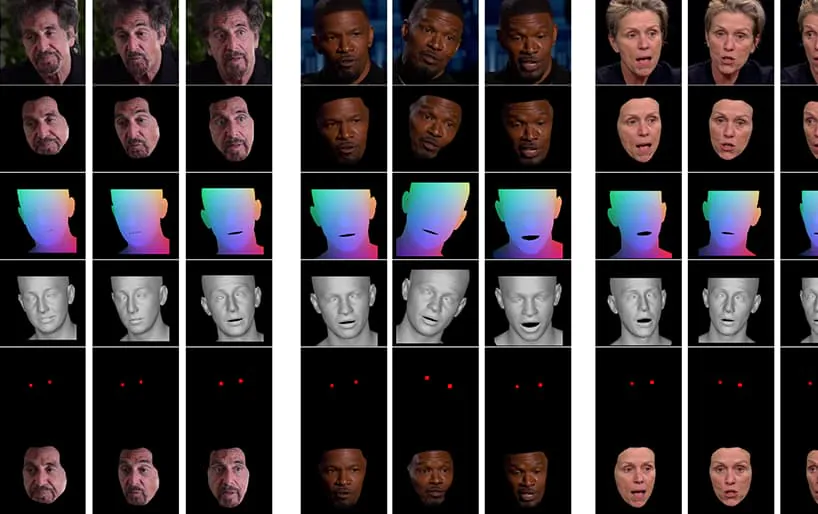

Dal video allegato all'articolo (incorporato alla fine di questo articolo), una breve clip dell'attore Al Pacino la cui espressione viene sottilmente alterata dalla NED, basata su concetti semantici di alto livello che definiscono le singole espressioni facciali e le emozioni ad esse associate. Il metodo "Reference-Driven" sulla destra prende le emozioni interpretate di un video sorgente e le applica all'intera sequenza video. Fonte: https://www.youtube.com/watch?v=Li6W8pRDMJQ

Questo particolare campo rientra nella crescente categoria di emozioni deepfaked, in cui l'identità del parlante originale viene preservata, ma le sue espressioni e microespressioni vengono alterate. Con il progredire di questa particolare tecnologia di intelligenza artificiale, si offre alle produzioni cinematografiche e televisive la possibilità di apportare sottili modifiche alle espressioni degli attori, ma si apre anche una categoria piuttosto nuova di deepfake video "alterati dalle emozioni".

Cambiando volti

Le espressioni facciali delle figure pubbliche, come i politici, sono rigorosamente curate; nel 2016 le espressioni facciali di Hillary Clinton sono arrivate sotto l'intenso controllo mediatico per il loro potenziale impatto negativo sulle sue prospettive elettorali; anche le espressioni facciali, a quanto pare, sono a argomento di interesse all'FBI; e sono un indicatore critico nei colloqui di lavoro, rendendo la prospettiva (lontana) di un filtro di "controllo delle espressioni" in tempo reale uno sviluppo auspicabile per chi cerca lavoro e cerca di superare un pre-screening su Zoom.

Uno studio del 2005 dal Regno Unito ha affermato che l'aspetto del viso influisce sulle decisioni di voto, mentre un servizio del Washington Post del 2019 ha esaminato il utilizzo della condivisione di videoclip "fuori contesto", che attualmente è la cosa più vicina che i sostenitori di notizie false devono effettivamente essere in grado di cambiare il modo in cui un personaggio pubblico sembra comportarsi, rispondere o sentire.

Verso la manipolazione dell'espressione neurale

Al momento, lo stato dell'arte nella manipolazione dell'affetto facciale è piuttosto rudimentale, poiché implica affrontare il sbrogliamento di concetti di alto livello (es triste, arrabbiato, contento, sorridente) dai contenuti video effettivi. Sebbene le tradizionali architetture deepfake sembrino raggiungere abbastanza bene questo districamento, rispecchiare le emozioni attraverso identità diverse richiede ancora che due set di volti di addestramento contengano espressioni corrispondenti per ciascuna identità.

Esempi tipici di immagini facciali nei set di dati utilizzati per addestrare i deepfake. Attualmente, è possibile manipolare l'espressione facciale di una persona solo creando percorsi espressione-espressione specifici per ID in una rete neurale deepfake. Il software deepfake del 2017 non ha una comprensione semantica intrinseca di un "sorriso": si limita a mappare e confrontare i cambiamenti percepiti nella geometria facciale dei due soggetti.

Ciò che è auspicabile, e non è stato ancora perfettamente raggiunto, è riconoscere come sorride il soggetto B (ad esempio) e semplicemente creare un 'sorriso' cambiare l'architettura, senza bisogno di mapparla a un'immagine equivalente del soggetto A sorridente.

. nuovo documento è intitolato Neural Emotion Director: controllo semantico delle espressioni facciali che preserva il parlato nei video "in-the-wild"., e proviene da ricercatori della School of Electrical & Computer Engineering presso l'Università tecnica nazionale di Atene, dell'Institute of Computer Science presso la Foundation for Research and Technology Hellas (FORTH) e del College of Engineering, Mathematics and Physical Sciences presso il Università di Exeter nel Regno Unito.

Il team ha sviluppato un framework chiamato Direttore delle emozioni neurali (NED), che incorpora una rete di traduzione delle emozioni basata su 3D, Manipolatore di emozioni basato su 3D.

NED prende una sequenza ricevuta di parametri di espressione e li traduce in un dominio target. Viene addestrato su dati non paralleli, il che significa che non è necessario addestrarlo su set di dati in cui ogni identità ha espressioni facciali corrispondenti.

Il video, mostrato alla fine di questo articolo, ripercorre una serie di test in cui NED impone uno stato emotivo apparente al filmato del set di dati di YouTube.

Gli autori sostengono che NED è il primo metodo basato su video per "dirigere" gli attori in situazioni casuali e imprevedibili e hanno reso il codice disponibile su NED pagina del progetto.

Metodo e architettura

Il sistema è addestrato su due grandi set di dati video annotati con etichette "emozione".

L'output è abilitato da un renderer di volti video che riproduce l'emozione desiderata su video utilizzando le tradizionali tecniche di sintesi dell'immagine facciale, tra cui la segmentazione del viso, l'allineamento e la fusione dei punti di riferimento del viso, in cui viene sintetizzata solo l'area del viso e quindi applicata al filmato originale.

L'architettura per la pipeline del Neural Emotion Detector (NED). Fonte: https://arxiv.org/pdf/2112.00585.pdf

Inizialmente, il sistema ottiene il recupero facciale 3D e impone allineamenti dei punti di riferimento facciali sui frame di input per identificare l'espressione. Successivamente, i parametri di espressione recuperati vengono trasmessi al Manipolatore Emozionale 3D e un vettore di stile viene calcolato tramite un'etichetta semantica (ad esempio "felice") o un file di riferimento.

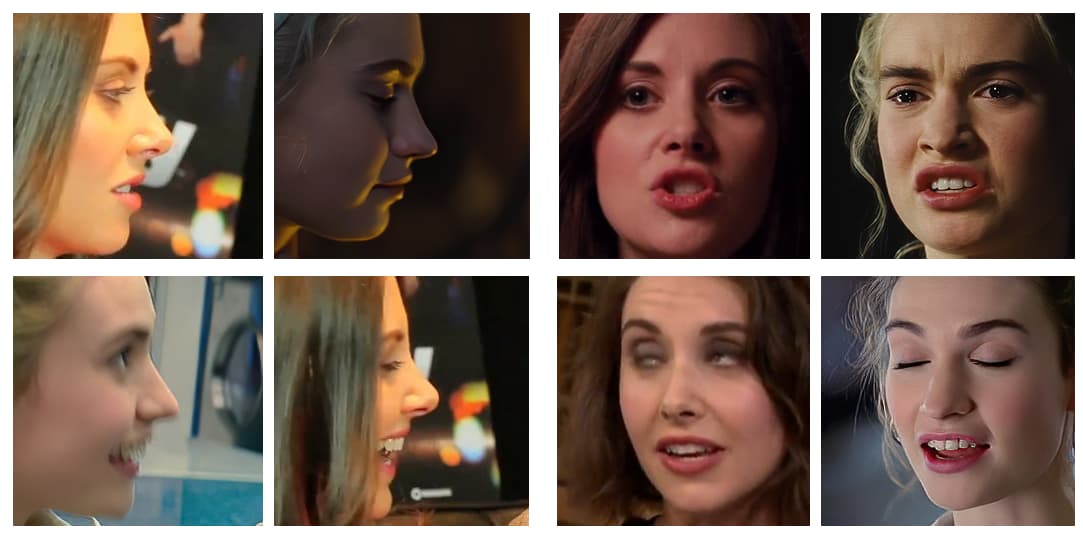

Un file di riferimento è un video che ritrae una particolare espressione/emozione riconosciuta, che viene poi imposta sull'intero video di destinazione, sostituendo l'espressione originale.

Fasi nella pipeline di trasferimento delle emozioni, con vari attori campionati dai video di YouTube.

La forma del viso 3D finale generata viene quindi concatenata con la Normalized Mean Face Coordinate (NMFC) e le immagini dell'occhio (i punti rossi nell'immagine sopra) e passata al renderer neurale, che esegue la manipolazione finale.

Risultati

I ricercatori hanno condotto studi approfonditi, inclusi studi sugli utenti e sull'ablazione, per valutare l'efficacia del metodo rispetto al lavoro precedente e hanno scoperto che nella maggior parte delle categorie, il NED supera l'attuale stato dell'arte in questo sottosettore della manipolazione facciale neurale.

Gli autori dell'articolo prevedono che le future implementazioni di questo lavoro e di strumenti di natura simile saranno utili principalmente nei settori televisivo e cinematografico, affermando:

"Il nostro metodo apre una miriade di nuove possibilità per applicazioni utili delle tecnologie di rendering neurale, che spaziano dalla post-produzione cinematografica e dai videogiochi agli avatar affettivi fotorealistici".

Si tratta di uno dei primi lavori in questo campo, ma uno dei primi a tentare la rievocazione facciale tramite video anziché immagini fisse. Sebbene i video siano essenzialmente costituiti da una serie di immagini fisse che si susseguono a velocità elevata, ci sono considerazioni temporali che rendono le precedenti applicazioni del trasferimento delle emozioni meno efficaci. Nel video allegato e negli esempi presenti nell'articolo, gli autori includono confronti visivi tra l'output di NED e altri metodi recenti comparabili.

Confronti più dettagliati e molti altri esempi di NED possono essere trovati nel video completo qui sotto:

3 dicembre 2021, 18:30 GMT+2 – Su richiesta di uno degli autori dell'articolo, sono state apportate delle correzioni al "file di riferimento", che ho erroneamente indicato come una foto (quando in realtà è un videoclip). È stata inoltre modificata la denominazione dell'Istituto di Informatica presso la Fondazione per la Ricerca e la Tecnologia.

3 dicembre 2021, 20:50 GMT+2 – Una seconda richiesta da parte di uno degli autori del documento per un'ulteriore modifica del nome dell'istituzione sopra menzionata.