Andersonin kulma

Dialogin lisääminen oikeaan videoon tekoälyn avulla

Uusi tekoälykehys voi kirjoittaa uudelleen, poistaa tai lisätä henkilön sanoja videossa ilman uudelleenkuvausta yhdessä kokonaisvaltaisessa järjestelmässä.

Kolme vuotta sitten internet olisi ollut ällistynyt mistä tahansa niistä 20–30 tekoälyyn perustuvasta videonmuokkauskehyksestä, joita julkaistaan viikoittain akateemisissa portaaleissa. Nykyään tästä suositusta tutkimuslinjasta on tullut niin tuottelias, että se melkein muodostaa uuden haaran "tekoälytyötä", ja käsittelen paljon vähemmän tällaisia julkaisuja kuin kaksi tai kolme vuotta sitten.

Yksi tämän sarjan uusin julkaisu kuitenkin kiinnitti huomioni: integroitu järjestelmä, joka voi puuttua oikeisiin videoleikkeisiin ja lisätä uutta puhetta olemassa olevaan videoon (sen sijaan, että luotaisiin kokonainen generatiivinen leike kasvoista tai kuvasta, mikä on paljon yleisempää).

Alla olevissa esimerkeissä, jotka editoin julkaisun yhteydessä saatavilla olevista lukuisista esimerkkivideoista hankkeen verkkosivuilla, näemme ensin varsinaisen lähdeklipin ja sitten sen alla klipin keskellä olevan tekoälyn puheen, joka sisältää äänisynteesin ja huulten synkronoinnin:

Klikkaa pelataksesi. Paikallinen editointi stitching-toiminnolla – yksi FaceEDiT:n tarjoamista menetelmistä. Paremman resoluution saamiseksi katso lähdesivusto. Lähde – https://facedit.github.io/

Tämä lähestymistapa on yksi uudelle menetelmälle kehitetyistä kolmesta lähestymistavasta. Tämän nimi on "paikallinen editointi ompelemalla", ja se kiinnostaa kirjoittajia (sekä minua) eniten. Pohjimmiltaan klippiä laajennetaan käyttämällä yhtä keskimmäisistä kehyksistä lähtökohtana uudelle tekoälytulkinnalle ja sen seuraavaa (todellista) kehystä tavoitteena, johon generatiivisesti lisätyn klipin tulisi pyrkiä vastaamaan. Yllä olevissa klipeissä näitä "siemen"- ja "kohde"-kehyksiä edustaa ylin videotauko, kun taas alla oleva muokattu video tarjoaa generatiivista täyttöä.

Kirjoittajat kuvailevat tätä kasvojen ja äänen synteesimenetelmää ensimmäiseksi täysin integroiduksi kokonaisvaltaiseksi menetelmäksi tekoälyllä toteutetuille videoeditoinneille ja tarkastelevat täysin kehittyneen kehyksen potentiaalia TV- ja elokuvatuotannossa:

Elokuvantekijöiden ja mediatuottajien on usein tarkistettava tallennettujen videoiden tiettyjä osia – ehkä jokin sana on lausuttu väärin tai käsikirjoitusta on muutettu kuvaamisen jälkeen. Esimerkiksi ikonisessa kohtauksessa… Titaanimainen (1997), jossa Rose sanoo, "En koskaan päästä irti, Jack" ohjaaja saattaa myöhemmin päättää, että sen pitäisi olla "En koskaan unohda sinua, Jack".

"Perinteisesti tällaiset muutokset edellyttävät koko kohtauksen uudelleenkuvaamista, mikä on kallista ja aikaa vievää. Puhuvien kasvojen synteesi tarjoaa käytännöllisen vaihtoehdon muokkaamalla kasvojen liikkeitä automaattisesti vastaamaan muokattua puhetta, mikä poistaa uudelleenkuvausten tarpeen."

Vaikka tällaiset tekoälyn interventiot voivat kohdata kulttuurinen Tai alan vastustuksesta huolimatta ne voivat myös muodostaa uudenlaisen toiminnallisuuden ihmisen johtamissa visuaalitehostejärjestelmissä ja työkalupaketeissa. Joka tapauksessa tällä hetkellä haasteet ovat puhtaasti teknisiä.

Sen lisäksi, että uusi järjestelmä laajentaa klipin tekoälyn luomalla lisädialogilla, se voi myös muuttaa olemassa olevaa puhetta:

Klikkaa pelataksesi. Esimerkki olemassa olevan dialogin muuttamisesta uuden dialogin lisäämisen sijaan. Katso lähdesivustolta parempi resoluutio.

Taiteen tila

Tällä hetkellä ei ole olemassa kokonaisvaltaisia järjestelmiä, jotka tarjoaisivat tällaista synteesikykyä; vaikka yhä useammat generatiiviset tekoälyalustat, kuten Googlen Veo-sarja, voi luoda ääntä, ja erilaiset muut kehykset voivat luoda syväväärennetty ääni, on tällä hetkellä luotava melko monimutkainen prosessi, jossa on erilaisia arkkitehtuureja ja temppuja, jotta voidaan häiritä todellista kuvamateriaalia uuden järjestelmän – nimeltään FaceEDiT – voi suorittaa.

Järjestelmä käyttää Diffuusiomuuntajat (DiT) yhdessä Flow Matching luoda kasvojen liikkeitä, jotka on ehdollistettu ympäröivien (kontekstiin liittyvien) liikkeiden ja puheäänisisällön perusteella. Järjestelmä hyödyntää olemassa olevia suosittuja kasvojen rekonstruktioon liittyviä paketteja, mukaan lukien LivePortrait (Kling otti hiljattain haltuunsa).

Tämän menetelmän lisäksi, koska heidän lähestymistapansa on ensimmäinen, joka yhdistää nämä haasteet yhdeksi ratkaisuksi, kirjoittajat ovat luoneet uuden vertailuarvon nimeltä FaceEDiTBenchsekä useita täysin uusia arviointimittareita, jotka sopivat juuri tähän erityistehtävään.

RFID lukija NFC lukija uutta työtä on otsikko FaceEDiT: Yhtenäinen puhuvien kasvojen muokkaus ja luominen kasvojen liikkeen täyttämisen avulla, ja se on peräisin neljältä tutkijalta Korean Pohangin tiede- ja teknologiayliopistosta (POSTECH), Korean edistyneestä tiede- ja teknologiainstituutista (KAIST) ja Texasin yliopistosta Austinissa.

Menetelmä

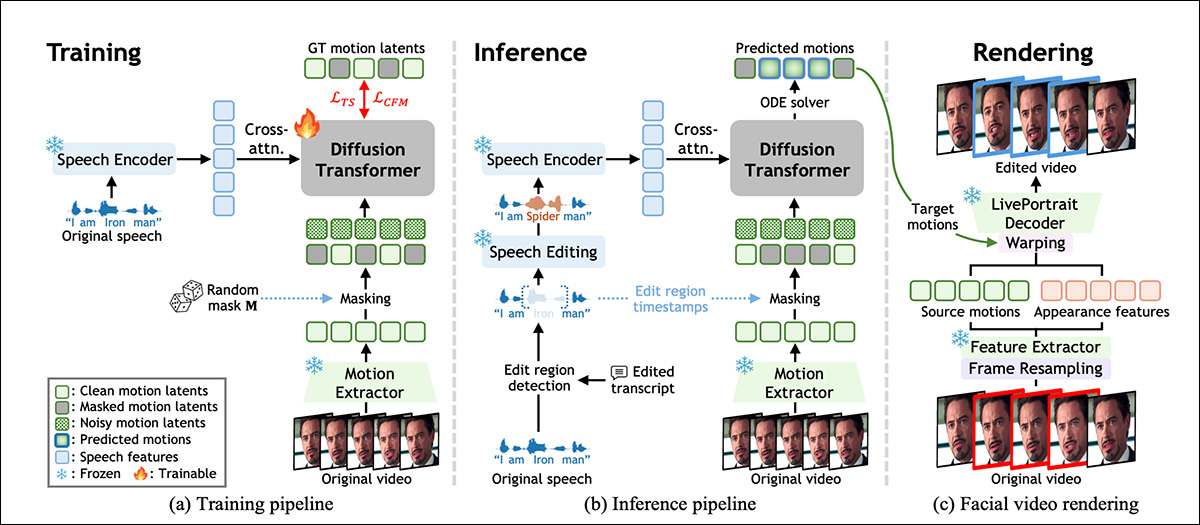

FaceDiT on opetettu rekonstruoimaan kasvojen liikkeitä oppimalla täyttämään näyttelijän alkuperäisen esityksen puuttuvat osat ympäröivän liikkeen ja puheäänen perusteella. Kuten alla olevassa kaaviossa on esitetty, tämä prosessi mahdollistaa mallin toiminnan aukkojen täyttäjänä opetuksen aikana ennustamalla ääntä vastaavia kasvojen liikkeitä pysyen samalla yhdenmukaisina alkuperäisen videon kanssa:

Yleiskatsaus FacEDiT-järjestelmään, joka näyttää, miten kasvojen liikkeet opitaan itseohjatun täydennyksen avulla harjoittelun aikana, miten ne ohjataan muokatun puheen avulla päättelyn aikana ja lopulta renderöidään takaisin videolle käyttämällä uudelleen alkuperäisen videomateriaalin ulkonäköä ja korvaamalla vain kohdennetun liikkeen. Lähde

Päättelyhetkellä sama arkkitehtuuri tukee kahta eri tuotostetta riippuen siitä, kuinka paljon videosta on maskattu: osittaisia editointia, joissa vain yhtä lausetta muutetaan ja loput jätetään koskemattomaksi; tai kokonaisten lauseiden generointia, jossa uusi liike syntetisoidaan kokonaan alusta.

Malli on koulutettu kautta virtauksen sovitus, joka käsittelee videoeditointia eräänlaisena polkuna kahden kasvojen liikkeen version välillä.

Sen sijaan, että flow-matching-toiminto oppisi arvaamaan, miltä muokatun kasvon tulisi näyttää tyhjästä, se oppii liikkumaan vähitellen ja sujuvasti kohinaisen paikkamerkin ja oikean liikkeen välillä. Tämän helpottamiseksi järjestelmä esittää kasvojen liikkeen kompaktina numerosarjana, joka on poimittu kustakin kuvasta käyttämällä edellä mainitun LivePortrait-järjestelmän versiota (katso yllä oleva kaavio).

Nämä liikevektorit on suunniteltu kuvaamaan ilmeitä ja pään asentoa ilman sotkeutuminen identiteetti, jotta puheen muutokset voidaan lokalisoida vaikuttamatta henkilön yleisilmeeseen.

FaceEDiT-koulutus

FaceEDiT:n kouluttamiseksi jokainen videoleike jaettiin sarjaan kasvojen liikkeitä kuvaavia tilannekuvia, ja jokainen ruutu yhdistettiin vastaavaan äänitiedostoon. Liikedatan satunnaiset osat piilotettiin, ja mallia pyydettiin arvaamaan, miltä puuttuvien liikkeiden tulisi näyttää, käyttäen sekä puhetta että ympäröivää paljastamatonta liikettä kontekstina.

Koska maskatut jännevälit ja niiden sijainnit vaihtelevat harjoitusesimerkistä toiseen, malli oppii vähitellen käsittelemään sekä pieniä sisäisiä muokkauksia että pidempiä aukkoja koko sekvenssin generoimiseksi sen mukaan, kuinka paljon tietoa sille annetaan.

Järjestelmän edellä mainittu diffuusiomuuntaja oppii palauttamaan peitetyn liikkeen jalostamalla kohinaisia syötteitä ajan kuluessa. Sen sijaan, että puhe ja liike syötettäisiin malliin kerralla, ääni ketjutetaan jokaiseen prosessointilohkoon seuraavien menetelmien avulla: ristiin huomiota, auttaen järjestelmää sovittamaan huulten liikkeet tarkemmin äänipuheeseen.

Realismin säilyttämiseksi editointien välillä huomio kohdistuu viereisiin kehyksiin koko aikajanan sijaan, mikä pakottaa mallin keskittymään paikalliseen jatkuvuuteen ja estää välkkymistä tai liikehyppyjä muutettujen alueiden reunoilla. Paikalliset upotukset (jotka kertovat mallille, missä kukin kehys sijaitsee sekvenssissä) auttavat mallia ylläpitämään luonnollista ajallista virtausta ja kontekstia.

Koulutuksen aikana järjestelmä oppii ennustamaan puuttuvaa kasvojen liikettä rekonstruoimalla peitettyjä alueita puheen ja lähellä olevan paljastavan liikkeen perusteella. Päättelyn aikana samaa järjestelmää käytetään uudelleen, mutta nyt peitteitä ohjataan puheen muokkausten avulla.

Kun sana tai lause lisätään, poistetaan tai muutetaan, järjestelmä paikantaa muuttuneen alueen, peittää sen ja luo uudelleen uutta ääntä vastaavan liikkeen. Täyden sekvenssin generointia käsitellään erikoistapauksena, jossa koko alue peitetään ja syntetisoidaan alusta alkaen.

Tiedot ja testit

Järjestelmän runko koostuu 22 diffuusiomuuntajakerroksesta, joissa kussakin on 16 huomiopäät ja eteenpäin syötetyillä mitoilla 1024 ja 2024 pikseliä. Liike- ja ulkonäköominaisuudet erotetaan käyttämällä jäädytetty LivePortrait-komponentit ja niiden kautta koodattu puhe WavLM ja muokattu käyttämällä VoiceCraft.

Erillinen projektiokerros kuvaa 786-ulotteiset puheominaisuudet DiT:n latenttiavaruuteen, ja vain DiT ja projektiomoduulit koulutetaan alusta alkaen.

Koulutus suoritettiin alaisuudessa AdamW optimoija tavoitetulla oppimisnopeudella 1e‑4 miljoonalla askeleella kahdella A6000-näytönohjaimella (kummassakin 48 Gt VRAM-muistia), yhteensä erän koko kahdeksasta.

FaceEDiTBench

FacediTBench-aineisto sisältää 250 esimerkkiä, joista jokaisessa on videoleike alkuperäisestä ja editoidusta puheesta sekä molempien litteroinnit. Videot ovat peräisin kolmesta lähteestä, joista 100 on peräisin HDTF, 100 lähettäjältä Hallo 3ja 50 alkaen CelebV-DubJokainen tarkastettiin manuaalisesti sen varmistamiseksi, että sekä ääni että video olivat riittävän selkeitä arviointia varten.

GPT-4o käytettiin jokaisen litteroinnin tarkistamiseen kieliopillisesti pätevien muokkausten luomiseksi. Nämä tarkistetut litteroinnit ja alkuperäinen puhe lähetettiin VoiceCraftille uuden äänitteen tuottamiseksi; ja jokaisessa vaiheessa sekä litterointi että luotu puhe tarkistettiin manuaalisesti laadun varmistamiseksi.

Jokainen näyte merkittiin muokkauksen tyypillä, muutoksen ajoituksella ja muokatun ajanjakson pituudella, ja muokkaukset luokiteltiin seuraavasti: lisäykset, poistottai vaihdotMuutettujen sanojen määrä vaihteli lyhyistä 1–3 sanan muokkauksista, keskipitkistä 4–6 sanan muokkauksista ja pidemmistä 7–10 sanan muokkauksista.

Muokkauksen laadun arvioimiseksi määriteltiin kolme mukautettua mittaria. Fotometrinen jatkuvuus, mitatakseen, kuinka hyvin muokatun segmentin valaistus ja väri sulautuvat ympäröivään videoon, vertaamalla pikselitason eroja rajoilla; liikkeen jatkuvuus, arvioida kasvojen liikkeen yhdenmukaisuutta mittaamalla optisen virtauksen muutoksia editoitujen ja editoimattomien kuvien välillä; ja identiteetin säilyttäminen, arvioidakseen, pysyykö kohteen ulkonäkö samana editoinnin jälkeen, vertaamalla alkuperäisten ja luotujen sekvenssien kasvojen upotuksia käyttämällä ArcFace kasvojentunnistusmalli.

Testit

Testausmallia koulutettiin kolmen edellä mainitun datajoukon materiaalilla, jotka käsittivät yhteensä noin 200 tuntia videomateriaalia, mukaan lukien vlogeja ja elokuvia sekä korkearesoluutioisia YouTube-videoita.

Puhuvien kasvojen editoinnin arvioimiseksi käytettiin FaceEDiTBenchiä HDTF-testiosuuden lisäksi, josta on tullut tämän tehtäväkokonaisuuden vertailustandardi.

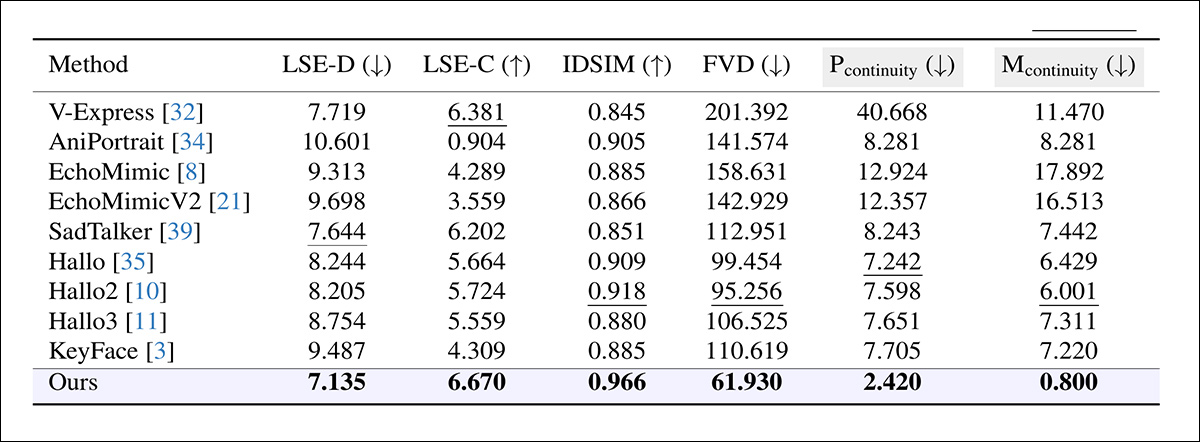

Koska ei ollut olemassa suoraan vertailukelpoisia järjestelmiä, jotka kykenisivät kapseloimaan tällaista kokonaisvaltaista toiminnallisuutta, kirjoittajat valitsivat useita kehyksiä, jotka toistivat ainakin osan tavoitetoiminnallisuudesta ja voisivat toimia lähtökohtana; nimittäin, KeyFace; KaikuMimiikka; EchoMimicV2; Hei; Hallo 2; Hallo 3; V-Express; AniPortrait, Ja SurullinenTalkkuja.

Useita vakiintuneita mittareita käytettiin myös luonnin ja editoinnin laadun arvioimiseen, ja huulisynkronoinnin tarkkuutta arvioitiin SyncNet, raportoiden sekä huulten liikkeiden ja äänen välisen absoluuttisen virheen (LSE-D) että luottamuspistemäärän (LSE-C); Fréchet Video Distance (FVD) videon kokonaisuudessaan realistiselta näyttämisen kvantifiointi; ja Oppineet havainnon samankaltaisuusmittarit (LPIPS), joka mittaa luotujen ja alkuperäisten kehysten välistä havaintokykyyn perustuvaa samankaltaisuutta.

Editointia varten kaikkia mittareita LPIPS:ää lukuun ottamatta sovellettiin vain muokattuun segmenttiin; luontia varten koko video arvioitiin ilman rajojen jatkuvuutta.

Jokainen malli tehtiin syntetisoimaan vastaava videosegmentti, joka sitten liitettiin alkuperäiseen leikkeeseen (tutkijat huomauttavat, että tämä menetelmä aiheutti usein näkyviä epäjatkuvuuksia, joissa editoitu osa kohtasi ympäröivän materiaalin). Testattiin myös toista lähestymistapaa, jossa koko video luotiin uudelleen muokatusta äänestä – mutta tämä väistämättä korvasi editoimattomat alueet eikä säilyttänyt alkuperäistä suorituskykyä:

Muokkauksen suorituskyvyn vertailu eri järjestelmissä, jotka alun perin suunniteltiin puhuvien kasvojen luomiseen. FaceEDiT suoriutui paremmin kaikissa mittareissa, saavuttaen pienemmän huulten synkronointivirheen (LSE-D), korkeamman synkronointivarmuuden (LSE-C), vahvemman identiteetin säilymisen (IDSIM), paremman havaintokyvyn realismin (FVD) ja sulavammat siirtymät muokkausrajojen yli (Pcontinuity, Mcontinuity). Harmaalla varjostetut sarakkeet korostavat keskeisiä kriteerejä rajojen laadun arvioinnissa; lihavoidut ja alleviivatut arvot osoittavat parhaat ja toiseksi parhaat tulokset.

Näistä tuloksista kirjoittajat kommentoivat seuraavaa:

”[Mallimme] suoriutuu merkittävästi nykyisiä menetelmiä paremmin editointitehtävässä. Se saavuttaa vahvan rajojen jatkuvuuden ja korkean identiteetin säilymisen, mikä osoittaa sen kyvyn ylläpitää ajallista ja visuaalista yhtenäisyyttä editoinnin aikana. Lisäksi sen erinomainen huulten synkronoinnin tarkkuus ja alhainen FVD heijastavat syntetisoidun videon realismia.”

Klikkaa pelataksesi. Tulokset, jotka tämä kirjoittaja on koonnut tukemalla projektisivustolla julkaistuista videoista. Paremman resoluution saamiseksi katso lähdesivusto.

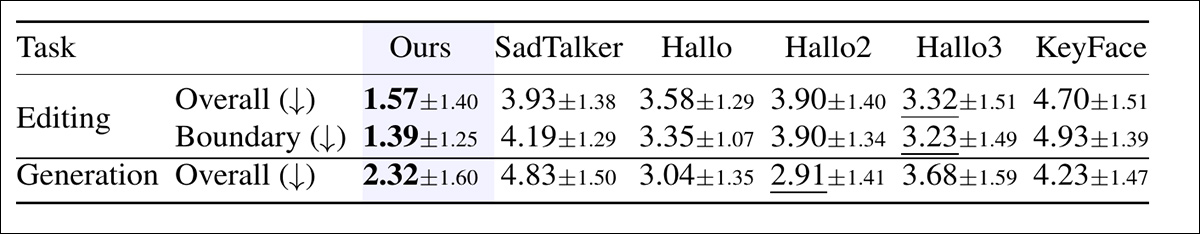

Lisäksi tehtiin ihmiskoe, jossa arvioitiin havaittua laatua sekä editoinnissa että luonnissa.

Jokaista vertailua varten osallistujat katsoivat kuusi videota ja asettivat ne paremmuusjärjestykseen kokonaislaadun perusteella ottaen huomioon huulten synkronoinnin tarkkuuden, luonnollisuuden ja pään liikkeen realismin. Editointikokeissa osallistujat arvioivat myös editoitujen ja editoimattomien segmenttien välisten siirtymien sujuvuutta:

Ihmisarvioijien antamat keskimääräiset sijoitukset, joissa alempi tarkoittaa parempaa. Sekä editoinnissa että luonnissa osallistujat arvioivat, kuinka luonnolliselta ja synkronoitulta kukin video näytti. Editoinnissa he arvioivat myös, kuinka sujuvaa siirtymä editoidun ja editoimattoman puheen välillä oli. Lihavoidut ja alleviivatut numerot osoittavat kaksi parasta pistemäärää.

Tutkimuksessa FaceEDiT sijoittui jatkuvasti parhaaksi ja oli selkeästi eturintamassa sekä editoinnin laadussa että saumattomassa siirtymässä. Se sai myös vahvat pisteet luontiasetuksessa, mikä viittaa siihen, että sen mitatut edut näkyvät havainnollisesti mieluummin tavoiteltuina tuotoksina.

Tilanpuutteen vuoksi ohjaamme lukijan tutustumaan lähdejulkaisuun saadaksesi lisätietoja ablaatiotutkimuksista ja uudessa työssä suoritetuista ja raportoiduista lisätesteistä. Totuus on, että tämänkaltaisilla prototyyppisillä tutkimustarjouksilla on vaikeuksia tuottaa mielekkäitä testitulososioita, koska ydinosa itsessään on väistämättä potentiaalinen lähtökohta myöhemmälle työlle.

Yhteenveto

Jopa päättelyn osalta tällaiset järjestelmät saattavat vaatia merkittäviä laskentaresursseja päättelyn aikana, mikä vaikeuttaa jatkokäyttäjien – tässä tapauksessa oletettavasti VFX-pajojen – työn pitämistä paikallisesti. Siksi palveluntarjoajat, joilla on lakisääteinen velvollisuus suojata asiakkaan kuvamateriaalia ja yleistä immateriaalioikeutta, suosivat aina lähestymistapoja, jotka voidaan mukauttaa realistisiin paikallisiin resursseihin.

Tämä ei tarkoita uuden tarjonnan kritisointia, joka saattaa hyvinkin toimia täydellisesti kvantisoitujen painojen tai muiden optimointien avulla, ja joka on ensimmäinen laatuaan oleva tarjous, joka houkuttelee minut takaisin tämän tutkimussuunnan pariin jo pitkään aikaan.

Julkaistu ensimmäisen kerran keskiviikkona 17. joulukuuta 202. Muokattu samana päivänä klo 20.10 Suomen aikaa ensimmäisen kappaleen lisätilan vuoksi.