Künstliche Intelligenz

Forscher schaffen Alternative zur GPU

Informatiker der Rice University haben zusammen mit Mitarbeitern von Intel eine kostengünstigere Alternative zur GPU entwickelt. Der neue Algorithmus heißt „Sublinear Deep Learning Engine“ (SLIDE) und verwendet Allzweck-Zentraleinheiten (CPUs) ohne spezielle Beschleunigungshardware.

Die Ergebnisse wurden im Austin Convention Center präsentiert, wo die Konferenz über maschinelle Lernsysteme MLSys stattfindet.

Eine der größten Herausforderungen im Bereich der künstlichen Intelligenz (KI) betrifft spezielle Beschleunigungshardware wie Grafikprozessoren (GPUs). Vor den neuen Entwicklungen glaubte man, dass zur Beschleunigung der Deep-Learning-Technologie der Einsatz dieser speziellen Beschleunigungshardware erforderlich sei.

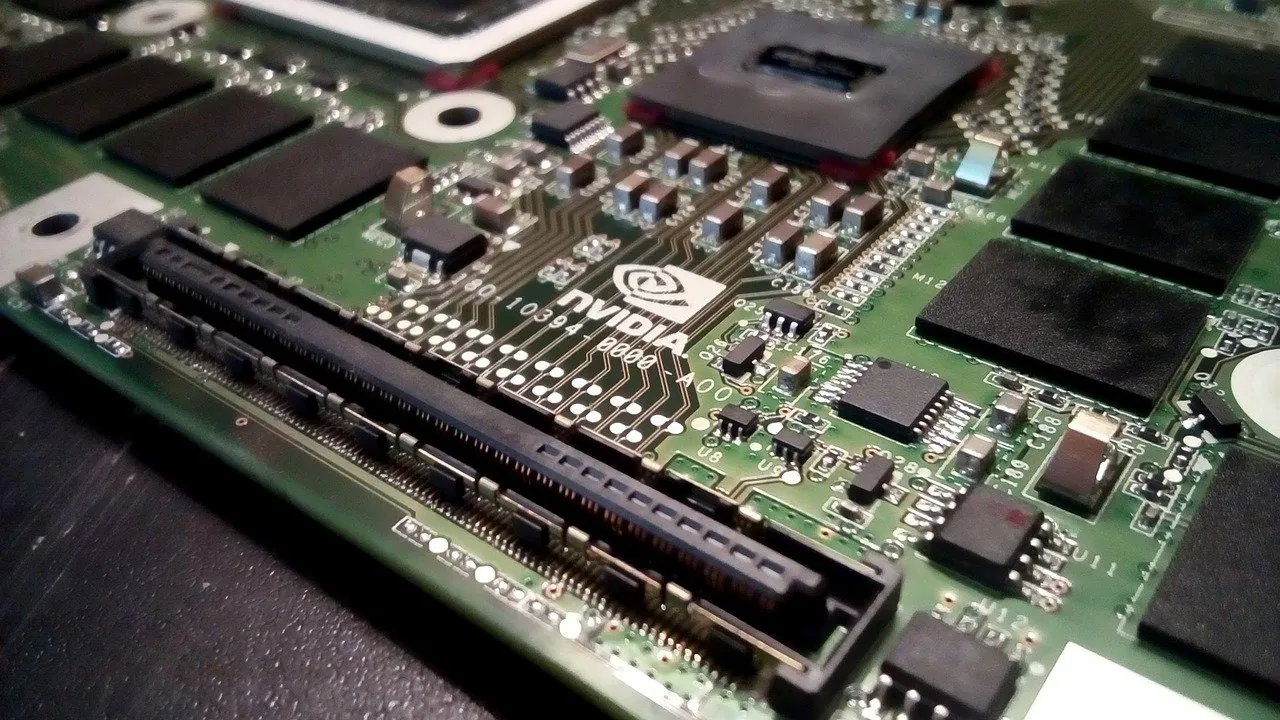

Viele Unternehmen legen großen Wert auf Investitionen in GPUs und spezielle Hardware für Deep Learning, das für Technologien wie digitale Assistenten, Gesichtserkennung und Produktempfehlungssysteme verantwortlich ist. Ein solches Unternehmen ist Nvidia, das die Tesla V100 Tensor Core GPUs herstellt. Nvidia meldete kürzlich einen Umsatzanstieg von 41 % im vierten Quartal im Vergleich zum Vorjahr.

Die Entwicklung von SLIDE eröffnet völlig neue Möglichkeiten.

Anshumali Shrivastava ist Assistenzprofessorin an der Brown School of Engineering von Rice und half zusammen mit den Doktoranden Beidi Chen und Tharun Medini bei der Erfindung von SLIDE.

„Unsere Tests zeigen, dass SLIDE die erste intelligente algorithmische Implementierung von Deep Learning auf der CPU ist, die die GPU-Hardwarebeschleunigung bei branchenweiten Empfehlungsdatensätzen mit großen, vollständig verbundenen Architekturen übertreffen kann“, sagte Shrivastava.

SLIDE meistert die Herausforderung von GPUs aufgrund seines völlig anderen Ansatzes für Deep Learning. Derzeit ist die Standardtrainingstechnik für tiefe neuronale Netze die „Rückausbreitung“ und erfordert eine Matrixmultiplikation. Diese Arbeitslast erfordert den Einsatz von GPUs, daher haben die Forscher das Training des neuronalen Netzwerks so geändert, dass es mit Hash-Tabellen gelöst werden kann.

Dieser neue Ansatz reduziert den Rechenaufwand für SLIDE erheblich. Die derzeit beste GPU-Plattform, die Unternehmen wie Amazon und Google für Cloud-basiertes Deep Learning nutzen, verfügt über acht Tesla V100, und der Preis liegt bei rund 100,000 US-Dollar.

„Wir haben einen im Labor und in unserem Testfall haben wir eine Arbeitslast genommen, die perfekt für V100 ist, eine mit mehr als 100 Millionen Parametern in großen, vollständig verbundenen Netzwerken, die in den GPU-Speicher passen“, sagte Shrivastava. „Wir haben ihn mit dem besten (Software-)Paket auf dem Markt trainiert, Googles TensorFlow, und das Training hat 3 1/2 Stunden gedauert.“

„Wir haben dann gezeigt, dass unser neuer Algorithmus das Training in einer Stunde durchführen kann, nicht auf GPUs, sondern auf einer 44-Kern-CPU der Xeon-Klasse“, fuhr er fort.

Hashing ist eine Art Datenindexierungsmethode, die in den 1990er Jahren für die Internetsuche erfunden wurde. Numerische Methoden werden verwendet, um große Informationsmengen in eine Ziffernfolge zu kodieren, die als Hash bezeichnet wird. Hashes werden aufgelistet, um Tabellen zu erstellen, die schnell durchsucht werden können.

„Es hätte keinen Sinn gemacht, unseren Algorithmus auf TensorFlow oder PyTorch zu implementieren, denn das Erste, was sie tun, ist, alles, was man tut, in ein Matrixmultiplikationsproblem umzuwandeln“, sagte Chen. „Genau davon wollten wir wegkommen. Also haben wir unseren eigenen C++-Code von Grund auf neu geschrieben.“

Laut Shrivastava besteht der größte Vorteil von SLIDE darin, dass es datenparallel ist.

„Mit Datenparallelität meine ich, dass ich mit zwei Dateninstanzen trainieren möchte, beispielsweise mit dem Bild einer Katze und dem Bild eines Busses. Diese aktivieren wahrscheinlich unterschiedliche Neuronen, und SLIDE kann diese beiden unabhängig voneinander aktualisieren oder trainieren“, sagte er. „Das ist eine deutlich bessere Nutzung der Parallelität für CPUs.“

„Die Kehrseite im Vergleich zu GPU ist, dass wir viel Speicher benötigen“, sagte er. „Es gibt eine Cache-Hierarchie im Hauptspeicher, und wenn man damit nicht vorsichtig umgeht, kann es zu einem Problem namens Cache-Thrashing kommen, bei dem es zu vielen Cache-Fehlern kommt.“

SLIDE hat die Tür für neue Wege zur Implementierung von Deep Learning geöffnet, und Shrivastava glaubt, dass dies erst der Anfang ist.

„Wir haben gerade erst an der Oberfläche gekratzt“, sagte er. „Es gibt noch viel zu optimieren. Wir haben zum Beispiel weder Vektorisierung noch integrierte Beschleuniger in der CPU wie Intel Deep Learning Boost verwendet. Es gibt noch viele andere Tricks, mit denen wir das Ganze noch schneller machen könnten.“