Künstliche Intelligenz

Menschliche Bildsynthese aus reflektierten Radiowellen

Forscher aus China haben eine Methode entwickelt, um mithilfe von Radiowellen nahezu fotorealistische Bilder von Menschen ohne Kamera zu synthetisieren Generative Adversarial Networks (GANs). Das von ihnen entwickelte System wird anhand von realen Bildern trainiert, die bei gutem Licht aufgenommen wurden, ist aber in der Lage, auch bei Dunkelheit relativ authentische „Schnappschüsse“ von Menschen aufzunehmen – und sogar durch größere Hindernisse hindurch, die die Menschen vor herkömmlichen Kameras verbergen würden.

Die Bilder basieren auf „Heatmaps“ von zwei Radioantennen, von denen eine Daten von der Decke abwärts erfasst und eine andere Störungen der Radiowellen aus einer „stehenden“ Position aufzeichnet.

Die aus den Proof-of-Concept-Experimenten der Forscher resultierenden Fotos haben einen gesichtslosen „J-Horror“-Aspekt:

RFGAN basiert auf Bildern realer Menschen in kontrollierten Umgebungen und auf Radiowellen-Heatmaps, die menschliche Aktivitäten aufzeichnen. Nachdem RFGAN Funktionen aus den Daten gelernt hat, kann es dann Snapshots basierend auf neuen RF-Daten erstellen. Das resultierende Bild ist eine Näherung, basierend auf der begrenzten Auflösung der verfügbaren niederfrequenten HF-Signale. Dieser Prozess funktioniert auch in abgedunkelten Umgebungen und über eine Vielzahl potenzieller Hindernisse hinweg. Quelle: https://arxiv.org/pdf/2112.03727.pdf

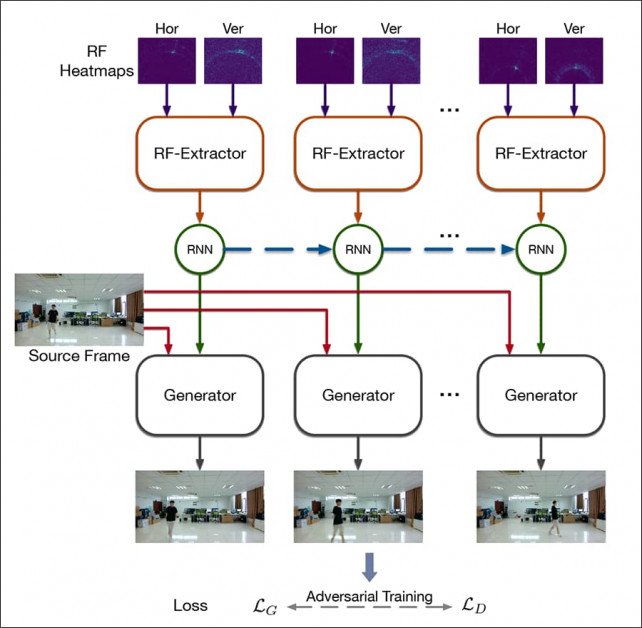

Um das GAN zu trainieren, genannt RFGANverwendeten die Forscher abgeglichene Daten einer Standard-RGB-Kamera und die verketteten entsprechenden Radio-Heatmaps, die genau zum Zeitpunkt der Aufnahme erstellt wurden. Bilder von synthetisierten Personen im neuen Projekt neigen dazu, ähnlich wie in der frühen Daguerreotypie-Fotografie unscharf zu sein, da die Auflösung der verwendeten Radiowellen mit einer Tiefenauflösung von 7.5 cm und einer Winkelauflösung von etwa 1.3 Grad sehr niedrig ist.

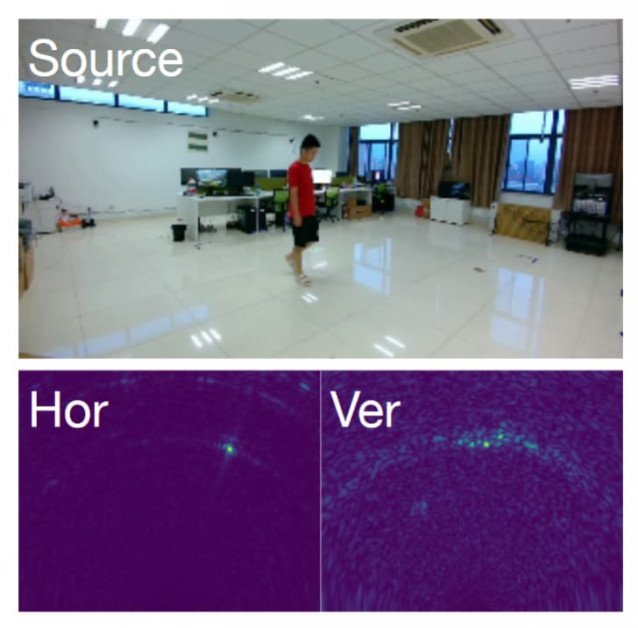

Oben das dem GAN-Netzwerk zugeführte Bild – unten die beiden Heatmaps, horizontal und vertikal, die die Person im Raum charakterisieren und innerhalb der Architektur selbst zu einer 3D-Darstellung der gestörten Daten synthetisiert werden.

The new Krepppapierassoziierte Zeichnung mit dem Titel RFGAN: RF-basierte menschliche Synthese, stammt von sechs Forschern der University of Electronic Science and Technology of China.

Daten und Architektur

Aufgrund des Fehlens früherer Datensätze oder Projekte mit diesem Umfang und der Tatsache, dass HF-Signale bisher noch nicht in einem GAN-Bildsynthese-Framework verwendet wurden, mussten die Forscher neue Methoden entwickeln.

Die Kernarchitektur von RFGAN.

Adaptive Normalisierung wurde verwendet, um die Zwillings-Heatmap-Bilder während des Trainings so zu interpretieren, dass sie räumlich mit den erfassten Bilddaten übereinstimmen.

Bei den HF-Erfassungsgeräten handelte es sich um Millimeterwellenradare (mmWave), die als zwei Antennenarrays, horizontal und vertikal, konfiguriert waren. Zum Senden und Empfangen wurden frequenzmodulierte Dauerstrichantennen (FMCW) und lineare Antennen verwendet.

Der Generator empfängt einen Quellrahmen als Eingabeschicht, wobei die RF-fusionierte Darstellung (Heatmap) das Netzwerk durch Normalisierung auf der Ebene der Faltungsschichten orchestriert.

Datum

Die Daten wurden aus HF-Signalreflexionen der mmWave-Antenne bei nur 20 Hz gesammelt, wobei gleichzeitig menschliche Videos mit sehr niedrigen 10 Bildern pro Sekunde aufgenommen wurden. Mit Hilfe von sechs Freiwilligen wurden neun Innenszenen aufgenommen, von denen jeder für verschiedene Sitzungen der Datenerfassung unterschiedliche Kleidung trug.

Das Ergebnis waren zwei unterschiedliche Datensätze: RF-Aktivität und RF-WalkErsteres enthält 68,860 Bilder von Menschen in unterschiedlichen Positionen (z. B Kniebeuge und Spaziergang), zusammen mit 137,760 entsprechenden Heatmap-Frames; und letzteres enthält 67,860 zufällige menschliche Gehhilfen zusammen mit 135,720 Paaren zugehöriger Heatmaps.

Die Daten waren der Konvention entsprechend ungleichmäßig zwischen Training und Test aufgeteilt, wobei 55,225 Bildframes und 110 Heatmap-Paare für das Training verwendet wurden und der Rest für Tests zurückgehalten wurde. Die Größe der RGB-Aufnahmerahmen wurde auf 450 x 320 und die Größe der Heatmaps auf 180 x 201 geändert.

Das Modell wurde dann mit Adam mit einer konsistenten Lernrate von 0.0002 sowohl für den Generator als auch für den Diskriminator trainiert, bei einer Epoche von 80 und einer (sehr spärlichen) Batchgröße von 2. Das Training erfolgte über PyTorch auf einer GTX-Sohle auf Verbraucherebene -1080-GPU, deren 8 GB VRAM für eine solche Aufgabe im Allgemeinen als recht bescheiden gelten würden (was die geringe Stapelgröße erklärt).

Obwohl die Forscher einige herkömmliche Metriken zum Testen der Realitätsnähe der Ausgabe adaptierten (im Detail im Artikel beschrieben) und die üblichen Ablationstests durchführten, gab es keine gleichwertige Vorarbeit, anhand derer sich die Leistung von RFGAN messen ließe.

Offenes Interesse an geheimen Signalen

RFGAN ist nicht das erste Projekt, das versucht, mithilfe von Radiofrequenzen ein volumetrisches Bild des Geschehens in einem Raum zu erstellen. Im Jahr 2019 entwickelten Forscher des MIT CSAIL eine Architektur namens RF-Avatarfähig zu Rekonstruktion von 3D-Menschen basierend auf Hochfrequenzsignalen im Wi-Fi-Bereich unter schweren Okklusionsbedingungen.

Im MIT CSAIL-Projekt aus dem Jahr 2019 wurden Radiowellen verwendet, um Verdeckungen, sogar Wände und Kleidung, zu entfernen, um aufgenommene Motive in einem traditionelleren CGI-basierten Workflow nachzubilden. Quelle: https://people.csail.mit.edu/mingmin/papers/rf-avatar.pdf

Die Forscher der neuen Arbeit würdigen auch lose damit zusammenhängende frühere Arbeiten zur Umgebungskartierung mit Radiowellen (bei denen es nicht darum ging, fotorealistische Menschen nachzubilden), die darauf abzielten Schätzen Sie die menschliche Geschwindigkeit; sehen durch Wände mit WLAN; menschliche Posen bewerten; und selbst menschliche Gesten erkennen, neben verschiedenen anderen Zielen.

Übertragbarkeit und breitere Anwendbarkeit

Anschließend machten sich die Forscher daran, herauszufinden, ob ihre Entdeckung zu sehr an die anfängliche Fangumgebung und die Trainingsbedingungen angepasst war, obwohl das Papier nur wenige Details zu dieser Phase des Experiments enthält. Sie behaupten:

„Um unser Modell in einer neuen Szene einzusetzen, müssen wir es nicht von Anfang an neu trainieren. Wir können das vortrainierte RFGAN mit sehr wenigen Daten (etwa 40 Sekunden) optimieren, um ähnliche Ergebnisse zu erzielen.“

Und fortsetzen:

„Die Verlustfunktionen und Hyperparameter sind in der Trainingsphase dieselben. Aus den quantitativen Ergebnissen geht hervor, dass das vortrainierte RFGAN-Modell nach Feinabstimmung mit nur wenigen Daten gewünschte menschliche Aktivitätsrahmen in der neuen Szene generieren kann. Das bedeutet, dass unser vorgeschlagenes Modell das Potenzial für eine breite Anwendung hat.“

Aus den im Artikel beschriebenen Details zu dieser bahnbrechenden Anwendung einer neuen Technik lässt sich nicht klar schließen, ob das von den Forschern erstellte Netzwerk ausschließlich auf die ursprünglichen Probanden „trainiert“ wurde oder ob sich aus RF-Heatmaps Details wie die Farbe der Kleidung ableiten lassen, da diese offenbar die beiden unterschiedlichen Frequenztypen umfassen, die bei optischen und Funkerfassungsmethoden zum Einsatz kommen.

In jedem Fall ist RFGAN eine neuartige Möglichkeit, die Nachahmungs- und Repräsentationskräfte von Generative Adversarial Networks zu nutzen, um eine neue und faszinierende Form der Überwachung zu schaffen – eine, die möglicherweise im Dunkeln und durch Mauern hindurch agieren könnte, und zwar auf eine Weise, die noch beeindruckender ist als die jüngsten Bemühungen Zu Sehen Sie runde Ecken mit reflektiertem Licht.

8. Dezember 2021 (Tag der ersten Veröffentlichung), 8:04 Uhr GMT+2 – wiederholtes Wort entfernt. – MA