Robotik

Vollständig integrierter Roboterarm lokalisiert und holt verlorene Gegenstände zurück

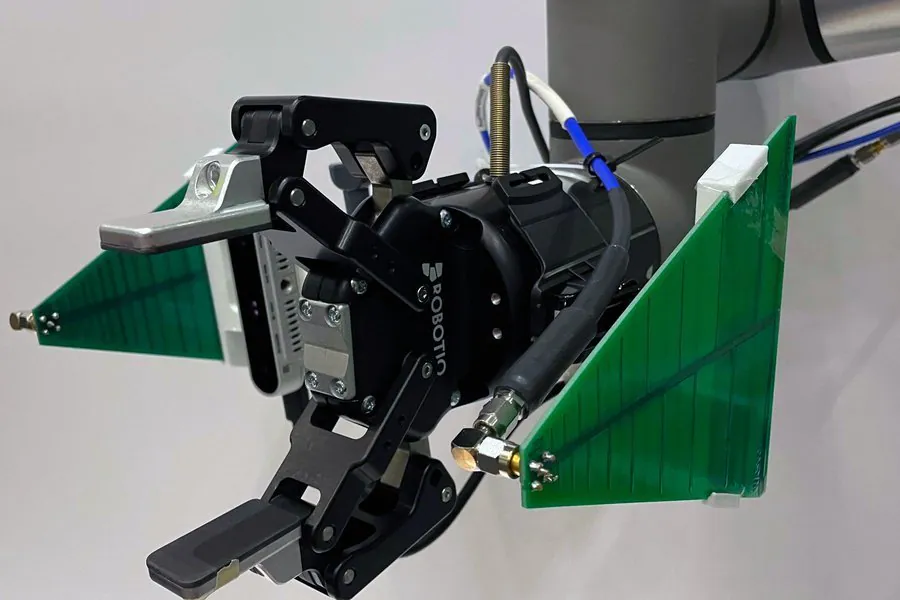

Forscher am Massachusetts Institute of Technology haben einen vollständig integrierten Roboterarm entwickelt, der visuelle Daten einer Kamera und Hochfrequenzinformationen (RF) einer Antenne kombiniert, um verlorene Objekte zu lokalisieren und wiederzufinden. Es kann Objekte lokalisieren, selbst wenn sie vergraben oder außer Sichtweite sind.

Das System heißt RFusion und der Prototyp basiert auf RFID-Tags, kostengünstigen, batterielosen Tags, die von einer Antenne gesendete Signale reflektieren. HF-Signale können die meisten Oberflächen durchdringen, sodass RFusion einen markierten Gegenstand auch dann lokalisieren kann, wenn er vergraben ist.

Der Roboterarm nutzt maschinelles Lernen, um den genauen Standort des Objekts automatisch zu bestimmen. Anschließend kann es die darauf befindlichen Gegenstände bewegen, das Objekt greifen und überprüfen, ob es sich um das richtige Objekt handelt. Kamera, Antenne, Roboterarm und KI sind vollständig integriert, sodass das System in jeder Umgebung eingesetzt werden kann, ohne dass eine umfangreiche Einrichtung erforderlich ist.

Laut den Forschern könnte RFusion für Anwendungen wie das Sortieren von Stapeln zur Erfüllung von Bestellungen in einem Lager oder für die Identifizierung und Installation von Komponenten in einer Automobilfabrik eingesetzt werden.

Fadel Adib ist leitender Autor und außerordentlicher Professor am Fachbereich Elektrotechnik und Informatik. Adib ist außerdem Direktor der Signalkinetik-Gruppe im MIT Medical Lab.

„Die Idee, Gegenstände in einer chaotischen Welt finden zu können, ist ein ungelöstes Problem, an dem wir seit einigen Jahren arbeiten. Roboter, die unter einem Stapel nach Dingen suchen können, werden in der Industrie immer wichtiger. Im Moment kann man sich das wie einen Roomba auf Steroiden vorstellen, aber kurzfristig könnte es viele Anwendungsmöglichkeiten in der Fertigung und im Lagerbereich geben“, sagte Adib.

Weitere Co-Autoren der Forschung sind die Forschungsassistentin Tara Boroushaki, die Hauptautorin; Elektrotechnik- und Informatikstudent Isaac Perper; wissenschaftlicher Mitarbeiter Mergen Nachin; und Alberto Rodriguez, außerordentlicher Professor des Jahrgangs 1957 in der Fakultät für Maschinenbau.

Die Forschung soll nächsten Monat auf der Association for Computing Machinery Conference on Embedded Networked Sensor Systems vorgestellt werden.

Das System trainieren

Die Forscher nutzten Reinforcement Learning, um ein neuronales Netzwerk zu trainieren, das die Flugbahn des Roboters zu einem Objekt optimieren kann.

„So lernt auch unser Gehirn. Wir werden von unseren Lehrern, von unseren Eltern, durch ein Computerspiel usw. belohnt. Das Gleiche passiert beim verstärkenden Lernen. Wir lassen den Agenten Fehler machen oder etwas richtig machen und bestrafen oder belohnen dann das Netzwerk. Auf diese Weise lernt das Netzwerk etwas, das für es wirklich schwer zu modellieren ist“, erklärt Boroushaki.

Der Optimierungsalgorithmus in RFusion wurde belohnt, da er die Anzahl der Bewegungen zum Lokalisieren des Gegenstands und die zurückgelegte Entfernung zum Aufnehmen begrenzte.

RFusion testen

Die Forscher testeten das System in mehreren Umgebungen, darunter in einer, in der ein Schlüsselbund in einer Kiste voller Unordnung vergraben war und eine Fernbedienung unter einem Stapel Gegenstände auf einer Couch versteckt war.

Sie wählten den Ansatz, die HF-Messungen zusammenzufassen und die visuellen Daten auf den Bereich direkt vor dem Roboter zu beschränken, um das System nicht zu überfordern. Dies führte zu einer Erfolgsquote von 96 Prozent bei der Bergung vollständig unter einem Stapel verborgener Objekte.

„Wenn man sich nur auf HF-Messungen verlässt, wird es manchmal einen Ausreißer geben, und wenn man sich nur auf das Sehen verlässt, kommt es manchmal zu einem Fehler der Kamera. Aber wenn man sie kombiniert, werden sie sich gegenseitig korrigieren. Das hat das System so robust gemacht“, sagt Boroushaki.

Matthew S. Reynolds ist CoMotion Presidential Innovation Fellow und außerordentlicher Professor für Elektro- und Computertechnik an der University of Washington.

„Jedes Jahr werden Milliarden von RFID-Tags verwendet, um Objekte in den komplexen Lieferketten von heute zu identifizieren, darunter Kleidung und viele andere Konsumgüter. Der RFusion-Ansatz weist den Weg zu autonomen Robotern, die einen Haufen gemischter Artikel durchwühlen und anhand der in den RFID-Tags gespeicherten Daten sortieren können. Das ist viel effizienter, als wenn jeder Artikel einzeln geprüft werden müsste, insbesondere wenn die Artikel für ein Computer-Vision-System ähnlich aussehen“, sagt Reynolds. „Der RFusion-Ansatz ist ein großer Fortschritt für die Robotik in komplexen Lieferketten, wo die schnelle und präzise Identifizierung und Kommissionierung des richtigen Artikels der Schlüssel zur termingerechten Auftragsabwicklung und zur Zufriedenheit anspruchsvoller Kunden ist.“

Die Forscher werden nun versuchen, die Geschwindigkeit des Systems zu erhöhen, um es reibungslos zu bewegen.