Künstliche Intelligenz

NeRF kommt der Ablösung von CGI einen weiteren Schritt näher

Forscher am MIT und bei Google haben einen großen Schritt bei der Lösung eines der grundlegendsten Hindernisse für eine aufkommende KI-gesteuerte Technologie gemacht, die schließlich CGI ersetzen könnte – die Zerlegung von NeRF-Bildern (Neural Radiance Field) in ihre visuellen Bestandteile, sodass die Bilder dies können neu strukturiert und neu beleuchtet werden.

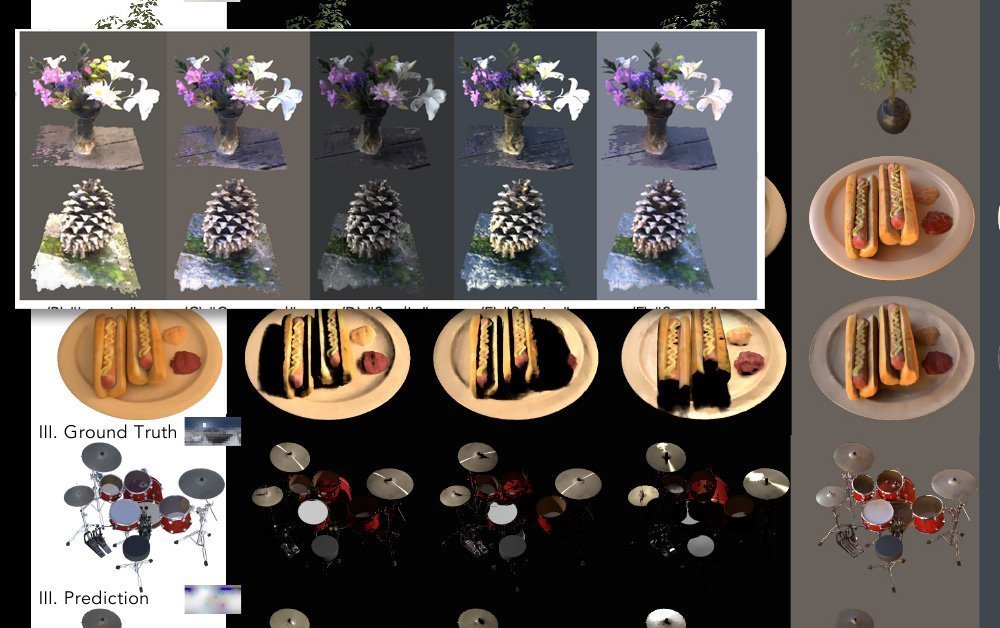

Der neue Ansatz, genannt NeRFactor, unterteilt erfasste Bilder effektiv in Pro-Objekt-Normale (denen Texturen zugewiesen werden können), Lichtsichtbarkeit, Albedo (der Anteil des einfallenden Lichts, der von einer Oberfläche wegreflektiert wird) und bidirektionale Reflexionsverteilungsfunktionen (BRDFs).

Wenn diese Facetten isoliert sind, ist es nicht nur möglich, Texturen für einzelne Objekte oder Objektgruppen zu ändern, sondern auch neuartige und einzigartige Beleuchtungsquellen und Schattenimplementierungen hinzuzufügen, wobei diejenigen außer Acht gelassen werden, die von den Multikamera-Arrays erfasst wurden, die Eingaben für NeRF-Bilder generieren.

Normalen, Sichtbarkeit, Albedo und BRDF getrennt unter NeRFactor. Quelle: https://www.youtube.com/watch?v=UUVSPJlwhPg

Das Modell unterstützt weiche oder harte Schatten von beliebigen, benutzerdefinierten Lichtquellen und trennt die vier Aspekte des aufgenommenen Videos programmgesteuert, indem es einen Rekonstruktionsverlust, Daten aus früheren BRDF-Berechnungen und eine einfache Glättungsregulierung verwendet.

Der Arbeitsablauf von NeRFactor extrahiert separat verwertbare Facetten von Bildern, die aus Arrays mit mehreren Kameras stammen. Quelle: https://arxiv.org/pdf/2106.01970.pdf

NeRFactor verwendet eine HDR-Lichtsonde, ein etablierter Ansatz, der seit seiner Gründung die visuelle Industrie- und Kunstszene durchdringt Einführung im Jahr 1998, um mögliche Strahlenwege zu evaluieren, die eine beliebige Beleuchtung ermöglichen. Da dadurch eine unkontrollierbare Anzahl möglicher Parameter erzeugt wird, wird die Lichtsonde durch ein mehrschichtiges Perzeptron (MLP) gefiltert, das die wahrgenommene Geometrie auf die Sonde abbildet, ohne zu versuchen, eine vollständige Beleuchtungsvolumenkarte für den Modellraum zu berechnen.

Zwei neuronale Strahlungsfeldmodelle werden verwendet, um fünf unter NeRFactor mögliche Beleuchtungsmodelle zu demonstrieren. Klicken Sie auf das Bild für eine höhere Auflösung.

Anlass zum Nachdenken

Die neue Forschung ist vielleicht am bedeutsamsten, wenn es darum geht, die Ebenen der aufgenommenen Bilder zu trennen, die die Reflexion steuern. Dies bleibt eine der größten Herausforderungen für die Bildgebung neuronaler Strahlungsfelder, da ein wirklich neuartiges und flexibles NeRF-System nicht nur in der Lage sein muss, Texturen zu ersetzen, sondern vor allem auch eine Möglichkeit benötigt, sich bewegende Objekte zu reflektieren (neben der allgemeinen festen Umgebung). Dies würde normalerweise in einem CGI-Workflow berücksichtigt werden.

Dieses Problem wurde kürzlich im Zusammenhang mit Intel festgestellt beeindruckende neue Forschung in die Umwandlung von Videospielmaterial in fotorealistische Videos über Faltungs-Neuronale Netze. In solchen Arbeitsabläufen müssten viele „gebackene“ Aspekte des Quellmaterials diskret und austauschbar werden, und dies lässt sich wohl leichter für die Neubeleuchtung (die eine Funktion der in NeRF gerenderten Geometrie ist) lösen als für Reflexionen (die „ Off-Screen-Geometrie, die völlig außerhalb des Modellbereichs liegt).

Daher bringt die Isolierung der Ebenen im NeRF-Video, die die Reflexion erleichtern, NeRF der Lösung seiner „Reflexionsherausforderung“ einen Schritt näher.

Die Verwendung einer HDR-Umgebung löst bereits das Problem der Erzeugung von Reflexionen der Weltumgebung (z. B. Himmel, Landschaften und andere „feste“ Umgebungsfaktoren), es sind jedoch neue Ansätze erforderlich, um bewegte und dynamische Reflexionen einzuführen.

Photogrammetrie mit NeRF

Neural Radiance Field-Bilder nutzen maschinelle Lernanalysen, um aus einer Szene oder einem Objekt, das aus verschiedenen Winkeln aufgenommen wurde, einen vollständig volumetrischen Raum zu entwickeln.

Verschiedene NeRF-basierte Systeme, die im letzten Jahr entstanden sind, haben eine unterschiedliche Anzahl beitragender Kamerageräte verwendet; Manche nutzen 16 oder mehr Kameras, andere nur eine oder zwei. In allen Fällen werden die Zwischenperspektiven „ausgefüllt“ (d. h. interpretiert), sodass die Szene oder das Objekt flüssig navigiert werden kann.

Die resultierende Einheit ist ein vollständig volumetrischer Raum mit einem intrinsischen 3D-Verständnis, das auf viele Arten genutzt werden kann, einschließlich der Möglichkeit, traditionelle CG-Netze aus der 3D-analysierten Summe der Eingabebilder zu generieren.

NeRF im Kontext eines „neuen CGI“

Bilder von neuronalen Strahlungsfeldern sind gezogen direkt aus Bildern der realen Welt, einschließlich bewegter Bilder von Menschen, Objekten und Szenen. Im Gegensatz dazu „studiert“ und interpretiert eine CGI-Methodik die Welt und erfordert dafür Fachkräfte, die Netze, Rigs und Texturen erstellen, die Bilder aus der realen Welt (z. B. Gesichts- und Umgebungsaufnahmen) nutzen. Es bleibt im Wesentlichen ein interpretativer und handwerklicher Ansatz, der teuer und mühsam ist.

Darüber hinaus hatte CGI bei seinen Versuchen, menschliche Abbilder nachzubilden, anhaltende Probleme mit dem „Uncanny Valley“-Effekt, der keine Einschränkung für einen NeRF-gesteuerten Ansatz darstellt, der einfach Videos oder Bilder von echten Menschen aufnimmt und manipuliert.

Darüber hinaus kann NeRF bei Bedarf herkömmliche Netzgeometrien im CGI-Stil direkt aus Fotos generieren und so viele der manuellen Verfahren ersetzen, die bei computergenerierten Bildern schon immer notwendig waren.

Herausforderungen für NeRF

Diese neueste Forschung von MIT und Google steht im Zusammenhang mit einer wahren Flut von NeRF-Artikeln im letzten Jahr, von denen viele Lösungen für die verschiedenen Herausforderungen angeboten haben, die der erste Artikel aus dem Jahr 2020 aufgeworfen hat.

Im April bot die Innovation eines chinesischen Forschungskonsortiums einen Weg dazu diskret isolieren die einzelnen Zeitleisten von Facetten in einer NeRF-Szene, einschließlich Personen.

Die chinesische Forschung ermöglicht Endbenutzern das Kopieren, Einfügen und Ändern der Größe erfasster Elemente und entwirrt sie so von der linearen Zeitachse des ursprünglichen Quellvideos. Quelle: https://www.youtube.com/watch?v=Wp4HfOwFGP4

Dieser Ansatz ermöglicht nicht nur die Neuvorstellung der Szene aus jedem vom Kameraarray erfassten Winkel (und nicht nur der einzelnen Ansicht, die in einer typischen Videoaufnahme dargestellt wird), sondern ermöglicht auch vielseitige Kompositionen – und sogar die Möglichkeit, zwei Facetten derselben darzustellen Filmmaterial, das in seinem eigenen individuellen Zeitrahmen läuft (oder bei Bedarf sogar rückwärts läuft).

Die chinesische Forschung ermöglicht Endbenutzern das Kopieren, Einfügen und Ändern der Größe erfasster Elemente und entwirrt sie so von der linearen Zeitachse des ursprünglichen Quellvideos. Quelle: https://www.youtube.com/watch?v=Wp4HfOwFGP4

Eine der größten Herausforderungen für NeRF besteht darin, die erheblichen Ressourcen zu senken, die zum Trainieren einer Szene erforderlich sind, und dies wurde in einer Reihe neuerer Veröffentlichungen angesprochen. So hat beispielsweise das Max-Planck-Institut für Intelligente Systeme kürzlich vorgestellt KiloNeRF, was nicht nur die Renderzeiten um den Faktor 1000 beschleunigt, sondern sogar den interaktiven Betrieb von NeRF ermöglicht.

KiloNeRF führt eine interaktive Umgebung mit 50 fps auf einer GTX 1080ti aus. Quelle: https://github.com/creiser/kilonerf

Die NeRF-Geschwindigkeitsinnovation, die im Jahr 2021 die Fantasie von Forschern und der Öffentlichkeit gleichermaßen erregte, war jedoch die PlenOctrees Zusammenarbeit unter der Leitung der UC Berkeley, die Echtzeit-Rendering neuronaler Strahlungsfelder bietet:

Die Wirkung der interaktiven Funktionen von PlenOctrees wurde in a reproduziert Live, webbasierte Schnittstelle.

Interaktive Live-Bewegung eines PlenOctrees-Objekts in Firefox (die Bewegung ist flüssiger und dynamischer, als dieses GIF darstellt). Quelle: http://alexyu.net/plenoctrees/demo/

Zusätzlich Rekursiv-NeRF (aus einem Artikel von Forschern der Tsinghua-Universität vom Mai 2021) bietet hochwertiges rekursives Rendering auf Abruf. Anstatt den Benutzer zu zwingen, ganze Szenen zu rendern, einschließlich Teilen, die möglicherweise nicht sichtbar sind, bietet Recursive-NeRF so etwas wie die verlustbehaftete Komprimierung von JPEG und kann diskrete Sub-NeRFs generieren, um zusätzliche Bilder bei Bedarf zu verarbeiten – was zu einer enormen Einsparung von Rechenressourcen führt .

Beibehaltung von Details, während unnötige Renderberechnungen mit Recursive-NeRF entfallen. Klicken Sie auf das Bild für eine höhere Auflösung. Quelle: https://arxiv.org/pdf/2105.09103.pdf

Andere Ansätze umfassen FastNeRF, das behauptet, ein hochauflösendes neuronales Rendering mit 200 Bildern pro Sekunde zu erreichen.

Es wurde festgestellt, dass viele der Optimierungstechniken für NeRF Folgendes umfassen die Szene „backen“., indem man sich auf Aspekte festlegt, die gerendert werden sollen, und andere Facetten verwirft, was die Erkundung einschränkt, aber die Interaktivität erheblich beschleunigt.

Der Nachteil dabei ist, dass sich die Belastung von der GPU auf den Speicher verlagert, da gebackene Szenen übermäßig viel Speicherplatz beanspruchen; Bis zu einem gewissen Grad kann dies durch ein Downsampling der gespeicherten Daten abgemildert werden, obwohl dies auch einen gewissen Aufwand im Hinblick auf das Verschließen von Möglichkeiten zur Erkundung oder Interaktivität mit sich bringt.

In Bezug auf Motion Capture und Rigging, ein neuer Ansatz der Universitäten Zheijang und Cornell, im Mai enthülltbot eine Methode zur Nachbildung animierbarer Menschen mithilfe von Mischungsgewichtsfeldern und Skelettstrukturen, die aus dem Eingabevideo interpretiert wurden:

Abgeleitete Skelettstruktur in animierbarem NeRF. Quelle: https://www.youtube.com/watch?v=eWOSWbmfJo4

Wann erlebt NeRF seinen „Jurassic Park“-Moment?

Trotz des rasanten Fortschritts bei der Bildsynthese über neuronale Strahlungsfelder wird sich erst in dieser Zeit ein „Gesetz der Thermodynamik“ dafür etablieren, wie einsetzbar NeRF werden kann. In Bezug auf eine Zeitleiste, die der Geschichte von CGI ähnelt, bewegt sich NeRF derzeit um das Jahr 1973, kurz vor dem erste Einsatz von CGI in Westworld.

Das bedeutet nicht, dass NeRF unbedingt neun Jahre auf sein Äquivalent warten muss Zorn von Khan Meilensteinoder Jahrzehnte für die ähnlichen Durchbrüche, die CGI unter der enthusiastischen Schirmherrschaft von James Cameron in den 1989er Jahren erzielte The Abyss oder 1991er Terminator 2 – und dann ist die Technologie wirklich revolutionär Ausbruchsmoment im Jahr 1993 Jurassic Park.

Die Imaging-Szene hat sich seit der langen Phase der Stagnation fotochemischer visueller Effekte, die von der Geburt des Kinos bis in die frühen 1990er Jahre die Film- und Fernsehproduktion dominierte, stark verändert. Das Aufkommen der PC-Revolution und die Beschleunigung des Mooreschen Gesetzes führten zur CGI-Revolution, die andernfalls schon in den 1960er Jahren hätte stattfinden können.

Es bleibt abzuwarten, ob es ein Hindernis gibt, das so unerbittlich ist, dass es den Fortschritt von NeRF so lange aufhalten könnte – und ob spätere Innovationen im Bereich Computer Vision NeRF als Hauptanwärter auf die Krone von CGI, die neuronale Strahlungsfelder charakterisiert, nicht inzwischen vollständig überholen könnten als kurzlebiges „Faxgerät“ der neuronalen Bildsynthese.

Bisher wurde NeRF in keinem Kontext außerhalb der akademischen Forschung eingesetzt; Es ist jedoch bemerkenswert, dass große Player wie Google Research und viele der bekanntesten Computer-Vision-Forschungslabore um den neuesten NeRF-Durchbruch konkurrieren.

Viele der größten Hindernisse von NeRF wurden in diesem Jahr direkt angegangen; Wenn nachfolgende Forschungen eine Lösung für das „Reflexionsproblem“ bieten und die vielen Stränge der NeRF-Optimierungsforschung zu einer entscheidenden Lösung für die erheblichen Verarbeitungs- und/oder Speicheranforderungen der Technologie zusammenwachsen, hat NeRF tatsächlich eine Chance, „das neue CGI“ zu werden ' in den nächsten fünf Jahren.