الذكاء الاصطناعي

LoReFT: ضبط التمثيل لنماذج اللغة

تسعى أساليب الضبط الدقيق ذات كفاءة المعلمات أو أساليب PeFT إلى تكييف نماذج اللغة الكبيرة عبر التحديثات لعدد صغير من الأوزان. ومع ذلك، فقد أظهرت غالبية الأعمال الحالية المتعلقة بقابلية التفسير أن التمثيلات تشفر معلومات غنية بالدلالات، مما يشير إلى أنه قد يكون بديلاً أفضل وأقوى لتحرير هذه التمثيلات. غالبًا ما يتم ضبط النماذج الكبيرة المدربة مسبقًا بشكل دقيق لاستخدامها في المجالات أو المهام الجديدة، وأثناء عملية الضبط الدقيق، يمكن تكييف نموذج أساسي واحد مع مجموعة واسعة من المهام حتى مع توفر كميات صغيرة فقط من البيانات الموجودة في المجال إلى النموذج. ومع ذلك، فإن عملية الضبط الدقيق للنموذج بأكمله تستهلك الموارد، ومكلفة، خاصة بالنسبة لنماذج اللغة التي تحتوي على عدد أكبر بكثير من الحجم والمعلمات.

تقترح أساليب الضبط الدقيق ذات كفاءة المعلمات أو أساليب PeFT معالجة التكاليف المرتفعة المرتبطة بضبط النموذج بأكمله عن طريق تحديث كمية صغيرة فقط من إجمالي الأوزان المتاحة، وهي عملية تساعد في تقليل وقت التدريب إلى جانب استخدام الذاكرة. والأهم من ذلك هو أن أساليب الضبط الدقيق أو PeFT ذات كفاءة المعلمة قد أظهرت أداءً مشابهًا للضبط الدقيق في العديد من الإعدادات العملية. تتعلم المحولات، وهي عائلة شائعة من أساليب الضبط الدقيق بكفاءة المعلمات أو أساليب PeFT، تعديلًا يمكن إضافته إلى مجموعة إضافية من الأوزان التي تعمل جنبًا إلى جنب مع النموذج الأساسي المجمد، مع المحولات الحديثة مثل LoRA تقلل عدد المعلمات القابلة للتدريب في التعلم تحديثات الوزن باستخدام تقديرات تقريبية منخفضة الرتبة بدلاً من مصفوفات الوزن الكامل عند تدريب المحولات.

من خلال الأعمال السابقة التي توضح أن تمثيلات التحرير قد تكون بديلاً أفضل للضبط الدقيق بكفاءة المعلمة أو أساليب PeFT، في هذه المقالة، سنتحدث عن أساليب الضبط الدقيق للتمثيل أو ReFT التي تعمل على نموذج متجمد، ونتعلم مهام محددة مداخلات على التمثيلات الخفية. تهدف هذه المقالة إلى تغطية إطار الضبط الدقيق ReFt أو التمثيل بعمق، ونستكشف الآلية والمنهجية وبنية الإطار إلى جانب مقارنته بأطر العمل الحديثة. اذا هيا بنا نبدأ.

ReFT: الضبط الدقيق للتمثيل لنماذج اللغة

في محاولة لاعتماد نماذج لغوية مدربة مسبقًا في مجالات ومهام جديدة، تقوم الأطر الحالية بضبط نماذج اللغة المدربة مسبقًا هذه بشكل متكرر كما هو الحال مع عملية الضبط الدقيق التي يتم تنفيذها، يمكن تكييف نموذج أساسي واحد مع مجموعة متنوعة من المهام حتى عند العمل مع كمية صغيرة من البيانات في المجال. على الرغم من أن عملية الضبط الدقيق تعزز الأداء العام، إلا أنها عملية مكلفة خاصة إذا كان نموذج اللغة يحتوي على عدد كبير جدًا من المعلمات. لمعالجة هذه المشكلة وتقليل التكاليف المرتبطة بها، استخدم PeFT أو Parameter-efficiency أطر الضبط الدقيق تحديث جزء صغير فقط من إجمالي الأوزان، وهي عملية لا تقلل من وقت التدريب فحسب، بل تقلل أيضًا من استخدام الذاكرة، مما يسمح لأطر عمل PeFT بتحقيق أداء مماثل عند مقارنتها بأساليب الضبط الدقيق الكاملة في السيناريوهات العملية. تعمل المحولات، وهي عائلة مشتركة من PeFTs، من خلال تعلم تعديل يمكن إضافته إلى مجموعة إضافية من الأوزان جنبًا إلى جنب مع مجموعة فرعية من الأوزان التي تعمل في انسجام مع النموذج الأساسي مع الأوزان المجمدة. أطر المحول الحديثة مثل لورا وQLoRA لقد أثبت أنه من الممكن تدريب محولات كاملة الدقة أعلى النماذج ذات الدقة المنخفضة دون التأثير على الأداء. عادةً ما تكون المحولات أكثر كفاءة وفعالية عند مقارنتها بالطرق الأخرى التي تقدم مكونات نموذجية جديدة.

من أهم ما يميز أطر الضبط الدقيق ذات الكفاءة البارامترية الحالية هو أنه بدلاً من تعديل التمثيلات، يقومون بتعديل الأوزان. ومع ذلك، فقد أثبتت الأطر التي تتعامل مع قابلية التفسير أن التمثيلات تشفر معلومات دلالية غنية، مما يشير إلى أن تحرير التمثيلات قد يكون أسلوبًا أفضل وأكثر قوة عند مقارنته بتحديثات الوزن. هذا الافتراض بأن تحرير التمثيلات هو النهج الأفضل هو ما يشكل أساس ReFT أو إطار الضبط الدقيق للتمثيل الذي يدرب التدخلات بدلاً من تكييف أوزان النموذج، مما يسمح للنموذج بمعالجة جزء صغير من جميع التمثيلات في محاولة لتوجيه سلوكيات النموذج لحل المهام المتلقين للمعلومات أثناء الاستدلال. تعد طرق الضبط الدقيق ReFT أو Representation عبارة عن بدائل سهلة الاستخدام لأطر الضبط الدقيق المعتمدة على الوزن PeFT أو أطر الضبط الدقيقة ذات الكفاءة في المعلمات. يستمد منهج ReFT الإلهام من النماذج الحديثة التي تعمل مع قابلية تفسير النماذج الكبيرة والتي تتدخل في التمثيلات للعثور على آليات سببية مخلصة، وتوجه سلوك النموذج أثناء الاستدلال، وبالتالي يمكن اعتبارها تعميمًا لنماذج تحرير التمثيل. بناءً على ذلك، يعد LoReFT أو Low-Rank Subspace ReFT مثالًا قويًا وفعالًا لـ ReFT، وهو عبارة عن معلمات لـ ReFT تتدخل في التمثيلات المخفية في الفضاء الخطي الممتد بواسطة مصفوفة إسقاط منخفضة الرتبة، وتبني مباشرة على DAS أو إطار بحث المحاذاة الموزعة.

على عكس الضبط الدقيق الكامل، يقوم إطار الضبط الدقيق PeFT أو المعلمة بكفاءة بتدريب جزء صغير فقط من معلمات النموذج، ويتمكن من تكييف النموذج مع المهام النهائية. يمكن تصنيف إطار الضبط الدقيق ذو كفاءة المعلمة إلى ثلاث فئات رئيسية:

- الأساليب القائمة على المحول: تعمل الأساليب المعتمدة على المحول على تدريب وحدات إضافية مثل الطبقات المتصلة بالكامل أعلى النموذج المُدرب مسبقًا بأوزان مجمدة. تقوم محولات السلسلة بإدخال مكونات بين الإدراك الحسي متعدد الطبقات أو MLP وLM أو طبقات انتباه النموذج الكبيرة، بينما تضيف المحولات المتوازية وحدات إلى جانب المكونات الموجودة. نظرًا لأن المحولات تضيف مكونات جديدة لا يمكن طيها في أوزان النماذج الموجودة بسهولة، فإنها تشكل عبئًا إضافيًا أثناء الاستدلال.

- لورا: LoRA مع متغيراته الحديثة تقارب الأوزان المضافة أثناء التدريب باستخدام مصفوفات منخفضة الرتبة، ولا تتطلب أعباء إضافية أثناء الاستدلال حيث يمكن دمج تحديثات الوزن في النموذج، وهذا هو السبب في اعتبارها هي الحالية أقوى أطر PeFT.

- الأساليب المستندة إلى السرعة: تضيف الأساليب المستندة إلى الموجه الرموز المميزة التي تتم تهيئتها عشوائيًا في الإدخال، وتدرب تضميناتها مع الحفاظ على تجميد أوزان نموذج اللغة. غالبًا ما يكون الأداء الذي تقدمه هذه الطرق غير مرضٍ عند مقارنته بأساليب PeFT الأخرى، كما أنها تحمل أيضًا تكلفة عامة كبيرة للاستدلال.

بدلاً من تحديث الأوزان، يتعلم إطار عمل ReFT التدخلات لتعديل جزء صغير من إجمالي التمثيلات. علاوة على ذلك، أظهرت الأعمال الحديثة المتعلقة بهندسة التمثيل وتوجيه التنشيط أن إضافة متجهات توجيه ثابتة إلى التيار المتبقي قد يسهل درجة من التحكم في أجيال النماذج الكبيرة المدربة مسبقًا دون الحاجة إلى استخدام موارد مكثفة الكون المثالى. أثبتت أطر عمل أخرى أن تحرير التمثيلات من خلال عملية القياس والترجمة المستفادة يمكن أن يحاول مطابقة الأداء الذي تقدمه محولات LoRA ولكن لا يتجاوزه في مجموعة واسعة من المهام مع عدد أقل من المعلمات المستفادة. علاوة على ذلك، أثبت نجاح هذه الأطر عبر مجموعة من المهام أن التمثيلات المقدمة بواسطة نماذج اللغة المدربة مسبقًا تحمل دلالات غنية، على الرغم من أن أداء هذه النماذج دون المستوى الأمثل، مما يؤدي إلى استمرار PeFTs كنهج متطور مع عدم وجود عبء الاستدلال الإضافي.

ReFT: المنهجية والهندسة المعمارية

لإبقاء عملية الحفاظ على النمط بسيطة، يفترض إطار عمل ReFT نموذجًا كبيرًا قائمًا على المحولات كنموذج مستهدف قادر على إنتاج تمثيل سياقي لتسلسل الرموز المميزة. بالنسبة لتسلسل معين مع عدد n من رموز الإدخال، يقوم إطار عمل ReFT أولاً بتضمين رموز الإدخال هذه في قائمة من التمثيلات التي تليها الطبقات m تحسب قائمة التمثيلات المخفية على التوالي كدالة للقائمة السابقة من التمثيلات المخفية. كل تمثيل مخفي هو ناقل، ويستخدم نموذج اللغة التمثيلات المخفية النهائية لإنتاج التنبؤات. يأخذ إطار عمل ReFT في الاعتبار كلا من نماذج اللغة المقنعة ونماذج اللغة الانحدارية الذاتية. الآن، وفقًا لفرضية التمثيل الخطي، في الشبكات العصبية، يتم تشفير المفاهيم داخل الفضاءات الفرعية الخطية للتمثيلات. وقد وجدت النماذج الحديثة أن هذا الادعاء صحيح في نماذج الشبكات العصبية المدربة على اللغة الطبيعية إلى جانب توزيعات المدخلات الأخرى.

علاوة على ذلك، في دراسات قابلية التفسير، يستخدم إطار التجريد العرضي تدخلات التبادل لتحديد دور مكونات الشبكة العصبية بشكل عرضي عند تنفيذ سلوكيات معينة. المنطق الكامن وراء تدخل التبادل هو أنه إذا تم إصلاح التمثيل على ما كان يمكن أن يكون عليه بالنسبة لمدخلات مضادة، ويؤثر هذا التدخل على مخرجات النموذج بشكل ثابت بالطريقة التي تؤكد بها المطالبات التي يقدمها إطار ReFT حول المكون المسؤول عن الإنتاج هذا التمثيل، فإن المكون يلعب دورا سببيا في السلوك. على الرغم من وجود طرق قليلة، إلا أن تدخل التبادل الموزع هو النهج المثالي لاختبار ما إذا كان المفهوم مشفرًا في مساحة فرعية خطية للتمثيل، كما تدعي فرضية التمثيل الخطي. علاوة على ذلك، تم استخدام طريقة DAS سابقًا للعثور على تمثيل خطي في نماذج اللغة لسمات الكيان والمشاعر والميزات اللغوية والتفكير الرياضي. ومع ذلك، أشارت العديد من التجارب إلى أن طريقة DAS معبرة للغاية، وتمتلك القدرة على العثور على مساحات فرعية سببية فعالة حتى عندما تتم تهيئة نموذج لغة المحول بشكل عشوائي، وبالتالي لم تتعلم بعد أي تمثيلات خاصة بالمهمة، مما يؤدي إلى مناقشة ما إذا كانت DAS فعالة ومسؤولة بدرجة كافية لمهام الترجمة الفورية.

تشير التعبيرية التي تقدمها DAS إلى أن هذا النهج يمكن أن يكون أداة مثالية للتحكم في سلوك نموذج اللغة إلى جانب عمله على التوليد الذي يمكن التحكم فيه والتحرير المسؤول. لذلك، لتكييف نماذج اللغة للمهام النهائية، يستخدم إطار عمل ReFT عملية تدخل التبادل الموزع لإنشاء طريقة فعالة جديدة للمعلمة. علاوة على ذلك، فإن طريقة ReFT عبارة عن مجموعة من التدخلات، ويفرض الإطار أنه بالنسبة لأي تدخلين يعملان على نفس الطبقة، يجب أن تكون مواقع التدخل منفصلة، مع بقاء معلمات جميع وظائف التدخل مستقلة. ونتيجة لذلك، يعد ReFT إطارًا عامًا يشمل التدخلات على التمثيلات المخفية أثناء التمرير الأمامي للنموذج.

ReFT: التجارب والنتائج

لتقييم أدائه مقابل أطر عمل PEFT الحالية، يجري إطار عمل ReFT تجارب عبر أربعة معايير متنوعة لمعالجة اللغات الطبيعية، ويغطي أكثر من 20 مجموعة بيانات، مع الهدف الأساسي وهو تقديم صورة غنية عن كيفية أداء إطار عمل LoReFT في سيناريوهات مختلفة. علاوة على ذلك، عندما يتم تنفيذ إطار عمل LoReFT في الحياة الواقعية، يحتاج المطورون إلى تحديد عدد التدخلات التي يجب تعلمها بالإضافة إلى مواضع الإدخال والطبقات التي سيتم تطبيق كل منها عليها. لإكمال المهمة، يقوم إطار عمل ReFT بضبط أربعة معلمات تشعبية.

- عدد مواضع البادئة التي سيتم التدخل فيها.

- عدد مواضع اللاحقة التي سيتم التدخل فيها.

- ما هي مجموعة الطبقات للتدخل فيها.

- ما إذا كان سيتم ربط معلمات التدخل عبر مواضع مختلفة في نفس الطبقة أم لا.

من خلال القيام بذلك، يعمل إطار عمل ReFT على تبسيط مساحة بحث المعلمات الفائقة، ويضمن فقط تكلفة استدلال إضافية ثابتة لا تتوسع مع طول الموجه.

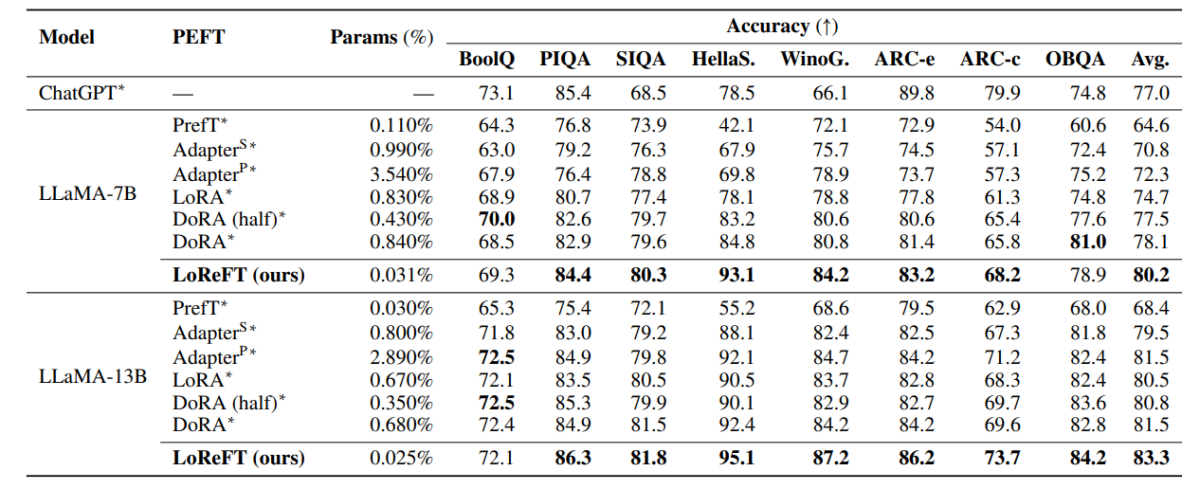

يقارن الجدول أعلاه دقة أطر عمل LLaMA-7B وLLaMA-13B مع نماذج PEFT الحالية عبر 8 مجموعات بيانات منطقية. كما يمكن ملاحظته، يتفوق نموذج LoReFT على أساليب PEFT الحالية بهامش مناسب، على الرغم من وجود معلمات أقل بكثير، مع الإبلاغ عن متوسط الأداء لثلاث عمليات تشغيل باستخدام بذور معلمات مميزة لنموذج LoReFT. يتم حساب المعلمة (%) عن طريق قسمة عدد المعلمات القابلة للتدريب على عدد المعلمات الإجمالية للنموذج الكبير الأساسي.

يلخص الجدول أعلاه مقارنة دقة أطر عمل LLaMA-7B وLLaMA-13B مع نماذج PEFT الحالية عبر 4 مجموعات بيانات مختلفة للاستدلال الحسابي، حيث يُبلغ الإطار عن متوسط الأداء لثلاث عمليات تشغيل ببذور عشوائية متميزة. كما يمكن ملاحظته، على الرغم من وجود عدد أقل بكثير من المعلمات (٪)، فإن إطار عمل LoReFT يتفوق على أطر عمل PEFT الحالية بهامش كبير.

يلخص الجدول أعلاه مقارنة دقة إطاري RoBERTa-base وRoBERTa-large مع نماذج PEFT الحالية عبر معيار GLUE، مع الإبلاغ عن الإطار متوسط الأداء لخمسة أشواط ببذور عشوائية متميزة. كما يمكن ملاحظته، على الرغم من وجود عدد أقل بكثير من المعلمات (٪)، فإن إطار عمل LoReFT يتفوق على أطر عمل PEFT الحالية بهامش كبير.

افكار اخيرة

في هذه المقالة، تحدثنا عن LoReFT، وهو بديل قوي لأطر عمل PEFT الحالية التي تحقق أداءً قويًا عبر المعايير من أربعة مجالات مختلفة مع تقديم ما يصل إلى 50 ضعف الكفاءة التي تقدمها نماذج PEFT الحديثة السابقة. غالبًا ما يتم ضبط النماذج الكبيرة المدربة مسبقًا بشكل دقيق لاستخدامها في المجالات أو المهام الجديدة، وأثناء عملية الضبط الدقيق، يمكن تكييف نموذج أساسي واحد مع مجموعة واسعة من المهام حتى مع توفر كميات صغيرة فقط من البيانات الموجودة في المجال إلى النموذج. ومع ذلك، فإن عملية الضبط الدقيق للنموذج بأكمله تستهلك الموارد، ومكلفة، خاصة بالنسبة لنماذج اللغة التي تحتوي على عدد أكبر بكثير من الحجم والمعلمات. تقترح أساليب الضبط الدقيق ذات كفاءة المعلمات أو أساليب PeFT معالجة التكاليف المرتفعة المرتبطة بضبط النموذج بأكمله عن طريق تحديث كمية صغيرة فقط من إجمالي الأوزان المتاحة، وهي عملية تساعد في تقليل وقت التدريب إلى جانب استخدام الذاكرة. والجدير بالذكر أن LoReFT ينشئ أداءً جديدًا متطورًا في التفكير المنطقي ومتابعة التعليمات وفهم اللغة الطبيعية في مواجهة أقوى PEFTs.