视频生成器

为什么生成视频系统不能制作完整的电影?

生成式人工智能视频的出现和进步促使许多普通观察者 预测 机器学习将证明我们所知的电影业的消亡——相反,单个创作者将能够在家里通过本地或基于云端的 GPU 系统创作好莱坞风格的大片。

这可能吗?即使可能, 即将来临,正如很多人所相信的那样?

个人最终将能够以我们所知的形式制作出具有一致的角色、叙事连续性和完全的照片真实感的电影,这是完全可能的,甚至是不可避免的。

然而,有几个真正根本的原因导致这种情况不太可能发生在基于 潜在扩散模型.

最后这一点很重要,因为目前这一类别包括 每周 流行的文本到视频 (T2) 和图像到视频 (I2V) 系统,包括 Minimax、Kling、Sora、Imagen、Luma、Amazon Video Generator、Runway ML、Kaiber(以及据我们所知,Adobe Firefly 的 有待 视频功能); 许多 其他类.

在这里,我们正在考虑真正的 作者 由个人创作的完整版人工智能作品,其角色、摄影和视觉效果至少与好莱坞目前的水平相当。

让我们来看看所涉及的挑战所面临的一些最大的实际障碍。

1:你无法进行准确的后续击球

叙事不一致是这些障碍中最大的一个。事实上,目前还没有哪个视频生成系统能够真正准确地生成“后续”镜头*。

这是因为 去噪扩散模型 这些系统的核心依赖于 随机噪声,而这一核心原则并不适用于两次重新演绎完全相同的内容(即从不同的角度,或将前一个镜头发展为与前一个镜头保持一致性的后续镜头)。

单独或与文字提示一起使用时 上传的“种子”图像 (多模态输入), 令牌 从提示中得出的句子将从受过训练的 潜在空间 模型的

然而,由于“随机噪声”因素的进一步阻碍,它将 永远不要用同样的方式做两次.

这意味着视频中人物的身份会发生转变,物体和环境也不会与最初的镜头相匹配。

这就是为什么描绘非凡视觉效果和好莱坞级输出的病毒剪辑往往是单镜头,或者是系统功能的“展示蒙太奇”,其中每个镜头都具有不同的角色和环境。

摘自 Marco van Hylckama Vlieg 的生成式 AI 蒙太奇 - 来源:https://www.linkedin.com/posts/marcovhv_thanks-to-generative-ai-we-are-all-filmmakers-activity-7240024800906076160-nEXZ/

这些收藏品的含义 特设 视频生成(在商业系统的情况下可能不诚实)是底层系统 能够 创建连续且一致的叙述。

这里所用的比喻是电影预告片,其中只包含一两分钟的电影镜头,但却让观众有理由相信整部电影都是存在的。

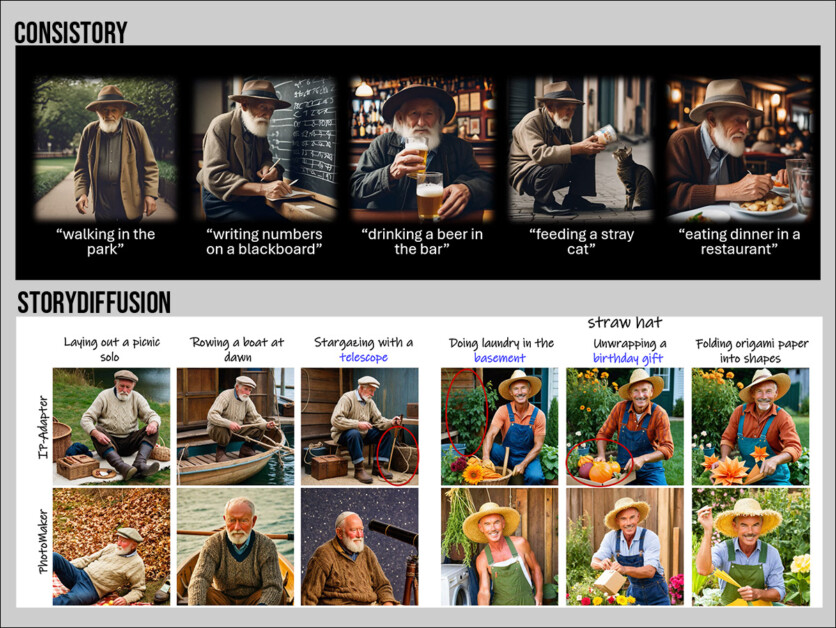

目前,唯一能够在扩散模型中提供叙事一致性的系统是那些生成静态图像的系统。其中包括 NVIDIA 的 共识故事以及科学文献中的各种项目,例如 剧院创客, 梦幻故事和 故事扩散.

来自最新模型的两个“静态”叙事连续性示例:来源:https://research.nvidia.com/labs/par/consistory/ 和 https://arxiv.org/pdf/2405.01434

理论上,人们可以使用此类系统的更好版本(以上都不是真正一致的)来创建一系列图像到视频的镜头,这些镜头可以串在一起形成一个序列。

在目前的技术水平下,这种方法无法产生合理的后续射击;而且,无论如何,我们已经偏离了 作者 通过增加一层复杂性来实现梦想。

另外,我们还可以使用 低秩适应 (LoRA)模型,专门针对角色、事物或环境进行训练,以在镜头间保持更好的一致性。

然而,如果一个角色希望穿着一套新服装出现,通常需要训练一个全新的 LoRA 来体现穿着这种服装的角色(尽管诸如“红色连衣裙”之类的子概念可以与相应的图像一起训练成单独的 LoRA,但它们并不总是容易使用)。

这增加了相当大的复杂性,甚至在电影的开场场景中也是如此:一个人起床,穿上睡袍,打哈欠,看着卧室的窗外,然后去浴室刷牙。

这样的场景大约包含 4-8 个镜头,可以用传统的电影制作程序在一个早上拍摄完成;按照目前生成式人工智能的最新水平,它可能代表着数周的工作、多个经过训练的 LoRA(或其他辅助系统)以及大量的后期处理

或者,也可以使用视频到视频的方式,通过文本提示将普通或 CGI 镜头转换为其他解释。 提供 例如这样的系统。

来自 Blender 的 CGI(左),由 Mathieu Visnjevec 在文本辅助的 Runway 视频到视频实验中进行解释 - 来源:https://www.linkedin.com/feed/update/urn:li:activity:7240525965309726721/

这里有两个问题:你已经必须制作核心素材,所以你已经在制作电影了 两次即使你使用的是 UnReal 的合成系统 元人类.

如果您创建 CGI 模型(如上面的剪辑所示)并将其用于视频到图像的转换,则不能依赖它们在各个镜头中的一致性。

这是因为视频传播模型看不到“全局”,而是根据前一帧创建新的帧,并且, 一些 例,考虑附近的未来框架;但是,将这个过程比作一场象棋比赛,他们无法思考“未来十步”,也无法记住后面十步。

其次,由于本节开头提到的原因,即使您为角色、环境和灯光风格添加了多个 LoRA,扩散模型仍然难以在镜头中保持一致的外观。

2:你无法轻松编辑镜头

如果您使用老式 CGI 方法描绘一个在街上行走的角色,并且决定要更改镜头的某些方面,则可以调整模型并再次渲染。

如果是真实拍摄,您只需重置并再次拍摄,并进行适当的更改。

然而,如果你制作了一个你喜欢的 gen-AI 视频镜头,但想改变 一方面 其中,你只能通过过去 30-40 年来开发的艰苦的后期制作方法来实现这一点:CGI、转描、建模和抠图——所有这些都是劳动密集型且昂贵的, 耗时的 程序。

扩散模型的工作方式是,只需改变文本提示的一个方面(即使在多模式提示中,你提供完整的源种子图像)就会改变 多方面 生成的输出,从而引发“打地鼠”游戏。

3:你不能依赖物理定律

传统的 CGI 方法提供了多种基于算法物理的模型,可以模拟流体动力学、气体运动、逆运动学(人体运动的精确建模)、布料动力学、爆炸以及其他各种现实世界现象。

然而,正如我们所见,基于扩散的方法记忆时间短,而且范围有限。 运动先验 (此类动作的示例,包含在训练数据集中)可供借鉴。

在 早期版本 OpenAI 在其广受好评的 Sora 生成系统登陆页面上承认,Sora 在这方面存在局限性(尽管这段文字后来已被删除):

“[Sora] 可能难以模拟复杂场景的物理特性,并且可能无法理解因果关系的具体实例(例如:角色咬饼干后可能不会留下痕迹)。

“该模型可能还会混淆提示中包含的空间细节,例如辨别左右,或者难以准确描述随时间展开的事件,例如特定的摄像机轨迹。”

各种基于 API 的生成视频系统的实际使用表明,它们在描述精确的物理现象方面存在类似的局限性。不过,某些常见的物理现象(如爆炸)似乎在其训练数据集中得到了更好的表现。

一些运动先验嵌入(无论是训练到生成模型中,还是从源视频中输入)需要一段时间才能完成(例如,一个人穿着精致的服装表演一段复杂且非重复的舞蹈动作)。同样,由于扩散模型的短视注意力窗口,在动作完成时,内容(面部识别、服装细节等)可能会发生变化。不过,LoRA 可以在一定程度上缓解这种情况。

在后期修复

纯“单用户”AI 视频生成还存在其他缺点,例如 困难 他们在描绘快速运动时所面临的普遍而更为紧迫的问题 获得时间一致性 在输出视频中。

此外,在生成视频中,创建特定的面部表演很大程度上取决于运气,就像对话的口型同步一样。

在这两种情况下,使用辅助系统,如 现场肖像 与 动画差异 在 VFX 社区中变得非常流行,因为它允许将至少广泛的面部表情和口型同步转置到现有的生成输出中。

使用 LivePortrait 将表情转换(左下角的驾驶视频)应用于目标视频的示例。该视频来自 Generative Z TunisiaGenerative。请前往 https://www.linkedin.com/posts/genz-tunisia_digitalcreation-liveportrait-aianimation-activity-7240776811737972736-uxiB/? 查看更高质量的完整版本

此外,还有无数复杂的解决方案,包括稳定扩散 GUI 等工具 舒适用户界面 以及专业的合成和处理应用程序 核弹以及潜在的空间操纵,使AI VFX从业者能够更好地控制面部表情和情绪。

虽然他 介绍 ComfyUI 中的面部动画制作过程被视作一种“折磨”,视觉特效专家 Francisco Contreras 开发了这样一种程序,可以添加唇音以及面部/头部描绘的其他方面。

Stable Diffusion 在 Nuke 驱动的 ComfyUI 工作流程的帮助下,让视觉特效专家 Francisco Contreras 能够对面部特征进行不同寻常的控制。如需观看分辨率更高的完整视频,请访问 https://www.linkedin.com/feed/update/urn:li:activity:7243056650012495872/

结语

对于单个用户生成连贯且逼真的大片风格的完整电影(具有逼真的对话、口型同步、表演、环境和连续性)的前景来说,这一切都不乐观。

此外,尽管论坛评论和媒体关注表明了这一点,但本文所述的障碍,至少与基于扩散的生成视频模型相关的障碍,目前并不一定“随时”就能解决。所描述的限制似乎是该架构固有的。

在人工智能综合研究中,就像在所有科学研究中一样,一些绝妙的想法会定期以其潜力让我们眼花缭乱,但需要进一步研究才能发掘其根本的局限性。

在生成/合成领域,这已经在生成对抗网络中发生了(GAN) 和神经辐射场 (神经RF),尽管多年来学术界一直致力于这一目标的研究,但最终证明这两项技术都很难融入高性能的商业系统。这些技术现在最常作为替代架构中的附加组件出现。

电影制片厂可能希望通过对合法授权的电影目录进行培训, 淘汰视觉特效艺术家,人工智能实际上 添加 目前劳动力所扮演的角色。

基于扩散的视频系统是否真的可以转变为具有叙事一致性和真实感的电影生成器,或者整个行业是否只是另一种炼金术追求,应该在未来 12 个月内变得显而易见。

也许我们需要一种全新的方法;或者 高斯泼溅 (GSplat),这是1990 世纪初期 并且最近 起飞了 在图像合成领域,代表了基于扩散的视频生成的潜在替代方案。

由于 GSplat 花了 34 年的时间才脱颖而出,因此 NeRF 和 GAN 等较老的竞争者——甚至潜在扩散模型——可能也尚未崭露头角。

* 虽然 Kaiber 的 AI Storyboard 功能 提供这种功能,我看到的结果是 非生产质量.

Martin Anderson 曾任 metaphysic.ai 科学研究内容主管

首次发布于 23 年 2024 月 XNUMX 日星期一