机器人

机器人如何学习寻求帮助

在不断发展的机器人世界中,普林斯顿大学和谷歌之间的突破性合作脱颖而出。 来自这些著名机构的工程师开发了一种创新方法,可以教会机器人一项关键技能:识别何时需要帮助以及如何寻求帮助。 这一发展标志着机器人技术的重大飞跃,弥合了自主功能和人机交互之间的差距。

迈向更智能、更独立的机器人之路始终受到一项重大挑战的阻碍:人类语言的复杂性和模糊性。 与计算机代码的二进制清晰度不同,人类语言充满了细微差别和微妙之处,使其成为机器人的迷宫。 例如,当存在多个碗时,像“拿起碗”这样简单的命令可能会变成一项复杂的任务。 机器人能够感知环境并对语言做出反应,但在面对这种语言上的不确定性时,它们常常发现自己处于十字路口。

量化不确定性

为了应对这一挑战,普林斯顿大学和谷歌团队推出了一种新颖的方法来量化人类语言的“模糊性”。 该技术本质上测量语言命令的不确定性水平,并使用该指标来指导机器人动作。 在命令可能导致多种解释的情况下,机器人现在可以衡量不确定性的程度并决定何时寻求进一步的澄清。 例如,在有多个碗的环境中,较高程度的不确定性会促使机器人询问要拿起哪个碗,从而避免潜在的错误或低效率。

这种方法不仅使机器人能够更好地理解语言,而且还提高了它们执行任务的安全性和效率。 通过集成 ChatGPT 背后的大型语言模型 (LLM),研究人员在使机器人动作更符合人类期望和需求方面迈出了重要一步。

大型语言模型的作用

法学硕士的整合在这种新方法中发挥着关键作用。 法学硕士有助于处理和解释人类语言。 在这种情况下,它们用于评估和测量机器人语言命令中存在的不确定性。

然而,对法学硕士的依赖也并非没有挑战。 正如研究团队所指出的,法学硕士的输出有时可能不可靠。

普林斯顿大学助理教授 Anirudha Majumdar 强调了这种平衡的重要性:

“盲目遵循法学硕士制定的计划可能会导致机器人以不安全或不值得信任的方式行事,因此我们需要基于法学硕士的机器人知道它们何时不知道。”

这凸显了采取细致入微的方法的必要性,其中法学硕士被用作指导工具,而不是万无一失的决策者。

实际应用与测试

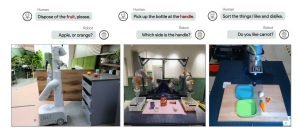

该方法的实用性已经在各种场景中得到测试,说明了其通用性和有效性。 其中一项测试涉及机械臂,其任务是将玩具食品分类为不同的类别。 这个简单的设置证明了机器人能够通过明确的选择有效地导航任务。

图片:普林斯顿大学

另一项实验的复杂性显着增加,该实验将机械臂安装在办公室厨房的轮式平台上。 在这里,机器人面临着现实世界的挑战,例如在出现多个选项时识别要放入微波炉的正确物品。

通过这些测试,机器人成功地展示了它们利用量化的不确定性做出决策或寻求澄清的能力,从而验证了该方法的实际效用。

未来的影响和研究

展望未来,这项研究的影响远远超出了当前的应用范围。 由 Majumdar 和研究生 Allen Ren 领导的团队正在探索如何将这种方法应用于机器人感知和人工智能中更复杂的问题。 这包括机器人需要结合视觉和语言信息来做出决策的场景,进一步缩小机器人理解和人类交互之间的差距。

正在进行的研究不仅旨在增强机器人以更高精度执行任务的能力,而且还以类似于人类认知的理解方式驾驭世界。 这项研究可以为机器人铺平道路,使机器人不仅更高效、更安全,而且更符合人类环境的微妙需求。

您可以找到已发表的研究 点击此处.