- Thuật ngữ (A đến D)

- Kiểm soát khả năng AI

- CỨU

- albumentation

- Hiệu suất tài sản

- Tự động mã hóa

- Lan truyền ngược

- Định lý Bayes

- Dữ Liệu Lớn.

- Chatbot: Hướng dẫn cho người mới bắt đầu

- Tư duy tính toán

- Tầm nhìn máy tính

- Ma trận hỗn loạn

- Mạng lưới thần kinh chuyển đổi

- An ninh mạng

- Vải dữ liệu

- Kể chuyện dữ liệu

- Khoa học dữ liệu

- Kho dữ liệu

- Cây quyết định

- Deepfakes

- Học kĩ càng

- Học tập củng cố sâu

- DevOps

- DevSecOps

- Mô hình khuếch tán

- Twin kỹ thuật số

- Giảm kích thước

- Thuật ngữ (E đến K)

- Cạnh AI

- Cảm xúc AI

- học hòa tấu

- Hacking đạo đức

- ETL

- AI có thể giải thích

- Học liên kết

- FinOps

- Trí tuệ nhân tạo

- Mạng đối thủ sáng tạo

- Sáng tạo so với phân biệt đối xử

- Tăng cường Gradient

- Xuống dốc

- Học vài lần

- Phân loại hình ảnh

- Hoạt động CNTT (ITOPs)

- Tự động hóa sự cố

- Kỹ thuật gây ảnh hưởng

- Phân cụm K-Means

- K-Những người hàng xóm gần nhất

- Thuật ngữ (L đến Q)

- Thuật ngữ (R đến Z)

- Học tăng cường

- AI có trách nhiệm

- RLHF

- Tự động hóa quá trình robot

- Có cấu trúc so với không có cấu trúc

- Phân tích tình cảm

- Giám sát vs Không giám sát

- Hỗ trợ Máy Vector

- Dữ liệu tổng hợp

- truyền thông tổng hợp

- Phân loại văn bản

- TinyML

- Chuyển giao học tập

- Mạng thần kinh biến áp

- Phép thử Turing

- Tìm kiếm sự giống nhau của vectơ

AI 101

Quá mức là gì?

Mục lục

Quá mức là gì?

Khi bạn đào tạo một mạng lưới thần kinh, bạn phải tránh trang bị quá mức. trang bị quá mức là một vấn đề trong học máy và thống kê, trong đó một mô hình học quá tốt các mẫu của tập dữ liệu huấn luyện, giải thích một cách hoàn hảo tập dữ liệu huấn luyện nhưng không khái quát được khả năng dự đoán của nó cho các tập dữ liệu khác.

Nói cách khác, trong trường hợp mô hình trang bị quá mức, nó thường cho thấy độ chính xác cực cao trên tập dữ liệu huấn luyện nhưng độ chính xác thấp trên dữ liệu được thu thập và chạy qua mô hình trong tương lai. Đó là một định nghĩa ngắn gọn về overfitting, nhưng chúng ta hãy xem xét khái niệm overfitting một cách chi tiết hơn. Chúng ta hãy xem quá mức xảy ra như thế nào và làm thế nào để tránh nó.

Hiểu về “Fit” và Underfitting

Sẽ rất hữu ích khi xem xét khái niệm về trang bị thiếu và “phù hợp với” nói chung khi thảo luận về việc trang bị quá mức. Khi đào tạo một mô hình, chúng tôi đang cố gắng phát triển một khung có khả năng dự đoán tính chất hoặc loại của các mục trong tập dữ liệu, dựa trên các tính năng mô tả các mục đó. Một mô hình phải có khả năng giải thích một mẫu trong tập dữ liệu và dự đoán các lớp điểm dữ liệu trong tương lai dựa trên mẫu này. Mô hình càng giải thích rõ ràng mối quan hệ giữa các tính năng của tập huấn luyện thì mô hình của chúng ta càng “phù hợp”.

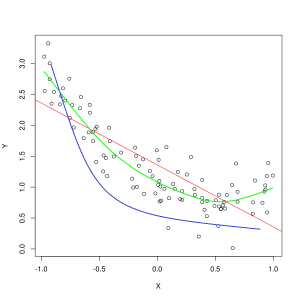

Đường màu xanh biểu thị dự đoán của một mô hình không phù hợp, trong khi đường màu xanh biểu thị mô hình phù hợp hơn. Ảnh: Pep Roca qua Wikimedia Commons, CC BY SA 3.0, (https://commons.wikimedia.org/wiki/File:Reg_ls_curvil%C3%ADnia.svg)

Một mô hình giải thích kém mối quan hệ giữa các tính năng của dữ liệu huấn luyện và do đó không thể phân loại chính xác các ví dụ dữ liệu trong tương lai là thiếu trang bị các dữ liệu đào tạo. Nếu bạn vẽ biểu đồ mối quan hệ được dự đoán của một mô hình thiếu phù hợp so với giao điểm thực tế của các tính năng và nhãn, thì các dự đoán sẽ sai lệch. Nếu chúng ta có một biểu đồ với các giá trị thực của một tập huấn luyện được gắn nhãn, thì một mô hình thiếu phù hợp nghiêm trọng sẽ bỏ lỡ hầu hết các điểm dữ liệu. Một mô hình phù hợp hơn có thể cắt một đường đi qua trung tâm của các điểm dữ liệu, với các điểm dữ liệu riêng lẻ chỉ sai lệch một chút so với giá trị dự đoán.

Trang bị thiếu thường có thể xảy ra khi không có đủ dữ liệu để tạo một mô hình chính xác hoặc khi cố gắng thiết kế một mô hình tuyến tính với dữ liệu phi tuyến tính. Nhiều dữ liệu đào tạo hơn hoặc nhiều tính năng hơn thường sẽ giúp giảm bớt tình trạng thiếu trang phục.

Vậy tại sao chúng ta không tạo một mô hình giải thích mọi điểm trong dữ liệu đào tạo một cách hoàn hảo? Chắc chắn độ chính xác hoàn hảo là mong muốn? Việc tạo ra một mô hình đã học quá tốt các mẫu của dữ liệu huấn luyện là nguyên nhân gây ra tình trạng thừa. Tập dữ liệu đào tạo và các tập dữ liệu khác trong tương lai mà bạn chạy qua mô hình sẽ không hoàn toàn giống nhau. Chúng có thể sẽ rất giống nhau ở nhiều khía cạnh, nhưng chúng cũng sẽ khác nhau ở những điểm chính. Do đó, thiết kế một mô hình giải thích tập dữ liệu huấn luyện một cách hoàn hảo có nghĩa là bạn kết thúc với một lý thuyết về mối quan hệ giữa các tính năng không khái quát hóa tốt cho các tập dữ liệu khác.

Hiểu về trang bị quá mức

Quá khớp xảy ra khi một mô hình tìm hiểu quá rõ các chi tiết trong tập dữ liệu huấn luyện, khiến mô hình bị ảnh hưởng khi dự đoán được thực hiện trên dữ liệu bên ngoài. Điều này có thể xảy ra khi mô hình không chỉ tìm hiểu các tính năng của tập dữ liệu mà còn tìm hiểu các biến động ngẫu nhiên hoặc tiếng ồn trong tập dữ liệu, đặt tầm quan trọng cho những lần xuất hiện ngẫu nhiên/không quan trọng này.

Việc trang bị quá mức có nhiều khả năng xảy ra hơn khi sử dụng các mô hình phi tuyến tính, vì chúng linh hoạt hơn khi học các tính năng dữ liệu. Các thuật toán học máy phi tham số thường có nhiều tham số và kỹ thuật khác nhau có thể được áp dụng để hạn chế độ nhạy của mô hình đối với dữ liệu và do đó giảm tình trạng thừa. Như một ví dụ, mô hình cây quyết định rất nhạy cảm với việc trang bị thừa, nhưng một kỹ thuật gọi là cắt tỉa có thể được sử dụng để loại bỏ ngẫu nhiên một số chi tiết mà mô hình đã học được.

Nếu bạn vẽ biểu đồ dự đoán của mô hình trên trục X và Y, bạn sẽ có một đường dự đoán ngoằn ngoèo qua lại, điều này phản ánh thực tế là mô hình đã quá cố gắng để phù hợp với tất cả các điểm trong tập dữ liệu. lời giải thích của nó.

Kiểm soát quá mức

Khi chúng tôi đào tạo một mô hình, lý tưởng nhất là chúng tôi muốn mô hình đó không mắc lỗi. Khi hiệu suất của mô hình hội tụ để đưa ra dự đoán chính xác trên tất cả các điểm dữ liệu trong tập dữ liệu huấn luyện, sự phù hợp sẽ trở nên tốt hơn. Một mô hình phù hợp tốt có thể giải thích hầu hết tất cả các tập dữ liệu huấn luyện mà không bị quá khớp.

Khi một mô hình đào tạo, hiệu suất của nó được cải thiện theo thời gian. Tỷ lệ lỗi của mô hình sẽ giảm khi thời gian đào tạo trôi qua, nhưng nó chỉ giảm đến một điểm nhất định. Điểm mà tại đó hiệu suất của mô hình trên tập kiểm tra bắt đầu tăng trở lại thường là điểm xảy ra hiện tượng overfitting. Để có được mô hình phù hợp nhất, chúng tôi muốn dừng đào tạo mô hình tại điểm mất mát thấp nhất trên tập huấn luyện, trước khi lỗi bắt đầu tăng trở lại. Điểm dừng tối ưu có thể được xác định bằng cách vẽ biểu đồ hiệu suất của mô hình trong suốt thời gian đào tạo và dừng đào tạo khi tổn thất thấp nhất. Tuy nhiên, một rủi ro với phương pháp kiểm soát việc trang bị quá mức này là việc chỉ định điểm cuối cho quá trình huấn luyện dựa trên hiệu suất kiểm tra có nghĩa là dữ liệu kiểm tra phần nào được đưa vào quy trình huấn luyện và nó sẽ mất trạng thái là dữ liệu hoàn toàn “chưa được xử lý”.

Có một số cách khác nhau mà người ta có thể chống lại việc trang bị quá mức. Một phương pháp để giảm việc trang bị thừa là sử dụng chiến thuật lấy mẫu lại, hoạt động bằng cách ước tính độ chính xác của mô hình. Bạn cũng có thể sử dụng một xác nhận tập dữ liệu bổ sung cho tập kiểm tra và vẽ đồ thị độ chính xác huấn luyện dựa trên tập hợp lệ thay vì tập dữ liệu kiểm tra. Điều này giữ cho tập dữ liệu thử nghiệm của bạn không bị lộ. Một phương pháp lấy mẫu lại phổ biến là xác thực chéo K-folds. Kỹ thuật này cho phép bạn chia dữ liệu của mình thành các tập hợp con mà mô hình được đào tạo và sau đó hiệu suất của mô hình trên các tập hợp con được phân tích để ước tính mô hình sẽ hoạt động như thế nào trên dữ liệu bên ngoài.

Việc sử dụng xác thực chéo là một trong những cách tốt nhất để ước tính độ chính xác của mô hình trên dữ liệu không nhìn thấy và khi được kết hợp với bộ dữ liệu xác thực, quá mức thường có thể được giữ ở mức tối thiểu.

Blogger và lập trình viên có chuyên môn về Machine Learning và Học kĩ càng chủ đề. Daniel hy vọng sẽ giúp những người khác sử dụng sức mạnh của AI vì lợi ích xã hội.