Штучний Інтелект

Проблема чорної скриньки в LLMs: виклики та нові рішення

Машинне навчання, підмножина штучного інтелекту, включає три компоненти: алгоритми, навчальні дані та кінцеву модель. Алгоритм, по суті набір процедур, навчається ідентифікувати шаблони з великого набору прикладів (навчальних даних). Кульмінацією цього навчання є модель машинного навчання. Наприклад, алгоритм, навчений із зображеннями собак, приведе до моделі, здатної ідентифікувати собак на зображеннях.

Чорний ящик у машинному навчанні

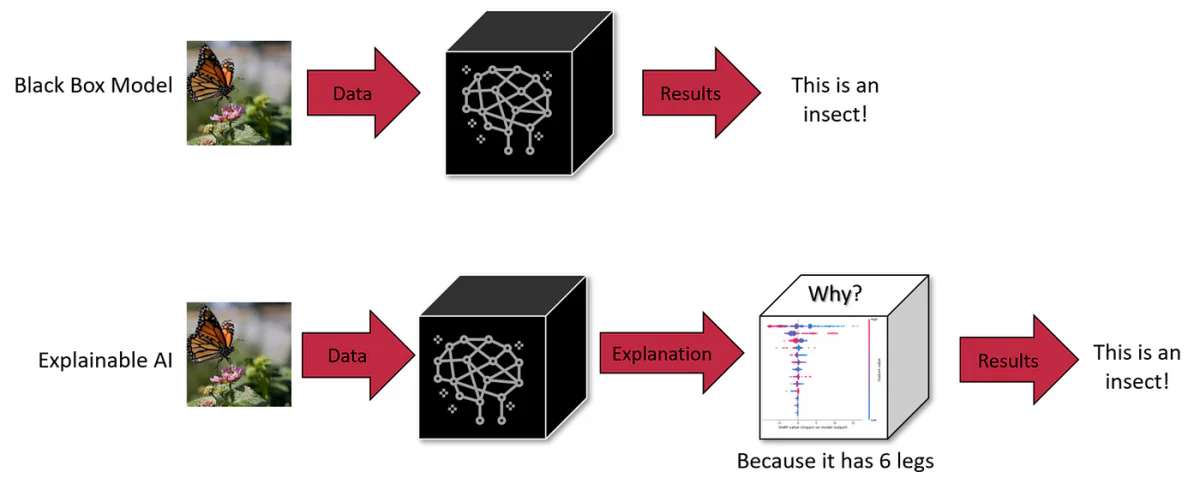

У машинному навчанні будь-який із трьох компонентів — алгоритм, навчальні дані або модель — може бути чорним ящиком. Хоча алгоритми часто загальновідомі, розробники можуть вирішити зберегти модель або навчальні дані в секреті для захисту інтелектуальної власності. Ця невідомість ускладнює розуміння процесу прийняття рішень ШІ.

Чорні ящики штучного інтелекту – це системи, внутрішня робота яких залишається непрозорою або невидимою для користувачів. Користувачі можуть вводити дані та отримувати вихідні дані, але логіка або код, які створюють вихідні дані, залишаються прихованими. Це загальна характеристика багатьох систем штучного інтелекту, включаючи просунуті генеративні моделі, такі як ChatGPT і DALL-E 3.

LLM, такі як GPT-4, представляють серйозну проблему: їхня внутрішня робота значною мірою непрозора, що робить їх «чорними ящиками». Така непрозорість — це не просто технічна загадка; це створює реальні проблеми безпеки та етики. Наприклад, якщо ми не можемо розрізнити, як ці системи роблять висновки, чи можемо ми довіряти їм у таких критичних областях, як медичні діагнози чи фінансові оцінки?

Масштаб і складність LLM

Масштаб цих моделей додає їх складності. Візьмемо, наприклад, GPT-3 із 175 мільярдами параметрів, а новіші моделі мають трильйони. Кожен параметр складно взаємодіє в нейронній мережі, сприяючи виникненню можливостей, які неможливо передбачити, досліджуючи окремо окремі компоненти. Через такий масштаб і складність майже неможливо повністю зрозуміти їхню внутрішню логіку, створюючи перешкоду для діагностики упереджень або небажаної поведінки в цих моделях.

Компроміс: масштаб проти інтерпретованості

Зменшення масштабу LLM може покращити інтерпретацію, але ціною їхніх розширених можливостей. Масштаб – це те, що забезпечує поведінку, якої менші моделі не можуть досягти. Це є властивим компромісом між масштабом, можливостями та інтерпретацією.

Вплив проблеми чорної скриньки LLM

1. Неправильне прийняття рішень

Непрозорість у процесі прийняття рішень LLM, таких як GPT-3 або BERT, може призвести до невиявлених упереджень і помилок. У таких сферах, як охорона здоров’я чи кримінальне правосуддя, де рішення мають далекосяжні наслідки, нездатність перевірити етичну та логічну обґрунтованість магістратури є серйозною проблемою. Наприклад, медичний діагноз LLM, який спирається на застарілі або упереджені дані, може дати шкідливі рекомендації. Подібним чином магістри права в процесі найму можуть ненавмисно закріпити гендерні упередження. Таким чином, природа чорного ящика не тільки приховує недоліки, але й потенційно може посилити їх, що вимагає проактивного підходу для підвищення прозорості.

2. Обмежена адаптованість у різноманітних контекстах

Відсутність розуміння внутрішньої роботи LLMs обмежує їх адаптивність. Наприклад, наймаючий LLM може бути неефективним в оцінюванні кандидатів на посаду, яка цінує практичні навички над академічною кваліфікацією, через його нездатність скорегувати свої критерії оцінювання. Подібним чином медичний магістр права може мати проблеми з діагностикою рідкісних захворювань через дисбаланс даних. Ця негнучкість підкреслює потребу в прозорості для повторного калібрування LLM для конкретних завдань і контекстів.

3. Упередженість і прогалини в знаннях

Обробка LLM величезних навчальних даних підлягає обмеженням, накладеним їхніми алгоритмами та архітектурою моделей. Наприклад, медичний LLM може виявити демографічні упередження, якщо навчатися на незбалансованих наборах даних. Крім того, кваліфікація LLM у нішевих темах може ввести в оману, що призведе до надто самовпевнених, неправильних результатів. Щоб усунути ці упередження та прогалини в знаннях, потрібні більше, ніж просто додаткові дані; це вимагає перевірки механіки обробки моделі.

4. Юридична та етична відповідальність

Незрозумілий характер LLM створює сіру юридичну зону щодо відповідальності за будь-яку шкоду, заподіяну їхніми рішеннями. Якщо магістр права в медичному закладі надає помилкові поради, що призводять до шкоди пацієнту, визначення відповідальності стає складним через непрозорість моделі. Ця правова невизначеність створює ризики для організацій, які розгортають LLM у чутливих областях, підкреслюючи необхідність чіткого управління та прозорості.

5. Проблеми довіри в конфіденційних програмах

Що стосується LLM, які використовуються в таких важливих сферах, як охорона здоров’я та фінанси, відсутність прозорості підриває їх надійність. Користувачі та регулятори повинні переконатися, що ці моделі не містять упереджень і не приймають рішення на основі несправедливих критеріїв. Перевірка відсутності упередженості в LLM вимагає розуміння їхніх процесів прийняття рішень, підкреслюючи важливість пояснення для етичного розгортання.

6. Ризики з персональними даними

LLM вимагає обширних навчальних даних, які можуть включати конфіденційну особисту інформацію. Характер чорної скриньки цих моделей викликає занепокоєння щодо того, як ці дані обробляються та використовуються. Наприклад, медичний магістр права, який пройшов навчання щодо записів пацієнтів, викликає питання щодо конфіденційності та використання даних. Забезпечення того, щоб персональні дані не використовувалися неналежним чином, вимагає прозорих процесів обробки даних у цих моделях.

Нові рішення для інтерпретації

Щоб вирішити ці проблеми, розробляються нові методи. До них відносяться контрфактичні (CF) методи апроксимації. Перший метод передбачає спонукання LLM змінити певну концепцію тексту, зберігаючи інші концепції незмінними. Цей підхід, хоч і ефективний, вимагає ресурсів під час висновку.

Другий підхід передбачає створення спеціального простору для вбудовування під керівництвом LLM під час навчання. Цей простір узгоджується з причинно-наслідковим графіком і допомагає ідентифікувати збіги, наближені до CF. Цей метод потребує менше ресурсів під час тестування та, як було показано, ефективно пояснює прогнози моделі навіть у LLM з мільярдами параметрів.

Ці підходи підкреслюють важливість причинно-наслідкових пояснень у системах НЛП для забезпечення безпеки та встановлення довіри. Контрфактичні наближення дають можливість уявити, як би змінився даний текст, якби певна концепція в процесі його генерації була іншою, допомагаючи в практичній оцінці причинно-наслідкового ефекту концепцій високого рівня на моделях НЛП.

Глибоке занурення: методи пояснення та причинно-наслідкові зв’язки в LLM

Інструменти зондування та важливості ознак

Зондування — це техніка, яка використовується для розшифровки того, що кодують внутрішні представлення в моделях. Він може бути контрольованим або неконтрольованим і спрямований на визначення того, чи конкретні концепції закодовані в певних місцях мережі. Незважаючи на ефективність певної міри, зонди не можуть надати причинно-наслідкові пояснення, як підкреслили Гейгер та ін. (2021).

Інструменти важливості ознак, ще одна форма методу пояснення, часто зосереджуються на вхідних функціях, хоча деякі градієнтні методи поширюють це на приховані стани. Прикладом є метод інтегрованих градієнтів, який пропонує причинно-наслідкову інтерпретацію шляхом вивчення базових (контрфактичних, CF) вхідних даних. Незважаючи на свою корисність, цим методам все ще важко зв’язати свій аналіз із концепціями реального світу, окрім простих вхідних властивостей.

Методи, засновані на втручанні

Методи, засновані на втручанні, передбачають модифікацію вхідних даних або внутрішніх представлень для вивчення впливу на поведінку моделі. Ці методи можуть створювати стани CF для оцінки причинних наслідків, але вони часто генерують неправдоподібні вхідні дані або стани мережі, якщо їх ретельно не контролювати. Причинно-наслідкова проксі-модель (CPM), натхненна концепцією S-учня, є новим підходом у цій сфері, що імітує поведінку поясненої моделі за вхідних даних CF. Однак потреба в окремому поясненні для кожної моделі є основним обмеженням.

Апроксимація контрфактів

Контрафакти широко використовуються в машинному навчанні для збільшення даних, включаючи збурення різних факторів або міток. Їх можна створити за допомогою ручного редагування, евристичної заміни ключових слів або автоматичного переписування тексту. Хоча редагування вручну є точним, воно також вимагає ресурсів. Методи на основі ключових слів мають свої обмеження, а генеративні підходи пропонують баланс між плавністю та охопленням.

Достовірні пояснення

Вірність у поясненнях означає точне відображення основних міркувань моделі. Немає загальноприйнятого визначення вірності, що веде до його характеристики за допомогою різних показників, таких як чутливість, узгодженість, згода важливості функцій, стійкість і можливість імітації. Більшість цих методів зосереджуються на поясненнях на рівні ознак і часто змішують кореляцію з причинно-наслідковим зв’язком. Наша робота спрямована на надання пояснень концепції високого рівня, використовуючи літературу про причинність, щоб запропонувати інтуїтивно зрозумілий критерій: вірність порядку.

Ми заглибились у притаманну складність LLM, зрозумівши їхню природу «чорної скриньки» та значні проблеми, які вона створює. Від ризиків неправильного прийняття рішень у чутливих сферах, таких як охорона здоров’я та фінанси, до етичних труднощів, пов’язаних із упередженістю та справедливістю, потреба в прозорості в LLMs ніколи не була такою очевидною.

Майбутнє LLM та їх інтеграція в наше повсякденне життя та процеси прийняття важливих рішень залежить від нашої здатності зробити ці моделі не лише більш досконалими, але й більш зрозумілими та відповідальними. Прагнення до пояснюваності та інтерпретації — це не просто технічне завдання, а фундаментальний аспект побудови довіри до систем ШІ. У міру того як магістратури стають більш інтегрованими в суспільство, попит на прозорість зростатиме не лише з боку практиків ШІ, але й з боку кожного користувача, який взаємодіє з цими системами.