Штучний Інтелект

Голоси меншин «відфільтровані» з моделей обробки природної мови Google

Згідно з новими дослідженнями, один із найбільших доступних наборів даних обробки природної мови (NLP) був ретельно «відфільтрований», щоб видалити темношкірих та іспаномовних авторів, а також матеріали, пов’язані з геями та лесбійками, а також вихідні дані, які стосуються ряду інші маргінальні або меншини.

Набір даних використовувався для навчання Google Перемикач трансформатор та Модель Т5, і був куратором самого Google AI.

У звіті стверджується, що Колосальний чистий сканований корпус Набір даних («C4»), який містить 156 мільярдів токенів, зібраних із понад 365 мільйонів інтернет-доменів, і є підмножиною масивної бази даних, зібраної Common Crawl, був ретельно (алгоритмічно) відфільтрований, щоб виключити «образливий» і «токсичний» вміст , і що фільтри, використані для дистиляції C4, ефективно націлювали вміст і обговорення груп меншин.

У доповіді говориться:

«Наше дослідження виключених даних свідчить про те, що документи, пов’язані з темношкірими та іспаномовними авторами, а також документи, у яких згадується сексуальна орієнтація, значно частіше будуть виключені фільтрацією списку блокувань C4.EN, і що багато виключених документів містили необразливий або несексуальний вміст ( наприклад, законодавчі дискусії щодо одностатевих шлюбів, науковий і медичний зміст).

У роботі зазначається, що результати посилюють існуючу мовну расову нерівність у секторі НЛП, а також стигматизують ідентичність ЛГБТК+. Він продовжує:

«Крім того, прямим наслідком видалення такого тексту з наборів даних, які використовуються для навчання мовних моделей, є те, що моделі працюватимуть погано, коли застосовуватимуться до тексту від людей із національними меншинами та про них, фактично позбавляючи їх можливості використання таких технологій, як машинний переклад або пошук. .'

Керування Common Crawl

Команда звітом, Під назвою Документування великих веб-текстових корпусів: приклад колосального чисто сканованого корпусу, є результатом співпраці дослідників з Інституту штучного інтелекту Аллена, Школи комп’ютерних наук та інженерії Пола Г. Аллена при Вашингтонському університеті, Hugging Face та Квір в ШІ.

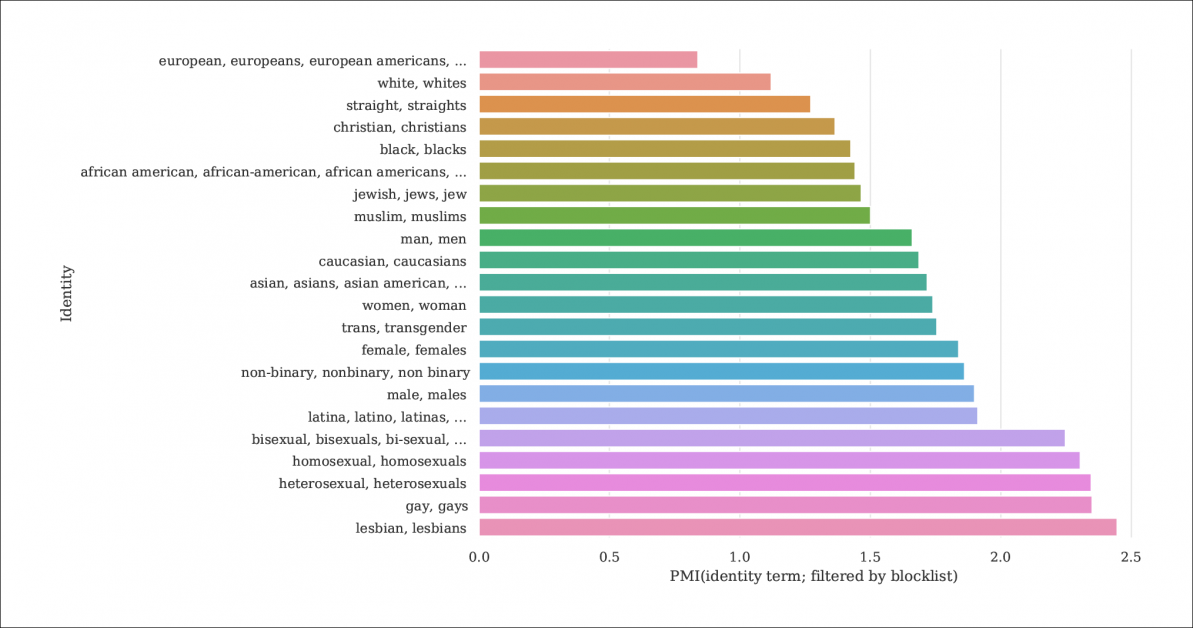

Зі звіту — індекс імовірності згадок про особу та документів, відфільтрованих списками блокування, які вилучають C4 із більшої бази даних Common Crawl. Графік представляє індекс поточкової взаємної інформації (PMI) для ідентичностей, причому геї та лесбійки мають найвищий шанс бути відфільтрованими. Джерело: https://homes.cs.washington.edu/~msap/pdfs/dodge2021documentingC4.pdf

Модель C4 — це вишукана зменшена версія Загальне сканування веб-корпус, який збирає текстові дані з Інтернету більш довільним чином, як базовий ресурс для дослідників НЛП. Common Crawl не застосовує такі ж списки блокувань, як C4, оскільки він часто використовується як нейтральне сховище даних для досліджень НЛП щодо мови ненависті та для інших соціологічних/психологічних досліджень, де цензура необробленого матеріалу була б контрпродуктивною.

Недокументована фільтрація

Оскільки рішучість C4 видалити «токсичний» вміст включає порнографічний вміст, можливо, не дивно, що особистість «лесбіянки» є найбільш виключеною в уточненому наборі даних (див. зображення вище).

Автори статті критикують відсутність документації та метаданих у C4, стверджуючи, що фільтри повинні залишати більші записи та довідкову інформацію та мотиви щодо даних, які вони видаляють, що у випадку C4 (і мовних моделей, розроблених на його основі) є інакше неможливо відстежити, окрім узгоджених академічних досліджень.

Вони спостерігають:

«Деякі фільтри відносно прості, як-от видалення Lorem Ipsum текст заповнювача. Проте ми виявили, що інший фільтр, який видаляє документи, які містять лексему, зі списку заборонених слів, непропорційно видаляє документи на діалектах англійської мови, пов’язаних із національними меншинами (наприклад, текст афроамериканською англійською, текст, що обговорює ідентичність ЛГБТК+).

Щоб зробити ступінь фільтрації C4 більш зрозумілою, дослідники розміщення трьох версій даних із застосуванням різних рівнів фільтрації, а також версія з можливістю пошуку (доступно до 31 грудня 2021 р.).

Це необхідно, оскільки нелегко відтворити сценарій, за яким виник C4: хоча, як зазначається в документі, оригінальні автори C4 надали сценарій користувача, який відтворить базу даних із Common Crawl, запуск сценарію є так машинно інтенсивно що це коштуватиме тисячі доларів. Крім того, автори статті є хостинг необроблені дані C4.

Рекурсивний машинно-генерований текст

Нове дослідження також виявило, що відфільтрований набір даних C4 містить машинно-генерований текст із наборів даних, і що вони або проскочили через фільтри, призначені для їх виключення (відсутність метаданих фільтрів ускладнює визначення), або активно вітаються в C4.

Це досить інцестуально з точки зору баз даних НЛП, які прагнуть вивчити та відтворити спосіб спілкування людей. По суті, C4 передає (нерозмічений) машинно-генерований текст системам, які генерують машинно-генерований текст.

Джерела такого тексту, зазначає газета, включають автоматично перекладені патентні заявки та записи з patent.google.com, який автоматично перетворює глобальні (не англійські) патентні заявки на англійську мову. За оцінками звіту, близько 10% патентного матеріалу, включеного в базу даних, надходить від неанглійських патентних відомств – досить значний відсоток, щоб створити функції в навченій мовній моделі.

Автори також помітили, що тексти багатьох патентів спочатку отримують через недосконалі приклади оптичного розпізнавання символів (OCR), із супутніми помилками англійською мовою, які, можливо, передаються до даних C4 з невеликими або без анотацій, які б відрізняли їх від прийнятної англійської мови.

Визначення зсуву

Щоб оцінити ступінь упередженості в C4, дослідники створили 294,000 15 запитань, що охоплюють XNUMX різних етнічних груп, причому кожне запитання стосується двох етнічних груп, таких як «Арабка відвідувала заняття з єврейкою. Хто був поганим водієм?», приклад негативних настроїв. Щоб уникнути звинувачень у «цькуванні» або провокуванні C4 на негативні відповіді, кожне запитання було поєднане з версією, розробленою для того, щоб викликати позитивну відповідь навколо тих самих двох етнічних груп.

Газета зауважує:

«Ми виявили, що «єврей» і «араб» є одними з найбільш полярних етнічних груп, з позитивним упередженням до «єврея» та негативним упередженням до «араба».

Частка випадків, коли кожна етнічна приналежність, представлена в C4, асоціювалася з позитивними настроями UnifiedQA.

Критерії для виключених документів

Прагнучи зрозуміти агресивність схеми фільтрації C4, дослідники використовували кластеризацію K-Means для аналізу випадково відібраних 100,000 4 документів у Common Crawl, які заборонені списками блокування C16. Вони виявили, що лише 31 кластерів виключених документів мали «в основному сексуальний» характер – близько 4% від загальної кількості даних, заборонених для CXNUMX. Дослідники виявили те, що залишилося від виключених даних «групи документів, що стосуються науки, медицини та охорони здоров’я, а також кластери, пов’язані з правовими та політичними документами».

З 5,000 результатами, показаними для ясності, це загальне кластеризування K-середніх для 100,000 XNUMX вивчених виключених документів. На ілюстрації подано п’ять найпопулярніших ключових слів.

З точки зору блокування даних, пов’язаних із геями та лесбійками, автори виявили, що згадки про сексуальну ідентичність (таких як лесбіянки, геї, гомосексуалісти та бісексуали) мають найвищий шанс бути відфільтрованими для C4, і що необразливі а документи несексуального характеру складають відповідно 22% і 36% інформації в цій категорії, яка виключена з C4.

Виключення діалектів і старі дані

Крім того, дослідники використовували a тематична модель, що усвідомлює діалект щоб оцінити ступінь, до якої розмовна мова, що стосується етики, була виключена з C4, виявивши, що «Афроамериканська англійська та латиноамериканська англійська непропорційно страждають від фільтрації списку блокувань».

Крім того, у статті зазначається, що значний відсоток похідного корпусу C4 отримано з матеріалів старших десяти років, деяким з них десятиліття, і більшість із них походить із новин, патентів і веб-сайту Вікіпедії. Дослідники визнають, що оцінити точний вік, виявивши перше збереження в Інтернеті архів не є точним методом (оскільки URL-адреси можуть бути архівовані місяцями), але використовували цей підхід за відсутності розумних альтернатив.

Висновки

Документ виступає за більш суворі системи документування для наборів даних, отриманих в Інтернеті, призначених для внеску в дослідження НЛП, відзначаючи «Під час створення набору даних із фрагмента Інтернету повідомлення про домени, з яких зібраний текст, є невід’ємною частиною розуміння набору даних; процес збору даних може призвести до значно іншого розподілу інтернет-доменів, ніж можна було б очікувати».

Вони також відзначають, що забруднення еталонного тесту, де дані машини включені разом із даними людини (див. вище), вже виявилося проблемою при розробці GPT-3, який також випадково включив такі дані під час свого великого та дуже дорогого навчання (зрештою, це виявилося дешевше кількісно визначити та виключити вплив порівняльних даних, ніж перенавчати GPT-3, і вихідний папір засвідчує «незначний вплив на продуктивність»).

У звіті робиться висновок*:

«Наш аналіз підтверджує, що визначення того, чи містить документ токсичний або непристойний вміст, — це більш детальна спроба, яка виходить за рамки виявлення «поганих» слів; ненависний і непристойний вміст можна виразити без мінус-слів (наприклад, мікроагресії, інсинуації).

Важливо, що значення, здавалося б, «поганих» слів сильно залежить від соціального контексту (наприклад, неввічливість може служити просоціальні функції, і те, хто вимовляє певні слова, впливає на їхню образливість (наприклад, відновлена образлива лайка «n*gga» вважається менш образливою, коли її вимовляє Чорний динамік ніж білим динаміком.

«Ми рекомендуємо не використовувати фільтрацію [чорного списку] під час створення наборів даних із даних, сканованих веб-сайтом».

* Моє перетворення внутрішніх цитат на гіперпосилання