Yapay Zeka

RigNeRF: Nöral Parlaklık Alanlarını Kullanan Yeni Bir Deepfakes Yöntemi

Adobe'de geliştirilen yeni araştırma, ilk uygulanabilir ve etkili deepfake yöntemini sunuyor. Nöral Parlaklık Alanları (NeRF) – 2017'de deepfake'lerin ortaya çıkışından bu yana beş yıl içinde mimaride veya yaklaşımda belki de ilk gerçek yenilik.

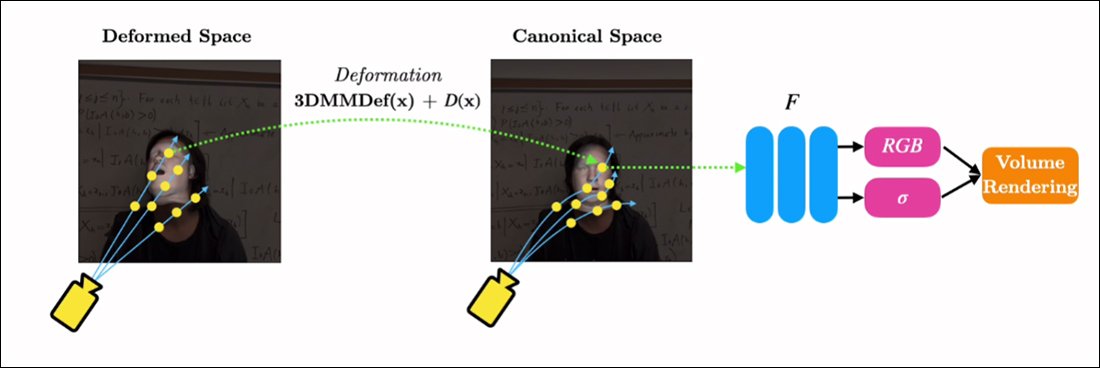

başlıklı yöntem RigNeRFKullanır 3D değiştirilebilir yüz modelleri (3DMM'ler), istenen girdi (yani, NeRF oluşturma işlemine empoze edilecek kimlik) ile nöral alan arasında ara bir araçsallık katmanı olarak; Son yıllarda yaygın olarak benimsenen Henüz hiçbiri video için işlevsel ve kullanışlı yüz değiştirme çerçeveleri üretmemiş olan Generative Adversarial Network (GAN) yüz sentezi yaklaşımları tarafından.

Geleneksel deepfake videolarının aksine, burada gösterilen hareketli içeriğin hiçbiri "gerçek" değil; kısa görüntülerle eğitilmiş, keşfedilebilir bir sinirsel alan. Sağda, istenen manipülasyonlar ("gülümseme", "sola bak", "yukarı bak" vb.) ile Sinirsel Işıltı Alanı görselleştirmesinin genellikle çözülmesi zor parametreleri arasında bir arayüz görevi gören 3B şekil değiştirilebilir yüz modelini (3DMM) görüyoruz. Bu klibin yüksek çözünürlüklü bir versiyonu ve diğer örnekler için bkz. proje sayfasıveya bu makalenin sonundaki katıştırılmış videolar. Kaynak: https://shahrukhathar.github.io/2022/06/06/RigNeRF.html

3DMM'ler, parametreleri başka türlü kontrol edilmesi zor olan NeRF ve GAN gibi daha soyut görüntü sentez sistemlerine uyarlanabilen yüzlerin etkin CGI modelleridir.

Yukarıdaki resimde (ortadaki resim, mavi gömlekli adam) ve hemen altındaki resimde (soldaki resim, mavi gömlekli adam) gördüğünüz şey, üzerine küçük bir 'sahte' yüz parçasının yerleştirildiği 'gerçek' bir video değil, yalnızca hacimsel bir sinirsel görüntü olarak var olan, vücudu ve arka planı da içeren tamamen sentezlenmiş bir sahnedir:

Yukarıdaki örnekte, sağdaki gerçek yaşam videosu (kırmızı elbiseli kadın), soldaki yakalanan kimliği (mavi gömlekli adam) RigNeRF aracılığıyla 'kuklalamak' için kullanılıyor. Yazarların iddiasına göre bu, poz ve ifadeyi ayırırken yeni görüntü sentezleri yapabilen ilk NeRF tabanlı sistem.

Yukarıdaki görselde soldaki erkek figürü 70 saniyelik bir akıllı telefon videosundan 'yakalandı' ve giriş verileri (tüm sahne bilgileri dahil) daha sonra sahneyi elde etmek için 4 V100 GPU'da eğitildi.

3DMM tarzı parametrik donanımlar şu şekilde de mevcut olduğundan: tüm vücut parametrik CGI proxy'leri (sadece yüz donanımları yerine), RigNeRF, gerçek insan hareketinin, dokusunun ve ifadesinin CGI tabanlı parametrik katmana aktarıldığı ve daha sonra eylemi ve ifadeyi işlenmiş NeRF ortamlarına ve videolarına çevirecek olan tam vücut derin taklitlerinin olasılığını potansiyel olarak açar. .

RigNeRF'e gelince - manşetlerin terimi anladığı mevcut anlamda bir derin sahte yöntem olarak nitelendiriliyor mu? Yoksa DeepFaceLab ve diğer emek yoğun, 2017 dönemi otomatik kodlayıcı derin sahte sistemlerine de koşan başka bir yarı aksak mı?

Yeni makalenin araştırmacıları bu noktada net:

'Yüzleri yeniden canlandırabilen bir yöntem olan RigNeRF, kötü niyetli kişiler tarafından deepfake üretmek için kötüye kullanılmaya müsaittir.'

Yeni kâğıt başlıklı RigNeRF: Tamamen Kontrol Edilebilir Nöral 3D Portrelerve Stonybrook Üniversitesi'nden ShahRukh Atha, RigNeRF'in geliştirilmesi sırasında Adobe'de stajyer olarak çalışmış ve Adobe Research'ten dört yazar daha tarafından hazırlanmıştır.

Otomatik Kodlayıcı Tabanlı Deepfakelerin Ötesinde

Son birkaç yılda manşetlere konu olan viral deepfake'lerin çoğu, otomatik kodlayıcı-tabanlı sistemler, 2017'de anında yasaklanan r/deepfakes alt dizininde yayınlanan koddan türetilmiştir - daha önce olmasa da kopyalandı şu anda çatallanmış olduğu GitHub'a binden fazla kez, en azından popüler (eğer tartışmalı) Derin Yüz Laboratuvarı dağıtım ve aynı zamanda Yüz nakli projesi.

GAN ve NeRF'in yanı sıra, otokodlayıcı çerçeveler de gelişmiş yüz sentezi çerçeveleri için 'kılavuz' olarak 3DMM'lerle deneyler yapmıştır. Bunun bir örneği: HifiFace projesi Ancak, bu yaklaşımdan bugüne kadar hiçbir kullanılabilir veya popüler girişim gelişmemiş gibi görünüyor.

RigNeRF sahnelerine ait veriler, kısa akıllı telefon videoları çekilerek elde edildi. Proje kapsamında, RigNeRF araştırmacıları tüm deneylerde bir iPhone XR veya iPhone 12 kullandı. Çekimin ilk yarısında, kamera etrafında hareket ettirilirken denekten başını sabit tutarak çeşitli yüz ifadeleri ve konuşmalar yapması istendi.

Yakalamanın ikinci yarısında, konu geniş bir ifade yelpazesi sergilerken başını hareket ettirmesi gerekirken kamera sabit bir konumu korur. Ortaya çıkan 40-70 saniyelik görüntü (yaklaşık 1200-2100 kare), modeli eğitmek için kullanılacak tüm veri setini temsil eder.

Veri Toplama İşlemlerini Azaltmak

Buna karşılık, DeepFaceLab gibi otomatik kodlayıcı sistemler, genellikle YouTube videoları ve diğer sosyal medya kanallarının yanı sıra filmlerden (ünlülerin deepfake'leri söz konusu olduğunda) alınan binlerce farklı fotoğrafın nispeten zahmetli bir şekilde toplanmasını ve iyileştirilmesini gerektirir.

Sonuçta ortaya çıkan eğitilmiş otokodlayıcı modeller genellikle çeşitli durumlarda kullanılmak üzere tasarlanmıştır. Ancak, en titiz "ünlü" deepfakeciler, eğitimin bir hafta veya daha uzun sürebilmesine rağmen, tek bir video için tüm modelleri sıfırdan eğitebilirler.

Yeni makalenin araştırmacılarının uyarı notuna rağmen, yapay zeka pornosunun yanı sıra popüler YouTube/TikTok "derin sahtecilik yeniden düzenlemelerine" de güç veren "yama işi" ve geniş kapsamlı veri kümelerinin, sahneye özgü bir metodolojiye sahip RigNeRF gibi bir derin sahtecilik sisteminde kabul edilebilir ve tutarlı sonuçlar üretmesi pek olası görünmüyor. Yeni çalışmada belirtilen veri yakalama kısıtlamaları göz önüne alındığında, bu, kötü niyetli derin sahteciler tarafından kimliğin gelişigüzel kötüye kullanılmasına karşı bir dereceye kadar ek bir koruma sağlayabilir.

NeRF'i Deepfake Videoya Uyarlama

NeRF, çeşitli bakış açılarından alınan az sayıda kaynak resmin keşfedilebilir bir 3D sinir uzayında bir araya getirildiği fotogrametri tabanlı bir yöntemdir. Bu yaklaşım, bu yılın başlarında NVIDIA'nın Anında NeRF NeRF için fahiş eğitim sürelerini dakikalara, hatta saniyelere indirebilen sistem:

Anında NeRF. Kaynak: https://www.youtube.com/watch?v=DJ2hcC1orc4

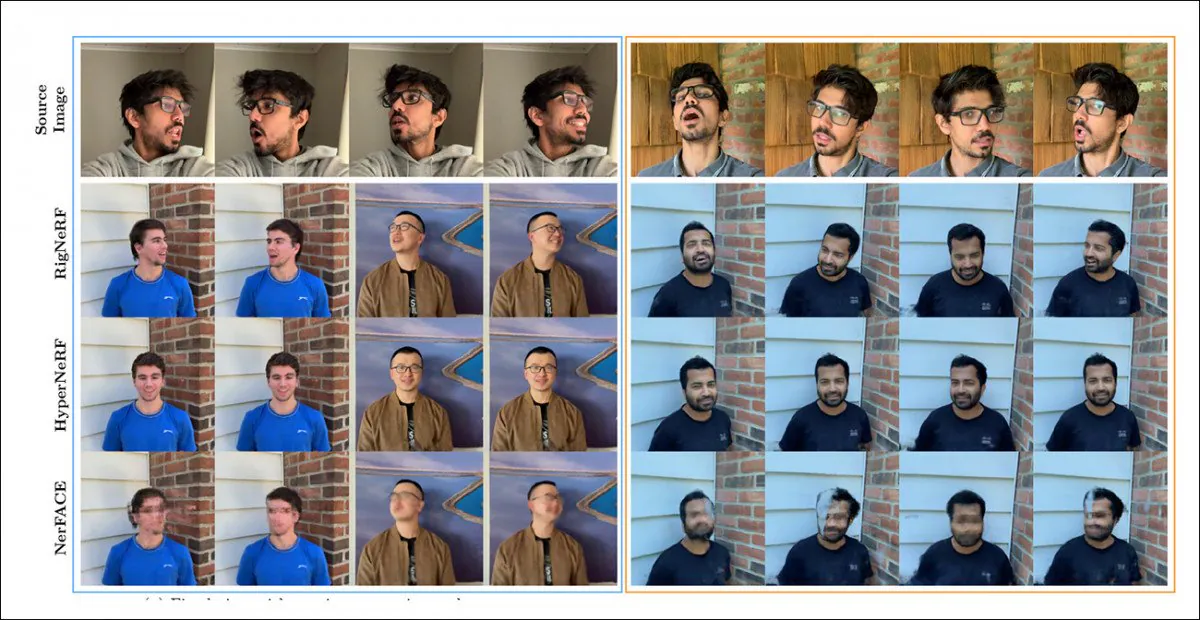

Ortaya çıkan Nöral Parlaklık Alanı sahnesi, temelde keşfedilebilen, ancak keşfedilebilen statik bir ortamdır. düzenlemesi zor. Araştırmacılar, önceki iki NeRF tabanlı girişimin – HyperNeRF + E/P ve nerface - yüz video sentezinde bir bıçak aldılar ve (görünüşe göre bütünlük ve özen uğruna) RigNeRF'i bir test turunda bu iki çerçeveye karşı koydular:

RigNeRF, HyperNeRF ve NerFACE arasında nitel bir karşılaştırma. Daha yüksek kaliteli sürümler için bağlantılı kaynak videolara ve PDF'ye bakın. Statik görüntü kaynağı: https://arxiv.org/pdf/2012.03065.pdf

Ancak bu durumda, RigNeRF'i destekleyen sonuçlar iki nedenden ötürü oldukça anormaldir: birincisi, yazarlar 'elma ile elma karşılaştırması için mevcut bir çalışma olmadığını' gözlemlemektedir; ikincisi, bu durum RigNeRF'in yeteneklerinin, önceki sistemlerin daha kısıtlı işlevselliğiyle en azından kısmen eşleşecek şekilde sınırlandırılmasını gerektirmiştir.

Sonuçlar önceki çalışmalara göre artımlı bir gelişme olmayıp, NeRF'in düzenlenebilirliği ve kullanışlılığı açısından bir 'çığır açıcı' olduğu için, test aşamasını bir kenara bırakıp RigNeRF'in öncüllerinden farklı olarak neler yaptığını göreceğiz.

Kombine Güçlü Yönler

NeRF ortamında poz/ifade kontrolü oluşturabilen NerFACE'in temel sınırlaması, kaynak görüntülerin statik bir kamerayla çekileceğini varsaymasıdır. Bu, çekim sınırlarının ötesine uzanan yeni görüntüler üretemeyeceği anlamına gelir. Bu durum, "hareketli portreler" oluşturabilen, ancak deepfake tarzı videolar için uygun olmayan bir sistem ortaya çıkarır.

Öte yandan HyperNeRF, yeni ve hiper-gerçek görünümler üretebilse de, kafa duruşlarını veya yüz ifadelerini değiştirmesine izin veren hiçbir araca sahip değildir, bu da otomatik kodlayıcı tabanlı derin sahteler için yine herhangi bir rakiple sonuçlanmaz.

RigNeRF, 3DMM modülünden gelen girdiler aracılığıyla sapmaların ve deformasyonların gerçekleştirilebileceği varsayılan bir temel çizgi olan 'kanonik bir alan' oluşturarak bu iki izole işlevselliği bir araya getirebilmektedir.

3DMM aracılığıyla üretilen deformasyonların (yani pozların ve ifadelerin) etki edebileceği bir 'kanonik alan' (poz yok, ifade yok) yaratmak.

3DMM sistemi, yakalanan nesneyle tam olarak eşleşmeyeceğinden, bu durumu işlem sırasında telafi etmek önemlidir. RigNeRF bunu, bir deformasyon alanı önselinden hesaplanan bir deformasyon alanı önseliyle gerçekleştirir. Çok Katmanlı Algılayıcı (MLP) kaynak görüntüden türetilmiştir.

Deformasyonları hesaplamak için gerekli kamera parametreleri şu şekilde elde edilir: KOLMAP, her çerçeve için ifade ve şekil parametreleri elde edilirken Kİ.

Konumlandırma daha da optimize edilmiştir dönüm noktası uydurma ve COLMAP'ın kamera parametreleri ve hesaplama kaynağı kısıtlamaları nedeniyle, video çıktısı eğitim için 256x256 çözünürlüğe düşürülür (aynı zamanda oto kodlayıcı deepfake sahnesini de etkileyen donanımla sınırlı bir küçültme işlemi).

Bundan sonra, deformasyon ağı dört V100 üzerinde eğitilir; bunlar sıradan meraklıların erişebileceği türden olmayan zorlu bir donanımdır (ancak makine öğrenimi eğitimi söz konusu olduğunda, genellikle ağırlığı zamanla takas etmek ve model eğitiminin birkaç gün hatta birkaç hafta süreceğini kabul etmek mümkündür).

Sonuç olarak, araştırmacılar şunları belirtiyor:

'Diğer yöntemlerin aksine, RigNeRF, 3DMM kılavuzlu deformasyon modülünün kullanımı sayesinde baş pozunu, yüz ifadelerini ve tüm 3 boyutlu portre sahnesini yüksek doğrulukla modelleyebiliyor ve böylece keskin ayrıntılara sahip daha iyi yeniden yapılandırmalar sağlıyor.'

Daha fazla ayrıntı ve sonuç görüntüleri için aşağıdaki gömülü videolara bakın.

İlk olarak 15 Haziran 2022'de yayınlandı.