Umetna inteligenca

LoReFT: Natančna nastavitev reprezentacije za jezikovne modele

Parametrsko učinkovito fino uravnavanje ali metode PeFT skušajo prilagoditi velike jezikovne modele s posodobitvami majhnega števila uteži. Vendar pa je večina obstoječega dela na področju interpretacije pokazala, da predstavitve kodirajo semantično bogate informacije, kar kaže na to, da bi bilo urejanje teh predstavitev morda boljša in močnejša alternativa. Vnaprej usposobljeni veliki modeli so pogosto natančno nastavljeni za uporabo za nove domene ali naloge, med postopkom natančnega prilagajanja pa je mogoče en sam osnovni model prilagoditi široki paleti nalog, tudi če so na voljo le majhne količine podatkov v domeni. do modela. Vendar je postopek natančnega prilagajanja celotnega modela zamuden in drag, zlasti za jezikovne modele z bistveno večjim številom velikosti in parametrov.

Parametrsko učinkovito fino uravnavanje ali metode PeFT predlagajo reševanje visokih stroškov, povezanih s finim uravnavanjem celotnega modela, s posodobitvijo le majhne količine razpoložljivih skupnih uteži, postopek, ki pomaga pri zmanjševanju časa usposabljanja skupaj z uporabo pomnilnika. Bolj pomembno je, da so metode natančnega prilagajanja, učinkovite s parametri, ali metode PeFT pokazale podobno zmogljivost kot natančno prilagajanje v več praktičnih nastavitvah. Adapterji, običajna družina parametrsko učinkovitih finih nastavitev ali metod PeFT, se naučijo urejanja, ki ga je mogoče dodati dodatnemu naboru uteži, ki delujejo poleg zamrznjenega osnovnega modela, pri čemer nedavni adapterji, kot je LoRA, zmanjšajo število učljivih parametrov v naučenem posodobitve teže z uporabo približkov nizkega ranga namesto matrik polne teže pri usposabljanju adapterjev.

S prejšnjimi deli, ki prikazujejo urejanje predstavitev, bi lahko bila boljša alternativa parametrsko učinkovitemu natančnemu uravnavanju ali metodam PeFT, v tem članku pa bomo govorili o metodah natančnega uravnavanja predstavitev ali ReFT, ki delujejo na zamrznjenem modelu, in se naučili specifičnih nalog posegi na skrite upodobitve. Namen tega članka je poglobljeno obravnavati ReFt ali ogrodje za fino uravnavanje reprezentacije in raziskati mehanizem, metodologijo, arhitekturo ogrodja skupaj z njegovo primerjavo z najsodobnejšimi ogrodji. Pa začnimo.

ReFT: Natančna nastavitev reprezentacije za jezikovne modele

V poskusu sprejetja vnaprej usposobljenih jezikovnih modelov za nova področja in naloge sedanja ogrodja te vnaprej usposobljene jezikovne modele pogosto natančno prilagodijo, saj je z implementiranim postopkom natančnega prilagajanja en sam osnovni model mogoče prilagoditi različnim nalogam celo pri delu z majhno količino podatkov v domeni. Čeprav postopek natančnega prilagajanja poveča splošno zmogljivost, je to drag postopek, zlasti če ima jezikovni model precej veliko število parametrov. Za reševanje te težave in zmanjšanje s tem povezanih stroškov PeFT ali Parameter-efficient okvirji za fino nastavitev posodobite le majhen del skupnih uteži, proces, ki ne le skrajša čas usposabljanja, ampak tudi zmanjša uporabo pomnilnika, kar omogoča, da ogrodja PeFT dosežejo podobno zmogljivost v primerjavi s pristopi popolne natančne nastavitve v praktičnih scenarijih. Adapterji, pogosta družina PeFT, delujejo tako, da se naučijo urejanja, ki ga je mogoče dodati dodatnemu naboru uteži skupaj s podmnožico uteži, ki delujejo usklajeno z osnovnim modelom z zamrznjenimi utežmi. Najnovejša ogrodja adapterjev, kot je LoRA in QLoRA so dokazali, da je mogoče usposobiti adapterje s polno natančnostjo na modelih z zmanjšano natančnostjo, ne da bi to vplivalo na zmogljivost. Adapterji so običajno učinkovitejši in učinkovitejši v primerjavi z drugimi metodami, ki uvajajo nove komponente modela.

Glavni poudarek trenutnega stanja tehnike Parametrsko učinkovitih ogrodij za fino uravnavanje je, da namesto spreminjanja predstavitev spreminjajo uteži. Vendar pa so okviri, ki se ukvarjajo z interpretabilnostjo, pokazali, da predstavitve kodirajo bogate semantične informacije, kar nakazuje, da je urejanje predstavitev lahko boljši in močnejši pristop v primerjavi s posodobitvami teže. Ta predpostavka, da je urejanje predstavitev boljši pristop, je tisto, kar tvori temelj ReFT ali ogrodja za fino uravnavanje predstavitev, ki usposablja intervencije namesto prilagajanja uteži modela, kar omogoča modelu, da manipulira z majhnim deležem vseh predstavitev v poskusu usmerjanja vedenja modela za reševanje nadaljnjih nalog med sklepanjem. Metode ReFT ali Representation Fine tuning so vmesne zamenjave za ogrodja PeFT ali Parameter-efficient fine tuning, ki temeljijo na teži. Pristop ReFT črpa navdih iz nedavnih modelov, ki delajo z obsežno interpretabilnostjo modela, ki posega v reprezentacije, da najde zveste vzročne mehanizme, in usmerja vedenje modela med sklepanjem, zato ga je mogoče obravnavati kot posplošitev modelov za urejanje predstavitev. Na podlagi istega je LoReFT ali podprostor nizkega ranga ReFT močan in učinkovit primerek ReFT in je parametrizacija ReFT, ki posega v skrite predstavitve v linearnem prostoru, ki ga razteza projekcijska matrika nizkega ranga, in gradi neposredno na DAS ali ogrodje Distributed Alignment Search.

V nasprotju s popolnim finim uravnavanjem PeFT ali parametrsko učinkovito ogrodje za fino uravnavanje usposablja le majhen del parametrov modela in uspe prilagoditi model nadaljnjim nalogam. Parametrsko učinkovito ogrodje natančnega prilagajanja lahko razvrstimo v tri glavne kategorije:

- Metode, ki temeljijo na adapterju: Metode, ki temeljijo na adapterjih, usposabljajo dodatne module, kot so popolnoma povezani sloji na vrhu predhodno usposobljenega modela z zamrznjenimi utežmi. Serijski adapterji vstavljajo komponente med večplastni perceptron ali MLP in LM ali velike modelne pozornostne plasti, medtem ko vzporedni adapterji dodajajo module poleg obstoječih komponent. Ker adapterji dodajajo nove komponente, ki jih ni mogoče zlahka zložiti v obstoječe uteži modela, predstavljajo dodatno obremenitev med sklepanjem.

- LoRA: LoRA skupaj s svojimi nedavnimi različicami približuje aditivne uteži med vadbo z uporabo matrik nizkega ranga in ne zahtevajo dodatnih režijskih stroškov med sklepanjem, saj je mogoče posodobitve uteži zliti v model, in to je razlog, zakaj veljajo za trenutne najmočnejša ogrodja PeFT.

- Metode, ki temeljijo na pozivih: Metode, ki temeljijo na pozivih, dodajajo mehke žetone, ki se naključno inicializirajo v vhod, in usposabljajo njihove vdelave, medtem ko ohranjajo uteži jezikovnega modela zamrznjene. Učinkovitost, ki jo ponujajo te metode, pogosto ni zadovoljiva v primerjavi z drugimi pristopi PeFT, prav tako pa povzročajo znatne režijske stroške sklepanja.

Namesto posodabljanja uteži se okvir ReFT nauči posegov za spreminjanje majhnega deleža skupnih predstavitev. Poleg tega so nedavna dela na področju predstavitvenega inženiringa in aktivacijskega krmiljenja pokazala, da lahko dodajanje fiksnih krmilnih vektorjev v preostali tok olajša določeno stopnjo nadzora nad vnaprej usposobljenimi generacijami velikih modelov, ne da bi zahteval intenzivne vire fina nastavitev. Druga ogrodja so pokazala, da lahko urejanje predstavitev z naučeno operacijo skaliranja in prevajanja poskuša uskladiti, vendar ne preseči zmogljivosti, ki jo ponujajo adapterji LoRA pri širokem naboru nalog z manj naučenimi parametri. Poleg tega je uspeh teh ogrodij pri različnih nalogah pokazal, da imajo predstavitve, uvedene z vnaprej usposobljenimi jezikovnimi modeli, bogato semantiko, čeprav je delovanje teh modelov neoptimalno, zaradi česar se PeFT nadaljujejo kot najsodobnejši pristop. brez dodatnega bremena sklepanja.

ReFT : Metodologija in arhitektura

Da bi bil postopek ohranjanja sloga preprost, okvir ReFT predpostavlja velik model na osnovi transformatorja kot svoj ciljni model, ki je sposoben ustvariti kontekstualizirano predstavitev zaporedja žetonov. Za dano zaporedje z n številom vhodnih žetonov ogrodje ReFT te vhodne žetone najprej vdela v seznam predstavitev, nato pa m plasti zaporedoma izračunajo seznam skritih predstavitev kot funkcijo prejšnjega seznama skritih predstavitev. Vsaka skrita predstavitev je vektor in jezikovni model uporablja končne skrite predstavitve za izdelavo napovedi. Ogrodje ReFT upošteva tako maskirane jezikovne modele kot avtoregresivne jezikovne modele. Glede na hipotezo o linearni predstavitvi so v nevronskih mrežah koncepti kodirani znotraj linearnih podprostorov predstavitev. Nedavni modeli so ugotovili, da je ta trditev resnična v modelih nevronskih mrež, usposobljenih za naravni jezik skupaj z drugimi distribucijami vnosa.

Poleg tega v študijah interpretabilnosti okvir priložnostne abstrakcije uporablja intervencije izmenjave, da naključno določi vlogo komponent nevronske mreže pri izvajanju določenih vedenj. Logika v ozadju interchange intervencije je, da če nekdo popravi predstavitev na tisto, kar bi bilo za hipotetični vnos, in ta intervencija dosledno vpliva na izhod modela na način, da trditve ogrodja ReFT o komponenti, ki je odgovorna za ustvarjanje ta reprezentacija, potem komponenta igra vzročno vlogo v vedenju. Čeprav obstaja nekaj metod, je porazdeljena izmenjava idealen pristop za preverjanje, ali je koncept kodiran v linearnem podprostoru reprezentacije, kot trdi hipoteza o linearni predstavitvi. Poleg tega je bila metoda DAS že prej uporabljena za iskanje linearne predstavitve atributov entitete, občutkov, jezikovnih značilnosti in matematičnega sklepanja v jezikovnih modelih. Vendar pa je več poskusov pokazalo, da je metoda DAS zelo ekspresivna in ima sposobnost iskanja vzročno učinkovitih podprostorov, tudi če je bil transformatorski jezikovni model inicializiran naključno, in se zato šele mora naučiti kakršnih koli predstavitev, specifičnih za nalogo, kar ima za posledico razprava o tem, ali je DAS dovolj učinkovit in odgovoren za naloge interpretabilnosti.

Izraznost, ki jo ponuja DAS, nakazuje, da bi lahko bil pristop idealno orodje za nadzor obnašanja jezikovnega modela skupaj z njegovim delom na nadzorovanem ustvarjanju in odgovornem urejanju. Zato za prilagoditev jezikovnih modelov za nadaljnja opravila ogrodje ReFT uporablja operacijo posredovanja porazdeljene izmenjave, da postane nova metoda učinkovita s parametri. Poleg tega je metoda ReFT nabor intervencij, okvir pa uveljavlja, da morata biti intervencijski poziciji za kateri koli dve intervenciji, ki delujeta na isti plasti, ločeni, pri čemer parametri vseh intervencijskih funkcij ostanejo neodvisni. Posledično je ReFT generično ogrodje, ki zajema posege na skrite predstavitve med prehodom modela naprej.

ReFT: Poskusi in rezultati

Za ovrednotenje njegove učinkovitosti glede na obstoječa ogrodja PEFT ogrodje ReFT izvaja poskuse v štirih različnih merilih uspešnosti obdelave naravnega jezika in pokriva več kot 20 nizov podatkov, pri čemer je glavni cilj zagotoviti bogato sliko o tem, kako ogrodje LoReFT deluje v različnih scenarijih. Poleg tega, ko se ogrodje LoReFT izvaja v resničnem življenju, se morajo razvijalci odločiti, koliko posegov se bodo naučili skupaj z vhodnimi položaji in plastmi, na katerih bodo uporabili vsakega posebej. Za dokončanje naloge okvir ReFT nastavi štiri hiperparametre.

- Število položajev predpone, na katerih je treba posredovati.

- Število položajev pripon, na katerih je treba posegati.

- Na kateri niz plasti posegati.

- Ali povezati intervencijske parametre med različnimi položaji v istem sloju ali ne.

S tem ogrodje ReFT poenostavlja prostor iskanja hiperparametrov in zagotavlja le fiksne dodatne stroške sklepanja, ki se ne prilagajajo dolžini poziva.

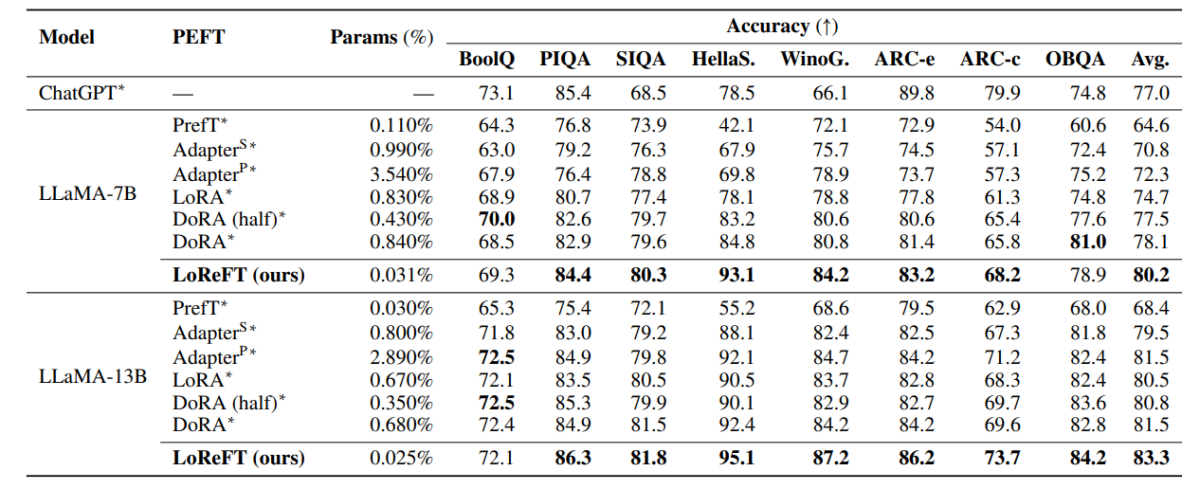

Zgornja tabela primerja natančnost ogrodij LLaMA-7B in LLaMA-13B z obstoječimi modeli PEFT v 8 naborih podatkov zdravorazumskega razmišljanja. Kot je mogoče opaziti, model LoReFT prekaša obstoječe pristope PEFT z dostojno rezervo, kljub temu, da ima veliko manj parametrov, pri čemer je povprečna uspešnost treh potekov sporočena z različnimi semeni parametrov za model LoReFT. Param(%) se izračuna tako, da se število parametrov, ki jih je mogoče učiti, deli s številom skupnih parametrov osnovnega velikega modela.

Zgornja tabela povzema primerjavo natančnosti ogrodij LLaMA-7B in LLaMA-13B z obstoječimi modeli PEFT v 4 različnih naborih podatkov o aritmetičnem sklepanju, pri čemer ogrodje poroča o povprečni uspešnosti treh zagonov z različnimi naključnimi semeni. Kot lahko opazimo, kljub temu, da ima veliko manj parametrov (%), ogrodje LoReFT precej prekaša obstoječa ogrodja PEFT.

Zgornja tabela povzema primerjavo natančnosti ogrodij RoBERTa-base in RoBERTa-large z obstoječimi modeli PEFT po merilu uspešnosti GLUE, pri čemer ogrodje poroča o povprečni zmogljivosti petih zagonov z različnimi naključnimi semeni. Kot lahko opazimo, kljub temu, da ima veliko manj parametrov (%), ogrodje LoReFT precej prekaša obstoječa ogrodja PEFT.

Končna thoughts

V tem članku smo govorili o LoReFT, zmogljivi alternativi obstoječim ogrodjem PEFT, ki dosega močno zmogljivost pri merilih uspešnosti iz štirih različnih področij, hkrati pa ponuja do 50-krat večjo učinkovitost kot prejšnji najsodobnejši modeli PEFT. Vnaprej usposobljeni veliki modeli so pogosto natančno nastavljeni za uporabo za nove domene ali naloge, med postopkom natančnega prilagajanja pa je mogoče en sam osnovni model prilagoditi široki paleti nalog, tudi če so na voljo le majhne količine podatkov v domeni. do modela. Vendar je postopek natančnega prilagajanja celotnega modela zamuden in drag, zlasti za jezikovne modele z bistveno večjim številom velikosti in parametrov. Parametrsko učinkovito fino uravnavanje ali metode PeFT predlagajo reševanje visokih stroškov, povezanih s finim uravnavanjem celotnega modela, s posodobitvijo le majhne količine razpoložljivih skupnih uteži, postopek, ki pomaga pri zmanjševanju časa usposabljanja skupaj z uporabo pomnilnika. Predvsem LoReFT vzpostavlja novo najsodobnejšo zmogljivost na področju zdravorazumskega razmišljanja, sledenja navodilom in razumevanja naravnega jezika proti najmočnejšim PEFT.