Umetna inteligenca

Prva obletnica ChatGPT: preoblikovanje prihodnosti interakcije AI

Če pomislimo na prvo leto ChatGPT, je jasno, da je to orodje bistveno spremenilo sceno AI. ChatGPT, ki je bil predstavljen konec leta 2022, je izstopal zaradi uporabniku prijaznega sloga pogovora, zaradi katerega se je interakcija z umetno inteligenco počutila bolj kot klepet z osebo kot s strojem. Ta nov pristop je hitro pritegnil pozornost javnosti. V samo petih dneh po izdaji je ChatGPT pritegnil že milijon uporabnikov. Do začetka leta 2023 je ta številka narasla na približno 100 milijonov mesečnih uporabnikov, do oktobra pa je platforma pritegnila približno 1.7 milijarde obiskov po vsem svetu. Te številke dovolj govorijo o njegovi priljubljenosti in uporabnosti.

V preteklem letu so uporabniki našli najrazličnejše kreativne načine za uporabo ChatGPT, od preprostih opravil, kot je pisanje e-pošte in posodabljanje življenjepisov, do ustanavljanja uspešnih podjetij. Vendar ne gre samo za to, kako ga ljudje uporabljajo; sama tehnologija je zrasla in se izboljšala. Sprva je bil ChatGPT brezplačna storitev, ki je ponujala podrobne besedilne odgovore. Zdaj je tu ChatGPT Plus, ki vključuje ChatGPT-4. Ta posodobljena različica je usposobljena za več podatkov, daje manj napačnih odgovorov in bolje razume zapletena navodila.

Ena največjih posodobitev je, da lahko ChatGPT zdaj komunicira na več načinov – lahko posluša, govori in celo obdeluje slike. To pomeni, da se lahko z njim pogovarjate prek njegove mobilne aplikacije in mu pokažete slike, da dobite odgovore. Te spremembe so odprle nove možnosti za umetno inteligenco in spremenile pogled in razmišljanje ljudi o vlogi umetne inteligence v naših življenjih.

Pot ChatGPT je od začetkov tehnološke predstavitve do trenutnega statusa glavnega igralca v tehnološkem svetu precej impresivna. Sprva so ga razumeli kot način za preizkušanje in izboljšanje tehnologije s pridobivanjem povratnih informacij javnosti. Toda hitro je postal bistveni del pokrajine AI. Ta uspeh kaže, kako učinkovito je natančno prilagajanje velikih jezikovnih modelov (LLM) z nadzorovanim učenjem in povratnimi informacijami od ljudi. Posledično lahko ChatGPT obravnava širok spekter vprašanj in nalog.

Dirka za razvoj najzmogljivejših in vsestranskih sistemov umetne inteligence je pripeljala do širjenja tako odprtokodnih kot lastniških modelov, kot je ChatGPT. Razumevanje njihovih splošnih zmogljivosti zahteva celovita merila uspešnosti za širok spekter nalog. Ta razdelek raziskuje ta merila uspešnosti in osvetljuje, kako se različni modeli, vključno s ChatGPT, zlagajo drug proti drugemu.

Ocenjevanje magistrskih študijev: merila uspešnosti

- MT-Klop: To merilo uspešnosti preizkuša večkratne pogovore in zmožnosti sledenja navodilom na osmih področjih: pisanje, igra vlog, pridobivanje informacij, razmišljanje, matematika, kodiranje, znanje STEM in humanistične/družbene vede. Kot ocenjevalci se uporabljajo močnejši LLM-ji, kot je GPT-4.

- AlpacaEval: Na osnovi ocenjevalnega nabora AlpacaFarm ta samodejni ocenjevalec, ki temelji na LLM, primerja modele z odzivi naprednih LLM-jev, kot sta GPT-4 in Claude, ter izračuna zmagovalno stopnjo kandidatnih modelov.

- Odprite LLM lestvico najboljših: Z uporabo orodja za ocenjevanje jezikovnega modela ta lestvica najboljših ocenjuje LLM-je na sedmih ključnih merilih uspešnosti, vključno z izzivi sklepanja in splošnimi preizkusi znanja, tako v nastavitvah brez možnosti kot v nastavitvah redkih poskusov.

- BIG-klop: To sodelovalno merilo pokriva več kot 200 novih jezikovnih nalog, ki obsegajo raznolik nabor tem in jezikov. Njegov namen je raziskati LLM in napovedati njihove prihodnje zmogljivosti.

- ChatEval: Ogrodje debate z več agenti, ki ekipam omogoča samostojno razpravljanje in vrednotenje kakovosti odgovorov različnih modelov na odprta vprašanja in tradicionalne naloge ustvarjanja naravnega jezika.

Primerjalna uspešnost

Kar zadeva splošna merila uspešnosti, so odprtokodni LLM-ji pokazali izjemen napredek. Lama-2-70Bje na primer dosegel impresivne rezultate, zlasti po natančnem prilagajanju s podatki o navodilih. Njegova različica, Llama-2-chat-70B, je blestela v AlpacaEval z 92.66-odstotno stopnjo zmage, s čimer je presegla GPT-3.5-turbo. Vendar GPT-4 ostaja vodilni s 95.28-odstotno stopnjo zmag.

Zefir-7B, manjši model, je pokazal zmogljivosti, primerljive z večjimi 70B LLM, zlasti v AlpacaEval in MT-Bench. Medtem je WizardLM-70B, natančno nastavljen z raznolikim naborom podatkov o navodilih, dosegel najvišjo oceno med odprtokodnimi LLM-ji na MT-Bench. Vendar je še vedno zaostajal za GPT-3.5-turbo in GPT-4.

Zanimiv vnos, GodziLLa2-70B, je dosegel konkurenčen rezultat na Open LLM Leaderboard, ki prikazuje potencial eksperimentalnih modelov, ki združujejo različne nize podatkov. Podobno je Yi-34B, razvit iz nič, izstopal z rezultati, primerljivimi z GPT-3.5-turbo in le malo za GPT-4.

UltraLlama se je s svojo fino nastavitvijo na raznolikih in visokokakovostnih podatkih ujemala z GPT-3.5-turbo v svojih predlaganih merilih in ga celo presegla na področjih svetovnega in strokovnega znanja.

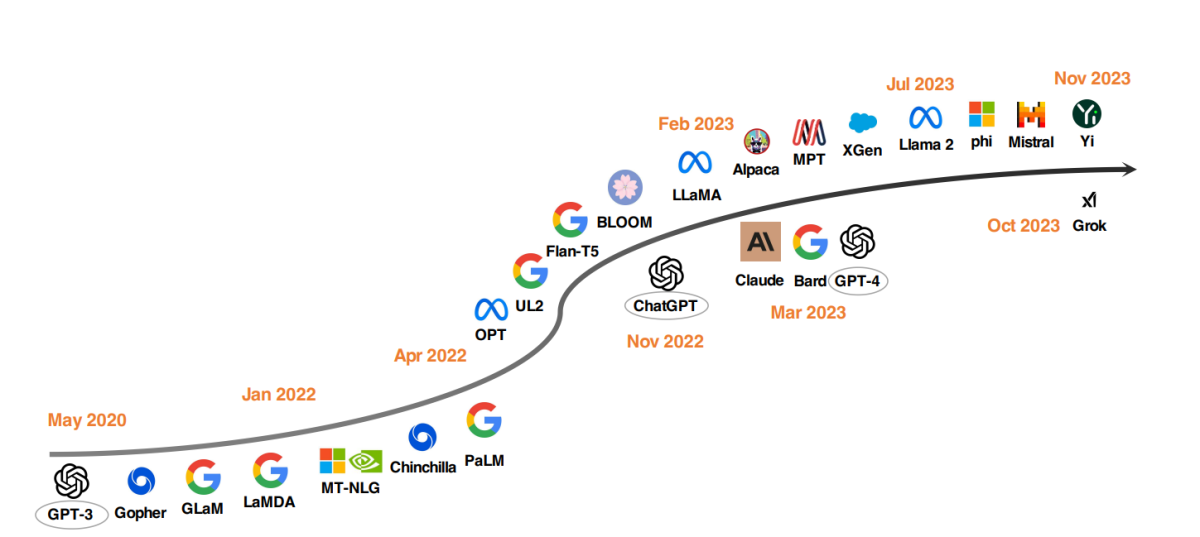

Širjenje: Vzpon velikih LLM

Opazen trend v razvoju LLM je povečevanje parametrov modela. Modeli, kot so Gopher, GLaM, LaMDA, MT-NLG in PaLM, so premaknili meje in dosegli vrhunec v modelih z do 540 milijardami parametrov. Ti modeli so pokazali izjemne zmogljivosti, vendar je njihova zaprtokodna narava omejila njihovo širšo uporabo. Ta omejitev je spodbudila zanimanje za razvoj odprtokodnih LLM, trend, ki dobiva zagon.

Vzporedno s povečanjem velikosti modelov so raziskovalci raziskovali alternativne strategije. Namesto da bi samo povečali modele, so se osredotočili na izboljšanje predhodnega usposabljanja manjših modelov. Primeri vključujejo Chinchilla in UL2, ki sta pokazala, da več ni vedno boljše; tudi pametnejše strategije lahko prinesejo učinkovite rezultate. Poleg tega je bilo veliko pozornosti namenjene prilagajanju navodil jezikovnih modelov, pri čemer so projekti, kot so FLAN, T0 in Flan-T5, pomembno prispevali k temu področju.

Katalizator ChatGPT

Predstavitev OpenAI-jev ChatGPT pomenilo prelomnico v NLP raziskavah. Da bi konkurirala OpenAI, sta podjetji, kot sta Google in Anthropic, lansirali lastna modela, Bard oziroma Claude. Medtem ko ti modeli pri mnogih opravilih kažejo primerljivo zmogljivost kot ChatGPT, še vedno zaostajajo za najnovejšim modelom OpenAI, GPT-4. Uspeh teh modelov se v prvi vrsti pripisuje okrepljenemu učenju iz človeških povratnih informacij (RLHF), tehniki, ki je deležna večjega raziskovalnega poudarka za nadaljnje izboljšave.

Govorice in ugibanja o Q* (Q-Star) OpenAI

Nedavna poročila nakazujejo, da so raziskovalci pri OpenAI morda dosegli pomemben napredek na področju umetne inteligence z razvojem novega modela, imenovanega Q* (izgovorjena zvezda Q). Domnevno ima Q* zmožnost izvajanja matematike na ravni osnovne šole, kar je med strokovnjaki sprožilo razprave o njegovem potencialu kot mejnika na poti k umetni splošni inteligenci (AGI). Čeprav OpenAI ni komentiral teh poročil, so govorice o sposobnostih Q* povzročile precejšnje navdušenje in špekulacije na družbenih omrežjih in med navdušenci nad AI.

Razvoj Q* je omembe vreden, ker obstoječi jezikovni modeli, kot sta ChatGPT in GPT-4, čeprav zmorejo nekatere matematične naloge, niso posebej spretni pri njihovem zanesljivem ravnanju. Izziv je v tem, da morajo modeli umetne inteligence ne samo prepoznati vzorce, kot to počnejo trenutno z globokim učenjem in transformatorji, ampak tudi sklepati in razumeti abstraktne koncepte. Matematika, ki je merilo za sklepanje, zahteva, da umetna inteligenca načrtuje in izvede več korakov, kar dokazuje globoko razumevanje abstraktnih konceptov. Ta sposobnost bi pomenila pomemben preskok v zmogljivostih AI, ki bi se lahko razširila onkraj matematike na druge zapletene naloge.

Vendar pa strokovnjaki svarijo pred pretiravanjem s tem razvojem. Čeprav bi bil sistem umetne inteligence, ki zanesljivo rešuje matematične probleme, impresiven dosežek, ni nujno, da nakazuje prihod superinteligentne umetne inteligence ali AGI. Sedanje raziskave umetne inteligence, vključno s prizadevanji OpenAI, so se osredotočile na osnovne probleme z različnimi stopnjami uspeha pri bolj zapletenih nalogah.

Možni napredki v aplikacijah, kot je Q*, so ogromni, od prilagojenega poučevanja do pomoči pri znanstvenih raziskavah in inženiringu. Vendar pa je pomembno tudi upravljati s pričakovanji ter prepoznati omejitve in varnostne pomisleke, povezane s takšnim napredkom. Pomisleki, da umetna inteligenca predstavlja eksistencialna tveganja, kar je temeljna skrb OpenAI, ostajajo pomembni, zlasti ko se sistemi umetne inteligence začnejo bolj povezovati z resničnim svetom.

Odprtokodno LLM gibanje

Da bi spodbudila odprtokodne LLM raziskave, je Meta izdala modele serije Llama, kar je sprožilo val novih razvojev, ki temeljijo na Llami. To vključuje modele, natančno nastavljene s podatki o navodilih, kot so Alpaca, Vicuna, Lima in WizardLM. Raziskave se prav tako razvejajo v izboljšanje zmogljivosti agentov, logično razmišljanje in modeliranje dolgega konteksta znotraj okvira, ki temelji na Llami.

Poleg tega obstaja vse večji trend razvoja zmogljivih LLM-jev iz nič, s projekti, kot so MPT, Falcon, XGen, Phi, Baichuan, Mistral, Grok, in Yi. Ta prizadevanja odražajo zavezanost demokratizaciji zmogljivosti zaprtokodnih LLM-jev, zaradi česar so napredna orodja AI bolj dostopna in učinkovita.

Vpliv ChatGPT in odprtokodnih modelov v zdravstvu

Gledamo v prihodnost, v kateri doktorji znanosti pomagajo pri kliničnem zapisovanju, izpolnjevanju obrazcev za povračila in podpirajo zdravnike pri diagnosticiranju in načrtovanju zdravljenja. To je pritegnilo pozornost tako tehnoloških velikanov kot zdravstvenih ustanov.

Microsoftova pogovori z Epic, vodilni ponudnik programske opreme za elektronske zdravstvene zapise, signalizira integracijo LLM v zdravstveno varstvo. Pobude že potekajo na UC San Diego Health in Stanford University Medical Center. Podobno tudi pri Googlu partnerstva s kliniko Mayo in Amazon Web Services' uvedba HealthScribe, storitve klinične dokumentacije z umetno inteligenco, pomeni pomembne korake v tej smeri.

Vendar te hitre uvedbe vzbujajo pomisleke glede prenosa nadzora nad medicino interesom podjetij. Zaradi lastniške narave teh LLM jih je težko oceniti. Njihova morebitna sprememba ali ukinitev zaradi dobičkonosnosti bi lahko ogrozila oskrbo bolnikov, zasebnost in varnost.

Nujno je potreben odprt in vključujoč pristop k razvoju LLM v zdravstvu. Zdravstvene ustanove, raziskovalci, kliniki in pacienti morajo sodelovati po vsem svetu, da bi zgradili odprtokodne LLM-je za zdravstveno varstvo. Ta pristop, podoben konzorciju Trillion Parameter, bi omogočil združevanje računskih, finančnih virov in strokovnega znanja.