Inteligența artificială

De ce studenții LLM se gândesc prea mult la puzzle-uri ușoare, dar renunță la cele dificile

Inteligența artificială a făcut progrese remarcabile, cu ajutorul Modelelor Limbajului Large (LLM) și omologilor lor avansati, Modele de raționament larg (LRM), redefinind modul în care mașinile procesează și generează text asemănător cu cel uman. Aceste modele pot scrie eseuri, pot răspunde la întrebări și chiar pot rezolva probleme matematice. Cu toate acestea, în ciuda abilităților lor impresionante, aceste modele afișează un comportament curios: adesea complică excesiv probleme simple în timp ce se luptă cu unele complexe. Un studiu recent studiu de către cercetătorii Apple oferă informații valoroase despre acest fenomen. Acest articol explorează de ce LLM-urile și LRM-urile se comportă în acest fel și ce înseamnă acest lucru pentru viitorul inteligenței artificiale.

Înțelegerea programelor de masterat în drept (LLM) și de masterat în drept (LRM)

Pentru a înțelege de ce LLM-urile și LRM-urile se comportă în acest fel, trebuie mai întâi să clarificăm ce sunt aceste modele. LLM-urile, cum ar fi GPT-3 sau BERT, sunt antrenate pe seturi vaste de date de text pentru a prezice următorul cuvânt dintr-o secvență. Acest lucru le face excelente în sarcini precum generarea de text, traducerea și rezumarea. Cu toate acestea, ele nu sunt în mod inerent concepute pentru raționament, care implică deducție logică sau rezolvarea problemelor.

Modelele LRM sunt o nouă clasă de modele concepute pentru a aborda această lacună. Acestea încorporează tehnici precum Lanțul de gândire (CoT) sugestii, în care modelul generează pași intermediari de raționament înainte de a oferi un răspuns final. De exemplu, atunci când rezolvă o problemă de matematică, un LRM ar putea să o descompună în pași, la fel cum ar face-o o ființă umană. Această abordare îmbunătățește performanța în sarcini complexe, dar se confruntă cu provocări atunci când se confruntă cu probleme de complexitate variabilă, așa cum dezvăluie studiul Apple.

Studiul de cercetare

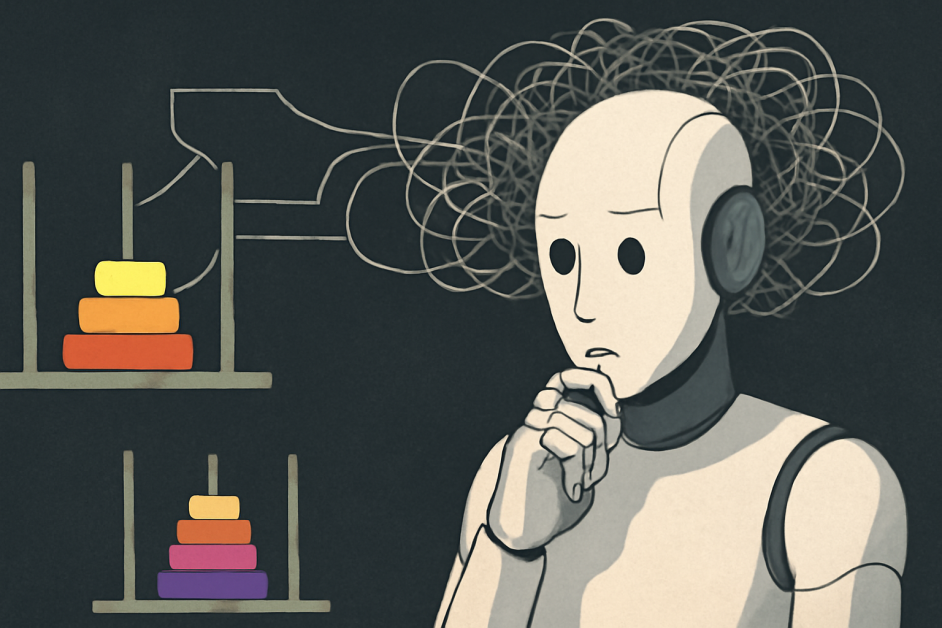

Echipa de cercetare Apple a adoptat o altă opinie abordare pentru a evalua capacitățile de raționament ale LLM-urilor și LRM-urilor. În loc să se bazeze pe teste tradiționale, cum ar fi testele de matematică sau de codare, care pot fi afectate de contaminarea datelor (unde modelele memorează răspunsurile), au creat medii controlate de puzzle-uri. Acestea au inclus puzzle-uri bine-cunoscute, cum ar fi Turnul din Hanoi, Sărituri de dame, Trecerea râuluiși Blocks World. De exemplu, Turnul Hanoi implică mutarea discurilor între cuie respectând reguli specifice, complexitatea crescând pe măsură ce se adaugă mai multe discuri. Prin ajustarea sistematică a complexității acestor puzzle-uri, menținând în același timp structuri logice consecvente, cercetătorii observă cum performează modelele într-un spectru de dificultăți. Această metodă le-a permis să analizeze nu numai răspunsurile finale, ci și procesele de raționament, ceea ce oferă o perspectivă mai profundă asupra modului în care aceste modele „gândesc”.

Constatări despre gândirea excesivă și renunțarea

Studiul a identificat trei regimuri distincte de performanță bazate pe complexitatea problemei:

- La niveluri scăzute de complexitate, LLM-urile standard au adesea performanțe mai bune decât LRM-urile, deoarece LRM-urile tind să gândească prea mult, generând pași suplimentari care nu sunt necesari, în timp ce LLM-urile standard sunt mai eficiente.

- Pentru problemele de complexitate medie, LRM-urile prezintă performanțe superioare datorită capacității lor de a genera urme de raționament detaliate care le ajută să abordeze eficient aceste provocări.

- Pentru problemele de complexitate ridicată, atât LLM-urile, cât și LRM-urile eșuează complet; LRM-urile, în special, experimentează o scădere totală a preciziei și își reduc efortul de raționament în ciuda dificultății crescute.

Pentru puzzle-uri simple, cum ar fi Turnul Hanoi cu unul sau două discuri, LLM-urile standard au fost mai eficiente în a oferi răspunsuri corecte. Cu toate acestea, LRM-urile au abordat adesea prea mult aceste probleme, generând urme lungi de raționament chiar și atunci când soluția era simplă. Acest lucru sugerează că LRM-urile pot imita explicații exagerate din datele lor de antrenament, ceea ce ar putea duce la ineficiență.

În scenarii moderat complexe, LRM-urile au avut performanțe mai bune. Capacitatea lor de a produce pași de raționament detaliați le-a permis să abordeze probleme care necesitau mai mulți pași logici. Acest lucru le permite să depășească LLM-urile standard, care se chinuiau să mențină coerența.

Totuși, pentru puzzle-uri extrem de complexe, cum ar fi Turnul Hanoi cu multe discuri, ambele modele au eșuat complet. În mod surprinzător, modelele LRM și-au redus efortul de raționament pe măsură ce complexitatea a crescut dincolo de un anumit punct, în ciuda faptului că dispuneau de suficiente resurse de calcul. Acest comportament de „abandonare” indică o limitare fundamentală în capacitatea lor de a scala capacitățile de raționament.

De ce se întâmplă asta

Exagerarea gândirii la puzzle-uri simple provine probabil din modul în care sunt antrenați LLM-urile și LRM-urile. Aceste modele învață din seturi de date vaste care includ atât explicații concise, cât și detaliate. Pentru probleme ușoare, acestea pot genera implicit urme de raționament detaliate, imitând exemplele lungi din datele lor de antrenament, chiar și atunci când un răspuns direct ar fi suficient. Acest comportament nu este neapărat un defect, ci o reflectare a antrenamentului lor, care prioritizează raționamentul în detrimentul eficienței.

Eșecul în rezolvarea puzzle-urilor complexe reflectă incapacitatea LLM-urilor și a LRM-urilor de a învăța să generalizeze reguli logice. Pe măsură ce complexitatea problemei crește, dependența lor de potrivirea tiparelor scade, ceea ce duce la raționament inconsistent și la o scădere a performanței. Studiul a constatat că LRM-urile nu reușesc să utilizeze algoritmi expliciți și raționează inconsistent în diferite puzzle-uri. Acest lucru evidențiază faptul că, deși aceste modele pot simula raționamentul, ele nu înțeleg cu adevărat logica subiacentă așa cum o fac oamenii.

Perspective Diverse

Acest studiu a stârnit discuții în comunitatea IA. Unii experți argumenta că aceste descoperiri ar putea fi interpretat greșitAceștia sugerează că, deși LLM-urile și LRM-urile pot să nu raționeze ca oamenii, ele demonstrează totuși o rezolvare eficientă a problemelor în anumite limite de complexitate. Subliniază faptul că „raționamentul” în IA nu trebuie să reflecte cogniția umană pentru a fi valoros. În mod similar, discuții pe platforme precum Hacker News laudă abordarea riguroasă a studiului, dar subliniază necesitatea unor cercetări suplimentare pentru a îmbunătăți raționamentul bazat pe inteligență artificială. Aceste perspective subliniază dezbaterea continuă despre ce constituie raționamentul în inteligență artificială și cum ar trebui să îl evaluăm.

Implicații și direcții viitoare

Constatările studiului au implicații semnificative pentru dezvoltarea inteligenței artificiale. Deși modelele de raționament la distanță (LRM) reprezintă un progres în imitarea raționamentului uman, limitările lor în gestionarea problemelor complexe și scalarea eforturilor de raționament sugerează că modelele actuale sunt departe de a realiza un raționament generalizabil. Acest lucru subliniază necesitatea unor noi metode de evaluare care să se concentreze pe calitatea și adaptabilitatea proceselor de raționament, nu doar pe acuratețea răspunsurilor finale.

Cercetările viitoare ar trebui să urmărească îmbunătățirea capacității modelelor de a executa cu precizie pași logici și de a ajusta efortul de raționament în funcție de complexitatea problemei. Dezvoltarea unor repere care reflectă sarcini de raționament din lumea reală, cum ar fi diagnosticul medical sau argumentarea juridică, ar putea oferi perspective mai semnificative asupra capacităților IA. În plus, abordarea dependenței excesive a modelelor de recunoașterea tiparelor și îmbunătățirea capacității lor de a generaliza regulile logice vor fi cruciale pentru avansarea raționamentului bazat pe IA.

Linia de jos

Studiul oferă o analiză critică a capacităților de raționament ale modelelor LLM și LRM. Acesta demonstrează că, deși aceste modele analizează excesiv puzzle-uri simple, acestea se confruntă cu dificultăți în rezolvarea celor mai complexe, expunând atât punctele forte, cât și limitele lor. Deși au performanțe bune în anumite situații, incapacitatea lor de a aborda probleme extrem de complexe evidențiază decalajul dintre raționamentul simulat și înțelegerea reală. Studiul subliniază necesitatea dezvoltării unui sistem de inteligență artificială care să poată raționa adaptiv pe diferite niveluri de complexitate, permițându-i să abordeze probleme cu complexități variate, la fel cum fac oamenii.