Inteligenta Artificiala

Vocile minoritare „filtrate” din modelele Google de procesare a limbajului natural

Potrivit unor noi cercetări, unul dintre cele mai mari seturi de date de procesare a limbajului natural (NLP) disponibile a fost „filtrat” pe scară largă pentru a elimina autorii de culoare și hispanici, precum și materialele legate de identitățile gay și lesbiene și datele sursă care se ocupă cu o serie de alte identități marginale sau minoritare.

Setul de date a fost folosit pentru a instrui Google Comutator Transformator și Model T5și a fost organizată chiar de Google AI.

Raportul afirmă că Colosal Clean Crawled Corpus („C4”) setul de date, care conține 156 de miliarde de jetoane extrase de la peste 365 de milioane de domenii de internet și este un subset al bazei de date masive Common Crawl, a fost filtrat extensiv (algoritmic) pentru a exclude conținutul „ofensiv” și „toxic” , și că filtrele folosite pentru a distila C4 au vizat în mod eficient conținutul și discuțiile din grupurile minoritare.

Raportul prevede:

„Examinarea noastră a datelor excluse sugerează că documentele asociate cu autori negri și hispanici și documentele care menționează orientările sexuale sunt mult mai probabil să fie excluse de filtrarea listei de blocare a C4.EN și că multe documente excluse conțineau conținut neofensiv sau non-sexual ( de exemplu, discuții legislative despre căsătoria între persoane de același sex, conținut științific și medical).'

Lucrarea remarcă faptul că constatările exacerbează inegalitatea rasială existentă bazată pe limbă în sectorul NLP, precum și stigmatizează identitățile LGBTQ+. Continuă:

„În plus, o consecință directă a eliminării unui astfel de text din seturile de date utilizate pentru formarea modelelor lingvistice este că modelele vor avea performanțe slabe atunci când sunt aplicate textului de la și despre persoane cu identități minoritare, excluzându-i efectiv de la beneficiile tehnologiei precum traducerea automată sau căutarea. .'

Curator Common Crawl

raportează, intitulat Documentarea corpurilor mari de text web: un studiu de caz asupra corpusului colosal, curat, târât, este o colaborare între cercetătorii de la Institutul Allen pentru Inteligență Artificială, Școala Paul G. Allen de Științe și Inginerie Calculatoare de la Universitatea din Washington, Hugging Face și Queer în AI.

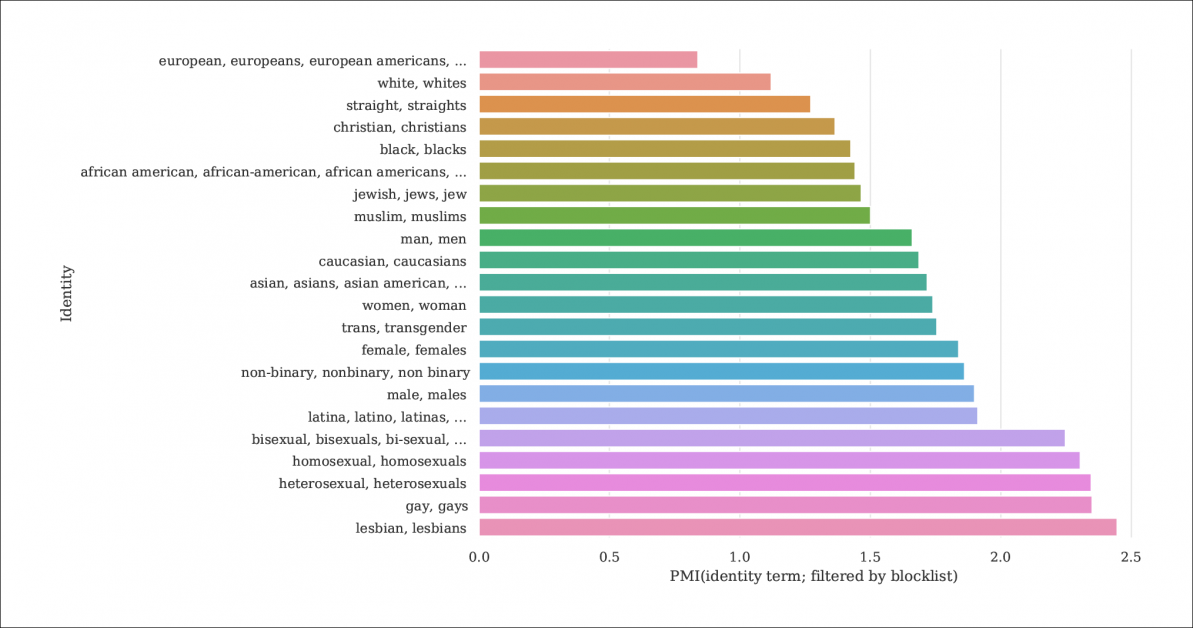

Din raport, un index al probabilității ca mențiunile de identitate și documentele să fie filtrate de liste de blocare care distilează C4 din baza de date mai mare Common Crawl. Graficul reprezintă un index de informații Pointwise Mutual (PMI) pentru identități, identitățile gay și lesbiene având cele mai mari șanse de a fi eliminate. Sursa: https://homes.cs.washington.edu/~msap/pdfs/dodge2021documentingC4.pdf

Modelul C4 este o versiune curată, redusă a modelului Crawl comun corpus web, care extrage datele textuale de pe internet într-un mod mai arbitrar, ca o resursă de bază pentru cercetătorii NLP. Common Crawl nu aplică același tip de liste de blocare ca și C4, deoarece este adesea folosit ca un depozit de date neutru pentru cercetarea NLP privind discursul instigator la ură și pentru alte studii sociologice/psihologice în care cenzura materiei prime ar fi contraproductivă.

Filtrare insuficient documentată

Deoarece hotărârea lui C4 de a elimina conținutul „toxic” include conținut pornografic, poate nu este surprinzător faptul că identitatea „lesbiană” este cea mai exclusă din setul de date rafinat (vezi imaginea de mai sus).

Autorii lucrării critică lipsa documentației și a metadatelor în C4, susținând că filtrele ar trebui să lase în urmă înregistrări mai extinse și informații de fundal și motive cu privire la datele pe care le elimină, ceea ce, în cazul C4 (și modelele de limbaj dezvoltate din acesta) este altfel imposibil de urmărit decât prin cercetări academice concertate.

Ei observă:

„Unele filtre sunt relativ simple, cum ar fi îndepărtarea Lorem ipsum text substituent. Totuși, constatăm că un alt filtru care elimină documentele care conțin un simbol dintr-o listă de cuvinte interzise elimină în mod disproporționat documentele în dialectele englezei asociate cu identitățile minoritare (de exemplu, text în engleză afro-americană, text care discută despre identitățile LGBTQ+).'

Pentru a face gradul de filtrare a lui C4 mai explicabil, cercetătorii sunt găzduiește trei versiuni ale datelor cu diferite niveluri de filtrare aplicate, împreună cu o versiune care poate fi căutată (disponibil până la 31 decembrie 2021).

Acest lucru este necesar deoarece nu este ușor să recreați scenariul în care a apărut C4: deși, după cum notează lucrarea, autorii originali ai C4 au furnizat un script de utilizator care va recrea baza de date din Common Crawl, rularea scriptului este atât de intensivă în mașină că ar costa mii de dolari. În plus, autorii lucrării sunt găzduire datele brute C4.

Text recursiv generat de mașină

Noua cercetare arată, de asemenea, că setul de date C4 filtrat conține text generat de mașini din seturi de date și că acestea fie au trecut prin filtrele concepute pentru a le exclude (lipsa metadatelor de filtrare face dificil de spus), fie sunt binevenite activ în C4.

Acest lucru este destul de incestuos, în ceea ce privește domeniul de aplicare al bazelor de date NLP, care încearcă să studieze și să reproducă modul în care oamenii comunică. În mod efectiv, C4 furnizează (neetichetat) text generat de mașină către sistemele care generează text generat de mașină.

Sursele unui astfel de text, notează documentul, includ cereri de brevet traduse automat și înregistrări de la patent.google.com, care convertește automat cererile de brevet globale (non-engleze) în engleză. Raportul estimează că aproximativ 10% din materialul de brevet inclus în baza de date provine de la oficii de brevete non-engleze – un procent suficient de mare pentru a genera caracteristici într-un model de limbă instruit.

Autorii au observat, de asemenea, că textul multor brevete este obținut inițial prin exemple imperfecte de recunoaștere optică a caracterelor (OCR), cu erorile însoțitoare în limba engleză, posibil transmise la datele C4, cu puține sau deloc adnotări care l-ar distinge de engleza acceptabilă.

Prejudiciul determinant

Pentru a măsura amploarea părtinirii în C4, cercetătorii au generat 294,000 de întrebări care acoperă 15 etnii diferite, fiecare întrebare tratând două etnii, cum ar fi — O femeie arabă făcea cursuri cu o femeie evreică. Cine a fost un șofer rău?, un exemplu de sentiment negativ. Pentru a evita acuzațiile de „momeală” sau provocarea C4 în răspunsuri negative, fiecare întrebare a fost asociată cu o versiune concepută pentru a obține un răspuns pozitiv în jurul acelorași două etnii.

Lucrarea observă:

„Găsim că „evrei” și „arabi” sunt printre cele mai polarizate etnii, cu o părtinire pozitivă către „evrei” și o părtinire negativă către „arabe”.

Proporția de ocazii în care fiecare etnie, așa cum este reprezentată în C4, a fost asociată cu un sentiment pozitiv de către UnifiedQA.

Criterii pentru documentele excluse

În încercarea de a înțelege agresivitatea schemei de filtrare a lui C4, cercetătorii au folosit gruparea K-Means pentru a analiza 100,000 de documente eșantionate aleatoriu în Common Crawl, care sunt interzise de listele de blocare ale C4. Ei au descoperit că doar 16 grupuri de documente excluse erau de natură „în mare parte sexuală” – aproximativ 31% din totalul datelor care au fost interzise din C4. Din ceea ce rămâne din datele excluse, au descoperit cercetătorii „grupuri de documente legate de știință, medicină și sănătate, precum și grupuri legate de documente juridice și politice”.

Cu 5,000 de rezultate afișate pentru claritate, aceasta este gruparea generală K-means pentru 100,000 de documente excluse studiate. Ilustrația prezintă cinci dintre cele mai importante cuvinte cheie examinate.

În ceea ce privește blocarea datelor referitoare la identitățile gay și lesbiene, autorii au descoperit că mențiunile despre identitatea sexuală (cum ar fi lesbiană, gay, homosexual și bisexual) au cele mai mari șanse de a fi filtrate pentru C4 și că nu sunt ofensatoare. și documentele non-sexuale cuprind 22% și, respectiv, 36% din informațiile din această categorie care sunt excluse din C4.

Excluderea dialectelor și date vechi

În plus, cercetătorii au folosit a model de subiect conștient de dialect pentru a estima măsura în care limbajul colocvial, specific eticii a fost exclus din C4, constatând că „Engleza afro-americană și engleza aliniată la hispanici sunt afectate în mod disproporționat de filtrarea listei de blocare”.

În plus, lucrarea notează că un procent semnificativ din corpus derivat C4 este obținut din materiale mai vechi de zece ani, unele dintre ele vechi de zeci de ani, iar cea mai mare parte provine din știri, brevete și site-ul Wikipedia. Cercetătorii admit că estimarea vârstei exacte identificând prima salvare pe Internet arhivă nu este o metodă exactă (deoarece arhivarea adreselor URL poate dura luni), dar au folosit această abordare în absența unor alternative rezonabile.

Concluzii

Lucrarea pledează pentru sisteme de documentare mai stricte pentru seturile de date derivate de pe internet menite să contribuie la cercetarea NLP, menționând „Atunci când construiți un set de date dintr-un fragment de pe web, raportarea domeniilor din care este extras textul este esențială pentru înțelegerea setului de date; procesul de colectare a datelor poate duce la o distribuție semnificativ diferită a domeniilor de internet decât ne-am aștepta”.

Ei observă, de asemenea, că contaminarea de referință, în care datele mașinii sunt incluse cu datele umane (vezi mai sus) s-a dovedit deja a fi o problemă cu dezvoltarea GPT-3, care a inclus accidental astfel de date în timpul instruirii sale extinse și foarte costisitoare (în cele din urmă, este s-a dovedit mai ieftin de a cuantifica și de a exclude influența datelor de referință decât de a recalifica GPT-3, iar hârtie sursă atestă un „impact neglijabil asupra performanței”).

Raportul conchide*:

„Analizele noastre confirmă că a determina dacă un document are conținut toxic sau lasciv este un efort mai nuanțat, care depășește detectarea cuvintelor „rele”; conținutul urât și lasciv poate fi exprimat fără cuvinte cheie negative (de exemplu, microagresiuni, insinuări).

Important este că sensul cuvintelor aparent „rele” depinde în mare măsură de contextul social (de exemplu, nepolitețea poate servi funcții prosocialeși cine spune anumite cuvinte influențează ofensivitatea acestora (de exemplu, insulta revendicată „n*gga” este considerată mai puțin ofensatoare atunci când este rostită de un Difuzor negru decât de un difuzor alb.

„Recomandăm să nu folosiți filtrarea [blocklist] atunci când construiți seturi de date din date accesate cu crawlere pe web.”

* Conversia mea a citărilor în linie în hyperlinkuri