Inteligența artificială

UniTune: Tehnica alternativă de editare a imaginilor neuronale de la Google

Se pare că Google Research atacă editarea imaginilor bazată pe text din mai multe puncte de vedere și, probabil, așteaptă să vadă ce „se întâmplă”. Sunt pe urmele lansării din această săptămână a... Hârtie magică, gigantul căutării a propus o metodă suplimentară bazată pe difuzie latentă de a efectua editări altfel imposibile bazate pe AI asupra imaginilor prin comenzi text, de data aceasta numită UniTune.

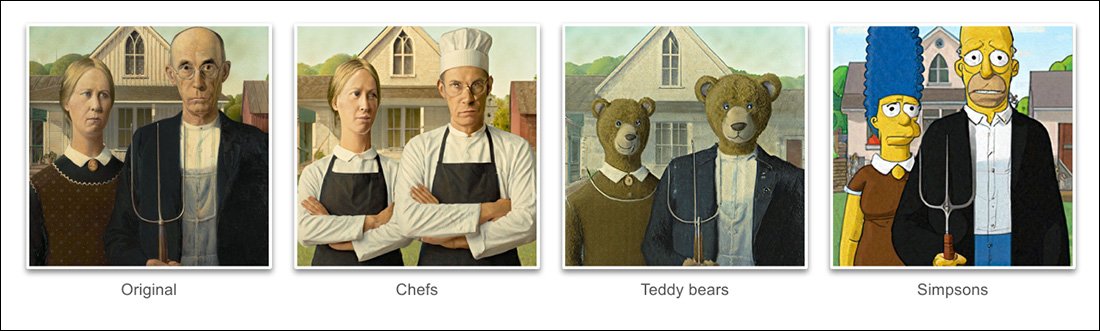

Pe baza exemplelor date în proiectul hârtie nouă, UniTune a atins un grad extraordinar de descurcarea de poziție și idee semantică din conținutul real al imaginii:

Stăpânirea compoziției semantice de către UniTune este remarcabilă. Observați cum, în rândul de imagini de sus, fețele celor două persoane nu au fost distorsionate de transformarea extraordinară din restul imaginii sursă (dreapta). Sursă: https://arxiv.org/pdf/2210.09477.pdf

După cum au învățat până acum fanii Stable Diffusion, aplicarea editărilor la secțiuni parțiale ale unei imagini fără a modifica negativ restul imaginii poate fi o operație dificilă, uneori imposibilă. Deși distribuții populare precum AUTOMAT1111 poate crea măști pentru editări locale și restricționate, procesul este întortocheat și adesea imprevizibil.

Răspunsul evident, cel puțin pentru un practicant de viziune computerizată, este să interpună un strat de segmentare semantică care este capabilă să recunoască și să izoleze obiecte dintr-o imagine fără intervenția utilizatorului și, într-adevăr, au existat recent mai multe inițiative noi pe această linie de gândire.

O alta posibilitate pentru blocarea operațiunilor de editare neuronală dezordonate și încurcate este de a valorifica influenta pre-antrenament Contrastiv al Limbajului-Imagine al OpenAI (CLIP), care se află în centrul modelelor de difuzie latentă, cum ar fi DALL-E 2 și Stable Diffusion, pentru a acționa ca un filtru în punctul în care un model text-to-image este gata să trimită o randare interpretată înapoi utilizatorului . În acest context, CLIP ar trebui să acționeze ca un modul de santinelă și de control al calității, respingând randurile defectuoase sau inadecvate. Aceasta este pe cale de a fi instituit (Link Discord) pe portalul DreamStudio API al Stability.ai.

Totuși, întrucât CLIP este, fără îndoială, atât vinovatul, cât și soluția într-un astfel de scenariu (deoarece, în esență, a influențat și modul în care a evoluat imaginea) și întrucât cerințele hardware pot depăși ceea ce este probabil disponibil local pentru un utilizator final, această abordare s-ar putea să nu fie ideală.

Limbajul comprimat

În schimb, UniTune propus „ajustează fin” un model de difuzie existent – în acest caz, Imagen, propriul model de Google, deși cercetătorii afirmă că metoda este compatibilă cu alte arhitecturi de difuzie latentă – astfel încât în acesta este injectat un token unic care poate fi activat prin includerea sa într-un mesaj text.

La valoarea nominală, asta sună ca Google cabină de vis, în prezent o obsesie în rândul fanilor și dezvoltatorilor de Stable Diffusion, care pot injecta personaje sau obiecte noi într-un punct de control existent, adesea în mai puțin de o oră, pe baza doar o mână de imagini sursă; sau altfel ca Inversie textuală, care creează fișiere „sidecar” pentru un punct de control, care sunt apoi tratate ca și cum ar fi fost inițial antrenate în model și poate profita de resursele vaste ale modelului prin modificarea clasificatorului său de text, rezultând un fișier minuscul (comparativ cu punctele de control eliminate de minimum 2 GB ale DreamBooth).

De fapt, susțin cercetătorii, UniTune a respins ambele abordări. Ei au descoperit că Textual Inversion a omis prea multe detalii importante, în timp ce DreamBooth „a avut rezultate mai slabe și a durat mai mult” decât soluția la care s-au hotărât în cele din urmă.

Cu toate acestea, UniTune folosește aceeași abordare semantică încapsulată de tip „metaprompt” ca și DreamBooth, cu modificări antrenate invocate de cuvinte unice alese de antrenor, care nu vor intra în conflict cu niciun termen existent în prezent într-un model de lansare publică antrenat laborios.

„Pentru a efectua operațiunea de editare, eșantionăm modelele ajustate fin cu promptul «[rare_tokens] edit_prompt» (de exemplu, «beikkpic two dogs in a restaurant» sau «beikkpic a minion»).”

Cum lucram impreuna

Deși este derutant de ce două lucrări aproape identice, în ceea ce privește funcționalitatea lor finală, ar trebui să ajungă de la Google în aceeași săptămână, există, în ciuda numărului mare de asemănări dintre cele două inițiative, cel puțin o diferență clară între UniTune și Imagic - cea din urmă folosește instrucțiuni în limbaj natural „necomprimat” pentru a ghida operațiunile de editare a imaginilor, în timp ce UniTune se antrenează cu token-uri unice în stil DreamBooth.

Prin urmare, dacă editați cu Imagic și doriți să efectuați o transformare de această natură...

Din articolul UniTune – UniTune se compară cu SDEdit, framework-ul de editare neuronală preferat al Google. Rezultatele UniTune sunt în extrema dreaptă, în timp ce masca estimată este vizibilă în a doua imagine din stânga.

.. în Imagic, ai introduce a treia persoană, stând în fundal, ca un monstru blănos drăguț.

Comanda UniTune echivalentă ar fi „Tipul din spate ca [x]”, În cazul în care x este orice cuvânt ciudat și unic a fost legat de conceptul bine pregătit asociat cu personajul monstrului cu blană.

În timp ce un număr de imagini sunt introduse fie în DreamBooth, fie în Textual Inversion cu intenția de a crea o abstracție în stil deepfake care poate fi comandată în mai multe ipostaze, atât UniTune, cât și Imagic introduc în schimb o singură imagine în sistem - imaginea originală, curată.

Acest lucru este similar cu modul în care au funcționat multe dintre instrumentele de editare bazate pe GAN din ultimii ani - prin convertirea unei imagini de intrare în coduri latente în spațiul latent al GAN, apoi adresarea acelor coduri și trimiterea lor către alte părți ale spațiului latent pentru modificare (de exemplu, introducerea unei imagini a unei persoane tinere cu părul închis la culoare și proiectarea acesteia prin coduri latente asociate cu „bătrân” sau „blond” etc.).

Cu toate acestea, rezultatele, într-un model de difuzie și prin această metodă, sunt destul de uimitor de precise prin comparație și mult mai puțin ambigue:

Procesul de reglare fină

Metoda UniTune trimite, în esență, imaginea originală printr-un model de difuzie cu un set de instrucțiuni despre cum ar trebui modificată, utilizând vastele depozite de date disponibile, antrenate în model. Practic, puteți face acest lucru chiar acum cu ajutorul Stable Diffusion. img2img funcționalitate – dar nu fără deformarea sau schimbarea într-un fel a părților imaginii pe care ați prefera să le păstrați.

În timpul procesului UniTune, sistemul este ajustare precisăd, adică UniTune obligă modelul să reia antrenamentul, cu majoritatea straturilor dezghețate (vezi mai jos). În cele mai multe cazuri, reglarea fină va reduce generalul general valorile de pierdere ale unui model de înaltă performanță câștigat cu greu în favoarea injectării sau rafinării unui alt aspect care se dorește a fi creat sau îmbunătățit.

Totuși, cu UniTune se pare că exemplarul modelului asupra căruia se acționează, deși poate cântări câțiva gigaocteți sau mai mult, va fi tratat ca o „coajă” colaterală de unică folosință și aruncat la sfârșitul procesului, având un singur scop. Acest tip de volum de date ocazional devine o criză de stocare cotidiană pentru fanii DreamBooth, ale căror modele, chiar și atunci când sunt eliminate, nu au mai puțin de 2 GB per subiect.

Ca și în cazul Imagic, reglarea principală în UniTune are loc la cele două straturi inferioare din cele trei din Imagen (de bază 64px, 64px>256px și 256px>1024px). Spre deosebire de Imagic, cercetătorii văd o valoare potențială în optimizarea reglajului și pentru acest ultim și cel mai mare strat de super-rezoluție (deși nu au încercat încă).

Pentru cel mai mic strat de 64 de pixeli, modelul este orientat spre imaginea de bază în timpul antrenamentului, cu mai multe perechi duplicate de imagine/text introduse în sistem pentru 128 de iterații la o dimensiune a lotului de 4 și cu Adafactor ca funcție de pierdere, funcționând la o rată de învățare de 0.0001. Desi Encoder T5 singur este înghețat în timpul acestei reglaje, este, de asemenea, înghețat în timpul antrenamentului primar al Imagen

Operația de mai sus se repetă apoi pentru stratul de 64>256px, folosind aceeași procedură de creștere a zgomotului folosită în antrenamentul original al Imagen.

Prelevarea de probe

Există multe metode posibile de eșantionare prin care modificările efectuate pot fi obținute din modelul ajustat, inclusiv Ghidul gratuit pentru clasificare (CFG), un pilon principal al Stable Diffusion. CFG definește practic măsura în care modelul este liber să „își urmeze imaginația” și să exploreze posibilitățile de randare – sau, la setări mai mici, măsura în care ar trebui să adere la datele sursă de intrare și să facă modificări mai puțin ample sau dramatice.

La fel ca Textual Inversion (puțin mai puțin cu DreamBooth), UniTune este capabil să aplice stiluri grafice distincte imaginilor originale, precum și editări mai fotorealiste.

De asemenea, cercetătorii au experimentat SDEditTehnica de „pornire târzie” a sistemului, în care sistemul este încurajat să păstreze detaliile originale, fiind doar parțial „zgomot” de la început, menținându-și însă caracteristicile esențiale. Deși cercetătorii au folosit această tehnică doar pe cel mai de jos strat (64px), ei cred că ar putea fi o tehnică de eșantionare auxiliară utilă în viitor.

Cercetătorii au exploatat și ei prompt-to-prompt ca tehnică suplimentară bazată pe text pentru a condiționa modelul:

„În setarea „prompt to prompt”, am constatat că o tehnică pe care o numim Prompt Guidance este deosebit de utilă pentru a regla fidelitatea și expresivitatea.

„Ghidarea promptă este similară cu Ghidarea fără clasificare, cu excepția faptului că linia de bază este o altă solicitare în loc de modelul necondiționat. Aceasta ghidează modelul către delta dintre cele două solicitări.”

Cu toate acestea, îndrumarea promptă, spun autorii, a fost necesară doar ocazional în cazurile în care CFG nu a reușit să obțină rezultatul dorit.

O altă abordare nouă de eșantionare întâlnită în timpul dezvoltării UniTune a fost interpolare, unde zonele imaginii sunt suficient de distincte încât atât imaginea originală, cât și cea modificată au o compoziție foarte similară, permițând utilizarea unei interpolări mai „naive”.

Interpolarea poate face procesele cu efort mai mare ale UniTune redundante în cazurile în care zonele de transformat sunt discrete și bine marginalizate.

Autorii sugerează că interpolarea ar putea funcționa atât de bine pentru un număr mare de imagini sursă țintă, încât ar putea fi utilizată ca setare implicită și observă, de asemenea, că are puterea de a efectua transformări extraordinare în cazurile în care ocluziile complexe nu trebuie negociate prin metode mai intensive.

UniTune poate efectua editări locale cu sau fără măști de editare, dar poate decide unilateral unde să poziționeze editările, cu o combinație neobișnuită de putere interpretativă și esențializare robustă a datelor de intrare sursă:

În imaginea de sus din a doua coloană, UniTune, însărcinat cu inserarea unui „tren roșu în fundal”, l-a plasat într-o poziție potrivită și autentică. Observați în celelalte exemple cum integritatea semantică a imaginii sursă este menținută chiar și în mijlocul unor modificări extraordinare ale conținutului pixelilor și stilurilor de bază ale imaginilor.

Latență

Deși prima iterație a oricărui sistem nou va fi lentă și deși este posibil ca fie implicarea comunității, fie angajamentul corporativ (de obicei nu sunt ambele) să accelereze și să optimizeze în cele din urmă o rutină care necesită multe resurse, atât UniTune, cât și Imagic efectuează niște manevre de învățare automată destul de importante pentru a crea aceste editări uimitoare și este discutabil în ce măsură un astfel de proces care necesită multe resurse ar putea fi vreodată redus la utilizarea domestică, mai degrabă decât la accesul bazat pe API (deși acesta din urmă ar putea fi mai dezirabil pentru Google).

În prezent, timpul de transfer de la date de intrare la rezultat este de aproximativ 3 minute pe un GPU T4, cu aproximativ 30 de secunde suplimentare pentru inferență (ca în orice rutină de inferență). Autorii recunosc că aceasta este o latență mare și cu greu se califică drept „interactivă”, dar observă și că modelul rămâne disponibil pentru editări ulterioare odată ce a fost reglat inițial, până când utilizatorul termină procesul, ceea ce reduce timpul per editare.

Publicat prima dată pe 21 octombrie 2022.