Unghiul lui Anderson

Restaurarea și editarea imaginilor umane cu ajutorul inteligenței artificiale

O nouă colaborare între Universitatea din California, Merced, și Adobe oferă un progres în ceea ce privește tehnologia de ultimă generație în... completarea imaginii umane – sarcina mult studiată de „deobscuring” părțile oclude sau ascunse ale imaginilor cu persoane, în scopuri precum încercare virtuală, animație și editare foto.

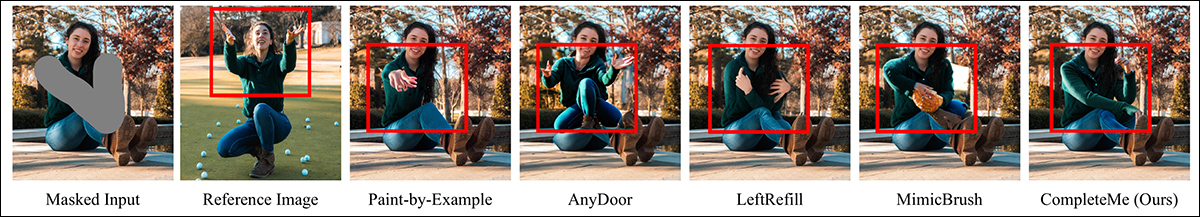

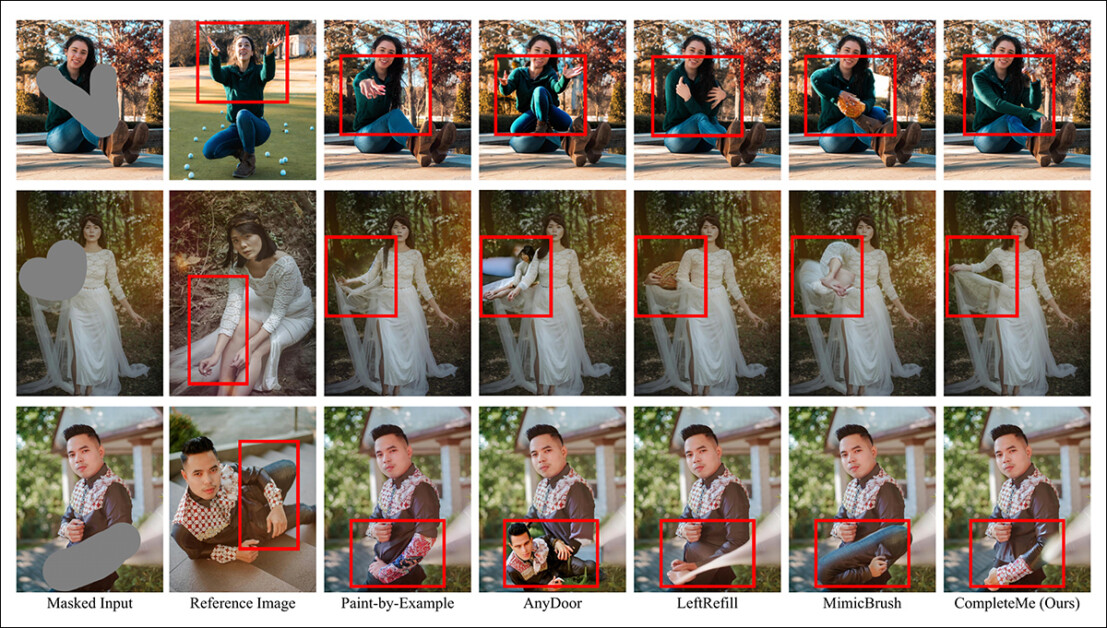

Pe lângă repararea imaginilor deteriorate sau modificarea lor după bunul plac al utilizatorului, sistemele umane de completare a imaginilor, cum ar fi CompleteMe, pot impune îmbrăcăminte nouă (prin intermediul unei imagini de referință suplimentare, ca în coloana din mijloc a acestor două exemple) în imaginile existente. Aceste exemple provin din PDF-ul suplimentar extins pentru noua lucrare. Sursă: https://liagm.github.io/CompleteMe/pdf/supp.pdf

abordare nouă, intitulat CompleteMe: Completare de imagini umane bazată pe referințe, folosește imagini de intrare suplimentare pentru a „sugera” sistemului ce conținut ar trebui să înlocuiască secțiunea ascunsă sau lipsă a reprezentării umane (de unde și aplicabilitatea la cadrele de probă bazate pe modă):

Sistemul CompleteMe poate adapta conținutul de referință la partea ascunsă sau mascată a unei imagini umane.

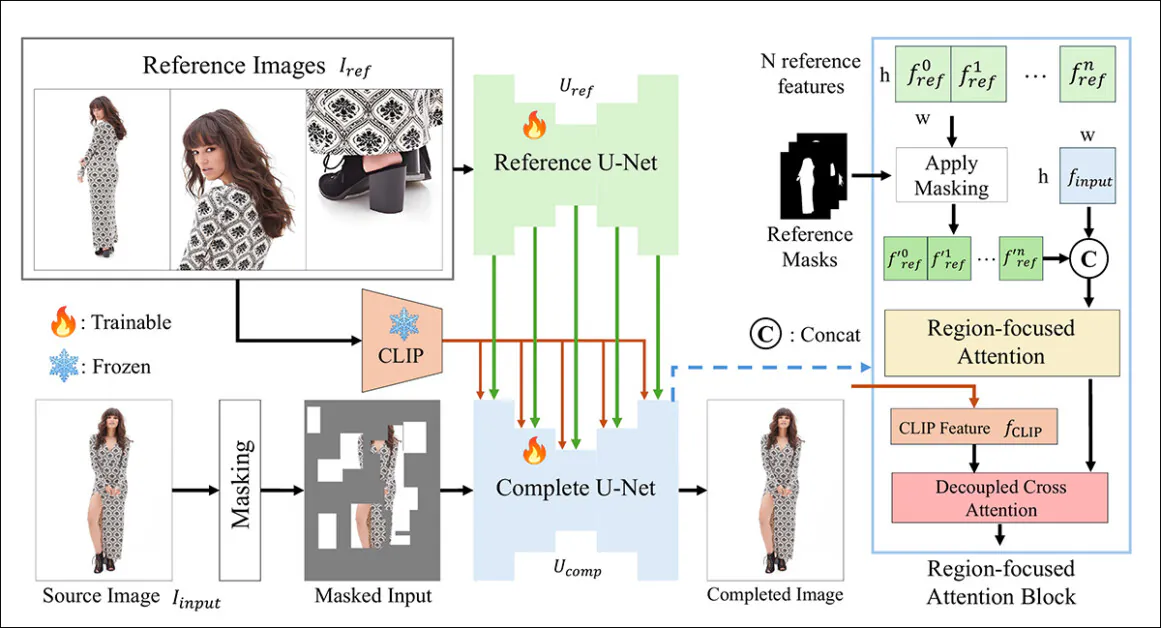

Noul sistem folosește o dublă U-Net arhitectură și o Atenție concentrată pe regiune bloc (RFA) care direcționează resursele către zona relevantă a instanței de restaurare a imaginii.

Cercetătorii oferă, de asemenea, un sistem de benchmarking nou și provocator, conceput pentru a evalua sarcinile de finalizare bazate pe referințe (întrucât CompleteMe face parte dintr-o direcție de cercetare existentă și în curs de desfășurare în domeniul vederii computerizate, deși una care nu a avut până acum o schemă de benchmarking).

În teste și într-un studiu bine scalat al utilizatorilor, noua metodă a ieșit în avantaj la majoritatea indicatorilor și în avantaj per total. În anumite cazuri, metodele rivale au fost complet depășite de abordarea bazată pe referințe:

Din materialul suplimentar: metoda AnyDoor are dificultăți deosebite în a decide cum să interpreteze o imagine de referință.

Lucrarea afirmă:

„Experimente ample efectuate pe benchmark-ul nostru demonstrează că CompleteMe depășește metodele de ultimă generație, atât cele bazate pe referințe, cât și cele nebazate pe referințe, în ceea ce privește indicatorii cantitativi, rezultatele calitative și studiile utilizatorilor.”

„În special în scenarii dificile care implică poziții complexe, modele vestimentare complicate și accesorii distinctive, modelul nostru atinge în mod constant o fidelitate vizuală superioară și o coerență semantică.”

Din păcate, proiectul Prezența pe GitHub nu conține niciun cod și nici nu promite nimic, iar inițiativa, care are și un scop modest Pagina proiectului, pare încadrată ca o arhitectură proprietară.

Un alt exemplu al performanței subiective a noului sistem în comparație cu metodele anterioare. Mai multe detalii mai târziu în articol.

Metodă

Cadrul CompleteMe se bazează pe o rețea U de referință, care gestionează integrarea materialelor auxiliare în proces, și o rețea U coezivă, care găzduiește o gamă mai largă de procese pentru obținerea rezultatului final, așa cum este ilustrat în schema conceptuală de mai jos:

Schema conceptuală pentru CompleteMe. Sursa: https://arxiv.org/pdf/2504.20042

Sistemul codifică mai întâi imaginea de intrare mascată într-o reprezentare latentă. În același timp, Reference U-Net procesează mai multe imagini de referință – fiecare arătând regiuni diferite ale corpului – pentru a extrage informații spațiale detaliate. caracteristici.

Aceste caracteristici trec printr-un bloc de atenție axat pe regiune, încorporat în U-Net „completă”, unde sunt mascat selectiv utilizând măști regionale corespunzătoare, asigurându-se că modelul se ocupă doar de zonele relevante din imaginile de referință.

Caracteristicile mascate sunt apoi integrate cu cele globale CLIPtrăsături semantice derivate prin decuplare atenție încrucișată, permițând modelului să reconstruiască conținutul lipsă atât cu detalii fine, cât și cu coerență semantică.

Pentru a spori realismul și robustețea, procesul de mascare a intrării combină ocluzii aleatorii bazate pe grilă cu măști ale formei corpului uman, fiecare aplicată cu probabilitate egală, crescând complexitatea regiunilor lipsă pe care modelul trebuie să le completeze.

Doar ca referinta

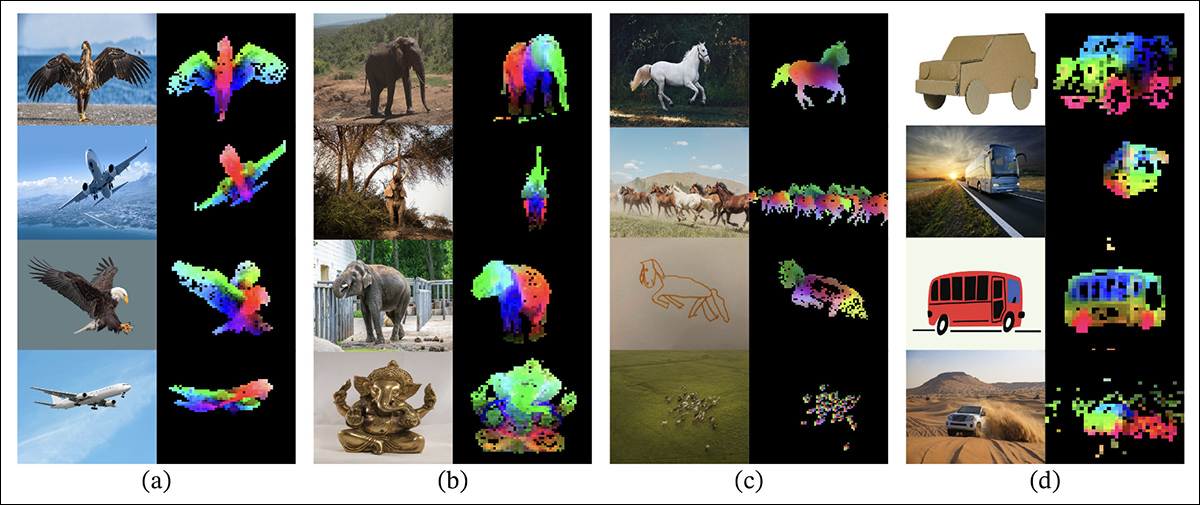

Metodele anterioare pentru pictarea imaginilor bazate pe referințe se bazau de obicei pe nivel semantic codificatoare. Proiectele de acest tip includ CLIP în sine și DINOv2, ambele extrag caracteristici globale din imaginile de referință, dar adesea pierd detaliile spațiale fine necesare pentru conservarea precisă a identității.

Din documentul de lansare pentru abordarea DINOV2 mai veche, care este inclusă în testele comparative din noul studiu: Suprapunerile colorate prezintă primele trei componente principale din Analiza Componentelor Principale (PCA), aplicate pe porțiuni de imagine din fiecare coloană, evidențiind modul în care DINOv2 grupează părți similare ale obiectelor în imagini variate. În ciuda diferențelor de poză, stil sau randare, regiunile corespondente (cum ar fi aripile, membrele sau roțile) sunt potrivite în mod constant, ilustrând capacitatea modelului de a învăța structura bazată pe părți fără supraveghere. Sursa: https://arxiv.org/pdf/2304.07193

CompleteMe abordează acest aspect printr-o rețea U de referință specializată, inițializată din Difuziune stabilă 1.5, dar funcționând fără treaptă de zgomot de difuzie*.

Fiecare imagine de referință, care acoperă diferite regiuni ale corpului, este codificată în caracteristici latente detaliate prin intermediul acestei rețele U. Caracteristicile semantice globale sunt, de asemenea, extrase separat folosind CLIP, iar ambele seturi de caracteristici sunt stocate în cache pentru o utilizare eficientă în timpul integrării bazate pe atenție. Astfel, sistemul poate gestiona flexibil mai multe intrări de referință, păstrând în același timp informațiile detaliate despre aspect.

Orchestrarea

Rețeaua U-Net coezivă gestionează etapele finale ale procesului de finalizare. Adaptat după variantă de repictare În Stable Diffusion 1.5, acesta preia ca intrare imaginea sursă mascată în formă latentă, alături de caracteristici spațiale detaliate extrase din imaginile de referință și caracteristici semantice globale extrase de codificatorul CLIP.

Aceste diverse intrări sunt reunite prin blocul RFA, care joacă un rol esențial în direcționarea concentrării modelului către cele mai relevante zone ale materialului de referință.

Înainte de a intra în mecanismul de atenție, caracteristicile de referință sunt mascate explicit pentru a elimina regiunile neînrudite și apoi concatenate cu reprezentarea latentă a imaginii sursă, asigurându-se că atenția este direcționată cât mai precis posibil.

Pentru a îmbunătăți această integrare, CompleteMe încorporează un mecanism de atenție încrucișată decuplat, adaptat din Adaptor IP cadru:

Adaptorul IP, din care o parte este încorporat în CompleteMe, este unul dintre cele mai de succes și adesea utilizate proiecte din ultimii trei ani tumultoși de dezvoltare a arhitecturilor modelelor de difuzie latentă. Sursă: https://ip-adapter.github.io/

Acest lucru permite modelului să proceseze caracteristici vizuale detaliate spațial și contextul semantic mai larg prin fluxuri de atenție separate, care sunt ulterior combinate, rezultând o reconstrucție coerentă care, susțin autorii, păstrează atât identitatea, cât și detaliile fine.

Benchmarking

În absența unui set de date adecvat pentru completarea umană bazată pe referințe, cercetătorii și-au propus propriul set de date. Benchmark-ul (fără nume) a fost construit prin selectarea unor perechi de imagini selectate din setul de date WPose conceput pentru Adobe Research din 2023. UniHuman proiect.

Exemple de poziții din proiectul Adobe Research 2023 UniHuman. Sursă: https://github.com/adobe-research/UniHuman?tab=readme-ov-file#data-prep

Cercetătorii au desenat manual măști sursă pentru a indica zonele de repictare, obținând în cele din urmă 417 grupuri de imagini tripartite care constituie o imagine sursă, o mască și o imagine de referință.

Două exemple de grupuri derivate inițial din setul de date de referință WPose și selectate pe larg de cercetătorii noii lucrări.

Autorii au folosit LLaVA Model de limbaj mare (LLM) pentru a genera solicitări textuale care descriu imaginile sursă.

Metricile utilizate au fost mai extinse decât de obicei; pe lângă cele obișnuite Raportul semnal-zgomot de vârf (PSNR), Indicele de similaritate structurală (SSIM) și Asemănarea imaginilor perceptive învățate (LPIPS, în acest caz pentru evaluarea regiunilor mascate), cercetătorii au folosit DINO pentru scorurile de similaritate; DreamSim pentru evaluarea rezultatelor generării; și CLIP.

Date și teste

Pentru a testa lucrarea, autorii au utilizat atât modelul implicit Stable Diffusion V1.5, cât și modelul de repictare 1.5. Codificatorul de imagini al sistemului a folosit CLIP Viziune model, împreună cu straturi de proiecție – rețele neuronale modeste care remodelează sau aliniază ieșirile CLIP pentru a se potrivi cu dimensiunile caracteristicilor interne utilizate de model.

Instruirea a avut loc pentru 30,000 de iterații pe opt plăci video NVIDIA A100.† GPU-uri, supravegheate de Eroare medie pătrată pierdere (MSE), la o dimensiunea lotului din 64 și a rata de învățare de 2 × 10-5Diverse elemente au fost plasate aleatoriu pe parcursul antrenamentului, pentru a preveni ca sistemul supraîncadrarea asupra datelor.

Setul de date a fost modificat de la Părți către întreg set de date, el însuși bazat pe DeepFashion-MultiModal set de date.

Exemple din setul de date Parts to Whole, utilizate în dezvoltarea datelor selectate pentru CompleteMe. Sursă: https://huanngzh.github.io/Parts2Whole/

Autorii afirmă:

„Pentru a îndeplini cerințele noastre, am [reconstruit] perechile de antrenament utilizând imagini ocluze cu mai multe imagini de referință care surprind diverse aspecte ale aspectului uman, împreună cu etichetele lor textuale scurte.”

„Fiecare eșantion din datele noastre de antrenament include șase tipuri de aspect: haine pentru partea superioară a corpului, haine pentru partea inferioară a corpului, haine pentru întregul corp, păr sau accesorii pentru cap, față și încălțăminte. Pentru strategia de mascare, aplicăm o mascare aleatorie de 50% cu grilă între 1 și 30 de ori, în timp ce pentru celelalte 50% folosim o mască a formei corpului uman pentru a crește complexitatea mascării.”

„După finalizarea lucrărilor de construcție, am obținut 40,000 de perechi de imagini pentru antrenament.”

Prior rival fără referință metodele testate au fost Completarea imaginii umane ocluzate de mari dimensiuni (LOHC) și modelul de pictare a imaginilor plug-and-play BrushNetModelele bazate pe referințe testate au fost Pictură după exemplu; AnyDoor; Reumplere stângăŞi MimicBrush.

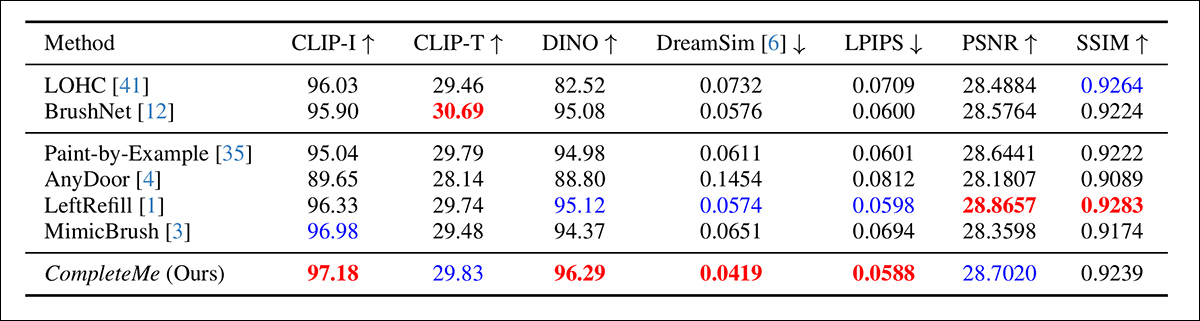

Autorii au început cu o comparație cantitativă a indicatorilor menționați anterior:

Rezultate pentru comparația cantitativă inițială.

În ceea ce privește evaluarea cantitativă, autorii observă că CompleteMe obține cele mai mari scoruri la majoritatea metricilor perceptive, inclusiv CLIP-I, DINO, DreamSim și LPIPS, care sunt destinate să surprindă alinierea semantică și fidelitatea aspectului dintre rezultat și imaginea de referință.

Cu toate acestea, modelul nu depășește toate valorile de referință în general. În special, BrushNet obține cele mai mari scoruri la CLIP-T, LeftRefill în SSIM și PSNR, iar MimicBrush depășește ușor performanța la CLIP-I.

Deși CompleteMe prezintă rezultate constant puternice per ansamblu, diferențele de performanță sunt modeste în unele cazuri, iar anumite valori rămân determinate de metode anterioare concurente. Poate nu pe nedrept, autorii prezintă aceste rezultate ca o dovadă a forței echilibrate a CompleteMe atât pe plan structural, cât și pe cel perceptiv.

Ilustrațiile pentru testele calitative efectuate în cadrul studiului sunt mult prea numeroase pentru a fi reproduse aici și îl îndemnăm pe cititor nu doar la lucrarea sursă, ci și la ampla documentație. PDF suplimentar, care conține multe exemple calitative suplimentare.

Evidențiem principalele exemple calitative prezentate în lucrarea principală, împreună cu o selecție de cazuri suplimentare extrase din setul suplimentar de imagini introduse anterior în acest articol:

Rezultatele calitative inițiale sunt prezentate în lucrarea principală. Vă rugăm să consultați lucrarea sursă pentru o rezoluție mai bună.

Din rezultatele calitative prezentate mai sus, autorii comentează:

„Având date cu intrări mascate, aceste metode non-referințiale generează conținut plauzibil pentru regiunile mascate folosind a priori de imagini sau solicitări text.”

„Totuși, așa cum se indică în caseta roșie, acestea nu pot reproduce detalii specifice, cum ar fi tatuaje sau modele vestimentare unice, deoarece le lipsesc imagini de referință care să ghideze reconstrucția unor informații identice.”

O a doua comparație, din care o parte este prezentată mai jos, se concentrează pe cele patru metode bazate pe referințe: Paint-by-Example, AnyDoor, LeftRefill și MimicBrush. Aici au fost furnizate doar o imagine de referință și un text prompt.

Comparație calitativă cu metode bazate pe referințe. CompleteMe produce completări mai realiste și păstrează mai bine detaliile specifice din imaginea de referință. Casetele roșii evidențiază zonele de interes deosebit.

Autorii afirmă:

„Având în vedere o imagine umană mascată și o imagine de referință, alte metode pot genera conținut plauzibil, dar adesea eșuează să păstreze cu exactitate informațiile contextuale din referință.”

„În unele cazuri, acestea generează conținut irelevant sau mapează incorect părțile corespondente din imaginea de referință. În schimb, CompleteMe completează eficient regiunea mascată prin păstrarea cu exactitate a informațiilor identice și cartografierea corectă a părților corespondente ale corpului uman din imaginea de referință.”

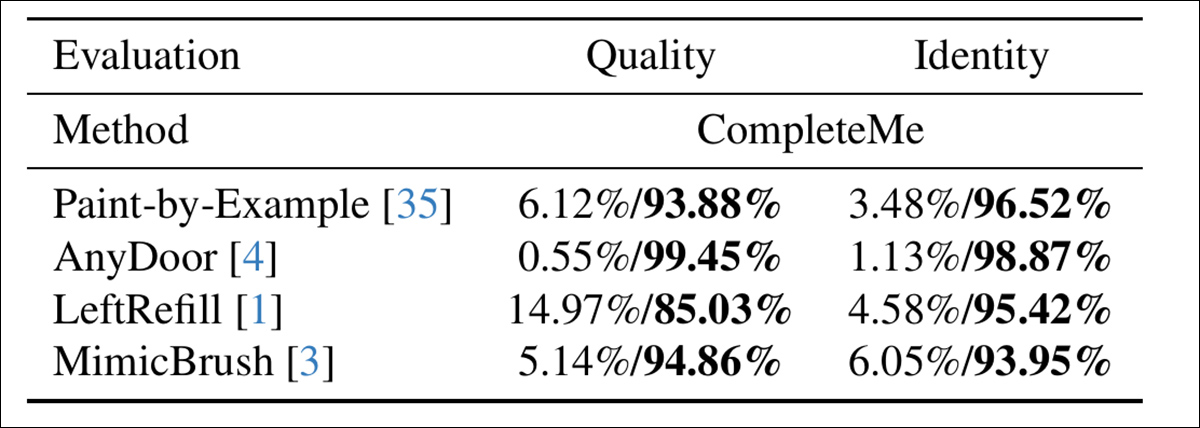

Pentru a evalua cât de bine se aliniază modelele cu percepția umană, autorii au realizat un studiu cu utilizatori care a implicat 15 adnotatori și 2,895 de perechi de eșantioane. Fiecare pereche a comparat rezultatul CompleteMe cu una dintre cele patru linii de referință bazate pe referințe: Paint-by-Example, AnyDoor, LeftRefill sau MimicBrush.

Adnotatorii au evaluat fiecare rezultat pe baza calității vizuale a regiunii completate și a măsurii în care aceasta a păstrat caracteristicile identității față de referință – iar aici, evaluând calitatea și identitatea generală, CompleteMe a obținut un rezultat mai definitiv:

Rezultatele studiului utilizatorului.

Concluzie

Dacă e să spunem ceva, rezultatele calitative ale acestui studiu sunt subminate de volumul lor mare, deoarece o examinare atentă indică faptul că noul sistem este o intrare foarte eficientă în această zonă relativ de nișă, dar intens urmărită, a editării imaginilor neuronale.

Totuși, este nevoie de puțină atenție suplimentară și de o mărire a PDF-ului original pentru a aprecia cât de bine adaptează sistemul materialul de referință la zona ocluzionată în comparație (în aproape toate cazurile) cu metodele anterioare.

Recomandăm insistent cititorului să examineze cu atenție avalanșa de rezultate inițial confuze, dacă nu chiar copleșitoare, prezentată în materialul suplimentar.

* Este interesant de observat cum versiunea V1.5, acum extrem de depășită, rămâne favorita cercetătorilor – parțial datorită testării similare tradiționale, dar și pentru că este cea mai puțin cenzurată și probabil cea mai ușor de antrenat dintre toate iterațiile Stable Diffusion și nu împărtășește... șchiopătare cenzurătoare a lansărilor FOSS Flux.

† Specificațiile VRAM nu au fost furnizate - ar fi fie 40 GB, fie 80 GB per placă.

Publicat prima dată marți, 29 aprilie 2025