Inteligenta Artificiala

AnimateLCM: Accelerarea animației modelelor de difuzie personalizate

În ultimii câțiva ani, modelele de difuzie au obținut un succes masiv și o recunoaștere pentru sarcinile de generare de imagini și videoclipuri. Modelele de difuzie video, în special, au câștigat o atenție semnificativă datorită capacității lor de a produce videoclipuri cu o coerență ridicată și fidelitate. Aceste modele generează videoclipuri de înaltă calitate prin utilizarea unui proces iterativ de eliminare a zgomotului în arhitectura lor care transformă treptat zgomotul gaussian de înaltă dimensiune în date reale.

Stable Diffusion este unul dintre cele mai reprezentative modele pentru sarcinile de generare a imaginii, bazându-se pe un AutoEncoder variațional (VAE) pentru a mapa între imaginea reală și caracteristicile latente eșantionate în jos. Acest lucru permite modelului să reducă costurile generative, în timp ce mecanismul de atenție încrucișată din arhitectura sa facilitează generarea de imagini condiționate de text. Mai recent, cadrul Stable Diffusion a construit fundația pentru mai multe adaptoare plug-and-play pentru a obține o generare de imagini sau video mai inovatoare și mai eficiente. Cu toate acestea, procesul generativ iterativ folosit de majoritatea modelelor de difuzie video face ca procesul de generare a imaginii să consume mult timp și să fie relativ costisitor, limitându-i aplicațiile.

În acest articol, vom vorbi despre AnimateLCM, un model de difuzie personalizat cu adaptoare care vizează generarea de videoclipuri de înaltă fidelitate cu pași și costuri de calcul minime. Cadrul AnimateLCM este inspirat de Modelul de consecvență, care accelerează eșantionarea cu pași minimi prin distilarea modelelor de difuzie a imaginii pre-antrenate. În plus, extinderea cu succes a Modelului de consistență, Modelul de consistență latentă (LCM), facilitează generarea condiționată a imaginilor. În loc să desfășoare învățarea de consistență direct pe setul de date video brute, cadrul AnimateLCM propune utilizarea unei strategii de învățare de consecvență decuplată. Această strategie decuplă distilarea priorităților de generare a mișcării și a priorităților de generare a imaginii, permițând modelului să îmbunătățească calitatea vizuală a conținutului generat și să îmbunătățească eficiența antrenamentului simultan. În plus, modelul AnimateLCM propune antrenarea adaptoarelor de la zero sau adaptarea adaptoarelor existente la modelul său de consistență video distilat. Acest lucru facilitează combinarea adaptoarelor plug-and-play din familia modelelor de difuzie stabilă pentru a realiza diferite funcții fără a afecta viteza eșantionului.

Acest articol își propune să acopere cadrul AnimateLCM în profunzime. Explorăm mecanismul, metodologia și arhitectura cadrului, împreună cu compararea acestuia cu cadrele de generare de imagini și video de ultimă generație. Asadar, haideti sa începem.

AnimateLCM: Animație de modele de difuzie personalizate

Modelele de difuzie au reprezentat un cadru pentru generarea de imagini și sarcinile de generare video datorită eficienței și capacităților lor în sarcinile generative. Majoritatea modelelor de difuzie se bazează pe un proces iterativ de eliminare a zgomotului pentru generarea de imagini care transformă treptat un zgomot gaussian cu dimensiuni mari în date reale. Deși metoda oferă rezultate oarecum satisfăcătoare, procesul iterativ și numărul de eșantioane iterative încetinește procesul de generare și, de asemenea, adaugă la cerințele de calcul ale modelelor de difuzie care sunt mult mai lente decât alte cadre generative precum GAN sau Retele adversare generative. În ultimii câțiva ani, modelele de consistență sau CM-urile au fost propuse ca o alternativă la modelele de difuzie iterativă pentru a accelera procesul de generare, menținând constant cerințele de calcul.

Punctul culminant al modelelor de consistență este că învață mapări de consistență care mențin auto-consecvența traiectoriilor introduse de modelele de difuzie pre-antrenate. Procesul de învățare al modelelor de consistență îi permite să genereze imagini de înaltă calitate cu pași minimi și, de asemenea, elimină nevoia de iterații intensive de calcul. În plus, modelul de consistență latentă sau LCM construit pe deasupra cadru de difuzie stabil poate fi integrat în interfața de utilizator web cu adaptoarele existente pentru a obține o serie de funcționalități suplimentare, cum ar fi traducerea în timp real a imaginii în imagine. În comparație, deși modelele existente de difuzie video oferă rezultate acceptabile, progrese sunt încă de făcut în domeniul accelerației eșantionului video și sunt de mare importanță datorită costurilor de calcul ridicate pentru generarea video.

Asta ne duce la AnimateLCM, un cadru de generare video de înaltă fidelitate care necesită un număr minim de pași pentru sarcinile de generare video. Urmând modelul de consistență latentă, cadrul AnimateLCM tratează procesul de difuzie inversă ca rezolvare a fluxului de probabilitate augmentat CFG sau Classifier Free Guidance și antrenează modelul pentru a prezice soluția unor astfel de fluxuri de probabilitate direct în spațiul latent. Cu toate acestea, în loc să desfășoare învățarea consecvenței pe date video brute în mod direct, care necesită o pregătire ridicată și resurse de calcul și care duce adesea la o calitate slabă, cadrul AnimateLCM propune o strategie de învățare consistentă decuplată care decuplă distilarea consecvenței generarii de mișcare și generarea de imagini anterior.

Cadrul AnimateLCM efectuează mai întâi distilarea consistenței pentru a adapta modelul de difuzie a bazei imaginii în modelul de consistență a imaginii, apoi efectuează inflația 3D atât la modelele de consistență a imaginii, cât și la modelele de difuzare a imaginii pentru a se adapta caracteristicilor 3D. În cele din urmă, cadrul AnimateLCM obține modelul de consistență video prin distilare de consistență pe datele video. În plus, pentru a atenua potențiala corupție a caracteristicilor ca urmare a procesului de difuzie, cadrul AnimateLCM propune și utilizarea unei strategii de inițializare. Deoarece cadrul AnimateLCM este construit peste cadrul Stable Diffusion, acesta poate înlocui ponderile spațiale ale modelului său de consistență video antrenat cu greutățile de difuzie a imaginii personalizate disponibile public pentru a obține rezultate inovatoare de generare.

În plus, pentru a antrena adaptoare specifice de la zero sau pentru a se potrivi mai bine cu adaptoarele disponibile public, cadrul AnimateLCM propune o strategie eficientă de accelerare pentru adaptoarele care nu necesită pregătirea modelelor specifice de profesor.

Contribuțiile cadrului AnimateLCM pot fi foarte bine rezumate astfel: Cadrul AnimateLCM propus își propune să obțină o generare video de înaltă calitate, rapidă și de înaltă fidelitate, iar pentru a realiza acest lucru, cadrul AnimateLCM propune o strategie de distilare decuplată care decuplează mișcarea și imaginea. antecedente de generație, rezultând o calitate mai bună a generației și o eficiență sporită a antrenamentului.

InstantID : Metodologie și Arhitectură

În esență, cadrul InstantID se inspiră puternic din modelele de difuzie și din strategiile de viteză de eșantionare. Modelele de difuzie, cunoscute și ca modele generative bazate pe scoruri, au demonstrat capacități remarcabile de generare a imaginii. Sub îndrumarea direcției scorului, strategia de eșantionare iterativă implementată de modelele de difuzie dezgomotează treptat datele corupte de zgomot. Eficiența modelelor de difuzie este unul dintre motivele majore pentru care acestea sunt folosite de majoritatea modele de difuzie video prin antrenament pe straturi temporale adăugate. Pe de altă parte, viteza de eșantionare și strategiile de accelerare a eșantionării ajută la abordarea vitezelor lente de generare în modelele de difuzie. Metoda de accelerare bazată pe distilare reglează greutățile de difuzie originale cu o arhitectură rafinată sau un planificator pentru a îmbunătăți viteza de generare.

Continuând, cadrul InstantID este construit pe baza modelului de difuzie stabilă care permite InstantID să aplice noțiuni relevante. Modelul tratează procesul de difuzie directă discretă ca SDE de conservare a variației în timp continuu. În plus, modelul de difuzie stabilă este o extensie a DDPM sau a modelului probabilistic de difuzie de deznodare, în care punctul de date de antrenament este perturbat treptat de lanțul Markov discret cu un cadru de perturbare care permite distribuirea datelor zgomotoase la diferite etape de timp pentru a urmări distribuția.

Pentru a obține o generare video de înaltă fidelitate cu un număr minim de pași, cadrul AnimateLCM îmblânzește modelele video stabile bazate pe difuzie pentru a urma proprietatea de auto-consistență. Structura generală de formare a cadrului AnimateLCM constă într-o strategie de învățare consecventă decuplată pentru adaptarea liberă a profesorilor și învățarea eficientă consecventă.

Tranziția de la modele de difuzie la modele de consistență

Cadrul AnimateLCM introduce propria sa adaptare a modelului de difuzie stabilă sau DM la modelul de consistență sau CM în urma proiectării modelului de consistență latentă sau LCM. Este de remarcat faptul că, deși modelele de difuzie stabilă prezic de obicei zgomotul adăugat la eșantioane, ele sunt modele esențiale de difuzie sigma. Este în contrast cu modelele de consistență care urmăresc să prezică direct soluția la traiectoria PF-ODE. În plus, în modelele de difuzie stabilă cu anumiți parametri, este esențial ca modelul să folosească o strategie de ghidare fără clasificator pentru a genera imagini de înaltă calitate. Cu toate acestea, cadrul AnimateLCM folosește un rezolutor ODE augmentat de ghidare fără clasificare pentru a eșantiona perechile adiacente în aceleași traiectorii, rezultând o eficiență mai bună și o calitate îmbunătățită. Mai mult, modelele existente au indicat că calitatea generării și eficiența antrenamentului sunt puternic influențate de numărul de puncte discrete din traiectorie. Un număr mai mic de puncte discrete accelerează procesul de antrenament, în timp ce un număr mai mare de puncte discrete are ca rezultat mai puțină părtinire în timpul antrenamentului.

Învățare de consecvență decuplată

Pentru procesul de distilare a consistenței, dezvoltatorii au observat că datele utilizate pentru antrenament influențează puternic calitatea generației finale a modelelor de consistență. Cu toate acestea, problema majoră cu seturile de date disponibile public în prezent este aceea că constau adesea în date de filigran sau de calitate scăzută și ar putea conține subtitrări prea scurte sau ambigue. Mai mult, antrenarea modelului direct pe videoclipuri de rezoluție mare este costisitoare din punct de vedere computațional și consumatoare de timp, ceea ce îl face o opțiune nefezabilă pentru majoritatea cercetătorilor.

Având în vedere disponibilitatea seturilor de date filtrate de înaltă calitate, cadrul AnimateLCM propune să decupleze distilarea priorităților de mișcare și priorităților de generare a imaginii. Pentru a fi mai specific, cadrul AnimateLCM distilează mai întâi modelele de difuzie stabilă în modele de consistență a imaginii cu seturi de date de text de imagine filtrate de înaltă calitate, cu o rezoluție mai bună. Cadrul antrenează apoi greutățile ușoare LoRA la straturile modelului de difuzie stabilă, înghețând astfel greutățile stabilului. model de difuzie. Odată ce modelul reglează greutățile LoRA, funcționează ca un modul de accelerare versatil și și-a demonstrat compatibilitatea cu alte modele personalizate în comunitățile de difuzie stabilă. Pentru inferență, cadrul AnimateLCM îmbină ponderile LoRA cu ponderile inițiale fără a deteriora viteza de inferență. După ce cadrul AnimateLCM câștigă modelul de consistență la nivelul generării imaginii, îngheață ponderile modelului de difuzie stabilă și ponderile LoRA pe acesta. În plus, modelul umflă nucleele de convoluție 2D la nucleele pseudo-3D pentru a antrena modelele de consistență pentru generarea video. Modelul adaugă, de asemenea, straturi temporale cu inițializare zero și o conexiune reziduală la nivel de bloc. Configurația generală ajută la asigurarea că rezultatul modelului nu va fi influențat atunci când este antrenat pentru prima dată. Cadrul AnimateLCM sub îndrumarea modelelor de difuzie video cu sursă deschisă antrenează straturile temporale extinse din modelele de difuzie stabilă.

Este important să recunoaștem că, în timp ce ponderile LoRA spațiale sunt concepute pentru a accelera procesul de eșantionare fără a lua în considerare modelarea temporală, iar modulele temporale sunt dezvoltate prin tehnici standard de difuzie, integrarea lor directă tinde să corupă reprezentarea la începutul antrenamentului. Acest lucru prezintă provocări semnificative în combinarea eficientă și eficientă a acestora cu un conflict minim. Prin cercetări empirice, cadrul AnimateLCM a identificat o abordare de inițializare de succes care nu numai că utilizează prioritățile de consistență din ponderile LoRA spațiale, dar și atenuează efectele adverse ale combinației lor directe.

La începutul antrenamentului de consistență, ponderile LoRA spațiale pre-antrenate sunt integrate exclusiv în modelul de consistență online, scutând modelul de consistență țintă de la inserare. Această strategie asigură că modelul țintă, servind drept ghid educațional pentru modelul online, nu generează predicții greșite care ar putea afecta în detriment procesul de învățare al modelului online. Pe parcursul perioadei de antrenament, greutățile LoRA sunt încorporate progresiv în modelul de consistență țintă printr-un proces de medie mobilă exponențială (EMA), realizând echilibrul optim de greutate după mai multe iterații.

Adaptarea liberă a profesorului

Modelele Stable Diffusion și adaptoarele plug and play merg adesea mână în mână. Cu toate acestea, s-a observat că, deși adaptoarele plug and play funcționează într-o oarecare măsură, acestea tind să-și piardă controlul în detalii chiar și atunci când majoritatea acestor adaptoare sunt antrenate cu modele de difuzie a imaginii. Pentru a contracara această problemă, cadrul AnimateLCM optează pentru adaptarea gratuită a profesorilor, o strategie simplă, dar eficientă, care fie găzduiește adaptoarele existente pentru o mai bună compatibilitate, fie antrenează adaptoarele de la zero sau. Abordarea permite cadrului AnimateLCM să realizeze generarea video controlabilă și generarea imagine-la-video cu un număr minim de pași fără a necesita modele de profesor.

AnimateLCM: Experimente și rezultate

Cadrul AnimateLCM folosește un Stable Diffusion v1-5 ca model de bază și implementează soluția DDIM ODE în scopuri de instruire. Cadrul aplică, de asemenea, Stable Diffusion v1-5 cu greutăți de mișcare cu sursă deschisă ca model de difuzare video pentru profesor, experimentele fiind efectuate pe setul de date WebVid2M fără date suplimentare sau augmentate. În plus, cadrul folosește setul de date TikTok cu mesaje textuale scurte subtitrate BLIP pentru generarea video controlabilă.

Rezultatele calitative

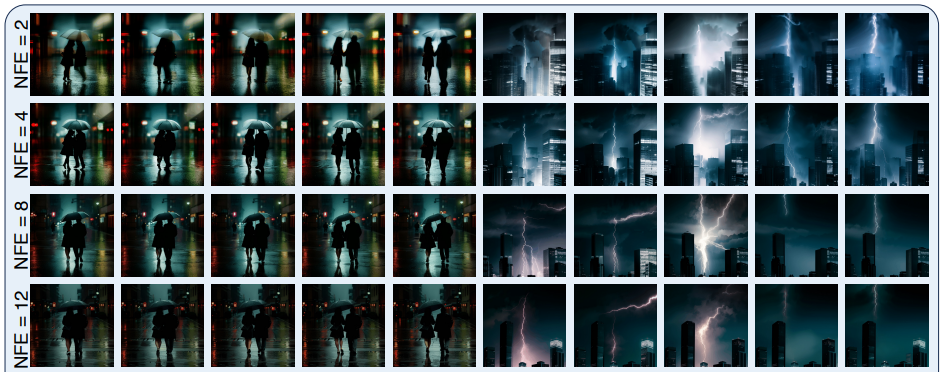

Următoarea figură demonstrează rezultatele metodei de generare în patru pași implementate de cadrul AnimateLCM în generarea text-to-video, generarea imagine-video și generarea video controlabilă.

După cum se poate observa, rezultatele furnizate de fiecare dintre ele sunt satisfăcătoare, rezultatele generate demonstrând capacitatea cadrului AnimateLCM de a urmări proprietatea de consistență chiar și cu pași variați de inferență, menținând mișcare și stil similar.

Rezultate cantitative

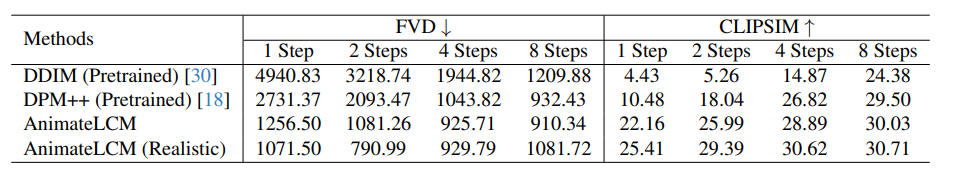

Următoarea figură ilustrează rezultatele cantitative și compararea cadrului AnimateLCM cu metodele de ultimă generație DDIM și DPM++.

După cum se poate observa, cadrul AnimateLCM depășește metodele existente cu o marjă semnificativă, mai ales în regimul de trepte joase, de la 1 la 4 pași. În plus, valorile AnimateLCM afișate în această comparație sunt evaluate fără a utiliza ghidarea fără CFG sau clasificator, care permite cadrului să economisească aproape 50% din timpul de inferență și din costul memoriei de vârf de inferență. În plus, pentru a-și valida și mai mult performanța, ponderile spațiale din cadrul AnimateLCM sunt înlocuite cu un model realist personalizat disponibil public, care atinge un echilibru bun între fidelitate și diversitate, care ajută la creșterea performanței în continuare.

Gânduri finale

În acest articol, am vorbit despre AnimateLCM, un model de difuzie personalizat cu adaptoare care își propune să genereze videoclipuri de înaltă fidelitate cu pași și costuri de calcul minime. Cadrul AnimateLCM este inspirat de Modelul de consistență care accelerează eșantionarea cu pași minimi prin distilarea modelelor de difuzie a imaginii pre-antrenate și extinderea cu succes a Modelului de consistență, Modelul de consistență latentă sau LCM care facilitează generarea condiționată a imaginilor. În loc să desfășoare învățarea consecvenței direct pe setul de date video brute, cadrul AnimateLCM propune utilizarea unei strategii de învățare de consecvență decuplată care decuplează distilarea anterioarelor de generare a mișcării și a priorităților de generare a imaginii, permițând modelului să îmbunătățească calitatea vizuală a conținutului generat și îmbunătățirea eficienței antrenamentului simultan.