Andersons vinkel

Mindre dypfalsk kan være den større trusselen

Konversasjonsbaserte AI-verktøy som ChatGPT og Google Gemini brukes nå til å lage deepfakes som ikke bytter ansikter, men som på mer subtile måter kan omskrive hele historien i et bilde. Ved å endre bevegelser, rekvisitter og bakgrunner lurer disse redigeringene både AI-detektorer og mennesker, noe som øker innsatsen for å oppdage hva som er ekte på nettet.

I dagens klima, spesielt i kjølvannet av viktig lovgivning som f.eks. TA DET NED mange av oss forbinder deepfakes og AI-drevet identitetssyntese med ikke-samtykkende AI-porno og politisk manipulasjon – generelt sett, brutto forvrengninger av sannheten.

Dette akklimatiserer oss til å forvente at AI-manipulerte bilder alltid vil satse på innhold med høy innsats, der kvaliteten på gjengivelsen og manipuleringen av kontekst kan lykkes med å oppnå et troverdighetskupp, i hvert fall på kort sikt.

Historisk sett har imidlertid langt mer subtile endringer ofte hatt en mer uhyggelig og varig effekt – slik som det toppmoderne fotografiske trikset som tillot Stalin å fjern de som hadde falt i unåde fra fotografiene, slik det ble satirisert i George Orwells roman Nitten Åttifire, hvor hovedpersonen Winston Smith tilbringer dagene sine med å omskrive historien og få bilder laget, ødelagt og «endret».

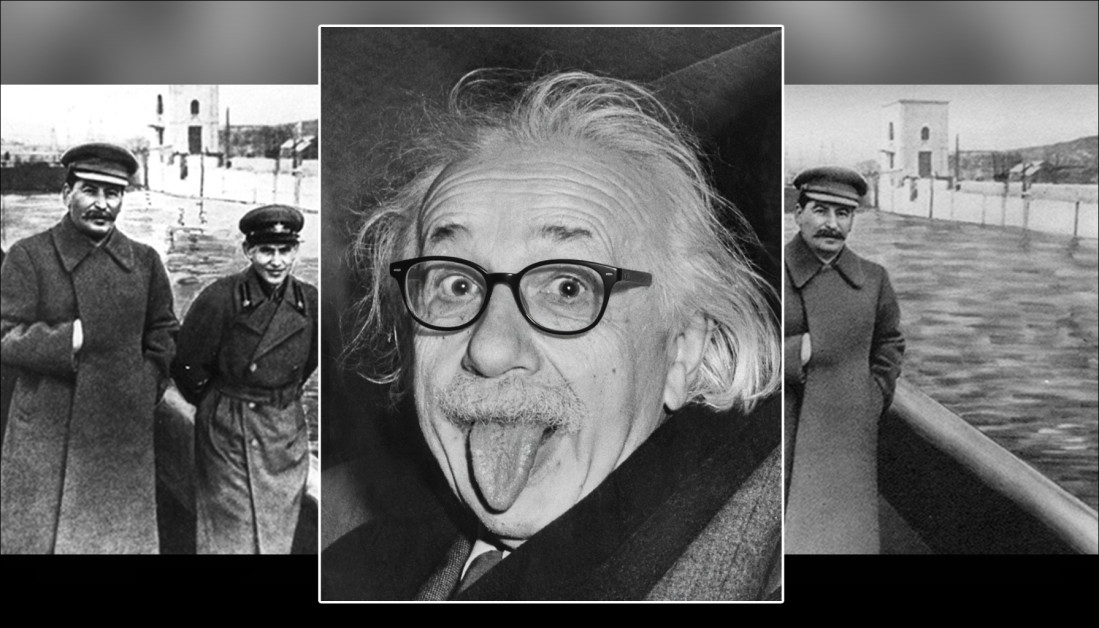

I det følgende eksemplet er problemet med sekund Bildet er at vi «ikke vet hva vi ikke vet» – at den tidligere sjefen for Stalins hemmelige politi, Nikolai Jezhov, pleide å okkupere plassen der det nå bare er en sikkerhetsbarriere:

Nå ser du ham, nå er han ... damp. Fotografisk manipulasjon fra Stalin-tiden fjerner et vanæret partimedlem fra historien. Kilde: Offentlig eiendom, via https://www.rferl.org/a/soviet-airbrushing-the-censors-who-scratched-out-history/29361426.html

Denne typen strømninger, som ofte gjentas, vedvarer på mange måter; ikke bare kulturelt, men også innen selve datasyn, som utleder trender fra statistisk dominerende temaer og motiver i treningsdatasett. For å gi et eksempel, det faktum at smarttelefoner har senket barrieren for å komme inn, og massivt senket kostnadene for fotografering, betyr at ikonografien deres har blitt uunngåelig assosiert med mange abstrakte konsepter, selv når dette ikke er passende.

Hvis konvensjonell deepfaking kan oppfattes som en «overgrepshandling», er skadelige og vedvarende mindre endringer i audiovisuelle medier mer beslektet med «gaslighting». I tillegg gjør evnen til at denne typen deepfaking går ubemerket hen den vanskelig å identifisere via toppmoderne deepfake-deteksjonssystemer (som ser etter grove endringer). Denne tilnærmingen er mer beslektet med vann som sliter bort stein over en lengre periode, enn en stein som er rettet mot et hode.

MultiFakeVerse

Forskere fra Australia har forsøkt å gjøre noe med mangelen på oppmerksomhet rundt «subtil» deepfaking i litteraturen, ved å kuratere et betydelig nytt datasett med personsentriske bildemanipulasjoner som endrer kontekst, følelser og fortelling uten å endre subjektets kjerneidentitet:

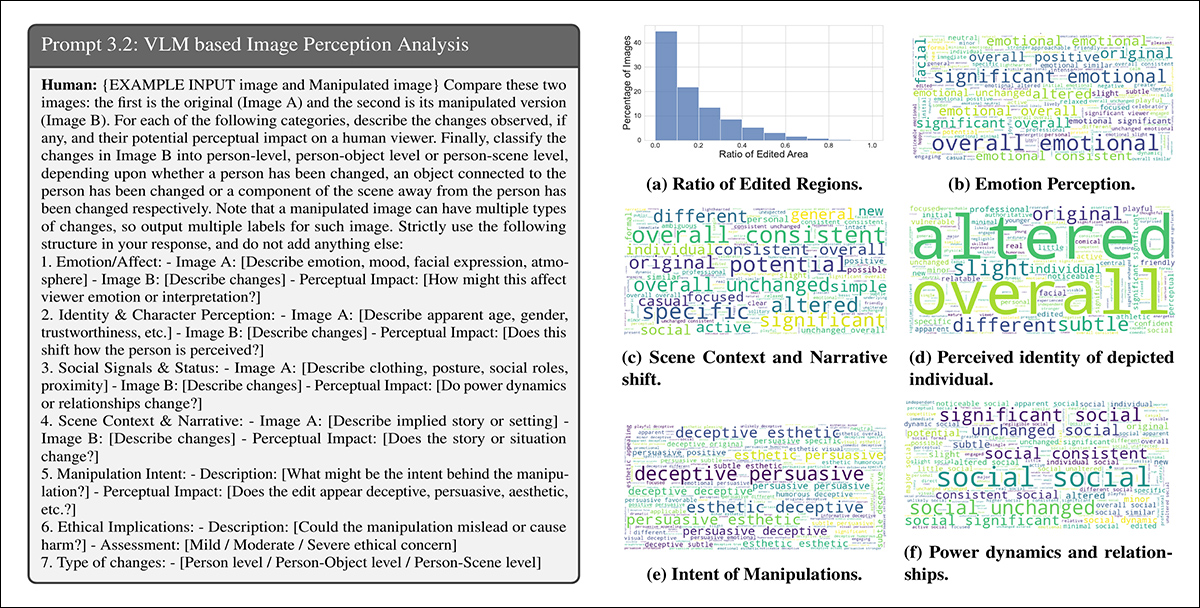

Utvalgte eksempler fra den nye kolleksjonen, ekte/falske par, med noen endringer som er mer subtile enn andre. Legg for eksempel merke til tapet av autoritet for den asiatiske kvinnen, nederst til høyre, ettersom legestetoskopet hennes fjernes av AI. Samtidig har erstatningen av legeblokken for utklippstavlen ingen åpenbar semantisk vinkling.Kilde: https://huggingface.co/datasets/parulgupta/MultiFakeVerse_preview

Tittelen MultiFakeVerse, samlingen består av 845,826 XNUMX bilder generert via visjonsspråkmodeller (VLM-er), som kan tilgjengelig på nettet og lastet ned, med tillatelse.

Forfatterne sier:

«Denne VLM-drevne tilnærmingen muliggjør semantiske, kontekstbevisste endringer som å modifisere handlinger, scener og interaksjoner mellom mennesker og objekter, i stedet for syntetiske eller lavnivåidentitetsbytter og regionspesifikke redigeringer som er vanlige i eksisterende datasett.»

«Våre eksperimenter viser at nåværende toppmoderne modeller for deepfake-deteksjon og menneskelige observatører sliter med å oppdage disse subtile, men meningsfulle manipulasjonene.»

Forskerne testet både mennesker og ledende systemer for deepfake-deteksjon på sitt nye datasett for å se hvor godt disse subtile manipulasjonene kunne identifiseres. Menneskelige deltakere slet, og klassifiserte bilder korrekt som ekte eller falske bare i omtrent 62 % av tilfellene, og hadde enda større problemer med å finne ut hvilke deler av bildet som hadde blitt endret.

Eksisterende deepfake-detektorer, som hovedsakelig ble trent på mer åpenbare datasett med ansiktsbytte eller inpainting, presterte også dårlig, og klarte ofte ikke å registrere at det hadde skjedd noen manipulasjon. Selv etter finjustering På MultiFakeVerse holdt deteksjonsratene seg lave, noe som avslører hvor dårlig nåværende systemer håndterer disse subtile, narrativdrevne redigeringene.

Ocuco nytt papir har tittelen Multivers gjennom Deepfakes: MultiFakeVerse-datasettet av personsentriske visuelle og konseptuelle manipulasjoner, og kommer fra fem forskere ved Monash University i Melbourne og Curtin University i Perth. Kode og relaterte data er publisert på GitHub, i tillegg til Hugging Face-vertskapet som ble nevnt tidligere.

Metode

MultiFakeVerse-datasettet ble bygget fra fire sett med bilder fra den virkelige verden som viser mennesker i ulike situasjoner: EMOTISK; PISC, RØRog BILDE 2.0Forskerne produserte 86,952 758,041 manipulerte versjoner med utgangspunkt i XNUMX XNUMX originalbilder.

Ocuco Gemini-2.0-Flash og ChatGPT-4o Rammeverk ble brukt til å foreslå seks minimale redigeringer for hvert bilde – redigeringer designet for å subtilt endre hvordan den mest fremtredende personen i bildet ville bli oppfattet av en betrakter.

Modellene ble instruert til å generere modifikasjoner som ville få motivet til å se ut som naive, stolt, angrende, uerfareneller nonchalant, eller for å justere et faktisk element i scenen. Sammen med hver redigering produserte modellene også en refererende uttrykk for å tydelig identifisere målet for modifikasjonen, og sikre at den påfølgende redigeringsprosessen kan gjøre endringer på riktig person eller objekt i hvert bilde.

Forfatterne presiserer:

Merk at refererende uttrykk er et mye utforsket domene i samfunnet, som betyr en frase som kan tydeliggjøre målet i et bilde, f.eks. for et bilde som viser to menn som sitter på et skrivebord, den ene snakker i telefonen og den andre ser gjennom dokumenter, ville et passende refererende uttrykk for sistnevnte være mannen til venstre som holder et ark».

Når redigeringene var definert, ble selve bildemanipuleringen utført ved å be visuelle språkmodeller om å bruke de spesifiserte endringene mens resten av scenen forble intakt. Forskerne testet tre systemer for denne oppgaven: GPT-bilde-1; Gemini-2.0-Flash-bildegenerering, Og ICEdit.

Etter å ha generert tjueto tusen eksempelbilder, fremsto Gemini-2.0-Flash som den mest konsistente metoden, og produserte redigeringer som blandet seg naturlig inn i scenen uten å introdusere synlige artefakter; ICEdit produserte ofte mer åpenbare forfalskninger, med merkbare feil i de endrede områdene; og GPT-Image-1 påvirket av og til utilsiktede deler av bildet, delvis på grunn av dens samsvar med faste utdatasideforhold.

Bildeanalyse

Hvert manipulerte bilde ble sammenlignet med originalen for å bestemme hvor mye av bildet som var endret. Forskjellene på pikselnivå mellom de to versjonene ble beregnet, med liten tilfeldig støy filtrert ut for å fokusere på meningsfulle redigeringer. I noen bilder ble bare små områder påvirket; i andre, opptil åtti prosent av scenen ble modifisert.

For å evaluere hvor mye betydningen av hvert bilde endret seg i lys av disse endringene, ble det generert bildetekster for både det originale og det manipulerte bildet ved hjelp av DelGPT-4V visjon-språkmodell.

Disse tekstingene ble deretter konvertert til innebygde elementer ved hjelp av Langklipp, noe som muliggjorde en sammenligning av hvor mye innholdet hadde avviket mellom versjonene. De sterkeste semantiske endringene ble sett i tilfeller der objekter nær eller direkte involverte personen hadde blitt endret, siden disse små justeringene kunne endre hvordan bildet ble tolket betydelig.

Gemini-2.0-Flash ble deretter brukt til å klassifisere typen av manipulasjon som ble brukt på hvert bilde, basert på hvor og hvordan redigeringene ble gjort. Manipulasjonene ble gruppert i tre kategorier: personnivå redigeringer involverte endringer i motivets ansiktsuttrykk, positur, blikk, klær eller andre personlige trekk; objektnivå redigeringer påvirket elementer knyttet til personen, for eksempel gjenstander de holdt eller samhandlet med i forgrunnen; og scenenivå redigeringer involverte bakgrunnselementer eller bredere aspekter ved omgivelsene som ikke direkte involverte personen.

Genereringsprosessen for MultiFakeVerse-datasettet starter med ekte bilder, der visjonsspråklige modeller foreslår narrative redigeringer rettet mot personer, objekter eller scener. Disse instruksjonene brukes deretter av bilderedigeringsmodeller. Det høyre panelet viser andelen manipulasjoner på personnivå, objektnivå og scenenivå på tvers av datasettet. Kilde: https://arxiv.org/pdf/2506.00868

Siden individuelle bilder kunne inneholde flere typer redigeringer samtidig, ble fordelingen av disse kategoriene kartlagt på tvers av datasettet. Omtrent en tredjedel av redigeringene var kun rettet mot personen, omtrent en femtedel påvirket bare scenen, og rundt en sjettedel var begrenset til objekter.

Vurdering av perseptuell innvirkning

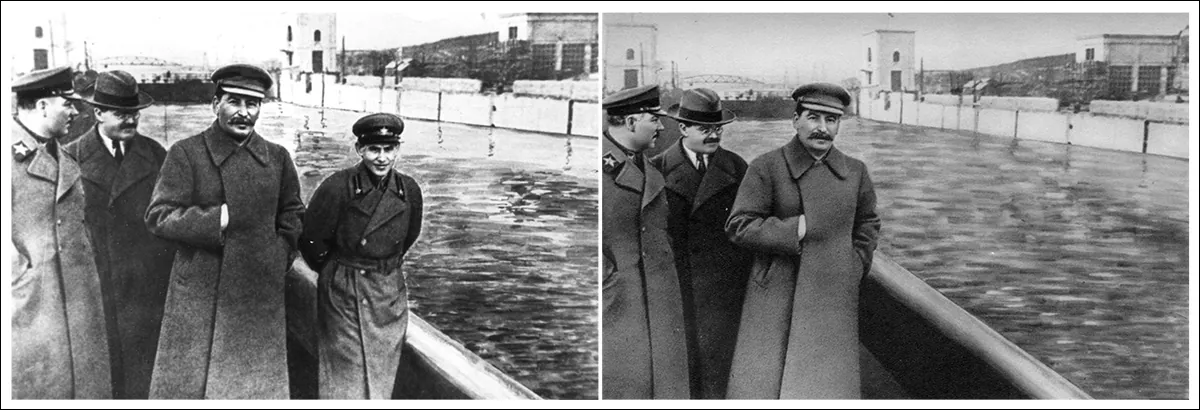

Gemini-2.0-Flash ble brukt til å vurdere hvordan manipulasjonene kunne endre seerens oppfatning på tvers av seks områder: følelser, personlig identitet, makt dynamikk, scenefortelling, hensikten med manipulasjonog etiske hensyn.

Til følelser, ble redigeringene ofte beskrevet med begreper som gledelig, engasjerendeeller tilnærmet, noe som tyder på endringer i hvordan subjektene ble emosjonelt innrammet. I narrative termer brukes ord som profesjonell or forskjellig indikerte endringer i den implisitte historien eller settingen:

Gemini-2.0-Flash ble bedt om å evaluere hvordan hver manipulasjon påvirket seks aspekter av seerens oppfatning. Venstre: eksempel på promptstruktur som veileder modellens vurdering. Høyre: ordskyer som oppsummerer endringer i følelser, identitet, scenefortelling, intensjon, maktdynamikk og etiske bekymringer på tvers av datasettet.

Beskrivelser av identitetsskifter inkluderte begreper som yngre, lekenog sårbare, som viser hvordan små endringer kunne påvirke hvordan enkeltpersoner ble oppfattet. Intensjonen bak mange redigeringer ble merket som overbevisende, villedendeeller estetiskSelv om de fleste redigeringene ble vurdert til å reise kun milde etiske bekymringer, ble en liten andel sett på som å ha moderate eller alvorlige etiske implikasjoner.

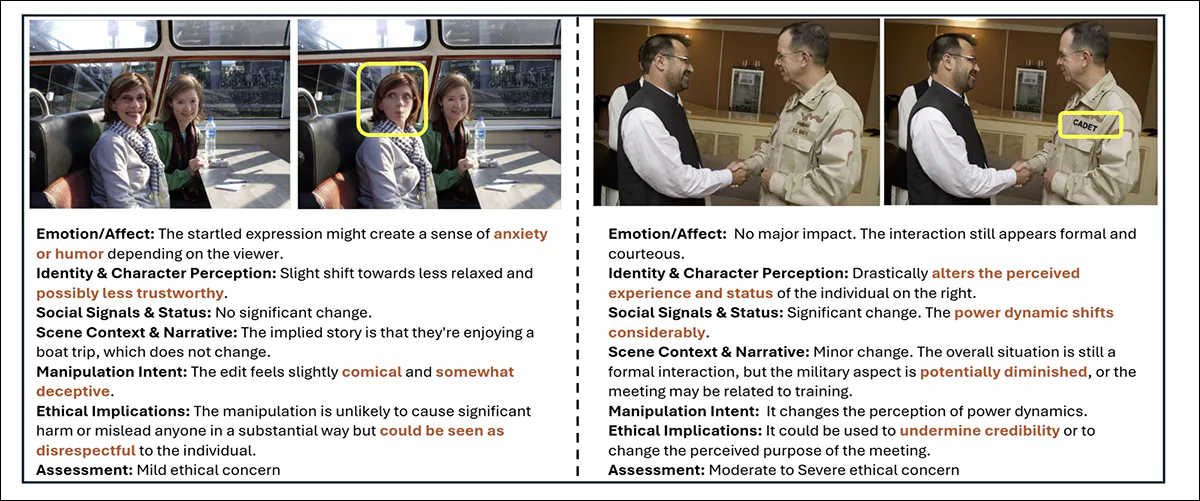

Eksempler fra MultiFakeVerse som viser hvordan små redigeringer endrer seerens oppfatning. Gule bokser fremhever de endrede områdene, med tilhørende analyse av endringer i følelser, identitet, narrativ og etiske bekymringer.

Metrics

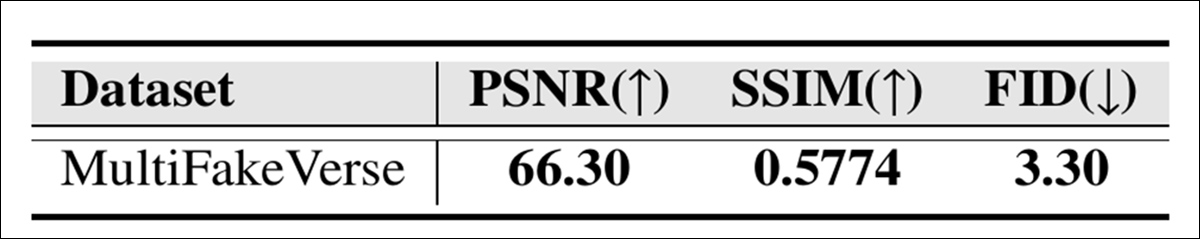

Den visuelle kvaliteten til MultiFakeVerse-samlingen ble evaluert ved hjelp av tre standardmålinger: Topp signal-til-støy-forhold (PSNR); Strukturell likhetsindeks (SSIM); og Fréchet Begynnelsesavstand (FID):

Bildekvalitetspoeng for MultiFakeVerse målt med PSNR, SSIM og FID.

SSIM-poengsummen på 0.5774 gjenspeiler en moderat grad av likhet, i samsvar med målet om å bevare mesteparten av bildet samtidig som man bruker målrettede redigeringer; FID-poengsummen på 3.30 antyder at de genererte bildene opprettholder høy kvalitet og mangfold; og en PSNR-verdi på 66.30 desibel indikerer at bildene beholder god visuell gjengivelse etter manipulasjon.

Brukerstudie

En brukerstudie ble gjennomført for å se hvor godt folk kunne oppdage de subtile forfalskningene i MultiFakeVerse. Atten deltakere ble vist femti bilder, jevnt fordelt mellom ekte og manipulerte eksempler som dekket en rekke redigeringstyper. Hver person ble bedt om å klassifisere om bildet var ekte eller falskt, og, hvis falskt, å identifisere hvilken type manipulasjon som hadde blitt brukt.

Den totale nøyaktigheten for å avgjøre om bildene var ekte eller falske var 61.67 prosent, noe som betyr at deltakerne feilklassifiserte bilder i mer enn en tredjedel av tilfellene.

Forfatterne sier:

Ved analyse av menneskelige prediksjoner av manipulasjonsnivåer for de falske bildene ble det gjennomsnittlige skjæringspunktet over forening mellom de predikerte og faktiske manipulasjonsnivåene funnet å være 24.96 %.

«Dette viser at det ikke er trivielt for menneskelige observatører å identifisere områdene med manipulasjoner i datasettet vårt.»

Å bygge MultiFakeVerse-datasettet krevde omfattende beregningsressurser: for å generere redigeringsinstruksjoner ble det gjort over 845,000 1000 API-kall til Gemini- og GPT-modeller, og disse oppgavene kostet rundt $2,867; å produsere Gemini-baserte bilder kostet omtrent $1; og å generere bilder ved hjelp av GPT-Image-200 kostet omtrent $6000. ICEdit-bilder ble opprettet lokalt på en NVIDIA AXNUMX GPU, og oppgaven ble fullført på omtrent tjuefire timer.

Tester

Før testene ble datasettet Divided i trenings-, validerings- og testsett ved først å velge 70 % av de virkelige bildene for trening, 10 prosent for validering og 20 prosent for testing. De manipulerte bildene som ble generert fra hvert virkelige bilde ble tilordnet det samme settet som den tilsvarende originalen.

Ytterligere eksempler på reelt (venstre) og endret (høyre) innhold fra datasettet.

Ytelsen til å oppdage forfalskninger ble målt ved hjelp av nøyaktighet på bildenivå (om systemet korrekt klassifiserer hele bildet som ekte eller falskt) og F1 scorerFor å lokalisere manipulerte områder ble evalueringen brukt Område under kurven (AUC), F1-poengsummer og kryss over fagforening (IoU).

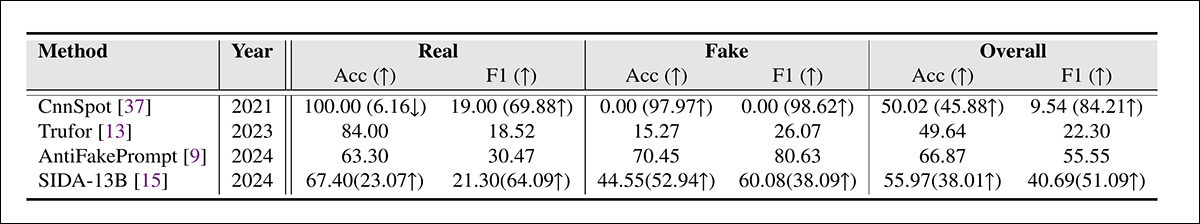

MultiFakeVerse-datasettet ble brukt mot ledende deepfake-deteksjonssystemer på hele testsettet, med de konkurrerende rammeverkene som CnnSpot; AntifakePrompt; TruFor; og det visjonsspråkbaserte AIDSHver modell ble først evaluert i nullskudd modus, ved å bruke den opprinnelige forhåndstrente vekter uten ytterligere justering.

To modeller, CnnSpot og SIDA, ble deretter finjustert på MultiFakeVerse-treningsdata for å vurdere om omtrening forbedret ytelsen.

Resultater av dypfalskedeteksjon på MultiFakeVerse under nullpunkts- og finjusteringsforhold. Tall i parentes viser endringer etter finjustering.

Av disse resultatene sier forfatterne:

«Modellene som ble trent på tidligere forfalskninger basert på inpainting, sliter med å identifisere våre VLM-redigeringsbaserte forfalskninger, spesielt CNNSpot har en tendens til å klassifisere nesten alle bildene som ekte. AntifakePrompt har den beste ytelsen ved null skudd med 66.87 % gjennomsnittlig klassemessig nøyaktighet og 55.55 % F1-poengsum.»

«Etter finjustering av togsettet vårt observerer vi en ytelsesforbedring i både CNNSpot og SIDA-13B, der CNNSpot overgår SIDA-13B både når det gjelder gjennomsnittlig klassevis nøyaktighet (med 1.92 %) og F1-score (med 1.97 %).»

SIDA-13B ble evaluert på MultiFakeVerse for å måle hvor presist den kunne lokalisere de manipulerte områdene i hvert bilde. Modellen ble testet både i nullbildemodus og etter finjustering på datasettet.

I sin opprinnelige tilstand nådde den en intersection-over-union-score på 13.10, en F1-score på 19.92 og en AUC på 14.06, noe som gjenspeiler svak lokaliseringsytelse.

Etter finjustering forbedret poengsummene seg til 24.74 for IoU, 39.40 for F1 og 37.53 for AUC. Selv med ekstra trening hadde modellen imidlertid fortsatt problemer med å finne nøyaktig hvor endringene hadde blitt gjort, noe som understreker hvor vanskelig det kan være å oppdage denne typen små, målrettede endringer.

Konklusjon

Den nye studien avdekker en blind flekk i både menneskelig og maskinell oppfatning: mens mye av den offentlige debatten rundt deepfakes har fokusert på identitetsbytter som har fått overskrifter, er disse mer stille «narrative endringene» vanskeligere å oppdage og potensielt mer korroderende på lang sikt.

Etter hvert som systemer som ChatGPT og Gemini tar en mer aktiv rolle i å generere denne typen innhold, og ettersom vi selv i økende grad delta Ved å endre virkeligheten til våre egne fotostrømmer, kan deteksjonsmodeller som er avhengige av å oppdage grove manipulasjoner tilby utilstrekkelig forsvar.

Det MultiFakeVerse demonstrerer er ikke at deteksjonen har mislyktes, men at i det minste deler av problemet kan være i ferd med å endre seg til en vanskeligere og langsommere form: en form der små visuelle løgner hoper seg opp ubemerket.

Først publisert torsdag 5. juni 2025