Kunstig intelligens

Hvordan AI gjør tegnspråkgjenkjenning mer presis enn noensinne

Når vi tenker på å bryte ned kommunikasjonsbarrierer, fokuserer vi ofte på språkoversettelsesapper eller stemmeassistenter. Men for millioner som bruker tegnspråk, har disse verktøyene ikke helt slått bro over gapet. Tegnspråk handler ikke bare om håndbevegelser – det er en rik, kompleks form for kommunikasjon som inkluderer ansiktsuttrykk og kroppsspråk, og hvert element har avgjørende betydning.

Her er det som gjør dette spesielt utfordrende: i motsetning til talespråk, som hovedsakelig varierer i ordforråd og grammatikk, skiller tegnspråk rundt om i verden seg fundamentalt i hvordan de formidler mening. American Sign Language (ASL), for eksempel, har sin egen unike grammatikk og syntaks som ikke samsvarer med muntlig engelsk.

Denne kompleksiteten betyr at det å skape teknologi for å gjenkjenne og oversette tegnspråk i sanntid krever en forståelse av et helt språksystem i bevegelse.

En ny tilnærming til anerkjennelse

Det var her et team ved Florida Atlantic Universitys (FAU) College of Engineering and Computer Science bestemte seg for å ta en ny tilnærming. I stedet for å prøve å takle hele kompleksiteten ved tegnspråk på én gang, fokuserte de på å mestre et avgjørende første steg: å gjenkjenne ASL-alfabetbevegelser med enestående nøyaktighet gjennom AI.

Tenk på det som å lære en datamaskin å lese håndskrift, men i tre dimensjoner og i bevegelse. Teamet bygde noe bemerkelsesverdig: et datasett med 29,820 21 statiske bilder som viser ASL-håndbevegelser. Men de samlet ikke bare bilder. De markerte hvert bilde med XNUMX nøkkelpunkter på hånden, og skapte et detaljert kart over hvordan hendene beveger seg og danner forskjellige tegn.

Dr. Bader Alsharif, som ledet denne forskningen som doktorgradskandidat, forklarer: «Denne metoden har ikke blitt utforsket i tidligere forskning, noe som gjør den til en ny og lovende retning for fremtidige fremskritt.»

Bryte ned teknologien

La oss dykke ned i kombinasjonen av teknologier som får dette tegnspråkgjenkjenningssystemet til å fungere.

MediaPipe og YOLOv8

Magien skjer gjennom sømløs integrasjon av to kraftige verktøy: MediaPipe og YOLOv8. Tenk på MediaPipe som en ekspert hånd-watcher - en dyktig tegnspråktolk som kan spore hver subtile fingerbevegelse og håndposisjon. Forskerteamet valgte MediaPipe spesifikt for sin eksepsjonelle evne til å gi nøyaktig hånd landemerkesporing, og identifisere 21 presise punkter på hver hånd, som vi nevnte ovenfor.

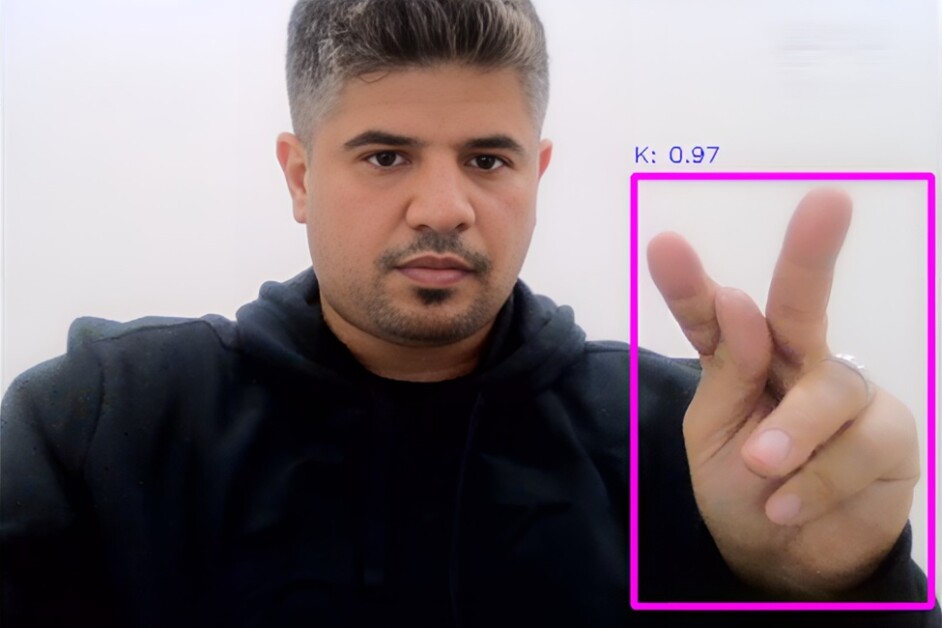

Men sporing er ikke nok – vi må forstå hva disse bevegelsene betyr. Det er der YOLOv8 kommer inn. YOLOv8 er en ekspert på mønstergjenkjenning, som tar alle de sporede punktene og finner ut hvilken bokstav eller gest de representerer. Forskningen viser at når YOLOv8 behandler et bilde, deler det det inn i et S × S-rutenett, med hver rutenettcelle ansvarlig for å oppdage objekter (i dette tilfellet håndbevegelser) innenfor sine grenser.

Alsharif et al., Franklin Open (2024)

Hvordan systemet faktisk fungerer

Prosessen er mer sofistikert enn det kan virke ved første øyekast.

Her er hva som skjer bak kulissene:

Hånddeteksjonsstadiet

Når du lager et tegn, identifiserer MediaPipe først hånden din i rammen og kartlegger de 21 nøkkelpunktene. Dette er ikke bare tilfeldige prikker – de tilsvarer spesifikke ledd og landemerker på hånden din, fra fingertuppene til håndflaten.

Romlig analyse

YOLOv8 tar deretter denne informasjonen og analyserer den i sanntid. For hver rutenettcelle i bildet forutsier den:

- Sannsynligheten for at en håndbevegelse er tilstede

- De nøyaktige koordinatene for bevegelsens plassering

- Konfidenspoengsummen til spådommen

Klassifisering

Systemet bruker noe som kalles "bounding box prediction" - forestill deg å tegne et perfekt rektangel rundt håndbevegelsen din. YOLOv8 beregner fem avgjørende verdier for hver boks: x- og y-koordinater for sentrum, bredde, høyde og en konfidenspoengsum.

Alsharif et al., Franklin Open (2024)

Hvorfor denne kombinasjonen fungerer så bra

Forskningsteamet oppdaget at ved å kombinere disse teknologiene skapte de noe som var større enn summen av delene. MediaPipes presise sporing kombinert med YOLOv8s avanserte objektdeteksjon ga bemerkelsesverdig nøyaktige resultater – vi snakker om en presisjon på 98 % og en F99-score på 1 %.

Det som gjør dette spesielt imponerende er hvordan systemet håndterer kompleksiteten til tegnspråk. Noen tegn kan ligne veldig på utrente øyne, men systemet kan oppdage subtile forskjeller.

Rekordstore resultater

Når forskere utvikler ny teknologi, er det store spørsmålet alltid: "Hvor godt fungerer det egentlig?" For dette tegnspråksgjenkjenningssystemet er resultatene imponerende.

Teamet ved FAU testet systemet sitt grundig, og her er hva de fant ut:

- Systemet identifiserer tegn riktig 98 % av tiden

- Den fanger opp 98 % av alle skilt som er laget foran den

- Samlet ytelsespoeng er på imponerende 99 %

«Resultater fra forskningen vår viser modellens evne til å nøyaktig oppdage og klassifisere amerikanske tegnspråkgester med svært få feil», forklarer Alsharif.

Systemet fungerer godt i hverdagssituasjoner – forskjellig belysning, forskjellige håndposisjoner, og til og med med forskjellige personer som signerer.

Dette gjennombruddet flytter grensene for hva som er mulig innen tegnspråkgjenkjenning. Tidligere systemer har slitt med nøyaktighet, men ved å kombinere MediaPipes håndsporing med YOLOv8s deteksjonsmuligheter, skapte forskerteamet noe spesielt.

«Suksessen til denne modellen skyldes i stor grad den nøye integreringen av overføringslæring, den nitidige datasettoppretting og den presise finjusteringen», sier Mohammad Ilyas, en av studiens medforfattere. Denne oppmerksomheten på detaljer ga resultater i systemets bemerkelsesverdige ytelse.

Hva dette betyr for kommunikasjon

Suksessen til dette systemet åpner for spennende muligheter for å gjøre kommunikasjon mer tilgjengelig og inkluderende.

Teamet stopper ikke bare ved å gjenkjenne bokstaver. Den neste store utfordringen er å lære systemet å forstå et enda bredere spekter av håndformer og gester. Tenk på de øyeblikkene når tegn ser nesten identiske ut – som bokstavene «M» og «N» i tegnspråk. Forskerne jobber med å hjelpe systemet sitt med å fange opp disse subtile forskjellene enda bedre. Som Dr. Alsharif uttrykker det: «Det er viktig at funnene fra denne studien ikke bare understreker systemets robusthet, men også dets potensial til å bli brukt i praktiske sanntidsapplikasjoner.»

Teamet fokuserer nå på:

- Få systemet til å fungere problemfritt på vanlige enheter

- Gjør det raskt nok for samtaler i den virkelige verden

- Sikre at den fungerer pålitelig i alle miljøer

Dekan Stella Batalama fra FAUs fakultet for ingeniørfag og informatikk deler den større visjonen: «Ved å forbedre gjenkjenning av amerikansk tegnspråk bidrar dette arbeidet til å lage verktøy som kan forbedre kommunikasjonen for døve og tunghørte.»

Tenk deg å gå inn på et legekontor eller delta på et kurs der denne teknologien bygger bro over kommunikasjonshull umiddelbart. Det er det virkelige målet her – å gjøre daglige interaksjoner smidigere og mer naturlige for alle involverte. Det handler om å skape teknologi som faktisk hjelper folk å få kontakt. Enten det er i utdanning, helsevesen eller hverdagssamtaler, representerer dette systemet et skritt mot en verden der kommunikasjonsbarrierer stadig blir mindre.