Artificial Intelligence

Het benutten van menselijke aandacht kan door AI gegenereerde afbeeldingen verbeteren

Nieuw onderzoek uit China heeft een methode voorgesteld om de kwaliteit van de afbeeldingen die door Latente diffusiemodellen (LDMs) modellen zoals stabiele diffusie.

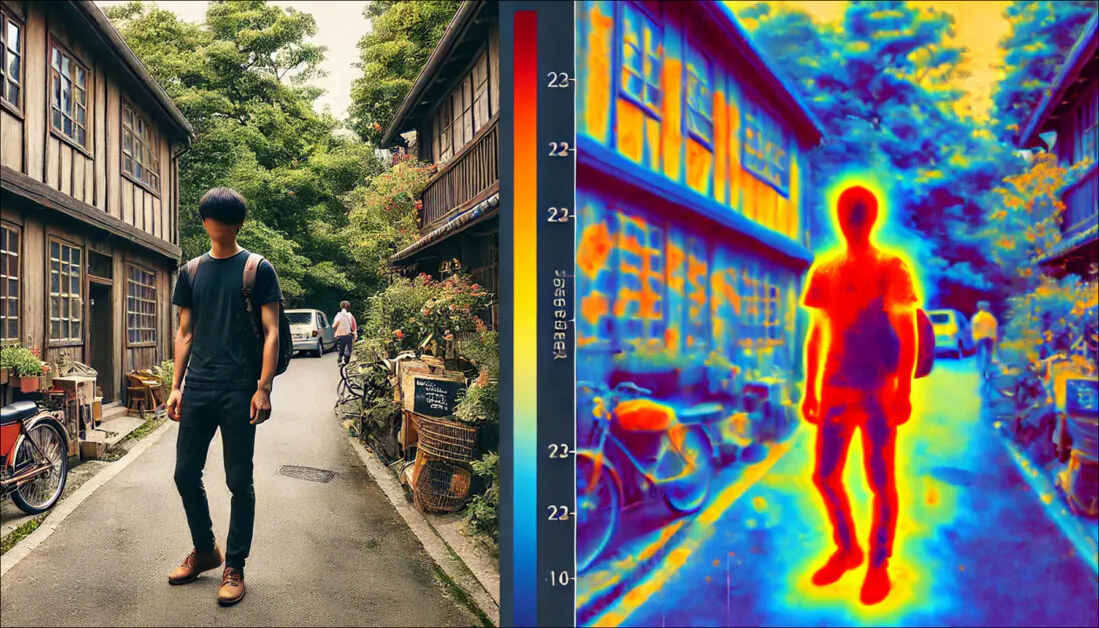

De methode richt zich op het optimaliseren van de saillante regio's van een afbeelding – gebieden die waarschijnlijk de meeste aandacht van de mens trekken.

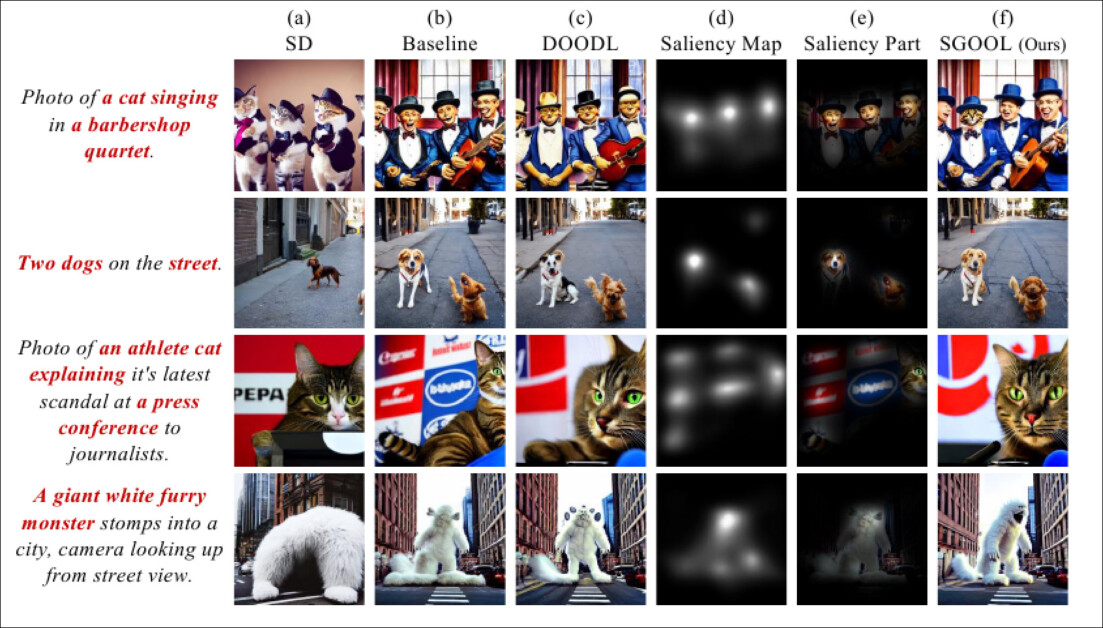

Uit nieuw onderzoek is gebleken dat saillantiekaarten (vierde kolom van links) kunnen worden gebruikt als een filter, of 'masker', om de aandacht bij ruisverwijderingsprocessen te richten op de gebieden van het beeld waar mensen waarschijnlijk het meest op letten. Bron: https://arxiv.org/pdf/2410.10257

Traditionele methoden optimaliseren de hele afbeelding uniform, terwijl de nieuwe aanpak gebruikmaakt van een opvallendheidsdetector om 'belangrijkere' gebieden te identificeren en prioriteren, zoals mensen dat ook doen.

In kwantitatieve en kwalitatieve testen bleek de methode van de onderzoekers beter te presteren dan op prior diffusie gebaseerde modellen, zowel wat betreft de beeldkwaliteit als de getrouwheid aan tekstprompts.

De nieuwe aanpak scoorde ook het beste in een proef met 100 deelnemers onder menselijke waarneming.

Natuurlijke selectie

Saliency, het vermogen om informatie in de echte wereld en in beelden te prioriteren, is een essentieel deel van de menselijke visie.

Een eenvoudig voorbeeld hiervan is de toegenomen aandacht voor details die de klassieke kunst besteedt aan belangrijke delen van een schilderij, zoals het gezicht in een portret of de masten van een schip in een onderwerp dat zich op zee afspeelt. In zulke voorbeelden concentreert de aandacht van de kunstenaar zich op het centrale onderwerp, wat betekent dat grote details, zoals de achtergrond van een portret of de verre golven van een storm, eerder schetsmatig en meer representatief zijn dan gedetailleerd.

Op basis van menselijke studies zijn de afgelopen tien jaar methoden voor machinaal leren ontwikkeld waarmee deze menselijke locus of interest in elke afbeelding kan worden nagebootst of op zijn minst benaderd.

Objectsegmentatie (semantische segmentatie) kan helpen bij het onderscheiden van facetten van een afbeelding en het ontwikkelen van bijbehorende saillantiekaarten. Bron: https://arxiv.org/pdf/1312.6034

In de loop van de onderzoeksliteratuur is de populairste detector voor saillantiekaarten de afgelopen vijf jaar de 2016 geweest Gradiëntgewogen klasse-activeringsmapping (Grad-CAM) initiatief, dat later evolueerde naar het verbeterde Afgestudeerd-CAM++ systeem, naast andere varianten en verfijningen.

Grad-CAM maakt gebruik van de gradiëntactivering van een semantisch teken (zoals 'hond' of 'kat') om een visuele kaart te produceren van waar het concept of de annotatie waarschijnlijk in de afbeelding wordt weergegeven.

Voorbeelden uit het originele Grad-CAM-artikel. In de tweede kolom worden alle bijdragende kenmerken geïndividualiseerd met behulp van begeleide backpropagation. In de derde kolom worden de semantische kaarten getekend voor de twee concepten 'hond' en 'kat'. De vierde kolom geeft de aaneenschakeling van de twee voorgaande gevolgtrekkingen weer. De vijfde kolom is de occlusie- (maskerings-) kaart die overeenkomt met de gevolgtrekking; en ten slotte visualiseert Grad-CAM in de zesde kolom een ResNet-18-laag. Bron: https://arxiv.org/pdf/1610.02391

Uit menselijk onderzoek naar de resultaten die met deze methoden zijn verkregen, is gebleken dat er een overeenkomst bestaat tussen deze wiskundige identificaties van belangrijke aandachtspunten in een afbeelding en de menselijke aandacht (bij het scannen van de afbeelding).

SGOOL

Ocuco's Medewerkers nieuw papier onderzoekt wat saillantie kan betekenen voor tekst-naar-afbeelding-systemen (en mogelijk ook voor tekst-naar-video-systemen) zoals Stable Diffusion en Flux.

Bij het interpreteren van de tekstprompt van een gebruiker, onderzoeken Latent Diffusion Models hun getrainde latente ruimte voor geleerde visuele concepten die overeenkomen met de gebruikte woorden of zinnen. Vervolgens parseren ze deze gevonden datapunten door een denoising proces, waarbij willekeurige ruis geleidelijk wordt ontwikkeld tot een creatieve interpretatie van de tekstprompt van de gebruiker.

Op dit punt geeft het model echter gelijke aandacht voor elk afzonderlijk onderdeel van de afbeeldingSinds de popularisering van diffusiemodellen in 2022, met de lancering van OpenAI's beschikbare Plaat Afbeeldingsgeneratoren en de daaropvolgende open-source van het Stable Diffusion-framework van Stability.ai, hebben gebruikers ontdekt dat 'essentiële' delen van een afbeelding vaak niet voldoende worden weergegeven.

Als we bedenken dat in een typische afbeelding van een mens het gezicht van de persoon (dat van maximaal belang (voor de kijker) waarschijnlijk niet meer dan 10-35% van het totale beeld in beslag neemt, druist deze democratische methode van aandachtsverspreiding in tegen zowel de aard van de menselijke perceptie als de geschiedenis van kunst en fotografie.

Wanneer de knoopjes van iemands spijkerbroek evenveel rekenkracht krijgen als zijn ogen, dan kan gezegd worden dat de toewijzing van bronnen niet optimaal is.

Daarom is de nieuwe methode die door de auteurs is voorgesteld, getiteld Saliency-geleide optimalisatie van diffusie-latenten (SGOOL) maakt gebruik van een opvallendheidsmapper om de aandacht te vestigen op de verwaarloosde delen van een afbeelding. Hierdoor worden minder middelen besteed aan delen die waarschijnlijk aan de rand van de aandacht van de kijker blijven.

Methode

De SGOOL-pijplijn omvat het genereren van afbeeldingen, het in kaart brengen van opvallendheid en optimalisatie, waarbij de algehele afbeelding en de met opvallendheid verfijnde afbeelding gezamenlijk worden verwerkt.

Conceptueel schema voor SGOOL.

De latente inbeddingen van het diffusiemodel worden direct geoptimaliseerd met scherpstellenwaardoor de noodzaak om een specifiek model te trainen vervalt. Stanford University's Impliciet model voor denoising-diffusie De bemonsteringsmethode (DDIM), die bekend is bij gebruikers van Stable Diffusion, is aangepast om de secundaire informatie uit saillantiekaarten te verwerken.

In de krant staat:

'We gebruiken eerst een saillantiedetector om het menselijke visuele aandachtssysteem na te bootsen en de saillante regio's te markeren. Om te voorkomen dat we een extra model opnieuw trainen, optimaliseert onze methode direct de diffusielatenten.

'Bovendien maakt SGOOL gebruik van een omkeerbaar diffusieproces en biedt het de voordelen van constante geheugenimplementatie. Daardoor wordt onze methode een parameterefficiënte en plug-and-play fine-tuningmethode. Er zijn uitgebreide experimenten uitgevoerd met verschillende meetmethoden en menselijke evaluatie.'

Omdat deze methode meerdere iteraties van het ruisverwijderingsproces vereist, hebben de auteurs de volgende methode toegepast: Directe optimalisatie van diffusie-latenten (DOODL) raamwerk, dat een omkeerbare diffusie proces – hoewel er nog steeds aandacht wordt besteed aan het geheel van het beeld.

Om de gebieden van menselijk belang te definiëren, maakten de onderzoekers gebruik van de 2022-studie van de Universiteit van Dundee TransalNet-framework.

Voorbeelden van saillantiedetectie uit het TransalNet-project van 2022. Bron: https://discovery.dundee.ac.uk/ws/portalfiles/portal/89737376/1_s2.0_S0925231222004714_main.pdf

De saillante gebieden die TransalNet verwerkte, werden vervolgens bijgesneden om sluitende saillantiesecties te genereren die waarschijnlijk het meest interessant zijn voor echte mensen.

Bij het definiëren van een gebruikersinterface moet rekening worden gehouden met het verschil tussen de gebruikerstekst en de afbeelding. verlies functie die kan bepalen of het proces werkt. Hiervoor is een versie van OpenAI's Contrastieve taal-beeldvooropleiding (CLIP) – inmiddels een steunpilaar van de beeldsynthese-onderzoekssector – werd gebruikt, samen met de overweging van de geschatte semantische afstand tussen de tekstprompt en de globale (niet-saliency) afbeeldingsuitvoer.

De auteurs beweren:

'[Het] uiteindelijke verlies [functie] betreft de relaties tussen opvallende delen en het globale beeld tegelijkertijd, wat helpt om lokale details en globale consistentie in het generatieproces in evenwicht te brengen.

'Dit opvallendheidsbewuste verlies wordt benut om de latente beeldinformatie te optimaliseren. De gradiënten worden berekend op de ruis [latente] en benut om het conditionerende effect van de invoerprompt op zowel opvallende als globale aspecten van de oorspronkelijk gegenereerde afbeelding te versterken.'

Gegevens en testen

Om SGOOL te testen, gebruikten de auteurs een 'vanilla'-distributie van Stable Diffusion V1.4 (aangegeven als 'SD' in de testresultaten) en Stable Diffusion met CLIP-geleiding (aangegeven als 'baseline' in de resultaten).

Het systeem werd geëvalueerd aan de hand van drie openbare datasets: Algemene syntactische processen (CPS), Tekenbank, en DailyDallE*.

De laatste bevat 99 uitgebreide opdrachten van een kunstenaar die voorkomt in een van de blogposts van OpenAI, terwijl DrawBench 200 opdrachten biedt in 11 categorieën. CSP bestaat uit 52 opdrachten, gebaseerd op acht verschillende naamvallen.

Voor SD, baseline en SGOOL werd in de tests het CLIP-model gebruikt ViT/B-32 om de afbeelding en tekst-embeddings te genereren. Dezelfde prompt en willekeurige zaad werd gebruikt. De uitvoergrootte was 256×256 en de standaardgewichten en -instellingen van TransalNet werden gebruikt.

Naast de CLIP-score-metriek wordt een geschatte Menselijke voorkeursscore (HPS) werd gebruikt, naast een praktijkonderzoek met 100 deelnemers.

Kwantitatieve resultaten van een vergelijking van SGOOL met eerdere configuraties.

Met betrekking tot de kwantitatieve resultaten die in de bovenstaande tabel zijn weergegeven, stelt het artikel:

'[Ons] model presteert aanzienlijk beter dan SD en Baseline op alle datasets, zowel wat betreft de CLIP-score als de HPS-metriek. De gemiddelde resultaten van ons model op de CLIP-score en HPS zijn respectievelijk 3.05 en 0.0029 hoger dan de tweede plaats.'

De auteurs hebben de boxplots van de HPS- en CLIP-scores verder geschat ten opzichte van de voorgaande benaderingen:

Boxplots voor de HPS- en CLIP-scores die in de tests zijn behaald.

Ze geven commentaar:

'Het is duidelijk dat ons model beter presteert dan de andere modellen, wat aangeeft dat ons model beter in staat is om afbeeldingen te genereren die consistent zijn met de prompts.

'In de boxplot is het echter niet eenvoudig om de vergelijking vanuit de boxplot te visualiseren vanwege de grootte van deze evaluatiemetriek bij [0, 1]. Daarom gaan we verder met het plotten van de overeenkomstige staafdiagrammen.

'Het is duidelijk dat SGOOL SD en Baseline overtreft op alle datasets, zowel wat betreft de CLIP-score als de HPS-meting. De kwantitatieve resultaten tonen aan dat ons model semantisch consistentere en door mensen geprefereerdere beelden kan genereren.'

De onderzoekers merken op dat hoewel het basismodel de kwaliteit van de beelduitvoer kan verbeteren, het geen rekening houdt met de saillante gebieden van de afbeelding. Ze beweren dat SGOOL, door een compromis te bereiken tussen globale en saillante beeldevaluatie, betere afbeeldingen verkrijgt.

Bij kwalitatieve (geautomatiseerde) vergelijkingen werd het aantal optimalisaties voor SGOOL en DOODL op 50 gezet.

Kwalitatieve resultaten voor de tests. Raadpleeg het bronartikel voor een betere definitie.

Hier merken de auteurs het volgende op:

'In de [eerste rij] zijn de onderwerpen van de prompt "een zingende kat" en "een barbershopkwartet". Er staan vier katten in de afbeelding die door SD is gegenereerd, en de inhoud van de afbeelding is slecht afgestemd op de prompt.

'De kat wordt genegeerd in de afbeelding die door Baseline is gegenereerd, en er is een gebrek aan detail in de weergave van het gezicht en de details in de afbeelding. DOODL probeert een afbeelding te genereren die consistent is met de prompt.

'Omdat DOODL echter het globale beeld rechtstreeks optimaliseert, worden de personen in het beeld geoptimaliseerd richting de kat.'

Ze merken verder op dat SGOOL daarentegen afbeeldingen genereert die beter aansluiten bij de oorspronkelijke opdracht.

In de menselijke perceptietest beoordeelden 100 vrijwilligers testafbeeldingen op kwaliteit en semantische consistentie (d.w.z. hoe nauw ze zich hielden aan hun brontekstprompts). De deelnemers hadden onbeperkt de tijd om hun keuzes te maken.

Resultaten van de menselijke perceptietest.

Zoals in het artikel wordt aangegeven, geniet de methode van de auteurs duidelijk de voorkeur boven de eerdere benaderingen.

Conclusie

Kort nadat de tekortkomingen die in dit artikel aan de orde komen, duidelijk werden in lokale installaties van Stable Diffusion, werden verschillende op maat gemaakte methoden (zoals Na Detailer) ontstond om het systeem te dwingen extra aandacht te besteden aan gebieden die van groter menselijk belang waren.

Bij deze aanpak is het echter wel nodig dat het diffusiesysteem eerst het normale proces doorloopt, waarbij alle delen van de afbeelding evenveel aandacht krijgen. Het extra werk wordt vervolgens in een extra fase uitgevoerd.

Uit het bewijsmateriaal van SGOOL blijkt dat het toepassen van basisprincipes van de menselijke psychologie op de prioritering van beeldsecties de initiële gevolgtrekking aanzienlijk zou kunnen verbeteren, zonder dat er nabewerkingsstappen nodig zijn.

* Het artikel biedt hiervoor dezelfde link als voor CommonSyntacticProcesses.

Eerste publicatie woensdag 16 oktober 2024