Mākslīgais intelekts

AnimateLCM: personalizētu difūzijas modeļu animācijas paātrināšana

Dažu pēdējo gadu laikā difūzijas modeļi ir guvuši milzīgus panākumus un atzinību attēlu un video ģenerēšanas uzdevumiem. Īpašu uzmanību video difūzijas modeļi ir ieguvuši, jo tie spēj radīt video ar augstu saskaņotību, kā arī precizitāti. Šie modeļi ģenerē augstas kvalitātes video, to arhitektūrā izmantojot iteratīvu trokšņa samazināšanas procesu, kas pakāpeniski pārveido augstas dimensijas Gausa troksni reālos datos.

Stabilā difūzija ir viens no reprezentatīvākajiem modeļiem attēlu ģenerēšanas uzdevumiem, kas paļaujas uz variācijas automātisko kodētāju (VAE), lai kartētu starp reālo attēlu un lejupizlasītajām latentajām funkcijām. Tas ļauj modelim samazināt ģeneratīvās izmaksas, savukārt savstarpējās uzmanības mehānisms tā arhitektūrā atvieglo teksta kondicionētu attēlu ģenerēšanu. Pavisam nesen Stable Diffusion sistēma ir izveidojusi pamatu vairākiem plug-and-play adapteriem, lai panāktu novatoriskāku un efektīvāku attēlu vai video ģenerēšanu. Tomēr iteratīvais ģeneratīvais process, ko izmanto lielākā daļa video difūzijas modeļu, padara attēlu ģenerēšanas procesu laikietilpīgu un salīdzinoši dārgu, ierobežojot tā pielietojumu.

Šajā rakstā mēs runāsim par AnimateLCM — personalizētu difūzijas modeli ar adapteriem, kuru mērķis ir ģenerēt augstas precizitātes video ar minimālām darbībām un skaitļošanas izmaksām. AnimateLCM ietvaru iedvesmojis konsekvences modelis, kas paātrina paraugu ņemšanu ar minimāliem soļiem, destilējot iepriekš apmācītus attēla difūzijas modeļus. Turklāt veiksmīgais konsekvences modeļa paplašinājums, latentais konsekvences modelis (LCM), atvieglo nosacītu attēlu ģenerēšanu. Tā vietā, lai veiktu konsekvences mācīšanos tieši neapstrādātā video datu kopā, AnimateLCM sistēma piedāvā izmantot atsaistītas konsekvences mācīšanās stratēģiju. Šī stratēģija atdala kustības ģenerēšanas prioritāšu un attēlu ģenerēšanas prioritāšu destilāciju, ļaujot modelim uzlabot ģenerētā satura vizuālo kvalitāti un vienlaikus uzlabot apmācības efektivitāti. Turklāt AnimateLCM modelis piedāvā apmācību adapterus no jauna vai esošo adapteru pielāgošanu tā destilētā video konsekvences modelim. Tas atvieglo plug-and-play adapteru apvienošanu stabilu difūzijas modeļu saimē, lai sasniegtu dažādas funkcijas, nekaitējot parauga ātrumam.

Šī raksta mērķis ir padziļināti aptvert AnimateLCM sistēmu. Mēs izpētām ietvara mehānismu, metodoloģiju un arhitektūru, kā arī tās salīdzinājumu ar vismodernākajām attēlu un video ģenerēšanas sistēmām. Tātad, sāksim.

AnimateLCM: personalizētu difūzijas modeļu animācija

Difūzijas modeļi ir izmantoti attēlu ģenerēšanas un video ģenerēšanas uzdevumu sistēmā, pateicoties to efektivitātei un iespējām veikt ģeneratīvos uzdevumus. Lielākā daļa difūzijas modeļu balstās uz iteratīvu trokšņu samazināšanas procesu attēla ģenerēšanai, kas pakāpeniski pārveido augstas dimensijas Gausa troksni reālos datos. Lai gan šī metode sniedz diezgan apmierinošus rezultātus, iteratīvais process un atkārtojošo paraugu skaits palēnina ģenerēšanas procesu, kā arī palielina difūzijas modeļu skaitļošanas prasības, kas ir daudz lēnākas nekā citas ģeneratīvās sistēmas, piemēram, GAN vai Ģeneratīvie pretrunīgie tīkli. Dažos pēdējos gados konsekvences modeļi vai CM ir ierosināti kā alternatīva iteratīvajiem difūzijas modeļiem, lai paātrinātu ģenerēšanas procesu, vienlaikus saglabājot nemainīgas skaitļošanas prasības.

Konsekvences modeļu galvenā iezīme ir tāda, ka tie apgūst konsekvences kartējumus, kas uztur iepriekš apmācīto difūzijas modeļu ieviesto trajektoriju paškonsekvenci. Konsekvences modeļu mācību process ļauj ģenerēt augstas kvalitātes attēlus ar minimālām darbībām, kā arī novērš vajadzību pēc skaitļošanas ietilpīgām iterācijām. Turklāt latentās konsekvences modelis jeb LCM ir izveidots, pamatojoties uz stabila difūzijas sistēma var integrēt tīmekļa lietotāja interfeisā ar esošajiem adapteriem, lai nodrošinātu virkni papildu funkcionalitātes, piemēram, reāllaika attēlu pārsūtīšanu uz attēlu. Salīdzinājumam, lai gan esošie video difūzijas modeļi sniedz pieņemamus rezultātus, video parauga paātrinājuma laukā joprojām ir jāpanāk progress, un tam ir liela nozīme augsto video ģenerēšanas skaitļošanas izmaksu dēļ.

Tādējādi mēs nonākam pie AnimateLCM — augstas precizitātes video ģenerēšanas sistēmas, kurai nepieciešams minimāls video ģenerēšanas darbību skaits. Sekojot latentās konsekvences modelim, AnimateLCM ietvars apstrādā reversās difūzijas procesu kā CFG vai Klasifikatora bezmaksas norādījumu paplašinātās varbūtības plūsmas atrisināšanu un apmāca modeli paredzēt šādu varbūtības plūsmu risinājumu tieši latentā telpā. Tomēr tā vietā, lai tieši veiktu neapstrādātu video datu konsekvences mācīšanos, kas prasa lielu apmācību un skaitļošanas resursus un kas bieži noved pie sliktas kvalitātes, AnimateLCM sistēma piedāvā atsaistītu konsekventu mācīšanās stratēģiju, kas atdala kustības ģenerēšanas un attēla ģenerēšanas prioritāšu konsekvences destilāciju.

AnimateLCM sistēma vispirms veic konsekvences destilāciju, lai attēla bāzes difūzijas modeli pielāgotu attēla konsekvences modelim, un pēc tam veic 3D inflāciju gan attēla konsekvences, gan attēla difūzijas modeļos, lai pielāgotos 3D funkcijām. Galu galā AnimateLCM sistēma iegūst video konsekvences modeli, veicot video datu konsekvences destilāciju. Turklāt, lai mazinātu iespējamo funkciju korupciju difūzijas procesa rezultātā, AnimateLCM sistēma arī ierosina izmantot inicializācijas stratēģiju. Tā kā AnimateLCM ietvars ir veidots uz stabilās difūzijas ietvara, tā var aizstāt apmācītā video konsekvences modeļa telpiskos svarus ar publiski pieejamiem personalizētiem attēla difūzijas svērumiem, lai sasniegtu novatoriskus ģenerēšanas rezultātus.

Turklāt, lai apmācītu konkrētus adapterus no jauna vai labāk piemērotu publiski pieejamiem adapteriem, AnimateLCM sistēma piedāvā efektīvu paātrināšanas stratēģiju adapteriem, kuriem nav nepieciešama specifisku skolotāju modeļu apmācība.

AnimateLCM ietvara ieguldījumu var ļoti labi apkopot šādi: Ierosinātā AnimateLCM ietvara mērķis ir panākt augstas kvalitātes, ātru un augstas precizitātes video ģenerēšanu, un, lai to panāktu, AnimateLCM sistēma piedāvā atsaistītu destilācijas stratēģiju, kas atdala kustību un attēlu. paaudzes prioritātes, kas nodrošina labāku paaudzes kvalitāti un uzlabotu apmācības efektivitāti.

InstantID: metodoloģija un arhitektūra

Savā pamatā InstantID ietvars smeļas iedvesmu no difūzijas modeļiem un paraugu ņemšanas ātruma stratēģijām. Difūzijas modeļi, kas pazīstami arī kā uz rezultātiem balstīti ģeneratīvie modeļi, ir parādījuši ievērojamas attēlu ģenerēšanas iespējas. Rezultātu virziena vadībā iteratīvā paraugu ņemšanas stratēģija, ko īsteno difūzijas modeļi, pakāpeniski noņem trokšņa bojātos datus. Difūzijas modeļu efektivitāte ir viens no galvenajiem iemesliem, kāpēc tos izmanto lielākā daļa video difūzijas modeļi trenējot pievienotos temporālos slāņus. No otras puses, paraugu ņemšanas ātrums un paraugu ņemšanas paātrināšanas stratēģijas palīdz novērst lēno ģenerēšanas ātrumu difūzijas modeļos. Uz destilāciju balstīta paātrinājuma metode noregulē sākotnējos difūzijas svarus ar izsmalcinātu arhitektūru vai plānotāju, lai palielinātu ģenerēšanas ātrumu.

Turpinot darbu, InstantID ietvars ir veidots, pamatojoties uz stabilo difūzijas modeli, kas ļauj InstantID piemērot atbilstošus jēdzienus. Modelis diskrēto priekšējo difūzijas procesu uzskata par nepārtraukta laika dispersiju saglabājošu SDE. Turklāt stabilās difūzijas modelis ir DDPM vai Denoising Diffusion Probabilistic Model paplašinājums, kurā apmācības datu punktu pakāpeniski traucē diskrētā Markova ķēde ar traucējumu audzētavu, kas ļauj sadalīt trokšņainos datus dažādos laika posmos, lai sekotu sadalījumam.

Lai panāktu augstas precizitātes video ģenerēšanu ar minimālu darbību skaitu, AnimateLCM sistēma pieradina stabilus uz difūziju balstītus video modeļus, lai ievērotu paškonsekvences īpašības. AnimateLCM ietvara vispārējā apmācības struktūra sastāv no atsaistītas konsekvences mācīšanās stratēģijas skolotāju brīvai adaptācijai un efektīvai konsekvences apmācībai.

Pāreja no difūzijas modeļiem uz konsekvences modeļiem

AnimateLCM ietvars ievieš savu stabilās difūzijas modeļa jeb DM pielāgošanu konsekvences modelim vai CM pēc latentās konsekvences modeļa jeb LCM dizaina. Ir vērts atzīmēt, ka, lai gan stabilie difūzijas modeļi parasti prognozē paraugiem pievienoto troksni, tie ir būtiski sigma difūzijas modeļi. Tas ir pretstatā konsekvences modeļiem, kuru mērķis ir tieši paredzēt risinājumu PF-ODE trajektorijai. Turklāt stabilos difūzijas modeļos ar noteiktiem parametriem ir svarīgi, lai modelis izmantotu vadības stratēģiju bez klasifikatoriem, lai radītu augstas kvalitātes attēlus. Tomēr AnimateLCM ietvars izmanto bez klasifikatora vadītu ODE risinātāju, lai ņemtu paraugus no blakus esošajiem pāriem vienās un tajās pašās trajektorijās, tādējādi nodrošinot labāku efektivitāti un uzlabotu kvalitāti. Turklāt esošie modeļi ir norādījuši, ka paaudzes kvalitāti un apmācības efektivitāti lielā mērā ietekmē diskrētu punktu skaits trajektorijā. Mazāks diskrēto punktu skaits paātrina apmācības procesu, savukārt lielāks diskrēto punktu skaits treniņa laikā rada mazāku novirzi.

Atsaistīta konsekvences mācīšanās

Konsistences destilācijas procesā izstrādātāji ir novērojuši, ka apmācībā izmantotie dati būtiski ietekmē konsistences modeļu pēdējās paaudzes kvalitāti. Tomēr pašlaik galvenā problēma ar publiski pieejamām datu kopām ir tā, ka tās bieži sastāv no ūdenszīmju datiem vai tās ir zemas kvalitātes un var saturēt pārāk īsus vai neskaidrus parakstus. Turklāt modeļa apmācība tieši lielas izšķirtspējas videoklipos ir skaitļošanas ziņā dārga un laikietilpīga, tāpēc lielākajai daļai pētnieku tā nav iespējama.

Ņemot vērā filtrētu augstas kvalitātes datu kopu pieejamību, AnimateLCM sistēma ierosina atdalīt kustības prioritāšu un attēlu ģenerēšanas prioritāšu destilāciju. Precīzāk sakot, AnimateLCM sistēma vispirms destilē stabilos difūzijas modeļus attēla konsekvences modeļos ar filtrētām augstas kvalitātes attēla teksta datu kopām ar labāku izšķirtspēju. Pēc tam ietvars trenē vieglos LoRA svarus stabilā difūzijas modeļa slāņos, tādējādi iesaldējot staļļa svarus. difūzijas modelis. Kad modelis noregulē LoRA svarus, tas darbojas kā daudzpusīgs paātrinājuma modulis, un tas ir pierādījis savu saderību ar citiem personalizētiem modeļiem stabilās difūzijas kopienās. Lai izdarītu secinājumus, AnimateLCM sistēma apvieno LoRA svarus ar sākotnējiem svariem, nesabojājot secinājumu ātrumu. Pēc tam, kad AnimateLCM ietvars iegūst konsekvences modeli attēla ģenerēšanas līmenī, tas iesaldē stabilā difūzijas modeļa un LoRA svaru svarus. Turklāt modelis uzpūš 2D konvolūcijas kodolus līdz pseido-3D kodoliem, lai apmācītu konsekvences modeļus video ģenerēšanai. Modelis pievieno arī pagaidu slāņus ar nulles inicializāciju un bloka līmeņa atlikušo savienojumu. Vispārējā iestatīšana palīdz nodrošināt, ka modeļa izvade netiks ietekmēta, kad tas tiek apmācīts pirmo reizi. AnimateLCM sistēma atvērtā avota video difūzijas modeļu vadībā apmāca laika slāņus, kas tiek paplašināti no stabiliem difūzijas modeļiem.

Ir svarīgi atzīt, ka, lai gan telpiskie LoRA svari ir paredzēti, lai paātrinātu paraugu ņemšanas procesu, neņemot vērā laika modelēšanu, un laika moduļi tiek izstrādāti, izmantojot standarta difūzijas metodes, to tiešai integrācijai ir tendence sabojāt attēlojumu apmācības sākumā. Tas rada ievērojamas problēmas, lai tās efektīvi un efektīvi apvienotu ar minimālu konfliktu. Izmantojot empīriskus pētījumus, AnimateLCM sistēma ir identificējusi veiksmīgu inicializācijas pieeju, kas ne tikai izmanto telpisko LoRA svaru konsekvences prioritātes, bet arī mazina to tiešās kombinācijas nelabvēlīgo ietekmi.

Konsekvences apmācības sākumā iepriekš apmācīti telpiskie LoRA svari tiek integrēti tikai tiešsaistes konsekvences modelī, aiztaupot mērķa konsekvences modeli no ievietošanas. Šī stratēģija nodrošina, ka mērķa modelis, kas kalpo kā tiešsaistes modeļa izglītojošs ceļvedis, nerada kļūdainas prognozes, kas varētu negatīvi ietekmēt tiešsaistes modeļa mācību procesu. Visā apmācības periodā LoRA svari tiek pakāpeniski iekļauti mērķa konsekvences modelī, izmantojot eksponenciāli mainīgā vidējā (EMA) procesu, panākot optimālo svara līdzsvaru pēc vairākām iterācijām.

Skolotāja bezmaksas adaptācija

Stabilas difūzijas modeļi un plug and play adapteri bieži vien iet roku rokā. Tomēr ir novērots, ka, lai gan plug and play adapteri zināmā mērā darbojas, tie mēdz zaudēt kontroli pār detaļām, pat ja lielākā daļa šo adapteru ir apmācīti ar attēla difūzijas modeļiem. Lai novērstu šo problēmu, AnimateLCM sistēma izvēlas skolotāju bezmaksas pielāgošanu — vienkāršu, bet efektīvu stratēģiju, kas vai nu iekļauj esošos adapterus, lai nodrošinātu labāku savietojamību, vai apmāca adapterus no paša sākuma vai. Šī pieeja ļauj AnimateLCM ietvaram sasniegt kontrolējamu video ģenerēšanu un attēla ģenerēšanu video ar minimālu darbību skaitu, neprasot skolotāju modeļus.

AnimateLCM: eksperimenti un rezultāti

AnimateLCM ietvars izmanto Stable Diffusion v1-5 kā bāzes modeli un ievieš DDIM ODE risinātāju apmācības nolūkos. Ietvars izmanto arī Stable Diffusion v1-5 ar atvērtā avota kustības svariem kā skolotāja video difūzijas modeli, eksperimentiem, kas tiek veikti WebVid2M datu kopā bez papildu vai papildinātiem datiem. Turklāt ietvars izmanto TikTok datu kopu ar BLIP titriem īsiem teksta norādījumiem kontrolējamai video ģenerēšanai.

Kvalitatīvie rezultāti

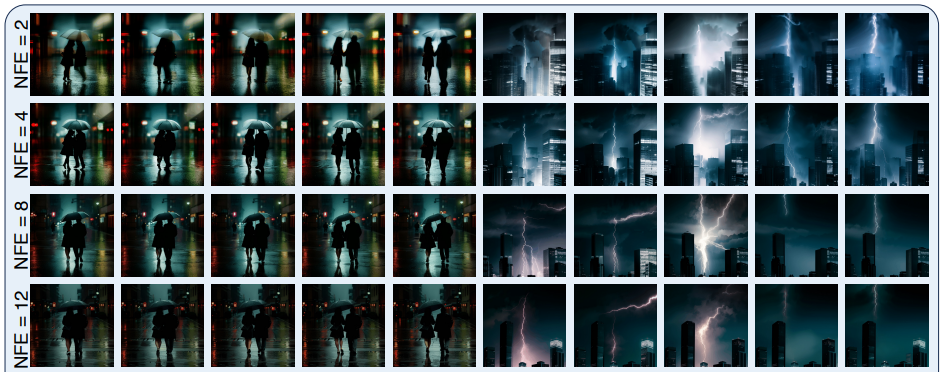

Nākamajā attēlā parādīti AnimateLCM ietvara ieviestās četrpakāpju ģenerēšanas metodes rezultāti teksta pārveidošanā video, attēla pārveidošanā video un vadāmā video ģenerēšanā.

Kā redzams, katra no tiem sniegtie rezultāti ir apmierinoši ar ģenerētajiem rezultātiem, kas parāda AnimateLCM ietvara spēju sekot konsekvences īpašībai pat ar dažādiem secinājumu soļiem, saglabājot līdzīgu kustību un stilu.

Kvantitatīvie rezultāti

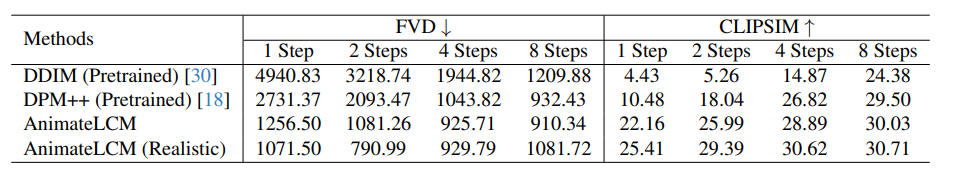

Nākamajā attēlā ir parādīti kvantitatīvie rezultāti un AnimateLCM ietvara salīdzinājums ar jaunākajām DDIM un DPM++ metodēm.

Kā redzams, AnimateLCM ietvars ar ievērojamu starpību pārspēj esošās metodes, īpaši zemo soļu režīmā, kas svārstās no 1 līdz 4 soļiem. Turklāt šajā salīdzinājumā parādītās AnimateLCM metrikas tiek novērtētas, neizmantojot CFG vai klasifikatora bezmaksas norādījumus, kas ļauj sistēmai ietaupīt gandrīz 50% no secinājumu veikšanas laika un secinājumu maksimālās atmiņas izmaksām. Turklāt, lai vēl vairāk apstiprinātu tā veiktspēju, AnimateLCM ietvara telpiskie svari tiek aizstāti ar publiski pieejamu personalizētu reālistisku modeli, kas nodrošina labu līdzsvaru starp precizitāti un daudzveidību, kas palīdz vēl vairāk uzlabot veiktspēju.

Final Domas

Šajā rakstā mēs runājām par AnimateLCM — personalizētu difūzijas modeli ar adapteriem, kura mērķis ir ģenerēt augstas precizitātes video ar minimālām darbībām un skaitļošanas izmaksām. AnimateLCM ietvaru iedvesmojis konsekvences modelis, kas paātrina paraugu ņemšanu ar minimāliem soļiem, destilējot iepriekš apmācītus attēlu difūzijas modeļus, un veiksmīgā konsekvences modeļa, latentās konsekvences modeļa vai LCM paplašināšanas, kas atvieglo nosacītu attēlu ģenerēšanu. Tā vietā, lai veiktu konsekvences mācīšanos tieši neapstrādātā video datu kopā, AnimateLCM sistēma ierosina izmantot atsaistītas konsekvences mācīšanās stratēģiju, kas atdala kustības ģenerēšanas prioritāšu un attēlu ģenerēšanas prioritāšu destilāciju, ļaujot modelim uzlabot ģenerētā satura vizuālo kvalitāti un vienlaikus uzlabot treniņu efektivitāti.