Mākslīgais intelekts

GPU var būt labāki, ne tikai ātrāki, apmācot dziļos neironu tīklus

Pētnieki no Polijas un Japānas, sadarbojoties ar Sony, ir atklājuši pierādījumus, ka mašīnmācīšanās sistēmās, kas apmācītas uz GPU, nevis CPU, apmācības procesā var būt mazāk kļūdu un iegūti izcili rezultāti, kas ir pretrunā vispārpieņemtajai izpratnei, ka GPU vienkārši veic šādas darbības ātrāk. nekā labāk.

Jūsu darbs IR Klientu apkalpošana pētniecība, ar nosaukumu GPU nenoteiktības ietekme uz paredzamo dziļo neironu tīklu apmācību, nāk no Ādama Mickeviča universitātes Psiholoģijas un kognitīvo zinātņu fakultātes un divām Japānas universitātēm kopā ar SONY Computer Science Laboratories.

Pētījums liecina, ka "neskaidrības" kuras dziļi neironu tīkli, saskaroties ar dažādām aparatūras un programmatūras konfigurācijām, dod priekšroku dārgākām (un arvien retāk).

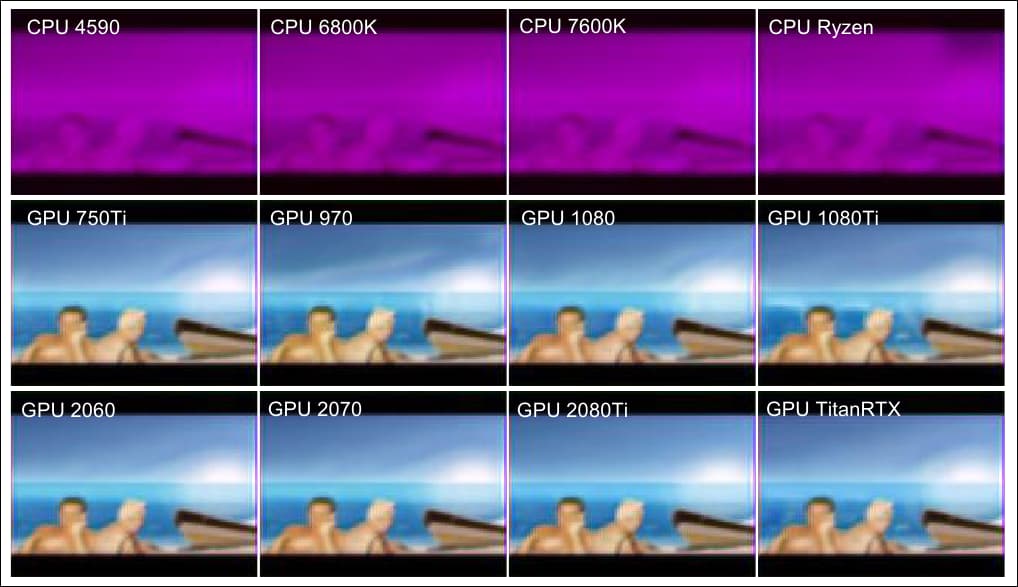

Šajā raksta papildu piemērā mēs redzam (divas apakšējās rindas) līdzīgu rezultātu kvalitāti, kas iegūta no dažādiem GPU, un (pirmā rinda) zemākus rezultātus, kas iegūti no dažādiem citādi ļoti spējīgiem CPU.. Avots: https://arxiv.org/pdf/2109.01451.pdf

Dīvainas parādības

Šie sākotnējie atklājumi nav vienādi piemērojami visos populārajos mašīnmācīšanās algoritmos, un vienkāršu automātiskās kodēšanas arhitektūru gadījumā šī parādība neparādās.

Neskatoties uz to, darbs norāda uz iespējamu "aizbēgšanas ātrumu" apmācības efektivitātei sarežģītos neironu tīklos, kur, aptverot tās pašas darbības ar mazāku ātrumu un ilgāku apmācības laiku, netiek iegūta veiktspējas paritāte, kādu varētu sagaidīt no matemātiskās iterācijas rutīnām.

Pētnieki norāda, ka šī veiktspējas atšķirība varētu būt īpaši raksturīga noteiktiem neironu tīklu veidiem un ka GPU specifiskās apstrādes nenoteiktie aspekti, kas bieži tiek uzskatīti par šķērsli, kas galu galā jāpārvar, var ne tikai sniegt ievērojamas priekšrocības, bet galu galā var būt arī apzināti. iekļautas vēlākās sistēmās. Rakstā arī norādīts, ka atklājumi varētu sniegt dziļāku ieskatu ar smadzenēm saistītā skaitļošanas apstrādē.

Identificējot īpatnības, kas šādā veidā palielina efektivitāti un rezultātu kvalitāti GPU, var iegūt dziļāku ieskatu “melnās kastes” AI arhitektūrā un pat uzlabot CPU veiktspēju – lai gan pašlaik pamatcēloņi ir nenotverami.

Autoencoder vs. PredNet

Pētot anomālijas, pētnieki izmantoja pamata automātisko kodētāju un arī Hārvardas universitātes paredzamo neironu tīklu PredNet2016. gada pētījums, kura mērķis bija izpētīt un mēģināt atkārtot cilvēka smadzeņu garozas uzvedību.

Abas sistēmas ir dziļi neironu tīkli, kas izstrādāti, lai sintezētu piemērotus attēlus, izmantojot nepārraudzītu mācīšanos (ar datiem, no kuriem etiķetes tika izlaistas), lai gan automātiskais kodētājs lineāri apstrādā vienu attēlu vienā partijā, kas pēc tam radītu izvadi kā nākamo attēlu atkārtotā konveijerā. Autoencoder tika apmācīts uz MNIST rokraksta datu bāze.

Autokodētājs pētnieku testos tika apmācīts MNIST datu bāzē, kurā ir 60,000 28 apmācības attēlu ar 28 × 10,000 pikseļiem, kas ir anti-aliased pelēktoņu indukcijai, kā arī XNUMX XNUMX testa attēlu.

Turpretim PredNet novērtē sarežģītu video ievadi, un šī pētījuma gadījumā tika apmācīts FPSI datu kopa, kurā ir ietverti plaši videomateriāli uz ķermeņa valkātas dienas Disneja pasaulē Orlando, Floridā (Disnijs bija viens no 2012. gada dokumenta pētniekiem).

Attēlu secības no FPSI, kas parāda pirmās personas skatus dienā Disney World.

Abas arhitektūras ir ļoti atšķirīgas sarežģītības ziņā. Autoencoder ir paredzēts attēlu rekonstrukcijai, nevis mērķa vērtību prognozēšanai. Turpretim PredNet ir četri slāņi, no kuriem katrs sastāv no reprezentācijas neironiem, izmantojot konvolucionālo ilgtermiņa īstermiņa atmiņu (LSTM).

Slāņi izvada kontekstuālas prognozes, kuras pēc tam tiek salīdzinātas ar mērķi, lai iegūtu kļūdas terminu, kas izplatās visā tīklā. Katrs no diviem modeļiem izmanto nekontrolētu mācīšanos.

Vienkāršā, lineārā automātiskā kodētāja arhitektūra un labirintiskāks un rekursīvāks PredNet tīkls.

Abas sistēmas tika pārbaudītas ar virkni aparatūras un programmatūras konfigurāciju, tostarp CPU bez GPU (Intel i5-4590, i7-6800K, i5-7600K vai AMD Ryzen-5-3600) un CPU ar GPU (Intel i5-7600K + NVIDIA GTX-750Ti, i5-7600K + GTX-970, i7-6700K + GTX-1080, i7-7700K + GTX-1080Ti, i7-9700 + RTX-2080Ti, i5-7600K + RTX-2060, i5-3600K + RTX-2070-5 9400 + RTX-XNUMX super vai iXNUMX-XNUMX + Titan-RTX).

Interaktīvais procesa skatītājs htop tika izmantots, lai nodrošinātu, ka visa apmācība notiek vai nu vienā pavedienā (uz Intel i7-6800K), četros pavedienos (uz Intel i5-4590 un i5-7600K) vai sešos pavedienos (uz AMD Ryzen-5-3600 ).

Seglu punkti

Autokodētājā vidējā atšķirība visās konfigurācijās ar un bez cuDNN nebija nozīmīga. PredNet rezultāti bija pārsteidzošāki ar ievērojamām atšķirībām zaudējumu novērtējumā un kvalitātē starp CPU un GPU apmācību.

PredNet apmācības vidējie zudumu rezultāti četros CPU un astoņos GPU, tīklam apmācot 5000 video kadrus 250 partijās, un attēlots vidējais zudums pēdējos 1000 kadros (50 partijās). cuDNN tika izslēgts.

Pētnieki to secina "Lai gan mehānisms ir neskaidrs, šķiet, ka GPU aparatūrai ir iespēja uzlabot DNN apmācību."

Rezultāti liecina, ka GPU var labāk izvairīties no segpunktiem — no slīpuma nolaišanās zonām, kas raksturo nogāzes dibenu.

Nogāžu zemākais punkts slīpuma nolaišanās gadījumā ir "seglu punkts", kas nosaukts acīmredzamu iemeslu dēļ. Avots: https://www.pinterest.com.au/pin/436849232581124086/

Seglu punkti, lai gan tie ir šķērslis, lielākoties tika noraidīti kā viegli apstrādājami, nesen domājot par stohastiskā gradienta nolaišanās (SGD) optimizāciju, taču jaunais dokuments liecina ne tikai par to, ka GPU var būt unikāli aprīkoti, lai no tiem izvairītos, bet arī tas, ka seglu punkti varbūt būtu jāpārskata.