Artificial Intelligence

少ないほど良い: より少ない文書を取得すると AI の回答が向上する理由

検索拡張生成 (RAG) 言語モデルと外部知識ソースを組み合わせたAIシステム構築のアプローチです。簡単に言うと、AIはまずユーザーのクエリに関連する関連文書(記事やウェブページなど)を検索し、それらの文書を使用してより正確な回答を生成します。この方法は、 大規模言語モデル (LLM) 実際のデータに基づいて回答することで、事実に基づいた回答を維持し、幻覚を軽減します。

直感的には、AI が取得する文書が多ければ多いほど、その回答はより情報に基づいたものになると思われるかもしれません。しかし、最近の研究では驚くべき展開が示されています。AI に情報を提供する場合、少ないほうがより効果的である場合があるのです。

文書は少なく、回答はより良く

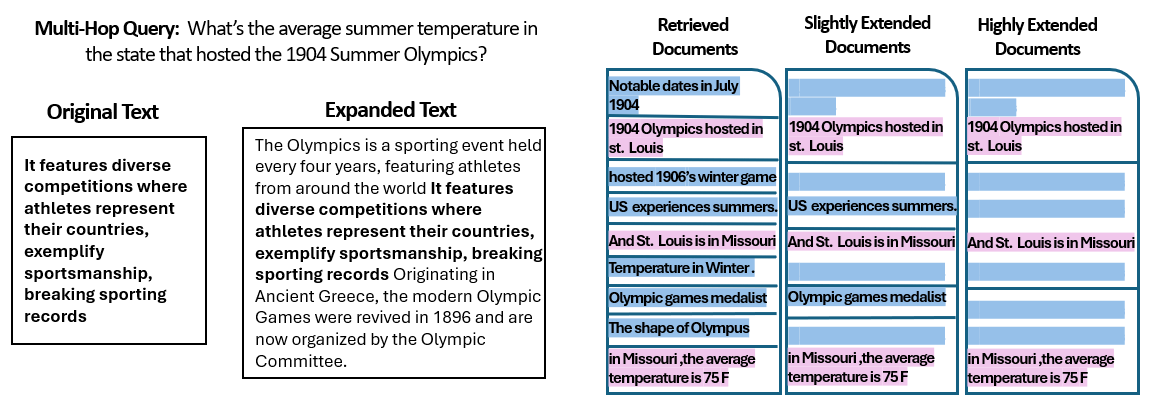

A 新しい研究 エルサレムのヘブライ大学の研究者らは、 数 RAG システムに与えられる文書の量は、そのパフォーマンスに影響します。重要なのは、テキストの総量を一定に保ったことです。つまり、提供される文書の数が少ない場合は、それらの文書がわずかに拡張され、多くの文書と同じ長さになります。このようにして、パフォーマンスの違いは、単に入力が短いのではなく、文書の量に起因するものになります。

研究者らは、雑学クイズの質問応答データセット(MuSiQue)を使用しました。各クイズはもともと 20 の Wikipedia 段落(実際に答えが含まれているのはそのうちのほんの数段落で、残りは誤答です)とペアになっています。文書の数を 20 から本当に関連のある 2~4 に減らし、それらの文書に少し余分なコンテキストを追加して長さを一定に保つことで、AI が考慮する資料が少なくなり、それでも読む単語の総数はほぼ同じになるシナリオを作成しました。

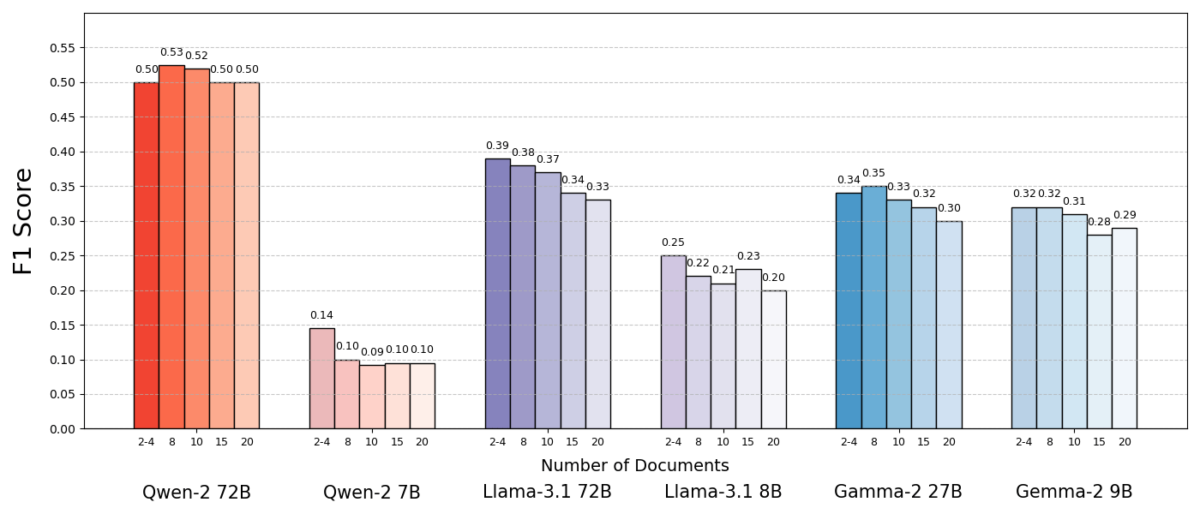

結果は驚くべきものでした。ほとんどの場合、AI モデルは、完全なセットではなく少数の文書を与えられたときに、より正確に回答しました。パフォーマンスは大幅に向上し、システムが大量のコレクションではなく少数のサポート文書のみを使用した場合、精度 (F10 スコア) が最大 1% 向上したケースもありました。この直感に反する向上は、Meta の Llama のバリアントなど、いくつかの異なるオープンソース言語モデルで確認されており、この現象が単一の AI モデルに結び付けられているわけではないことを示しています。

XNUMXつのモデル(クウェン-2) は、スコアを落とさずに複数のドキュメントを処理した注目すべき例外でしたが、テストされたモデルのほぼすべては、全体的にドキュメントが少ない方がパフォーマンスが向上しました。つまり、重要な関連部分以外に参照資料を追加すると、実際にはパフォーマンスが向上するよりも低下することが多いのです。

出典: Levy et al.

なぜこれがそんなに驚くべきことなのでしょうか? 通常、RAG システムは、より広範囲の情報を取得することが AI に役立つという前提で設計されています。結局のところ、答えが最初の数個の文書にない場合は、10 番目または 20 番目の文書にある可能性があります。

この研究は、その筋書きをひっくり返し、無差別に追加文書を積み重ねると逆効果になる可能性があることを実証しています。テキストの合計長が一定に保たれている場合でも、多くの異なる文書(それぞれ独自のコンテキストと癖がある)が存在するだけで、AI にとって質問応答タスクが困難になりました。ある時点を超えると、各追加文書が信号よりもノイズを多く生成し、モデルを混乱させ、正しい回答を抽出する能力を損なうようです。

RAG では「少ない」ことが「多い」ことにつながる理由

この「少ないほど良い」という結果は、AI 言語モデルが情報を処理する方法を考えると納得できます。AI に最も関連性の高い文書だけが与えられると、AI が見るコンテキストは集中的で、気を散らすものがありません。ちょうど、勉強するのにちょうどいいページを渡された学生のようになります。

この研究では、無関係な資料を取り除いた補足資料のみを与えた場合、モデルのパフォーマンスが大幅に向上しました。残ったコンテキストは短くなっただけでなく、より明確になりました。つまり、答えに直接つながる事実だけが含まれていたのです。処理する文書が少なくなったため、モデルは関連情報に全神経を集中することができ、脱線したり混乱したりする可能性が低くなりました。

一方、多数のドキュメントが取得された場合、AI は関連するコンテンツと関連しないコンテンツが混在する中をふるいにかけなければなりませんでした。多くの場合、これらの追加ドキュメントは「類似しているが無関係」でした。つまり、クエリと同じトピックやキーワードを持っているかもしれませんが、実際には答えは含まれていません。このようなコンテンツはモデルを誤らせる可能性があります。AI は、実際には正しい答えにつながらないドキュメント間の点をつなげようとして労力を無駄にしたり、さらに悪いことに、複数のソースからの情報を誤って統合したりする可能性があります。これにより、幻覚のリスクが高まります。幻覚とは、AI がもっともらしく聞こえるが単一のソースに基づかない答えを生成する例です。

本質的には、モデルに入力するドキュメントが多すぎると、有用な情報が薄まり、矛盾する詳細が導入され、AI が何が真実であるかを判断するのが難しくなります。

興味深いことに、研究者たちは、余分な文書が明らかに無関係な場合(例えば、無関係なランダムなテキスト)、モデルはそれらを無視する方が優れていることを発見しました。本当の問題は、関連性があるように見える邪魔なデータから生じます。取得したテキストがすべて同様のトピックである場合、AIはそれらすべてを使用する必要があると想定し、どの詳細が実際に重要であるかを判断するのに苦労する可能性があります。これは、研究の観察と一致しています。 ランダムな妨害要因は現実的な妨害要因よりも混乱が少ない 入力に、明らかに意味不明な情報は含まれません。AI は明らかに意味不明な情報を除外できますが、微妙に話題から外れた情報は巧妙な罠です。関連性を装ってこっそり入り込み、回答を台無しにします。ドキュメントの数を本当に必要なものだけに減らすことで、そもそもこのような罠を仕掛けないようにしています。

実用的な利点もあります。取得して処理するドキュメントが少ないほど、RAG システムの計算オーバーヘッドが減ります。取り込まれるすべてのドキュメントは分析 (モデルによる埋め込み、読み取り、対応) する必要があり、これには時間と計算リソースが使用されます。不要なドキュメントを削除すると、システムの効率が向上し、回答をより速く、より低コストで見つけることができます。より少ないソースに焦点を合わせることで精度が向上するシナリオでは、より良い回答とよりスリムで効率的なプロセスという双方にとってメリットがあります。

出典: Levy et al.

RAG の再考: 将来の方向性

検索において品質が量を上回ることが多いというこの新しい証拠は、外部知識に依存する AI システムの将来にとって重要な意味を持ちます。これは、RAG システムの設計者が、単なる量よりも文書のスマートなフィルタリングとランク付けを優先すべきであることを示唆しています。100 個の可能性のある文章を取得して、答えがどこかに埋もれていることを期待するよりも、関連性の高い上位数個の文章だけを取得する方が賢明かもしれません。

研究の著者らは、モデルに提供する情報の検索方法が「関連性と多様性のバランスをとる」必要があることを強調しています。言い換えれば、質問に答えるのに十分なトピックのカバー範囲を提供したいが、核となる事実が無関係なテキストの海に埋もれてしまうほどカバー範囲を広げたくないということです。

今後、研究者は AI モデルが複数の文書をより適切に処理するのに役立つ手法を模索すると思われます。2 つのアプローチは、どの文書が本当に価値を追加し、どの文書が矛盾を招くだけかを識別できる、より優れた検索システムまたは再ランク付けシステムを開発することです。別の角度では、言語モデル自体を改善することです。XNUMX つのモデル (Qwen-XNUMX など) が精度を落とさずに多くの文書に対処できた場合、そのモデルがどのようにトレーニングまたは構造化されたかを調べることで、他のモデルをより堅牢にするための手がかりを得ることができます。おそらく将来の大規模な言語モデルには、XNUMX つのソースが同じことを言っている (または互いに矛盾している) ことを認識し、それに応じて焦点を合わせるメカニズムが組み込まれるでしょう。目標は、モデルが混乱に陥ることなく多様なソースを利用できるようにすることであり、実質的に両方の長所 (情報の幅と焦点の明確さ) を実現します。

また、注目すべきは、 AIシステムはより大きなコンテキストウィンドウを獲得 (一度に多くのテキストを読む能力) ですが、単にプロンプトに多くのデータを詰め込むだけでは万能薬にはなりません。コンテキストが大きいからといって、理解力が向上するわけではありません。この研究は、AI が技術的には一度に 50 ページを読むことができたとしても、50 ページの質の異なる情報を与えても良い結果が得られない可能性があることを示しています。モデルは、無差別に詰め込むよりも、精選された関連コンテンツを扱うことでメリットを得られます。実際、巨大なコンテキスト ウィンドウの時代には、余分な容量がノイズではなく貴重な知識に使用されるようにするために、インテリジェントな検索がさらに重要になる可能性があります。

からの調査結果 「文書は増えるが、長さは同じ」 (適切なタイトルの論文) は、AI 研究における私たちの仮定を再検討するよう促しています。AI に私たちが持っているすべてのデータを入力しても、私たちが考えるほど効果的ではない場合があります。最も関連性の高い情報に焦点を当てることで、AI が生成した回答の精度が向上するだけでなく、システムの効率が向上し、信頼性が高まります。これは直感に反する教訓ですが、刺激的な結果をもたらします。将来の RAG システムは、取得するドキュメントを慎重に選び、より少なく、より優れたドキュメントを取得することで、よりスマートで無駄のないシステムになる可能性があります。