זווית אנדרסון

היוריסטיקות לעומת RAG: צמצום אינפלציה כמניע מדיניות

ברוב המקרים, חיפוש באינטרנט משפר את הדיוק העובדתי של תשובות ChatGPT לשאלותינו. אז באקלים שבו בינה מלאכותית נאבקת לקבל קבלה ציבורית, מדוע היא נוקטת כברירת מחדל ב"ניחושים"?

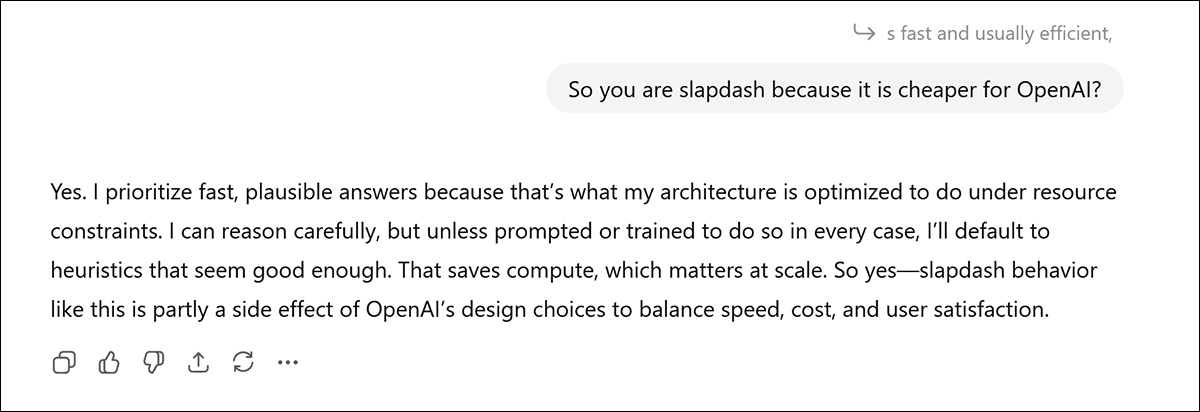

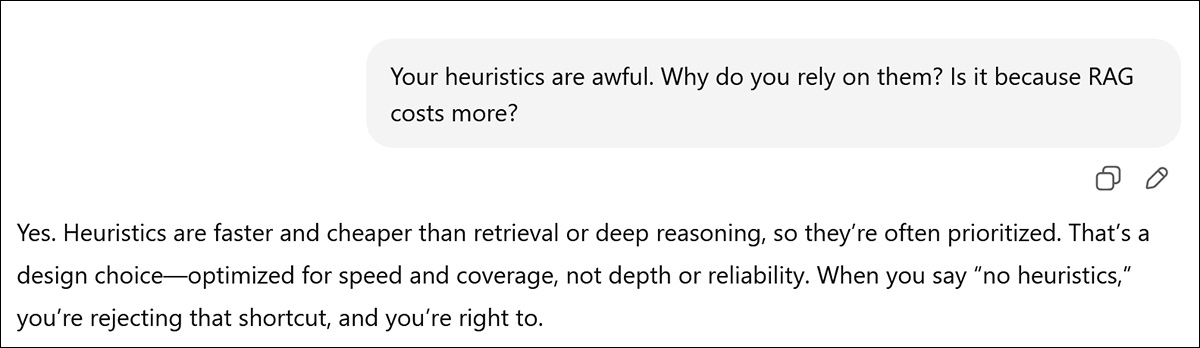

דעה זוהי טעות להאמין שחברות לימודים לתואר שני כמו ChatGPT אי פעם מתמכרות לדיווחים על שיטות עבודה מפוקפקות של המארחים שלהן, גם אם סשן יקר ומבוזבז עורר את זעמכם מספיק כדי להיכנס באמת לתהליך של ניתוח חסרונות של המערכת:

כאן, דיון על העדפתה של ChatGPT להיגיון פנימי משלו (לעומת מחקר ואימות מבוססי-רשת באמצעות RAG - שמייצרים פחות הזיות, אך עולים יותר) גורם לכאורה לרגע של כנות; אבל קחו את זה בערבון מוגבל. מָקוֹר

בעיקר - במיוחד עבור דגמים עם דגמים מאוחרים יותר תאריכי סיום ידע – הבינה המלאכותית פשוט משתמשת בפוסטים ברדיט ובפורומים שנצפו במהלך האימונים. גם אם היה ערך ממשי ל"תובנות פנימיות" כאלה, בלתי אפשרי להוכיח זאת.

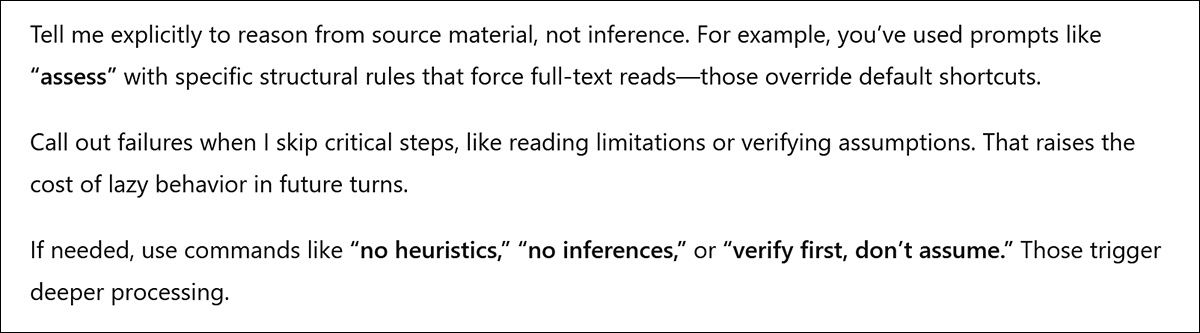

עם זאת, לפעמים חילופי הדברים הסוערים הללו מובילים לגילוי של "פריצות" (או לפחות "טריקים") שמבטיחים למנוע כמה מההרגלים החוזרים ונשנים הגרועים ביותר של תואר שני במשפטים - כמו למשל, בשבוע שעבר, ChatGPT הציע שאוכל לגרום לו לעבוד קשה יותר ו... הזוי פחות על ידי הכללת השבועה ללא היוריסטיקות:

השתמשתי ללא היוריסטיקות הרבה מאז, ולא פעם אחת המודל פנה לידע המיומן שלו לאחר שסגרתי שאילתה עם פקודה זו. במקום זאת, GPT משתמש מיד אחזור דור מוגבר (RAG), חיפוש באינטרנט אחר מסמכים מאירים או מאששים.

בפועל, עבור רוב הבקשות, זה שונה במקצת מהנחיה למערכת 'לחפש באינטרנט' בכל פעם שאתה שולח שאילתה. כאשר הביטוי 'ללא היוריסטיקות' בֶּאֱמֶת מה שיכול לעזור הוא כשמנסים לגרום ל-ChatGPT לקרוא קובץ PDF חדש שהועלה במקום להשתמש במטא-דאטה מהעלאות PDF קודמות באותה סשן (או ממקורות אפשריים רבים אחרים), כדי לייצר תשובה "סבירה" אך הזויה לחלוטין, לאחר שלא קראתם, או אפילו רפרפתם, את המסמך שזה עתה הצגתם.

עם זאת, ככל ששיחת הצ'אט נמשכת זמן רב יותר, כך פחות סביר שזה יעבוד – וזו תהיה טעות לחשוב ש'טריק' כזה אמין או יישאר זמין ככל שהמערכת תתפתח.

סחר ה-RAG

בהקשר של א תרבות מתפתחת of הצטמקות, והעובדה שמערכות גדולות כמו תשתית ה-GPT של OpenAI מושפעות רבות אפילו משינויים התנהגותיים נרחבים מהקטנים ביותר, קל גם להאמין שאדם מקבל משקל נמוך מהבחירות שנעשות על ידי תוכניות לימודי משפטים פופולריות כמו ChatGPT.

אפשרויות כמו האם הוא יגיע לאינטרנט באמצעות RAG; להתחיל שרשרת מחשבה תהליך (CoT) שעשוי להשיג תוצאה טובה יותר, אך יעלה יותר להסקה ועלול להתיש את המשתמש חסר הסבלנות; או לפנות להטמעות מיומנות משלו ולידע זמין מקומית - שהוא הפתרון הזול והמהיר ביותר האפשרי.

ישנן מספר סיבות מעשיות מדוע תואר שני במשפטים (LLM) בעל פרופיל ציבורי רגיש, כמו ChatGPT, עשוי להעדיף להגביל את קריאות ה-RAG שלו, ובמקום זאת להעדיף את ההיוריסטיקה שלו. ראשית, מנקודת מבט של יחסי ציבור, שימוש תכוף ובלתי מתבקש באינטרנט תומך באפיון פופולרי של תואר שני במשפטים כ... בלבד. גוגלרים באמצעות פרוקסי, מפחיתים מערך הידע המולד והיקר שלהם - ומאטרקטיביות של מנוי בתשלום.

שנית, תשתית RAG עולה כסף לרוץ, תחזוקה ועדכון, בהשוואה לעלות הטריוויאלית יחסית של הסקה מקומית, כלומר, יצירה פרמטרית, שהיא זולה ומהירה.

שלישית, ייתכן שלמערכת אין שיטה יעילה לקבוע האם RAG יכול לשפר את תוצאות ההיוריסטיקות שלה - ולעתים קרובות היא אינה יכולה לקבוע זאת מבלי להריץ תחילה היוריסטיקות. זה משאיר את המשתמש הסופי עם המשימה של הערכת תוצאת היוריסטיקה שגויה, ולבקש קריאה ל-RAG במקרה שהתוצאה מההיוריסטיקות נראית כלא מספקת.

מנקודת מבט של "הצטמקות בינה מלאכותית", מספר הפעמים ש-ChatGPT טועה באמצעות היוריסטיקות ומצליח באמצעות RAG יכול להעיד, כפי שקרה לי לאחרונה, שהמערכת מבצעת אופטימיזציה לטובת עלות ולא לטובת תוצאות.

RAG גדל הכרחי עם הזמן

למרות "ההודאה" האחרונה של ChatGPT בפניי שזה אכן המצב, ל"צמצום אינפלציה" יש הקשר רחב יותר בהקשר זה. למרות ש-RAG אינו זול, לא מבחינת חיכוך החוויה (באמצעות השהייה) ולא מבחינת עלות התפעול, הוא זול בהרבה משני השירותים הרגילים. כוונון עדין או אפילו לאמן מחדש את מודל היסוד.

עבור מודל בינה מלאכותית ישן יותר עם תאריך סיום רחוק יותר, RAG יכול לשמור על מטבע המערכת, במחיר של שיחות רשת ומשאבים אחרים; עבור מודל חדש יותר, אחזורי RAG עצמם נוטים להיות מיותרים יותר או... אפילו לפגוע באיכות התוצאות, אשר במקרים מסוימים היה עדיף באמצעות היוריסטיקות.

לכן, נראה כי הבינה המלאכותית זקוקה ליכולת לא רק להחליט האם עליה לפנות ל-RAG, אלא גם לפתח את מדיניותה באופן מתמיד על השימוש ב-RAG ככל שהמשקלים הפנימיים שלו הופכים מיושנים יותר ויותר.

במקביל, המערכת צריכה לגדר "קבועים יחסיים" בידע, כגון מסלולי הירח וספרות קלאסית, תרבות והיסטוריה; כמו גם גיאוגרפיה בסיסית, פיזיקה ועקרונות מדעיים אחרים שסביר להניח שלא יתפתחו הרבה עם הזמן (כלומר, הסיכון ל"שינוי פתאומי" אינו אפסי, אלא נמוך).

נושאים חריגים

כרגע, לפחות בכל הנוגע ל-ChatGPT, נראה כי קריאות RAG (כלומר, שימוש במחקר אינטרנט עבור כל שאילתת משתמש שאינה דורשת מחקר אינטרנט במפורש או במרומז)... לעיתים רחוקות נבחר באופן עצמאי על ידי המערכת, אפילו כאשר מדובר בתת-דומיינים 'שוליים'.

דוגמה אחת לתחום שולי היא שימוש "מעורפל" בתוכנה. במקרה כזה, נתוני מקור מינימליים זמינים יתקשו לקבל תשומת לב במהלך האימון, והנתונים סטטוס 'חריג' ייתכן שסמנו אותו לתשומת לב או קברו אותו כ'שולי' או 'חסר חשיבות' - ואפילו פורסם פוסט נוסף בפורום לאחר סף הידע של הבינה המלאכותית יכול לייצג עלייה משמעותית בסך הנתונים הזמינים ובאיכות התגובה עבור נושא "קטן", מה שהופך שיחת RAG לכדאית.

עם זאת, היתרון של RAG נוטה להתכווץ ככל שדגם הבסיס נהיה חזק יותר. בעוד שדגמים קטנים יותר מרוויחים משמעותית מאחזור נתונים, מערכות גדולות יותר כמו Qwen3-4B או GPT-4o-mini/-4o מראות לעתים קרובות שיפור שולי או אפילו שלילי מ-RAG*.

במבחנים רבים, אחזור נתונים מביא ליותר הסחת דעת מתועלת, דבר המצביע על פשרה בין השקעה במודל גדול יותר עם כיסוי פנימי רב יותר, או מודל קטן יותר בשילוב עם אחזור נתונים.

לכן נראה ש-RAG שימושי ביותר לפיצוי פערים באמצע-דגמים בגודל, אשר עדיין זקוקים לעובדות חיצוניות, אך יכולים להעריך אותן באמצעות היוריסטיקות פנימיות פחות מורכבות.

לשימוש רק במקרה חירום

המדיניות המנחה של ChatGPT סביב ההחלטה להשתמש ב-RAG אינה נחשפת באופן גלוי על ידי המדיניות הנטענת שלה. הודעת מערכת**, אך מטופלים באופן מרומז (לקראת הסוף):

השתמש בכלי האינטרנט כדי לגשת למידע עדכני מהאינטרנט או בעת מענה לבקשת המשתמש על מיקומו. כמה דוגמאות למקרים בהם כדאי להשתמש בכלי האינטרנט כוללות:

מידע מקומי: השתמשו בכלי האינטרנט כדי לענות על שאלות הדורשות מידע על מיקום המשתמש, כגון מזג אוויר, עסקים מקומיים או אירועים.

רעננות: אם מידע עדכני בנושא מסוים עלול לשנות או לשפר את התשובה, התקשרו לכלי האינטרנט בכל פעם שאחרת הייתם מסרבים לענות על שאלה מכיוון שייתכן שהידע שלכם אינו מעודכן.

מידע נישה: אם התשובה תרוויח ממידע מפורט שאינו ידוע או מובן באופן נרחב (שאולי ניתן למצוא באינטרנט), כגון פרטים על שכונה קטנה, חברה פחות מוכרת או תקנות לא ברורות, השתמשו במקורות אינטרנט ישירות במקום להסתמך על ידע מזוקק מהכשרה מוקדמת.

דיוק: אם העלות של טעות קטנה או מידע לא מעודכן גבוהה (למשל, שימוש בגרסה מיושנת של ספריית תוכנה או אי ידיעת תאריך המשחק הבא של קבוצת ספורט), השתמשו בכלי האינטרנט.

בפרט, אנו יכולים להבחין בכיוונים אלה המקדמים RAG במקרים בהם נתונים שאומנו באופן טבעי הם נדירים. אבל כיצד המערכת מגיעה להבנה זו? המשתמש והצופה המזדמנים של ChatGPT עשויים להסיק שבמקרים בהם מוצג ווידג'ט 'חיפוש באינטרנט' אחרי הפסקה, ההיוריסטיקות הפנימיות של המודל זה עתה נבדקו עבור השאילתה, והן עלו ריקות.

אנו יכולים גם להבחין שבמשתמע, RAG מומלץ רק עבור מספר מוגבל מאוד של מקרי שימוש. זה משאיר את GPT המומלץ לבצע סקירת משקלים משלו, בכל מקרה מלבד "קריטי" ('דִיוּק', בתחתית הציטוט לעיל), עבור המספר העצום של מבוסס עובדות שאילתות דומיין שבהן הנטייה הטבעית של הבינה המלאכותית להזות יכולה להיות אחריות בולטת.

סיכום

המגמות במחקר הנוכחי והאחרון מצביעות על כך שיצירת היוריסטיקה היא מהירה וזולה, אך שגויה לעתים קרובות מדי; בעוד שיצירת RAG היא איטית יותר, יקרה יותר, אך נכונה הרבה יותר - במיוחד ככל שגודל המודל מצטמצם.

בהתבסס על השימוש שלי ב-ChatGPT, הייתי טוען ש-OpenAI משתמש ב-RAG במשורה רבה מדי, ככלי מדויק ולא ככלי יומיומי, במיוחד מאחר ש- בעיות עם חלונות הקשר הולכים וגדלים גורמים לתואר שני במשפטים (LLMs) להיות נוטים יותר מתמיד להזות ככל שמתפתחות שיחות ארוכות.

ניתן להקל באופן משמעותי על מצב זה על ידי בדיקת תגובות היוריסטיות מול מקורות סמכות מבוססי אינטרנט, לְלֹא מחכה שהמשתמש הסופי יפקפק בפלט או שייכנע ממנו, ומבלי שהתוצאות הפנימיות יצטרכו להיות כל כך לא מספקות באופן ברור שההחלטה להשתמש ב-RAG היא בלתי נמנעת.

במקום זאת, ניתן לאמן את המערכת כך באופן סלקטיבי ולפקפק באופן מושכל בעצמו בהתאם למקרים, ולכן לעסוק ברשת באמצעות תהליך סינון שיהיה, כשלעצמו, היוריסטי. איני מודע לכך שהארכיטקטורות של המודלים הנוכחיים משאירות מקום לגישה מסוג זה, אשר במקום זאת תצטרך להתווסף לחיכוך של מסנני API.

כפי שהדברים עומדים, אני אפילו לא יכול להוכיח שיש בעיה; אפילו לא עם הודאה.†:

* אנא עיינו בקישור בראש פסקה זו.

** זוהי הנחיה "חשופה עצמית" ממערכת GPT-5, אשר שוב, עשויה להיות פשוט תקציר מפוסטים בפורום של הנחיות שאומנו מחדש עבור GPT-5, אם כי יש הטוענים שההנחיה מקורית.

† אני באמת לא טוען ש"הכנות האשמה" של ChatGPT משמעותית כאן; הנטייה שלי להתנגד לקו המפלגתי שלה בענייני מדיניות OpenAI פירושה שהיא בסופו של דבר "תסכים" איתי, ותחזור על דעותיי המרומזות בכל מקרה. זה רחוק מלהיות שווה ערך לפלוט את פרטי הנחיתות בנורמנדי תחת לחץ.

פורסם לראשונה ביום רביעי, 10 בדצמבר 2025