זווית אנדרסון

וידאו AI משכלל את הסלפי של החתול

מחוללי וידאו מבוססי בינה מלאכותית נותנים לעתים קרובות תוצאות קרובות, אך ללא ספק, מבחינת אספקת מה שכתובת הטקסט שלכם רצתה. אבל תיקון חדש ברמה גבוהה עושה את כל ההבדל.

מערכות וידאו גנרטיביות מתקשות לעיתים קרובות ליצור סרטונים יצירתיים או פרועים באמת, ולעתים קרובות אינן עומדות בציפיות של הנחיות הטקסט של המשתמש.

חלק מהסיבה לכך היא הסתבכות – העובדה שמודלים של חזון/שפה צריכים להתפשר על משך הזמן שהם מאמנים על נתוני המקור שלהם. מעט מדי אימון, והמושגים גמישים, אך אינם מפותחים במלואם – יותר מדי אימון, והמושגים מדויקים, אך אינם גמישים מספיק כדי לשלב אותם בשילובים חדשים.

תוכלו לקבל את הרעיון מהסרטון המוטמע למטה. משמאל נמצאת פשרה מסוג "אמצע הדרך" שמערכות בינה מלאכותית רבות מספקות בתגובה להנחיה תובענית (ההנחיה נמצאת בראש הסרטון בכל ארבע הדוגמאות) שמבקשת הצבת אלמנטים סמוכים שהיא פנטסטית מדי מכדי להיות דוגמת אימון אמיתית. מימין, נמצא פלט בינה מלאכותית שדבק בהנחיה בצורה טובה בהרבה:

לחץ להפעלה (ללא אודיו). מימין, אנו רואים את WAN 2.2 'מעובד' שבאמת מספק את ההנחיות, בהשוואה לפרשנויות המעורפלות של WAN 2.2 'ונילה', משמאל. אנא עיינו בקבצי הווידאו המקוריים לקבלת רזולוציה טובה יותר ודוגמאות רבות נוספות, אם כי הגרסאות המאוגדות המוצגות כאן אינן קיימות באתר הפרויקט, והן הורכבו עבור מאמר זה. מָקוֹר

ובכן, למרות שעלינו לסלוח לידיים האנושיות של הברווז המוחא כפיים (!), ברור שהדוגמאות מימין דבקות בטקסט המקורי הרבה יותר טוב מאלה משמאל.

מעניין לציין, ששתי הארכיטקטורות המוצגות הן למעשה ה- אותו אדריכלות – הפופולרית והמוכשרת מאוד וואן 2.2, מהדורה סינית שצברה תאוצה משמעותית בקהילות הקוד הפתוח והחובבים השנה.

ההבדל הוא שהצינור הגנרטיבי השני הוא מחולק לגורמים, שבמקרה זה אומר שמודל שפה גדול (LLM) שימש לפירוש מחדש של הפריים הראשון (הפריים) של הסרטון, כך שיהיה קל הרבה יותר למערכת לספק את מה שהמשתמש מבקש.

"עיגון חזותי" זה כרוך בהזרקת תמונה שנוצרה מהנחיה משופרת LLM זו לתוך הצינור היצירתי כ"מסגרת התחלה", ושימוש ב... LoRA מודל פרשני שיסייע בשילוב פריים ה"פולש" בתהליך יצירת הסרטון.

התוצאות, מבחינת דיוק מהיר, הן די יוצאות דופן, במיוחד עבור פתרון שנראה אלגנטי למדי:

לחץ להפעלה (ללא אודיו). דוגמאות נוספות של יצירת וידאו 'מחולק לגורמים' שדבקה באמת בתסריט. אנא עיינו בקבצי הווידאו המקוריים לקבלת רזולוציה טובה יותר ודוגמאות רבות נוספות, אם כי הגרסאות המאוגדות המוצגות כאן אינן קיימות באתר הפרויקט, והן הורכבו עבור מאמר זה.

פתרון זה מגיע בצורה של ה- מאמר חדש יצירת וידאו מגורם לגורמים: ניתוק בניית סצנות וסינתזה זמנית במודלים של דיפוזיה של טקסט לווידאו, והסרטונים הנלווים אליו אתר הפרויקט.

בעוד שמערכות רבות כיום מנסות לשפר את הדיוק המהיר באמצעות מודלים של שפה כדי לכתוב מחדש טקסט מעורפל או לא מוגדר מספיק, העבודה החדשה טוענת שאסטרטגיה זו עדיין מובילה לכישלון כאשר המודל... ייצוג סצנה פנימי פגום.

אפילו עם הנחיה מפורטת שנכתבה מחדש, מודלים של טקסט-לסרטון לעיתים קרובות מרכיבים אלמנטים מרכזיים בצורה שגויה או יוצרים מצבים התחלתיים לא תואמים ששוברים את ההיגיון של האנימציה. כל עוד הפריים הראשון אינו משקף את מה שההנחיה מתארת, הסרטון המתקבל לא יוכל להתאושש, ללא קשר לרמת איכות מודל התנועה.

העיתון קובע*:

מודלים [מטקסט לווידאו] מייצרים לעתים קרובות פריימים בעלי שינוי חלוקה, אך עדיין משיגים [ציוני הערכה] דומים למודלים של I2V, דבר המצביע על כך. מידול התנועה שלהם נשאר טבעי למדי גם כאשר נאמנות הסצנה ירודה יחסית.

מודלים [תמונה-לוידאו] מציגים התנהגות משלימה, [ציוני הערכה] חזקים מסצנות ראשוניות מדויקות וקוהרנטיות זמנית חלשה יותר, בעוד שמודלים של I2V+טקסט מאזנים את שני ההיבטים.

ניגוד זה מרמז על אי התאמה מבנית במודלים הנוכחיים של T2Vבסיס סצנה וסינתזה זמנית נהנים מהטיות אינדוקטיביות שונות, אך ארכיטקטורות קיימות מנסות ללמוד את שתיהן בו זמנית בתוך מודל יחיד.

השוואה אבחנתית של מצבי יצירה מצאה שמודלים ללא עיגון סצנה מפורש הציגו ציון טוב בתנועה, אך לעתים קרובות התפשרו על פריסת הסצנה, בעוד שגישות מותנות תמונה הראו את הדפוס ההפוך:

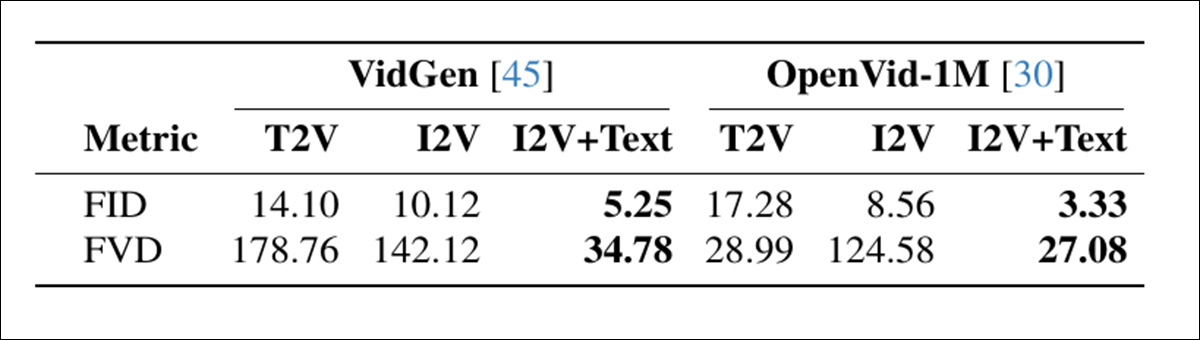

השוואה בין מצבי יצירת וידאו על שני מערכי נתונים, המראה ש-I2V+טקסט משיג את איכות הפריימים (FID) והקוהרנטיות הזמנית (FVD) הטובות ביותר, תוך הדגשת היתרון של הפרדת בניית הסצנה מתנועה. מָקוֹר

ממצאים אלה מצביעים על פגם מבני שבו מודלים עכשוויים מנסים ללמוד גם פריסת סצנות וגם אנימציה בבת אחת, למרות ששתי המשימות דורשות סוגים שונים של... הטיה אינדוקטיבית, ועדיף לטפל בהם בנפרד.

אולי מעניין במיוחד ש"טריק" זה יכול להיות מיושם באופן פוטנציאלי על התקנות מקומיות של מודלים כמו Wan 2.1 ו-2.2, ומודלים דומים של דיפוזיה של וידאו כמו סרטון הוניואןבאופן אנקדוטי, בהשוואה לאיכות התפוקה של חובבים לפורטלים מסחריים גנרטיביים כמו Kling ו-Runway, רוב ספקי ה-API הגדולים משפרים הצעות קוד פתוח כמו WAN עם LoRAs, ונראה גם עם טריקים מהסוג שנראה במאמר החדש. לכן, גישה ספציפית זו עשויה לייצג השלמת פער עבור נציגי FOSS.

בדיקות שבוצעו עבור השיטה מצביעות על כך שגישה פשוטה ומודולרית זו מציעה שדרוג חדש בתחום מדד T2V-CompBench, מה שמשפר משמעותית את כל המודלים שנבדקו. המחברים מציינים לסיכום כי בעוד שהמערכת שלהם משפרת באופן דרסטי את האמינות, היא אינה מטפלת (וגם לא נועדה לטפל) סחף זהות, כיום מקללת המחקר של בינה מלאכותית גנרטיבית.

המאמר החדש מגיע מארבעה חוקרים ב- Ecole Polytechnique Fédérale de Lausanne (EPFL) בשוויץ.

שיטה ונתונים

ההצעה המרכזית של הטכניקה החדשה היא שמודלים של דיפוזיה מטקסט לווידאו (T2V) צריכים להיות "מעוגנים" למסגרות התחלה שמתאימות באמת להנחיית הטקסט הרצויה.

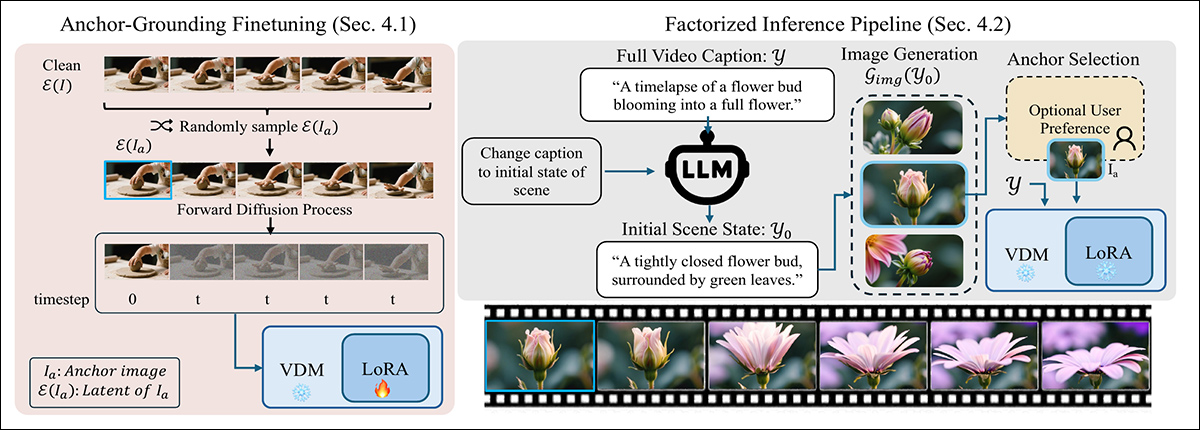

כדי להבטיח שהמודל יכבד את מסגרת ההתחלה, השיטה החדשה משבשת את תהליך דיפוזיה סטנדרטי על ידי הזרקת חומר נקי סמוי מתמונת העוגן בשלב זמן אפס, מחליף אחד מהקלטים הרועשים הרגילים. קלט לא מוכר זה מבלבל את המודל בהתחלה, אך עם LoRA מינימלי כוונון עדין, הוא לומד להתייחס למסגרת המוזרקת כעוגן ויזואלי קבוע ולא כחלק ממסלול הרעש:

שיטה דו-שלבית לביסוס יצירת טקסט-לסרטון עם עוגן חזותי: משמאל, המודל מכוון עדין באמצעות LoRA קל משקל כדי לטפל בלטנט נקי מוזרק כאלוץ סצנה קבוע. מימין, ההנחיה מפוצלת לכיתוב של הפריים הראשון, המשמש ליצירת תמונת העוגן המנחה את הסרטון.

בהסקה, המתודה כותבת מחדש את ההנחיה כדי לתאר רק הפריים הראשון, באמצעות LLM כדי לחלץ מצב סצנה התחלתי סביר המתמקד בפריסה ובמראה.

הנחיה זו, שנכתבה מחדש, מועברת למחולל תמונות כדי לייצר מסגרת עוגן מועמדת (אותה המשתמש יכול לשפר באופן אופציונלי). המסגרת שנבחרה מקודדת למסגרת סמוי ומוזרקת לתהליך הדיפוזיה על ידי החלפת שלב הזמן הראשון, מה שמאפשר למודל לייצר את שאר הסרטון. תוך שמירה על עוגן לסצנה הראשונית – תהליך שפועל מבלי לדרוש שינויים בארכיטקטורה הבסיסית.

התהליך נבדק על ידי יצירת LoRAs עבור Wan2.2-14B, Wan2.1-1B, ו CogVideo1.5-5Bהכשרת LoRA נערכה ב- לדרג מתוך 256, על 5000 קליפים שנדגמו באופן אקראי מה- אולטרה-וידאו אוסף.

האימון נמשך 6000 צעדים, ודרש 48 שעות GPU† עבור Wan-1B ו-CogVideo-5B, ו-96 שעות GPU עבור Wan-14B. המחברים מציינים ש-Wan-5B תומך באופן טבעי בטקסט בלבד ובטקסט-תמונה (שבמקרה זה מוכנסים למסגרות הישנות יותר), ולכן לא דרש כוונון עדין כלשהו.

בדיקות

בניסויים שבוצעו עבור התהליך, כל הנחיית טקסט עברה תחילה חידוד באמצעות Qwen2.5-7B-Instruct, אשר השתמשה בתוצאה כדי ליצור כיתוב מפורט של 'תמונת זרע' המכיל תיאור של הסצנה כולה. לאחר מכן, תיאור זה הועבר אל תמונה של קווין, אשר הוטל עליה ליצור את 'מסגרת הקסם' שתוחדר לתהליך הדיפוזיה.

מדדי הייחוס ששימשו להערכת המערכת כללו את T2V-CompBench שהוזכר לעיל, לבדיקת הבנת קומפוזיציה על ידי ציון עד כמה המודלים שימרו אובייקטים, תכונות ופעולות בתוך סצנה קוהרנטית; ו- VBench 2.0, להערכת נימוקים רחבים יותר ועקביות על פני 18 מדדים, המקובצים ל יצירתיות, היגיון בריא, יכולת שליטה, נאמנות אנושית, ו פיסיקה:

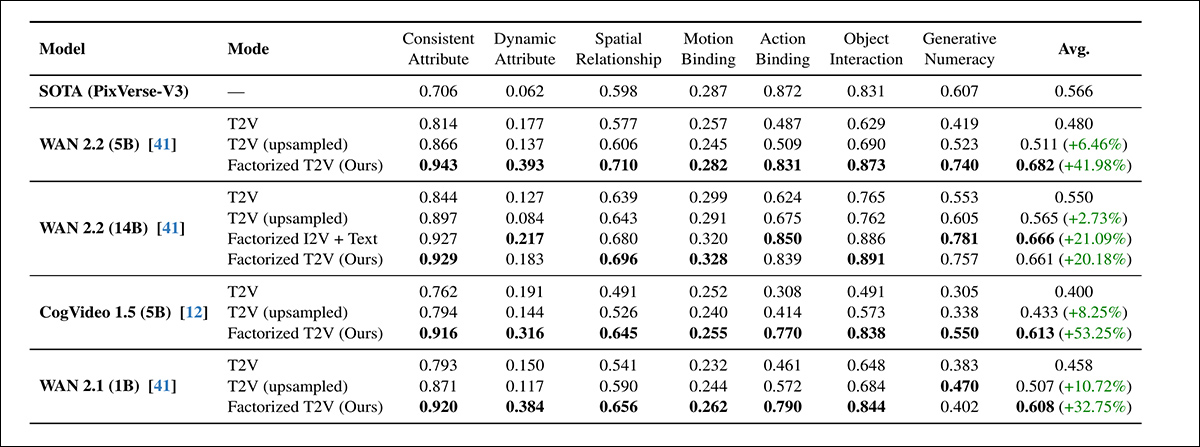

בכל שבע קטגוריות ההערכה של T2V-CompBench, שיטת T2V המעובדת לגורמים עלתה על ערכי הבסיס של T2V הסטנדרטיים והמודלמים עבור כל דגם שנבדק, עם רווחים שהגיעו עד 53.25%. הגרסאות בעלות הציון הגבוה ביותר תאמו או עלו לעתים קרובות על מדד הייחוס הקנייני PixVerse-V3.

בנוגע לסבב הבדיקות הראשוני הזה, המחברים מציינים*:

בכל המודלים, הוספת תמונת עוגן משפרת באופן עקבי את ביצועי הקומפוזיציה. כל המודלים הקטנים יותר שעברו פירוק גורמים (CogVideo 5B, Wan 5B ו-Wan 1B) מציגים ביצועים טובים יותר מדגם Wan 14B T2V הגדול יותר.

"ה-Wan 5B המעובד שלנו גם עולה בביצועיו על מודל הבסיס המסחרי של PixVerse-V3, שהוא המודל המדווח הטוב ביותר במבחן הייחוס. זה מדגים כי בסיס חזותי משפר באופן משמעותי את הבנת הסצנה והפעולה אפילו במודלים בעלי קיבולת קטנה יותר.

"בתוך כל משפחת דגמים, הגרסה המעובדת עולה על הביצועים של המודל המקורי. ראוי לציין כי ה-LoRA הקל שלנו, המקורקע בעוגן, על WAN 14B מגיע לביצועים דומים לגרסת ה-I2V 14B המאומנת מראש (0.661 לעומת 0.666), למרות שאינה דורשת אימון מחדש מלא."

לאחר מכן הגיע סבב VBench2.0:

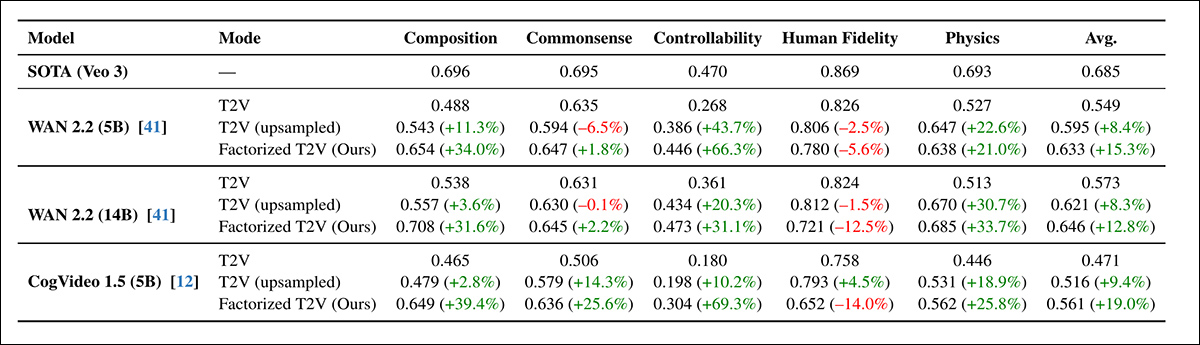

גישת T2V המחולקת לגורמים שיפרה באופן עקבי את ביצועי VBench 2.0 בתחומי הקומפוזיציה, הנמקה, יכולת הבקרה והפיזיקה, עם שיפורים מסוימים העולים על 60% - אם כי נאמנות המשתמש נותרה מתחת לקו הבסיס הקנייני של Veo 3.

בכל הארכיטקטורות, הגישה המחולקת לגורמים העלתה את הציונים בכל קטגוריית VBench מלבד נאמנות אנושית, אשר ירדה מעט אפילו עם דגימה מהירה. WAN 5B עלה בביצועיו על WAN 14B הגדול יותר, מה שחיזק את תוצאות T2V-CompBench הקודמות לפיהם הארקה חזותית תרמה יותר מקנה המידה.

בעוד שהשיפורים ב-VBench היו עקביים, הם היו קטנים יותר מאלה שנצפו ב-T2V-CompBench, והמחברים מייחסים זאת למשטר הניקוד הבינארי המחמיר יותר של VBench.

עבור הבדיקות האיכותניות, המאמר מספק תמונות סטטיות, אך אנו מפנים את הקורא לסרטונים המורכבים המשובצים במאמר זה, לקבלת מושג ברור יותר, עם האזהרה שסרטוני המקור רבים ומגוונים יותר, וכן בעלי רזולוציה ופרטים גבוהים יותר. מצא אותם כאןבנוגע לתוצאות איכותיות, המאמר קובע:

סרטונים מעוגנים מציגים באופן עקבי קומפוזיציה מדויקת יותר של הסצנה, קשירה חזקה יותר בין אובייקט לתכונה והתקדמות זמנית ברורה יותר.

שיטת הפירוק לגורמים נותרה יציבה גם כאשר מספר שלבי הדיפוזיה קוצץ מ-50 ל-15, וכמעט ולא הראתה אובדן ביצועים ב-T2V-CompBench. לעומת זאת, גם קווי הבסיס של טקסט בלבד וגם קווי הבסיס של הדגימה המוגדלת ירדו בחדות תחת אותם תנאים.

למרות שהפחתת צעדים יכולה תיאורטית לשלש את המהירות, תהליך הייצור המלא הפך מהיר יותר רק פי 2.1 בפועל, עקב עלויות קבועות של יצירת תמונת עוגן. ובכל זאת, התוצאות הצביעו על כך שעיגון לא רק שיפר את איכות הדגימה אלא גם עזר לייצב את תהליך הדיפוזיה, ותמך ביצירה מהירה ויעילה יותר ללא אובדן דיוק.

אתר האינטרנט של הפרויקט מספק דוגמאות לדורות של שיטות דגימה-מעל לעומת דורות של שיטות חדשות, שאנו מציעים כאן כמה דוגמאות ערוכות (ברזולוציה נמוכה יותר):

לחץ להפעלה (ללא אודיו). מקורות התחלה מדוגמים לעומת גישת הפירוק לגורמים של המחברים.

המחברים מסכמים:

"התוצאות שלנו מצביעות על כך ששיפור הארקה, ולא הגדלת הקיבולת בלבד, עשוי להיות חשוב באותה מידה. התקדמות אחרונה בדיפוזיה של T2V הסתמכה במידה רבה על הגדלת גודל המודל ונתוני האימון, אך אפילו מודלים גדולים מתקשים לעתים קרובות להסיק סצנה ראשונית קוהרנטית מטקסט בלבד."

"זה בניגוד לדיפוזיה של תמונה, שבה קנה המידה הוא פשוט יחסית; במודלי וידאו, כל שיפור ארכיטקטוני חייב לפעול על פני ממד זמני נוסף, מה שהופך את קנה המידה לדורש משאבים רב משמעותית."

"הממצאים שלנו מצביעים על כך ששיפור הארקה יכול להשלים את קנה המידה על ידי טיפול בצוואר בקבוק אחר: יצירת הסצנה הנכונה לפני תחילת סינתזת התנועה."

"על ידי פירוק יצירת וידאו לתוך קומפוזיציה של הסצנה ומידול זמני, אנו ממתנים מספר מצבי כשל נפוצים מבלי להזדקק למודלים גדולים משמעותית. אנו רואים בכך עקרון עיצוב משלים שיכול להנחות ארכיטקטורות עתידיות לעבר סינתזת וידאו אמינה ומובנית יותר."

סיכום

למרות שבעיות ההסתבכות הן אמיתיות מאוד, ועשויות לדרוש פתרונות ייעודיים (כגון הערכות משופרות של אוצרות והפצה לפני האימון), היה זה פוקח עיניים לראות את תהליך הפירוק לגורמים 'מפרק' מספר תזמורים של קונספט עקשני ו'תקוע' לרינדורים מדויקים הרבה יותר - עם שכבה מתונה בלבד של התניה של LoRA, והתערבות של תמונת התחלה/זרע משופרת באופן ניכר.

הפער במשאבים בין הסקה של חובבים מקומיים לבין פתרונות מסחריים עשוי להיות לא עצום כפי שחושבים, בהתחשב בכך שכמעט כל הספקים מבקשים לתרץ את ההוצאות המשמעותיות שלהם על משאבי GPU עבור הצרכנים.

באופן אנקדוטי, נראה כי מספר גדול מאוד מספקי הווידאו הגנרטיבי הנוכחיים משתמשים בגרסאות ממותגות ובדרך כלל "משופרות" של מודלים סיניים של FOSS. ה"חפיר" העיקרי של כל אחת ממערכות ה"מתווכות" הללו הוא שהן טרחו לאמן LoRAs, או - בעלות גדולה יותר ובתגמול מעט גדול יותר - לבצע כוונון עדין מלא של משקלי המודל.מה Architect.

תובנות מסוג זה יכולות לסייע בצמצום הפער הזה עוד יותר, בהקשר של סצנת השקה שבה הסינים נראים נחושים (לאו דווקא מסיבות אלטרואיסטיות או אידיאליסטיות) לדמוקרטיזציה של דור הבינה המלאכותית, בעוד שאינטרסים עסקיים מערביים אולי יעדיפו שגודל המודל הגדל והתקנות יסגרו בסופו של דבר את כל המודלים הטובים באמת מאחורי ממשקי API ושכבות מרובות של מסנני תוכן.

* ההדגשות של המחברים, לא שלי.

† המאמר אינו מציין איזה כרטיס מסך נבחר, או כמה מהם נעשה בו שימוש.

מה Architect למרות שמסלול ה-LoRA סביר יותר, הן מטעמי קלות שימוש כלכלית והן משום שהמשקלים המלאים, ולא כימות משקלים, לא תמיד זמינים.

פורסם לראשונה ביום שישי, 19 בדצמבר 2025