Intelligenza Artificiale

GOTCHA: un sistema CAPTCHA per live deepfake

Una nuova ricerca della New York University si aggiunge alle crescenti indicazioni secondo cui potremmo presto dover sottoporci all'equivalente deepfake di un "test di ebbrezza" per autenticarci, prima di iniziare una videochiamata sensibile, come una videoconferenza di lavoro o qualsiasi altro scenario sensibile che potrebbe attrarre truffatori che utilizzano deepfake in tempo reale software di streaming.

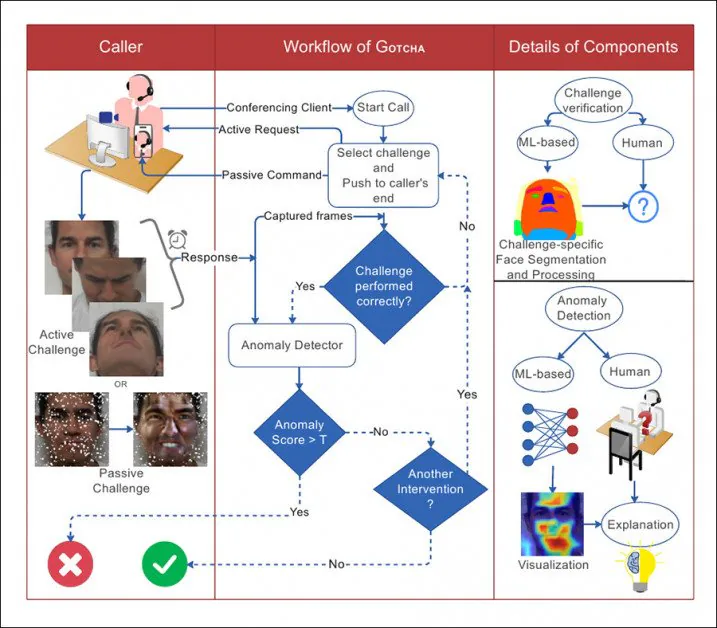

Alcune delle sfide attive e passive applicate agli scenari di videochiamata in GOTCHA. L'utente deve rispettare e superare le sfide, mentre vengono utilizzati metodi "passivi" aggiuntivi (come il tentativo di sovraccaricare un potenziale sistema deepfake) su cui il partecipante non ha alcuna influenza. Fonte: http://export.arxiv.org/pdf/2210.06186

Il sistema proposto è intitolato GOTCHA – un tributo ai sistemi CAPTCHA che sono diventati un ostacolo crescente alla navigazione sul web negli ultimi 10-15 anni, in cui i sistemi automatizzati richiedono all'utente di eseguire attività in cui le macchine non riescono, come l'identificazione degli animali o decifrare testi confusi (e, ironia della sorte, queste sfide spesso girano l'utente in un libero AMT-style annotatore esterno).

In sostanza, GOTCHA estende l'agosto 2022 DF-Captcha documento della Ben-Gurion University, che è stato il primo a proporre di far saltare la persona all'altro capo della chiamata attraverso alcuni cerchi visivamente semantici per dimostrare la loro autenticità.

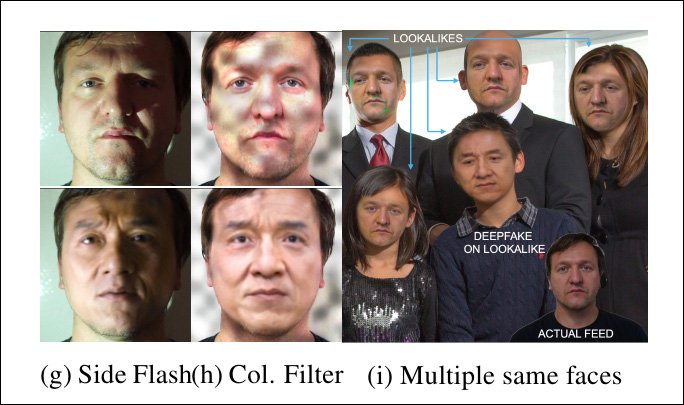

Il documento dell'agosto 2022 della Ben Gurion University ha proposto per la prima volta una serie di test interattivi per un utente, tra cui l'occlusione del viso o persino la depressione della pelle, compiti che anche i sistemi di deepfake dal vivo ben addestrati potrebbero non aver previsto o essere in grado di affrontare in modo fotorealistico. . Fonte: https://arxiv.org/pdf/2208.08524.pdf

In particolare, GOTCHA aggiunge metodologie "passive" a una "cascata" di test proposti, tra cui la sovrapposizione automatica di elementi irreali sul volto dell'utente e il "sovraccarico" di frame che attraversano il sistema sorgente. Tuttavia, solo le attività di risposta all'utente possono essere valutate senza autorizzazioni speciali per accedere al sistema locale dell'utente, che, presumibilmente, si presenterebbero sotto forma di moduli locali o componenti aggiuntivi per sistemi popolari come Skype e Zoom, o persino sotto forma di software proprietario dedicato specificamente al compito di eliminare i falsi.

Dall'articolo, un'illustrazione dell'interazione tra il chiamante e il sistema in GOTCHA, con linee tratteggiate come flussi decisionali.

I ricercatori hanno convalidato il sistema su un nuovo set di dati contenente oltre 2.5 milioni di frame video provenienti da 47 partecipanti, ognuno dei quali ha affrontato 13 sfide di GOTCHA. Sostengono che il framework induce una riduzione "coerente e misurabile" della qualità dei contenuti deepfake per gli utenti fraudolenti, mettendo a dura prova il sistema locale fino a quando artefatti evidenti non rendono l'inganno evidente a occhio nudo (sebbene GOTCHA contenga anche alcuni metodi di analisi algoritmica più sofisticati).

. nuovo documento è intitolato Gotcha: un sistema di risposta alla sfida per il rilevamento di deepfake in tempo reale (nel corpo del testo il nome del sistema è scritto in maiuscolo, ma non nel titolo della pubblicazione, sebbene non si tratti di un acronimo).

Una serie di sfide

Per lo più in accordo con il documento di Ben Gurion, le attuali sfide che gli utenti devono affrontare sono suddivise in diversi tipi di attività.

Da occlusione, all'utente viene richiesto di oscurare il proprio volto con la mano o con altri oggetti, oppure di presentare il proprio volto con un'angolazione che difficilmente potrebbe essere stata addestrata in un modello deepfake (solitamente a causa della mancanza di dati di addestramento per pose "strane" – vedere la gamma di immagini nella prima illustrazione sopra).

Oltre alle azioni che l'utente può eseguire autonomamente secondo le istruzioni, GOTCHA può sovrapporre ritagli facciali casuali, adesivi e filtri di realtà aumentata, al fine di "corrompere" il flusso di volti che un modello deepfake addestrato localmente potrebbe aspettarsi, causandone il fallimento. Come indicato in precedenza, sebbene si tratti di un processo "passivo" per l'utente, è intrusivo per il software, che deve essere in grado di intervenire direttamente nel flusso del corrispondente finale.

Successivamente, all'utente potrebbe essere richiesto di assumere con il proprio viso espressioni facciali insolite che potrebbero essere assenti o sottorappresentate in qualsiasi set di dati di addestramento, causando un abbassamento della qualità dell'output deepfaked (immagine 'b', seconda colonna da sinistra, nella prima illustrazione sopra).

Come parte di questo filone di test, all'utente potrebbe essere richiesto di leggere un testo o fare una conversazione progettata per sfidare un sistema locale di deepfaking dal vivo, che potrebbe non aver addestrato una gamma adeguata di fonemi o altri tipi di dati della bocca a un livello dove può ricostruire il movimento accurato delle labbra sotto tale controllo.

Infine (e questo sembrerebbe mettere a dura prova le capacità recitative del corrispondente finale), in questa categoria, all'utente potrebbe essere chiesto di eseguire una "microespressione", ovvero un'espressione facciale breve e involontaria che tradisce un'emozione. A questo proposito, l'articolo afferma: "[di solito] dura 0.5-4.0 secondi ed è difficile da falsificare".

Sebbene l'articolo non descriva come estrarre una microespressione, la logica suggerisce che l'unico modo per farlo è creare un'emozione appropriata nell'utente finale, magari presentandogli un contenuto sorprendente come parte della routine del test.

Distorsione facciale, illuminazione e Ospiti inaspettati

Inoltre, in linea con i suggerimenti del documento di agosto, il nuovo lavoro propone di chiedere all'utente finale di eseguire distorsioni e manipolazioni facciali insolite, come premere il dito sulla guancia, interagire con il viso e/o i capelli ed eseguire altri movimenti che nessun sistema deepfake live attuale è in grado di gestire bene, poiché si tratta di azioni marginali: anche se fossero presenti nel set di dati di addestramento, la loro riproduzione sarebbe probabilmente di bassa qualità, in linea con altri dati "anomali".

Un sorriso, ma questa "faccia depressa" non viene tradotta bene da un sistema deepfake live locale.

Un'ulteriore sfida consiste nel modificare le condizioni di illuminazione in cui si trova l'utente finale, poiché è possibile che l'addestramento di un modello deepfake sia stato ottimizzato per le situazioni di illuminazione standard delle videoconferenze o addirittura per le esatte condizioni di illuminazione in cui si svolge la chiamata.

Pertanto, all'utente potrebbe essere chiesto di illuminare il viso con la torcia del telefono cellulare o di alterare in qualche altro modo l'illuminazione (e vale la pena notare che questa virata è la proposta centrale di un altro documento di rilevamento deepfake dal vivo uscito quest'estate).

I sistemi live deepfake sono messi alla prova da un'illuminazione inaspettata e persino da più persone nello streaming, dove si aspettava solo un singolo individuo.

Nel caso in cui il sistema proposto abbia la capacità di interporsi nel flusso utente locale (che si sospetta nasconda un intermediario deepfake), l'aggiunta di modelli inaspettati (vedere la colonna centrale nell'immagine sopra) può compromettere la capacità dell'algoritmo deepfake di mantenere una simulazione.

Inoltre, sebbene sia irragionevole aspettarsi che un corrispondente abbia a disposizione altre persone per aiutarlo ad autenticarsi, il sistema può inserire volti aggiuntivi (immagine più a destra in alto) e verificare se un sistema deepfake locale commette l'errore di spostare l'attenzione, o addirittura di provare a falsificarli tutti (i sistemi deepfake autoencoder non hanno capacità di "riconoscimento dell'identità" che potrebbero mantenere l'attenzione focalizzata su un individuo in questo scenario).

Steganografia e sovraccarico

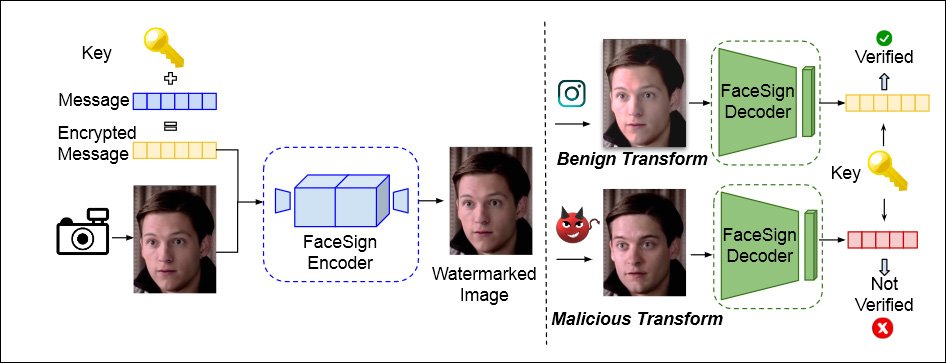

GOTCHA incorpora anche un approccio prima proposta dall'Università della California a San Diego nell'aprile di quest'anno, che utilizza la steganografia per crittografare un messaggio nel flusso video locale dell'utente. Le routine deepfake distruggeranno completamente questo messaggio, causando un errore di autenticazione.

Da un articolo dell'aprile 2022 dell'Università della California di San Diego e della San Diego State University, emerge un metodo per determinare l'identità autentica verificando se un segnale steganografico inviato al flusso video di un utente sopravvive intatto al loop locale. In caso contrario, potrebbe essere in agguato un imbroglio di deepfaking. Fonte: https://arxiv.org/pdf/2204.01960.pdf

Inoltre, GOTCHA è in grado di sovraccaricare il sistema locale (a cui è stato concesso l'accesso e l'autorizzazione), duplicando un flusso e presentando dati "eccessivi" a qualsiasi sistema locale, progettati per causare un errore di replicazione in un sistema deepfake locale.

Il sistema contiene ulteriori test (vedere il documento per i dettagli), inclusa una sfida, nel caso di un corrispondente basato su smartphone, di capovolgere il proprio telefono, che distorcerà un sistema deepfake locale:

Ancora una volta, questo tipo di cosa funzionerebbe solo in un caso d'uso convincente, in cui l'utente è costretto a concedere l'accesso locale allo streaming, e non può essere implementato tramite una semplice valutazione passiva del video dell'utente, a differenza dei test interattivi (come premere un dito sul viso).

Praticità

L'articolo accenna brevemente alla misura in cui test di questa natura possono infastidire l'utente finale, oppure in qualche modo disturbarlo - ad esempio, obbligando l'utente ad avere a portata di mano un numero di oggetti che possono essere necessari per i test, come gli occhiali da sole.

Riconosce inoltre che potrebbe essere difficile ottenere corrispondenti potenti per conformarsi alle routine di test. Riguardo al caso di una video-chiamata con un amministratore delegato, gli autori affermano:

"L'usabilità potrebbe essere fondamentale in questo caso, quindi sfide informali o frivole (come distorsioni o espressioni facciali) potrebbero non essere appropriate. Le sfide che utilizzano oggetti fisici esterni potrebbero non essere auspicabili. Il contesto in questo caso è opportunamente modificato e GOTCHA adatta di conseguenza la sua serie di sfide."

Dati e test

GOTCHA è stato testato contro quattro varietà di sistemi deepfake live locali, incluse due varianti del popolarissimo creatore di deepfakes con codifica automatica DeepFaceLab ('DFL', anche se, sorprendentemente, il documento non lo menziona DeepFace dal vivo, che è stato, dall'agosto del 2021, l'implementazione "live" di DeepFaceLab e sembra la risorsa iniziale più probabile per un potenziale falsario).

I quattro sistemi sono stati addestrati in modo "leggermente" con il DFL su una persona non famosa che partecipava ai test e su una celebrità abbinata; il DFL è stato addestrato in modo più completo, con più di 2 milioni di iterazioni o passaggi, in cui ci si aspetterebbe un modello molto più performante; Animatore di immagini latenti (LIA); E Scambio di volti Generative Adversarial Network (FGAN).

Per i dati, i ricercatori hanno catturato e curato i suddetti video clip, con 47 utenti che eseguono 13 sfide attive, con ogni utente che produce circa 5-6 minuti di video 1080p a 60 fps. Gli autori affermano inoltre che questi dati saranno eventualmente resi pubblici.

Il rilevamento delle anomalie può essere eseguito da un osservatore umano o algoritmicamente. Per quest'ultima opzione, il sistema è stato addestrato su 600 volti dal Set di dati FaceForensics. La funzione di perdita di regressione era il potente LPIPS (Learned Perceptual Image Patch Similarity), mentre l'entropia incrociata binaria è stata utilizzata per addestrare il classificatore. AutoCam è stato utilizzato per visualizzare i pesi del rilevatore.

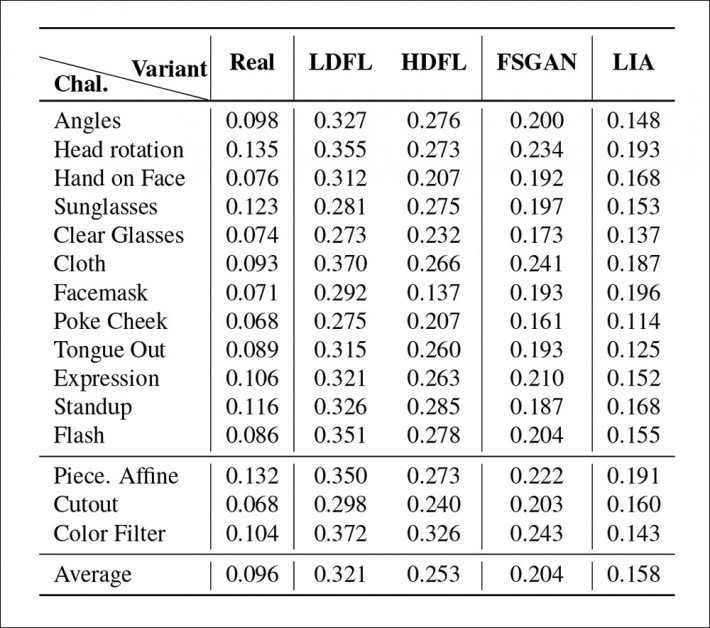

Risultati primari dei test per GOTCHA.

I ricercatori hanno scoperto che per l'intera cascata di test sui quattro sistemi, il numero e la gravità più bassi delle anomalie (ovvero artefatti che rivelerebbero la presenza di un sistema deepfake) sono stati ottenuti dalla distribuzione DFL più addestrata. La versione meno allenata faticava in particolare a ricreare complessi movimenti labiali (che occupano ben poco dell'inquadratura, ma che ricevono un'elevata attenzione umana), mentre FSGAN occupava la via di mezzo tra le due versioni DFL, e LIA si è rivelata del tutto inadeguata al compito , con i ricercatori che affermano che LIA fallirebbe in una vera distribuzione.

Pubblicato per la prima volta il 17 ottobre 2022.