Mesterséges Intelligencia

Jobb gépi tanulási teljesítmény a CNN-alapú képátméretezés révén

A Google Research egy új módszert javasolt a képalapú számítógépes látástréning munkafolyamatok hatékonyságának és pontosságának javítására azáltal, hogy javítja az adatkészletben lévő képek zsugorításának módját az előfeldolgozási szakaszban.

A papír Kép átméretezésének megtanulása számítógépes látási feladatokhoz, Hossein Talebi és Peyman Milanfar kutatók a CNN segítségével új hibrid képátméretező architektúrát hoznak létre, amely jelentős javulást eredményez a négy népszerű számítógépes látás adatkészletén elért felismerési eredményekben.

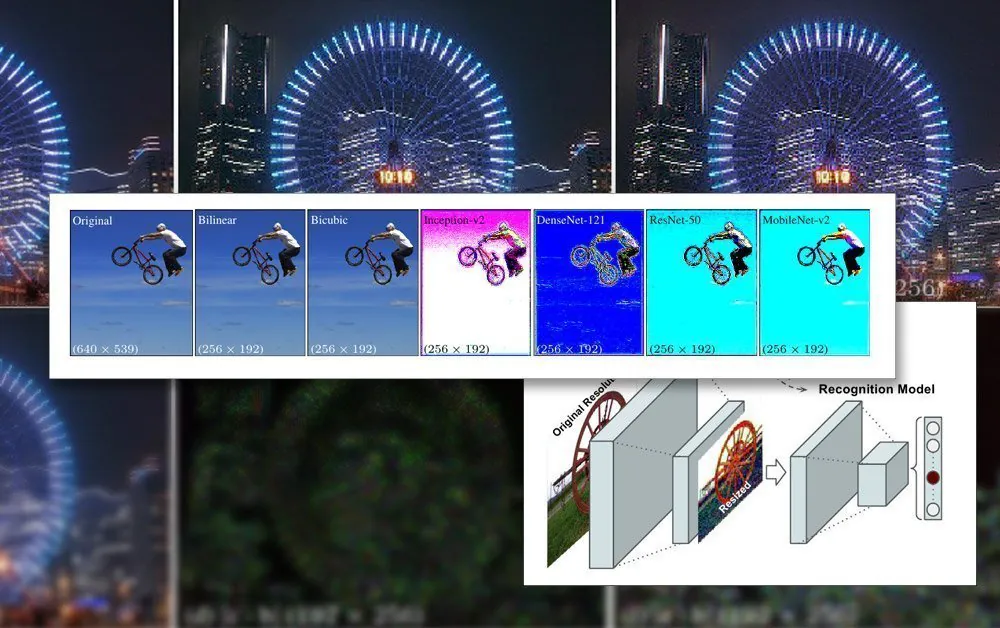

Az elismerés és átméretezés javasolt közös keretrendszere. Forrás: https://arxiv.org/pdf/2103.09950.pdf

A cikk megjegyzi, hogy az automatizált gépi tanulási folyamatokban jelenleg használt átméretezési/átméretezési módszerek évtizedek óta elavultak, és gyakran csak az alapvető bilineáris, bikubikus és a legközelebbi szomszédot használják. átméretezés – olyan módszerek, amelyek válogatás nélkül kezelik az összes pixelt.

Ezzel szemben a javasolt módszer kiegészíti a képadatokat egy CNN-n keresztül, és beépíti ezt a bemenetet az átméretezett képekbe, amelyek végül áthaladnak a modell architektúráján.

Képkorlátok az AI-képzésben

A képekkel foglalkozó modell betanításához a gépi tanulási keretrendszer tartalmazni fog egy előfeldolgozási szakaszt, ahol a különböző méretű, színterű és felbontású képek (amelyek hozzájárulnak a betanítási adatkészlethez) szisztematikusan kivágásra kerülnek, és konzisztens méretekre és stabil, egységes formátumra átméretezve.

Ez általában a PNG formátumon alapuló kompromisszumokkal jár, ahol a feldolgozási idő/erőforrások, a fájlméret és a képminőség közötti kompromisszum jön létre.

A legtöbb esetben a feldolgozott kép végső méretei nagyon kicsik. Az alábbiakban láthatunk egy példát a 80 × 80 felbontású képre, amelyen a legkorábbi mélyhamisítások adatkészletei keletkeztek:

Mivel az arcok (és más lehetséges témák) ritkán férnek bele a kívánt négyzetarányba, előfordulhat, hogy fekete sávokat kell hozzáadni (vagy helyet kell elpazarolni) a képek homogenizálása érdekében, ami tovább csökkenti a ténylegesen használható képadatokat:

Itt az arcot egy nagyobb képterületről vették ki, amíg a lehető leggazdaságosabban le nem vágják, hogy a teljes arcterületet magában foglalja. Azonban, ahogy a jobb oldalon látható, a fennmaradó terület nagy része nem kerül felhasználásra az edzés során, ami nagyobb súlyt ad az átméretezett adatok képminőségének fontosságához.

Ahogy a GPU képességei javultak az elmúlt években, az új generációs NVIDIA kártyák növekvő mennyiségben A video-RAM-ból (VRAM) az átlagos hozzájáruló képméretek kezdenek növekedni, bár a 224×224 pixel még mindig meglehetősen szabványos (például ez a ResNet-50 adatkészlet).

Egy átméretezetlen 224×244 pixeles kép.

Tételek beillesztése VRAM-ba

Ennek oka az, hogy a képeknek azonos méretűnek kell lenniük gradiens süllyedés, a módszer, amellyel a modell idővel javul, egységes képzési adatokat igényel.

A képeknek azért kell ilyen kicsiknek lenniük, mert a képzés során kis kötegekben, általában kötegenként 6-24 kép között kell betölteni (teljesen kicsomagolni) őket a VRAM-ba. Túl kevés kép kötegenként, és nincs elég csoportanyag a jó általánosításhoz, amellett, hogy meghosszabbítja a képzési időt; túl sok, és előfordulhat, hogy a modell nem éri el a szükséges jellemzőket és részleteket (lásd alább).

A képzési architektúra ezen „élő betöltési” szakaszát a látens tér. Ez az a hely, ahol ugyanazon adatokból (azaz ugyanazokból a képekből) ismételten kinyerhetők a jellemzők, amíg a modell el nem konvergál egy olyan állapotba, ahol rendelkezik minden olyan általános tudással, amelyre szüksége van ahhoz, hogy később, hasonló típusú, nem látott adatokon transzformációkat hajtson végre.

Ez a folyamat általában napokig tart, bár akár egy hónapig vagy még több is eltarthat állandó és hajthatatlan, nagy mennyiségű, 24/7 gondolkodóba a hasznos általánosítás eléréséhez. A VRAM méretének növelése csak egy bizonyos pontig hasznos, mivel a képfelbontás kismértékű növelése is nagyságrendileg befolyásolhatja a feldolgozási kapacitást, és ezzel összefüggésben a pontosságra gyakorolt hatások, amelyek nem mindig kedvezőek.

A nagyobb VRAM kapacitás használata a nagyobb kötegméretek befogadására szintén vegyes áldás, mivel az így elért nagyobb edzési sebesség valószínűleg ellensúlyozni kell kevésbé pontos eredményekkel.

Ezért, mivel a betanítási architektúra annyira korlátozott, minden, ami a folyamat meglévő korlátain belül javítani tud, figyelemre méltó eredmény.

Hogyan segít a kiváló méretcsökkentés

A képzési adatkészletben szereplő kép tökéletes minősége bizonyítottan javítja a képzés eredményét, különösen tárgyfelismerési feladatokban. 2018-ban a Max Planck Intelligens Rendszerek Intézetének kutatói állította hogy az újramintavételi módszer kiválasztása jelentősen befolyásolja a képzési teljesítményt és az eredményeket.

Ezen túlmenően a Google korábbi munkája (amelyeket az új cikk szerzői is írnak) azt találták, hogy az osztályozás pontossága javítható ellenőrzés fenntartása tömörítési műtermékek az adatkészlet-képekben.

Az új resamplerbe épített CNN-modell a bilineáris átméretezést egy „kihagyó kapcsolat” funkcióval kombinálja, amely képes beépíteni a betanított hálózat kimenetét az átméretezett képbe.

A tipikus kódoló/dekódoló architektúrától eltérően az új javaslat nem csak előrecsatolt szűk keresztmetszetként működhet, hanem fordított szűk keresztmetszetként is szolgálhat bármilyen célméretre és/vagy képarányra való felskálázáshoz. Ezenkívül a „standard” újramintavételezési módszer lecserélhető bármely más megfelelő hagyományos módszerre, mint pl. elindítja.

Nagyfrekvenciás részletek

Az új módszer olyan képeket hoz létre, amelyek úgy tűnik, hogy a kulcsfontosságú jellemzőket (amelyeket végül a betanítási folyamat felismer) közvetlenül a forrásképbe "sütnek". Esztétikai szempontból az eredmények nem szokványosak:

Az új módszer négy hálózaton keresztül – Inception V2; DenseNet-121; ResNet-50; és a MobileNet-V2. A Google Research képmintavételezési/-átméretezési módszerének eredményei nyilvánvaló pixel-aggregációjú képeket készítenek, előrevetítve azokat a főbb jellemzőket, amelyek a képzési folyamat során észrevehetők lesznek.

A kutatók megjegyzik, hogy ezeket a kezdeti kísérleteket kizárólag képfelismerési feladatokra optimalizálták, és a tesztek során a CNN-alapú „tanult átméretező” javított hibaarányt tudott elérni az ilyen feladatok során. A kutatók a jövőben más típusú képalapú számítógépes látásalkalmazásokban is alkalmazni kívánják a módszert.