Intelligence Artificielle

Style instantané : préservation du style dans la génération de texte en image

Au cours des dernières années, les modèles de diffusion basés sur le réglage ont démontré des progrès remarquables dans un large éventail de tâches de personnalisation et de personnalisation des images. Cependant, malgré leur potentiel, les modèles de diffusion actuels basés sur le réglage continuent de faire face à une multitude de défis complexes en matière de production et de génération d'images cohérentes au style, et cela pourrait être dû à trois raisons. Premièrement, le concept de style reste encore largement indéfini et indéterminé et comprend une combinaison d’éléments comprenant l’atmosphère, la structure, le design, les matériaux, la couleur et bien plus encore. Les méthodes basées sur la seconde inversion sont sujettes à une dégradation du style, entraînant une perte fréquente de détails à granularité fine. Enfin, les approches basées sur des adaptateurs nécessitent un ajustement fréquent du poids pour chaque image de référence afin de maintenir un équilibre entre la contrôlabilité du texte et l'intensité du style.

En outre, l'objectif principal de la majorité des approches de transfert de style ou de génération d'images de style est d'utiliser l'image de référence et d'appliquer son style spécifique à partir d'un sous-ensemble ou d'une image de référence donnée à une image de contenu cible. Cependant, c'est le grand nombre d'attributs de style qui rend difficile la tâche des chercheurs qui doivent collecter des ensembles de données stylisés, représenter correctement le style et évaluer le succès du transfert. Auparavant, les modèles et les cadres qui traitaient du processus de diffusion basé sur un réglage fin affinaient l'ensemble de données d'images partageant un style commun, un processus à la fois long et avec une généralisabilité limitée dans les tâches du monde réel car il est difficile pour rassembler un sous-ensemble d’images partageant le même style ou presque identique.

Dans cet article, nous parlerons d'InstantStyle, un framework conçu dans le but de résoudre les problèmes rencontrés par les modèles de diffusion actuels basés sur le réglage pour la génération et la personnalisation d'images. Nous parlerons des deux stratégies clés mises en œuvre par le framework InstantStyle :

- Une approche simple mais efficace pour découpler le style et le contenu des images de référence dans l'espace de fonctionnalités, prédite en partant de l'hypothèse que les fonctionnalités du même espace de fonctionnalités peuvent être ajoutées ou soustraites les unes aux autres.

- Prévenir les fuites de style en injectant les caractéristiques de l'image de référence exclusivement dans les blocs spécifiques au style et en évitant délibérément le besoin d'utiliser des poids encombrants pour un réglage fin, caractérisant souvent des conceptions plus lourdes en paramètres.

Cet article vise à couvrir le framework InstantStyle en profondeur, et nous explorons le mécanisme, la méthodologie, l'architecture du framework ainsi que sa comparaison avec les frameworks de pointe. Nous parlerons également de la façon dont le framework InstantStyle démontre des résultats de stylisation visuelle remarquables et établit un équilibre optimal entre la contrôlabilité des éléments textuels et l'intensité du style. Alors, commençons.

InstantStyle : préservation du style dans la génération de texte en image

Les cadres d'IA générative de texte en image basés sur la diffusion ont remporté un succès notable et remarquable dans un large éventail de tâches de personnalisation, en particulier dans les tâches de génération d'images cohérentes, notamment la personnalisation d'objets, la préservation d'images et le transfert de style. Cependant, malgré les récents succès et l'amélioration des performances, le transfert de style reste une tâche difficile pour les chercheurs en raison de la nature indéterminée et indéfinie du style, incluant souvent une variété d'éléments, notamment l'atmosphère, la structure, le design, les matériaux, la couleur et bien plus encore. Cela étant dit, l'objectif principal de la génération d'images stylisées ou du transfert de style est d'appliquer le style spécifique à partir d'une image de référence donnée ou d'un sous-ensemble d'images de référence. à l’image du contenu cible. Cependant, le grand nombre d'attributs de style rend difficile la tâche des chercheurs qui doivent collecter des ensembles de données stylisés, représenter correctement le style et évaluer le succès du transfert. Auparavant, les modèles et les cadres qui traitaient du processus de diffusion basé sur un réglage fin affinaient l'ensemble de données d'images partageant un style commun, un processus à la fois long et avec une généralisabilité limitée dans les tâches du monde réel car il est difficile pour rassembler un sous-ensemble d’images partageant le même style ou presque identique.

Face aux défis rencontrés par l'approche actuelle, les chercheurs se sont intéressés au développement d'approches affinées pour le transfert de style ou génération d'images stylisées, et ces frameworks peuvent être divisés en deux groupes différents :

- Approches sans adaptateur : Les approches et cadres sans adaptateur exploitent le pouvoir de l'auto-attention au sein du processus de diffusion, et en mettant en œuvre une opération d'attention partagée, ces modèles sont capables d'extraire directement des caractéristiques essentielles, notamment des clés et des valeurs, à partir d'images de style de référence données.

- Approches basées sur des adaptateurs : Les approches et cadres basés sur des adaptateurs, quant à eux, intègrent un modèle léger conçu pour extraire des représentations d'images détaillées à partir des images de style de référence. Le cadre intègre ensuite ces représentations dans le processus de diffusion en utilisant habilement des mécanismes d’attention croisée. L'objectif principal du processus d'intégration est de guider le processus de génération et de garantir que l'image résultante est alignée sur les nuances stylistiques souhaitées de l'image de référence.

Cependant, malgré ces promesses, les méthodes sans réglage se heurtent souvent à quelques difficultés. Premièrement, l’approche sans adaptateur nécessite un échange de clés et de valeurs au sein des couches d’auto-attention, et pré-capte les matrices de clés et de valeurs dérivées des images de style de référence. Lorsqu'elle est mise en œuvre sur des images naturelles, l'approche sans adaptateur nécessite l'inversion de l'image vers le bruit latent à l'aide de techniques telles que l'inversion de modèles DDIM ou Denoising Diffusion Implicit. Cependant, l'utilisation de DDIM ou d'autres approches d'inversion peut entraîner la perte de détails fins tels que la couleur et la texture, diminuant ainsi les informations de style dans les images générées. De plus, l’étape supplémentaire introduite par ces approches est un processus qui prend du temps et peut présenter des inconvénients importants dans les applications pratiques. D’un autre côté, le principal défi des méthodes basées sur des adaptateurs réside dans la recherche du juste équilibre entre la fuite de contexte et l’intensité du style. Une fuite de contenu se produit lorsqu'une augmentation de l'intensité du style entraîne l'apparition d'éléments non stylistiques de l'image de référence dans la sortie générée, le principal point de difficulté étant de séparer efficacement les styles du contenu dans l'image de référence. Pour résoudre ce problème, certains frameworks construisent des ensembles de données appariés qui représentent le même objet dans différents styles, facilitant l'extraction de la représentation du contenu et des styles démêlés. Cependant, en raison de la représentation intrinsèquement indéterminée du style, la tâche de création d’ensembles de données appariés à grande échelle est limitée en termes de diversité de styles qu’elle peut capturer, et il s’agit également d’un processus gourmand en ressources.

Pour remédier à ces limitations, le framework InstantStyle est introduit. Il s'agit d'un nouveau mécanisme sans réglage basé sur des méthodes existantes basées sur des adaptateurs, avec la capacité de s'intégrer de manière transparente à d'autres méthodes d'injection basées sur l'attention et de réaliser efficacement le découplage du contenu et du style. De plus, le framework InstantStyle introduit non pas un, mais deux moyens efficaces pour compléter le découplage du style et du contenu, obtenant ainsi une meilleure migration de style sans avoir besoin d'introduire des méthodes supplémentaires pour réaliser le découplage ou créer des ensembles de données appariés.

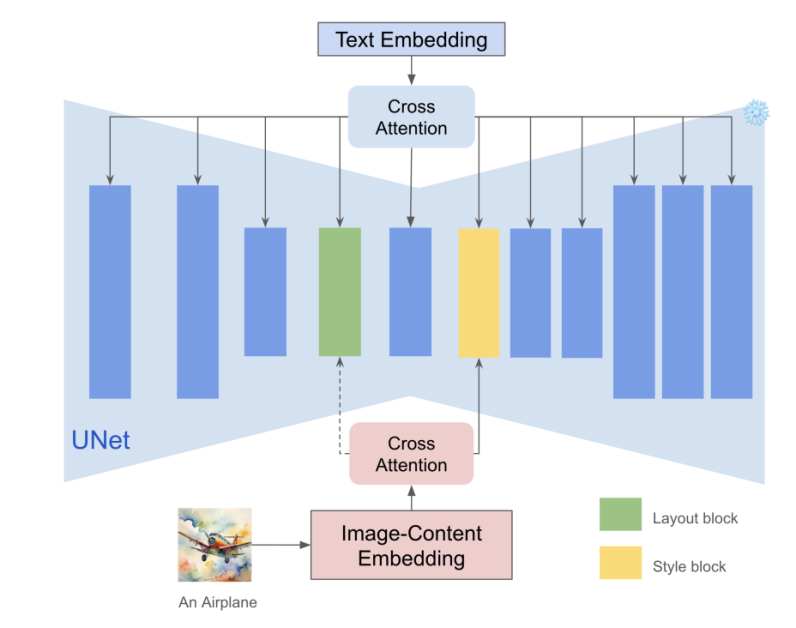

De plus, les frameworks antérieurs basés sur des adaptateurs ont été largement utilisés dans les méthodes basées sur CLIP en tant qu'extracteur de caractéristiques d'image, certains frameworks ont exploré la possibilité d'implémenter un découplage de fonctionnalités dans l'espace de fonctionnalités, et par rapport à l'indétermination du style, il est plus facile de décrire le contenu avec du texte. Étant donné que les images et les textes partagent un espace de fonctionnalités dans les méthodes basées sur CLIP, une simple opération de soustraction des fonctionnalités de texte contextuel et des fonctionnalités d'image peut réduire considérablement les fuites de contenu. De plus, dans une majorité de modèles de diffusion, il existe une couche particulière dans son architecture qui injecte les informations de style et réalise le découplage du contenu et du style en injectant des fonctionnalités d'image uniquement dans des blocs de style spécifiques. En mettant en œuvre ces deux stratégies simples, le framework InstantStyle est capable de résoudre les problèmes de fuite de contenu rencontrés par une majorité de frameworks existants tout en conservant la force du style.

Pour résumer, le framework InstantStyle utilise deux mécanismes simples, directs mais efficaces pour parvenir à un dissociation efficace du contenu et du style des images de référence. Le framework Instant-Style est une approche indépendante du modèle et sans réglage qui démontre des performances remarquables dans les tâches de transfert de style avec un énorme potentiel pour les tâches en aval.

Style instantané : méthodologie et architecture

Comme démontré par les approches précédentes, il existe un équilibre dans l’injection de conditions de style dans les modèles de diffusion sans réglage. Si l'intensité de la condition de l'image est trop élevée, cela peut entraîner une fuite de contenu, tandis que si l'intensité de la condition de l'image tombe trop bas, le style peut ne pas sembler assez évident. L’une des principales raisons derrière cette observation est que dans une image, le style et le contenu sont interdépendants et qu’en raison des attributs de style indéterminés inhérents, il est difficile de dissocier le style et l’intention. En conséquence, des pondérations méticuleuses sont souvent ajustées pour chaque image de référence dans le but d’équilibrer la contrôlabilité du texte et la force du style. De plus, pour une image de référence d'entrée donnée et la description textuelle correspondante dans les méthodes basées sur l'inversion, des approches d'inversion telles que DDIM sont adoptées sur l'image pour obtenir la trajectoire de diffusion inversée, un processus qui se rapproche de l'équation d'inversion pour transformer une image en un flux latent. représentation du bruit. S'appuyant sur la même chose et en partant de la trajectoire de diffusion inversée ainsi que d'un nouvel ensemble d'invites, ces méthodes génèrent un nouveau contenu dont le style s'aligne sur l'entrée. Cependant, comme le montre la figure suivante, l'approche d'inversion DDIM pour les images réelles est souvent instable car elle repose sur des hypothèses de linéarisation locale, ce qui entraîne la propagation d'erreurs et conduit à une perte de contenu et à une reconstruction d'image incorrecte.

En ce qui concerne la méthodologie, au lieu d'employer des stratégies complexes pour démêler le contenu et le style des images, le framework Instant-Style adopte l'approche la plus simple pour obtenir des performances similaires. Lorsqu'on le compare aux attributs de style sous-déterminés, le contenu peut être représenté par du texte naturel, permettant au framework Instant-Style d'utiliser l'encodeur de texte de CLIP pour extraire les caractéristiques du texte du contenu en tant que représentations contextuelles. Simultanément, le framework Instant-Style implémente l'encodeur d'image CLIP pour extraire les caractéristiques de l'image de référence. Tirant parti de la caractérisation des fonctionnalités globales de CLIP et post-soustrayant les fonctionnalités de texte du contenu des fonctionnalités de l'image, le framework Instant-Style est capable de découpler explicitement le style et le contenu. Bien qu'il s'agisse d'une stratégie simple, elle aide le framework Instant-Style à être très efficace pour minimiser les fuites de contenu.

De plus, chaque couche d'un réseau profond est responsable de la capture de différentes informations sémantiques, et l'observation clé des modèles précédents est qu'il existe deux couches d'attention responsables du style de gestion. up Plus précisément, ce sont les couches Blocks.0.attentions.1 et Down Blocks.2.attentions.1 qui sont responsables de la capture du style comme la couleur, le matériau, l'atmosphère, et la couche de disposition spatiale capture respectivement la structure et la composition. Le framework Instant-Style utilise ces couches implicitement pour extraire les informations de style et empêche les fuites de contenu sans perdre la force du style. La stratégie est simple mais efficace puisque le modèle a localisé des blocs de style qui peuvent injecter les caractéristiques de l'image dans ces blocs pour obtenir un transfert de style transparent. De plus, étant donné que le modèle réduit considérablement le nombre de paramètres de l'adaptateur, la capacité de contrôle de texte du framework est améliorée et le mécanisme est également applicable à d'autres modèles d'injection de fonctionnalités basés sur l'attention pour l'édition et d'autres tâches.

Instant-Style : expériences et résultats

Le framework Instant-Style est implémenté sur le framework Stable Diffusion XL, et il utilise l'adaptateur IR pré-entraîné couramment adopté comme exemple pour valider sa méthodologie, et coupe tous les blocs à l'exception des blocs de style pour les fonctionnalités de l'image. Le modèle Instant-Style entraîne également l'adaptateur IR sur 4 millions d'ensembles de données appariés texte-image à grande échelle à partir de zéro, et au lieu d'entraîner tous les blocs, il met à jour uniquement les blocs de style.

Pour tester ses capacités de généralisation et sa robustesse, le framework Instant-Style mène de nombreuses expériences de transfert de style avec différents styles sur différents contenus, et les résultats peuvent être observés dans les images suivantes. Étant donné une image de référence de style unique ainsi que diverses invites, le framework Instant-Style offre un style cohérent et de haute qualité. génération d'image.

De plus, étant donné que le modèle injecte des informations d'image uniquement dans les blocs de style, il est capable d'atténuer considérablement le problème de fuite de contenu et n'a donc pas besoin d'effectuer un réglage du poids.

En progressant, le framework Instant-Style adopte également l'architecture ControlNet pour réaliser une stylisation basée sur l'image avec contrôle spatial, et les résultats sont démontrés dans l'image suivante.

Comparé aux méthodes de pointe précédentes, notamment StyleAlign, B-LoRA, Swapping Self Attention et IP-Adapter, le framework Instant-Style démontre les meilleurs effets visuels.

Réflexions finales

Dans cet article, nous avons parlé d'Instant-Style, un cadre général qui utilise deux stratégies simples mais efficaces pour parvenir à un démêlage efficace du contenu et du style des images de référence. Le framework InstantStyle est conçu dans le but de résoudre les problèmes rencontrés par les modèles de diffusion actuels basés sur le réglage pour la génération et la personnalisation d'images. Le framework Instant-Style met en œuvre deux stratégies essentielles : Une approche simple mais efficace pour découpler le style et le contenu des images de référence dans l'espace de fonctionnalités, prédite en partant de l'hypothèse que les fonctionnalités du même espace de fonctionnalités peuvent être ajoutées ou soustraites les unes aux autres. Deuxièmement, éviter les fuites de style en injectant les caractéristiques de l'image de référence exclusivement dans les blocs spécifiques au style et en évitant délibérément la nécessité d'utiliser des poids encombrants pour un réglage fin, caractérisant souvent des conceptions plus lourdes en paramètres.