Intelligence artificielle

LipSync3D de Google offre une meilleure synchronisation des mouvements de la bouche "Deepfaked"

A collaboration entre les chercheurs de Google AI et l'Indian Institute of Technology Kharagpur propose un nouveau cadre pour synthétiser les têtes parlantes à partir de contenu audio. Le projet vise à produire des moyens optimisés et dotés de ressources raisonnables pour créer du contenu vidéo « tête parlante » à partir de l'audio, dans le but de synchroniser les mouvements des lèvres avec l'audio doublé ou traduit automatiquement, et pour une utilisation dans des avatars, dans des applications interactives et dans d'autres environnements en temps réel.

Source : https://www.youtube.com/watch?v=L1StbX9OznY

Les modèles d’apprentissage automatique formés au cours du processus – appelés LipSync3D – ne nécessitent qu’une seule vidéo de l’identité du visage cible comme données d’entrée. Le pipeline de préparation des données sépare l'extraction de la géométrie du visage de l'évaluation de l'éclairage et des autres facettes d'une vidéo d'entrée, permettant une formation plus économique et ciblée.

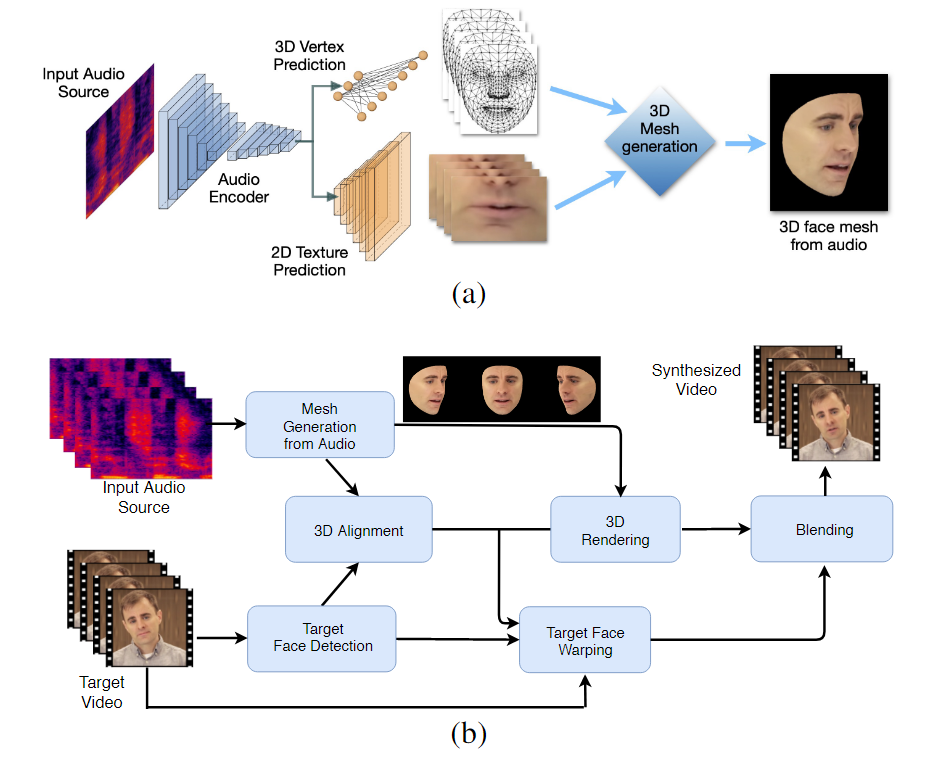

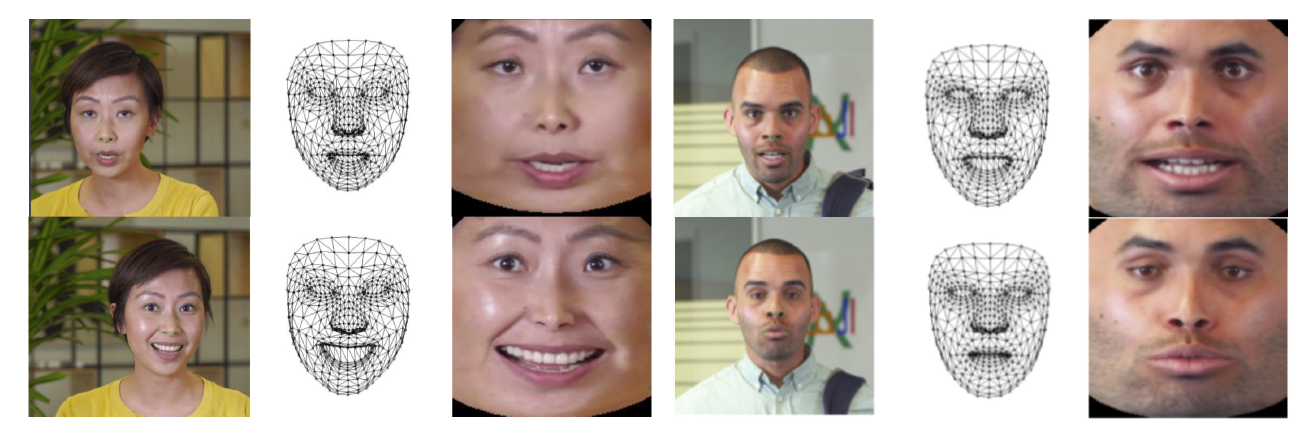

Le flux de travail en deux étapes de LipSync3D. Ci-dessus, la génération d'un visage 3D à texture dynamique à partir de l'audio "cible" ; ci-dessous, l'insertion du maillage généré dans une vidéo cible.

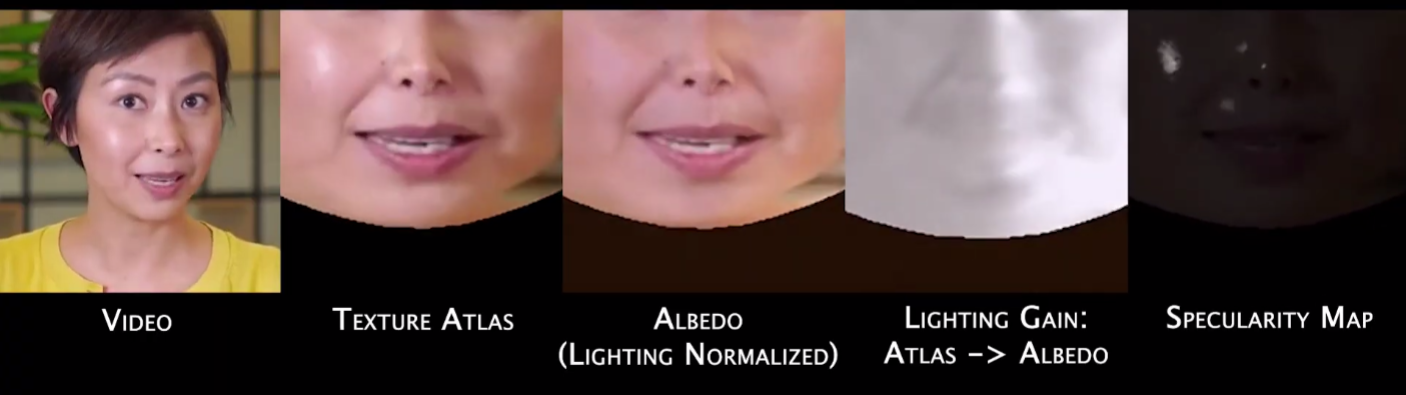

En fait, la contribution la plus notable de LipSync3D à l'ensemble des efforts de recherche dans ce domaine est peut-être son algorithme de normalisation de l'éclairage, qui découple l'apprentissage et l'éclairage d'inférence.

Le découplage des données d'éclairage de la géométrie générale aide LipSync3D à produire une sortie de mouvement des lèvres plus réaliste dans des conditions difficiles. D'autres approches de ces dernières années se sont limitées à des conditions d'éclairage «fixes» qui ne révéleront pas leur capacité plus limitée à cet égard.

Lors du prétraitement des trames de données d'entrée, le système doit identifier et supprimer les points spéculaires, car ceux-ci sont spécifiques aux conditions d'éclairage dans lesquelles la vidéo a été prise et interféreront autrement avec le processus de rééclairage.

LipSync3D, comme son nom l'indique, n'effectue pas une simple analyse de pixels sur les visages qu'il évalue, mais utilise activement des repères faciaux identifiés pour générer des maillages mobiles de style CGI, ainsi que les textures "dépliées" qui les entourent dans un CGI traditionnel. pipeline.

Pose de normalisation dans LipSync3D. Sur la gauche se trouvent les trames d'entrée et les entités détectées ; au milieu, les sommets normalisés de l'évaluation du maillage généré ; et à droite, l'atlas de texture correspondant, qui fournit la vérité terrain pour la prédiction de texture. Source : https://arxiv.org/pdf/2106.04185.pdf

Outre la nouvelle méthode de rééclairage, les chercheurs affirment que LipSync3D offre trois innovations principales par rapport aux travaux précédents : la séparation de la géométrie, de l'éclairage, de la pose et de la texture en flux de données discrets dans un espace normalisé ; un modèle de prédiction de texture auto-régressif facilement entraînable qui produit une synthèse vidéo cohérente dans le temps ; et un réalisme accru, évalué par des évaluations humaines et des mesures objectives.

La séparation des différentes facettes de l'imagerie faciale vidéo permet un meilleur contrôle de la synthèse vidéo.

LipSync3D peut dériver le mouvement de la géométrie appropriée des lèvres directement à partir de l'audio en analysant les phonèmes et d'autres facettes de la parole, et en les traduisant en poses musculaires correspondantes connues autour de la bouche.

Ce processus utilise un pipeline de prédiction conjointe, où la géométrie et la texture déduites ont des encodeurs dédiés dans une configuration d'auto-encodeur, mais partagent un encodeur audio avec la parole qui est destinée à être imposée au modèle :

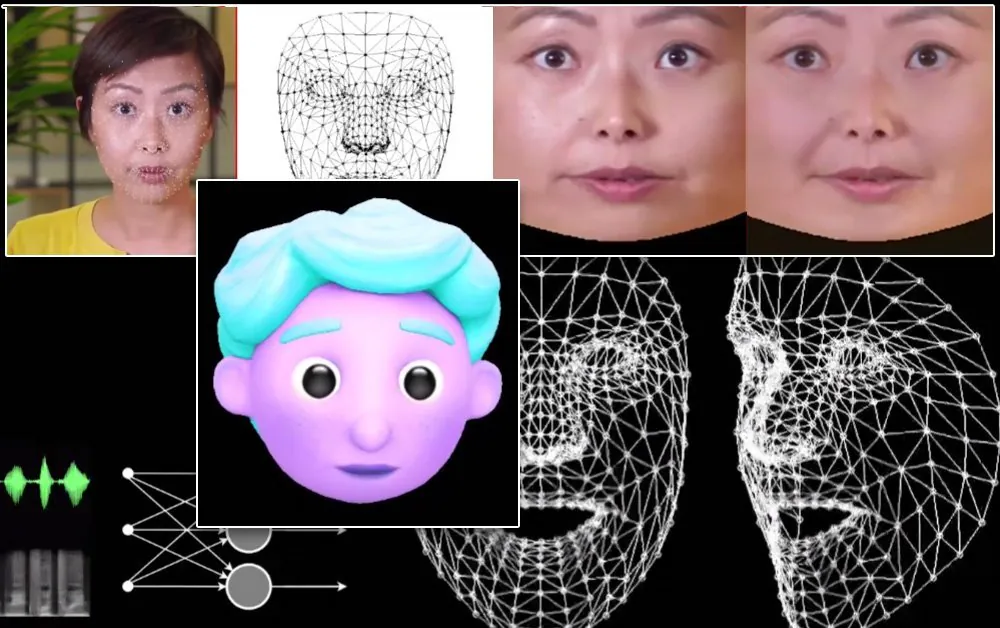

La synthèse de mouvement labile de LipSync3D est également destinée à alimenter les avatars CGI stylisés, qui ne sont en fait que le même type d'informations de maillage et de texture que l'imagerie du monde réel :

Un avatar 3D stylisé a ses mouvements de lèvres alimentés en temps réel par une source vidéo de haut-parleur. Dans un tel scénario, les meilleurs résultats seraient obtenus par une pré-formation personnalisée.

Les chercheurs prévoient également l'utilisation d'avatars avec une sensation un peu plus réaliste :

![]()

Les exemples de temps de formation pour les vidéos vont de 3 à 5 heures pour une vidéo de 2 à 5 minutes, dans un pipeline qui utilise TensorFlow, Python et C++ sur une GeForce GTX 1080. Les sessions de formation ont utilisé une taille de lot de 128 images sur 500-1000 époques, chaque époque représentant une évaluation complète de la vidéo.

Vers une resynchronisation dynamique du mouvement des lèvres

Le domaine de la resynchronisation des lèvres pour s'adapter à une nouvelle piste audio a reçu beaucoup d'attention dans la recherche en vision par ordinateur ces dernières années (voir ci-dessous), notamment parce qu'il s'agit d'un sous-produit de controverses. technologie deepfake.

En 2017, l'Université de Washington recherche présentée capable d'apprendre la synchronisation labiale à partir de l'audio, en l'utilisant pour modifier les mouvements des lèvres du président Obama de l'époque. En 2018; l'Institut Max Planck pour l'informatique a dirigé une autre initiative de recherche pour activer le transfert vidéo identité> identité, avec synchronisation labiale a sous-produit du procédé; et en mai 2021, la startup AI FlawlessAI a dévoilé sa technologie propriétaire de synchronisation labiale TrueSync, largement reçu dans la presse en tant que catalyseur des technologies de doublage améliorées pour les sorties de films majeures dans toutes les langues.

Et, bien sûr, le développement en cours de référentiels open source deepfake fournit une autre branche de recherche active contribuée par les utilisateurs dans ce domaine de la synthèse d'images faciales.