Intelligence Artificielle

Meilleures performances d'apprentissage automatique grâce au redimensionnement d'image basé sur CNN

Google Research a proposé une nouvelle méthode pour améliorer l'efficacité et la précision des flux de travail de formation à la vision par ordinateur basés sur des images en améliorant la manière dont les images d'un ensemble de données sont réduites au stade du prétraitement.

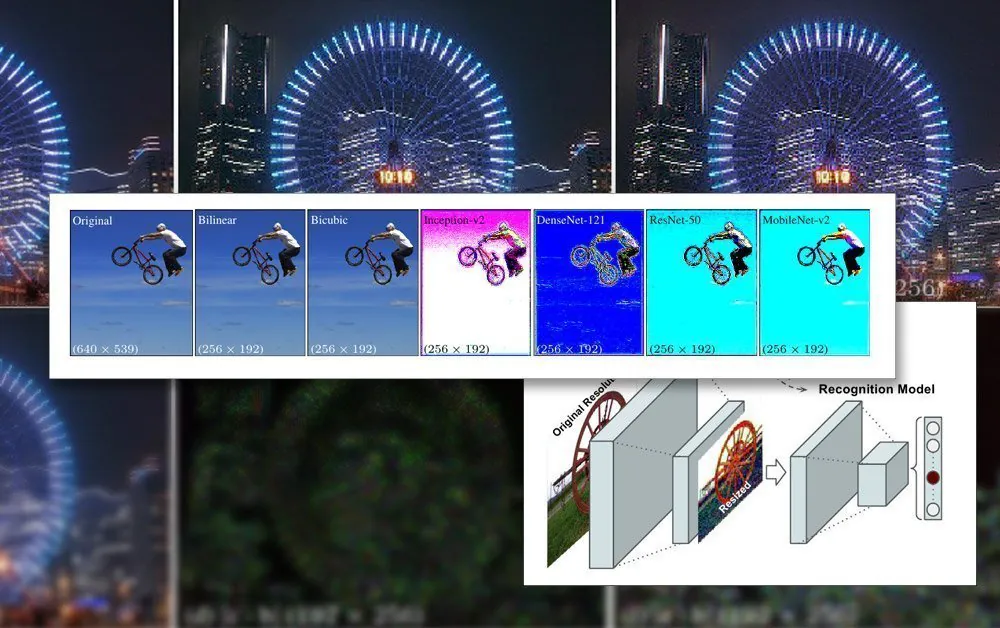

Dans l' papier Apprendre à redimensionner les images pour les tâches de vision par ordinateur, les chercheurs Hossein Talebi et Peyman Milanfar utilisent un CNN pour créer une nouvelle architecture hybride de redimensionnement d'image qui produit une amélioration notable des résultats de reconnaissance obtenus sur quatre ensembles de données de vision par ordinateur populaires.

Le cadre commun proposé pour la reconnaissance et le redimensionnement. Source : https://arxiv.org/pdf/2103.09950.pdf

L'article observe que les méthodes de redimensionnement/redimensionnement actuellement utilisées dans les pipelines d'apprentissage automatique automatisé sont dépassées depuis des décennies et utilisent fréquemment uniquement des méthodes de base bilinéaires, bicubiques et les plus proches voisins. redimensionnement – les méthodes qui traitent tous les pixels de manière indiscriminée.

En revanche, la méthode proposée augmente les données d'image via un CNN et intègre cette entrée dans les images redimensionnées qui passeront finalement par l'architecture du modèle.

Contraintes d'image dans la formation à l'IA

Afin de former un modèle qui traite des images, un cadre d'apprentissage automatique comprendra une étape de prétraitement, où une variété disparate d'images de différentes tailles, espaces colorimétriques et résolutions (qui contribueront à l'ensemble de données de formation) sont systématiquement recadrées et redimensionné dans des dimensions cohérentes et un format stable et unique.

En général, cela impliquera un compromis basé sur le format PNG, où un compromis entre le temps de traitement/les ressources, la taille du fichier et la qualité de l'image sera établi.

Dans la plupart des cas, les dimensions finales de l'image traitée sont très petites. Ci-dessous, nous voyons un exemple de l'image de résolution 80 × 80 à laquelle certains des premiers ensembles de données deepfakes ont été générés:

Étant donné que les visages (et d'autres sujets possibles) correspondent rarement au rapport carré requis, il peut être nécessaire d'ajouter des barres noires (ou de perdre de l'espace autorisé) afin d'homogénéiser les images, réduisant davantage les données d'image réellement utilisables :

Ici, le visage a été extrait d'une zone d'image plus grande jusqu'à ce qu'il soit recadré aussi économiquement que possible afin d'inclure toute la zone du visage. Cependant, comme on le voit à droite, une grande partie de la zone restante ne sera pas utilisée pendant la formation, ce qui ajoute plus de poids à l'importance de la qualité d'image des données redimensionnées.

Comme les capacités du GPU se sont améliorées ces dernières années, avec la nouvelle génération de cartes NVIDIA équipées de des quantités croissantes de vidéo-RAM (VRAM), la taille moyenne des images contributives commence à augmenter, bien que 224 × 224 pixels soit encore assez standard (par exemple, c'est la taille de la ResNet-50 base de données).

Une image non redimensionnée de 224×244 pixels.

Insertion de lots dans la VRAM

La raison pour laquelle les images doivent toutes avoir la même taille est que Descente graduelle, la méthode par laquelle le modèle s'améliore au fil du temps, nécessite des données d'entraînement uniformes.

La raison pour laquelle les images doivent être si petites est qu'elles doivent être chargées (entièrement décompressées) dans la VRAM pendant la formation par petits lots, généralement entre 6 et 24 images par lot. Trop peu d'images par lot, et il n'y a pas assez de matériel de groupe pour bien généraliser, en plus de rallonger le temps de formation ; trop, et le modèle peut ne pas obtenir les caractéristiques et les détails nécessaires (voir ci-dessous).

Cette section de « chargement en direct » de l'architecture de formation est appelée espace latent. C'est là que les caractéristiques sont extraites à plusieurs reprises des mêmes données (c'est-à-dire des mêmes images) jusqu'à ce que le modèle ait convergé vers un état où il dispose de toutes les connaissances généralisées dont il a besoin pour effectuer des transformations sur des données ultérieures et invisibles d'un type similaire.

Ce processus prend généralement des jours, bien qu'il puisse même falloir un mois ou plus de cogitation constante et inflexible à haut volume 24 heures sur 7, XNUMX jours sur XNUMX, pour parvenir à une généralisation utile. Les augmentations de la taille de la VRAM ne sont utiles que jusqu'à un certain point, car même des incréments mineurs de la résolution de l'image peuvent avoir un effet d'ordre de grandeur sur la capacité de traitement et des effets connexes sur la précision qui peuvent ne pas toujours être favorables.

L'utilisation d'une plus grande capacité de VRAM pour s'adapter à des tailles de lots plus élevées est également une bénédiction mitigée, car les vitesses d'entraînement plus élevées obtenues par cela sont susceptibles d'être compensés par des résultats moins précis.

Par conséquent, étant donné que l'architecture de formation est si limitée, tout ce qui peut apporter une amélioration dans les limites existantes du pipeline est une réalisation notable.

Comment une réduction des effectifs supérieure aide

Il a été prouvé que la qualité ultime d'une image qui sera incluse dans un ensemble de données de formation a un effet d'amélioration sur les résultats de la formation, en particulier dans les tâches de reconnaissance d'objets. En 2018, des chercheurs de l'Institut Max Planck pour les systèmes intelligents soutenu que le choix de la méthode de rééchantillonnage a notamment un impact sur les performances et les résultats de la formation.

De plus, des travaux antérieurs de Google (co-écrits par les auteurs du nouvel article) ont montré que la précision de la classification peut être améliorée en garder le contrôle sur les artefacts de compression dans les images du jeu de données.

Le modèle CNN intégré au nouveau rééchantillonneur combine le redimensionnement bilinéaire avec une fonction « ignorer la connexion » qui peut intégrer la sortie du réseau formé dans l'image redimensionnée.

Contrairement à une architecture encodeur/décodeur classique, la nouvelle proposition peut non seulement agir comme un goulot d'étranglement direct, mais aussi comme un goulot d'étranglement inverse pour la mise à l'échelle vers n'importe quelle taille cible et/ou rapport hauteur/largeur. De plus, la méthode de rééchantillonnage « standard » peut être remplacée par toute autre méthode traditionnelle appropriée, telle que Lanczos.

Détails haute fréquence

La nouvelle méthode produit des images qui semblent « intégrer » des caractéristiques clés (qui seront finalement reconnues par le processus d'apprentissage) directement dans l'image source. Sur le plan esthétique, les résultats sont atypiques :

La nouvelle méthode appliquée sur quatre réseaux – Inception V2 ; DenseNet-121 ; ResNet-50 ; et MobileNet-V2. Les résultats de la méthode de sous-échantillonnage/redimensionnement d'image de Google Research produisent des images avec une agrégation de pixels évidente, anticipant les caractéristiques clés qui seront discernées au cours du processus de formation.

Les chercheurs soulignent que ces premières expériences sont exclusivement optimisées pour les tâches de reconnaissance d'images et que, lors des tests, leur « redimensionneur appris » basé sur CNN a permis d'obtenir des taux d'erreur réduits dans ces tâches. Les chercheurs prévoient d'appliquer ultérieurement cette méthode à d'autres types d'applications de vision par ordinateur basées sur l'image.