Intelligence artificielle

AnimateLCM : accélérer l'animation de modèles de diffusion personnalisés

Au cours des dernières années, les modèles de diffusion ont connu un succès et une reconnaissance massifs pour les tâches de génération d'images et de vidéos. Les modèles de diffusion vidéo, en particulier, suscitent une attention considérable en raison de leur capacité à produire des vidéos d’une grande cohérence et fidélité. Ces modèles génèrent des vidéos de haute qualité en employant un processus de débruitage itératif dans leur architecture qui transforme progressivement le bruit gaussien de grande dimension en données réelles.

La diffusion stable est l'un des modèles les plus représentatifs pour les tâches de génération d'images, s'appuyant sur un auto-encodeur variationnel (VAE) pour mapper entre l'image réelle et les caractéristiques latentes sous-échantillonnées. Cela permet au modèle de réduire les coûts de génération, tandis que le mécanisme d'attention croisée dans son architecture facilite la génération d'images conditionnées par du texte. Plus récemment, le framework Stable Diffusion a jeté les bases de plusieurs adaptateurs plug-and-play permettant de générer une image ou une vidéo plus innovante et plus efficace. Cependant, le processus de génération itératif employé par la majorité des modèles de diffusion vidéo rend le processus de génération d’images long et relativement coûteux, limitant ainsi ses applications.

Dans cet article, nous parlerons d'AnimateLCM, un modèle de diffusion personnalisé avec des adaptateurs visant à générer des vidéos haute fidélité avec des étapes et des coûts de calcul minimes. Le framework AnimateLCM s'inspire du modèle de cohérence, qui accélère l'échantillonnage avec un minimum d'étapes en distillant des modèles de diffusion d'images pré-entraînés. De plus, l'extension réussie du modèle de cohérence, le modèle de cohérence latente (LCM), facilite la génération d'images conditionnelles. Au lieu d'effectuer un apprentissage de cohérence directement sur l'ensemble de données vidéo brutes, le framework AnimateLCM propose d'utiliser une stratégie d'apprentissage de cohérence découplée. Cette stratégie dissocie la distillation des priors de génération de mouvement et des priors de génération d'images, permettant au modèle d'améliorer la qualité visuelle du contenu généré et d'améliorer simultanément l'efficacité de la formation. De plus, le modèle AnimateLCM propose de former des adaptateurs à partir de zéro ou d'adapter les adaptateurs existants à son modèle de cohérence vidéo distillé. Cela facilite la combinaison d'adaptateurs plug-and-play dans la famille des modèles de diffusion stables pour réaliser différentes fonctions sans nuire à la vitesse d'échantillonnage.

Cet article vise à couvrir en profondeur le framework AnimateLCM. Nous explorons le mécanisme, la méthodologie et l'architecture du framework, ainsi que sa comparaison avec les frameworks de génération d'images et de vidéos de pointe. Alors, commençons.

AnimateLCM : Animation de Modèles de Diffusion Personnalisés

Les modèles de diffusion constituent le cadre de prédilection pour les tâches de génération d'images et de génération de vidéos en raison de leur efficacité et de leurs capacités sur les tâches génératives. La majorité des modèles de diffusion reposent sur un processus de débruitage itératif pour la génération d’images qui transforme progressivement un bruit gaussien de haute dimension en données réelles. Bien que la méthode donne des résultats quelque peu satisfaisants, le processus itératif et le nombre d'échantillons itératifs ralentissent le processus de génération et ajoutent également aux exigences de calcul des modèles de diffusion qui sont beaucoup plus lents que d'autres cadres génératifs comme GAN ou Réseaux d'adversaires génératifs. Au cours des dernières années, les modèles de cohérence ou CM ont été proposés comme alternative aux modèles de diffusion itératifs pour accélérer le processus de génération tout en maintenant les exigences de calcul constantes.

Le point fort des modèles de cohérence est qu'ils apprennent des mappages de cohérence qui maintiennent l'auto-cohérence des trajectoires introduites par les modèles de diffusion pré-entraînés. Le processus d'apprentissage des modèles de cohérence lui permet de générer des images de haute qualité en un minimum d'étapes et élimine également le besoin d'itérations gourmandes en calculs. De plus, le modèle de cohérence latente ou LCM construit sur le cadre de diffusion stable peut être intégré à l'interface utilisateur Web avec les adaptateurs existants pour obtenir une multitude de fonctionnalités supplémentaires telles que la traduction d'image en image en temps réel. En comparaison, bien que les modèles de diffusion vidéo existants donnent des résultats acceptables, des progrès restent à faire dans le domaine de l'accélération des échantillons vidéo et sont d'une grande importance en raison des coûts de calcul élevés pour la génération vidéo.

Cela nous amène à AnimateLCM, un framework de génération vidéo haute fidélité qui nécessite un nombre minimal d'étapes pour les tâches de génération vidéo. Suivant le modèle de cohérence latente, le cadre AnimateLCM traite le processus de diffusion inverse comme la résolution d'un flux de probabilité augmenté CFG ou Classifier Free Guidance, et entraîne le modèle pour prédire la solution de ces flux de probabilité directement dans l'espace latent. Cependant, au lieu d'effectuer directement un apprentissage de cohérence sur des données vidéo brutes, ce qui nécessite des ressources de formation et de calcul élevées et conduit souvent à une mauvaise qualité, le cadre AnimateLCM propose une stratégie d'apprentissage cohérente découplée qui dissocie la distillation de cohérence des priorités de génération de mouvement et de génération d'images.

Le framework AnimateLCM effectue d'abord la distillation de cohérence pour adapter le modèle de diffusion de base d'image dans le modèle de cohérence d'image, puis effectue un gonflement 3D des modèles de cohérence d'image et de diffusion d'image pour s'adapter aux fonctionnalités 3D. Finalement, le framework AnimateLCM obtient le modèle de cohérence vidéo en effectuant une distillation de cohérence sur les données vidéo. De plus, pour atténuer la corruption potentielle des fonctionnalités résultant du processus de diffusion, le framework AnimateLCM propose également d'utiliser une stratégie d'initialisation. Étant donné que le framework AnimateLCM est construit sur le framework Stable Diffusion, il peut remplacer les poids spatiaux de son modèle de cohérence vidéo entraîné par les poids de diffusion d'images personnalisés accessibles au public pour obtenir des résultats de génération innovants.

De plus, pour former des adaptateurs spécifiques à partir de zéro ou pour mieux s'adapter aux adaptateurs accessibles au public, le framework AnimateLCM propose une stratégie d'accélération efficace pour les adaptateurs qui ne nécessitent pas de formation des modèles d'enseignant spécifiques.

Les contributions du framework AnimateLCM peuvent être très bien résumées comme suit : Le framework AnimateLCM proposé vise à obtenir une génération vidéo de haute qualité, rapide et haute fidélité, et pour y parvenir, le framework AnimateLCM propose une stratégie de distillation découplée qui découple le mouvement et l'image. générations antérieures, ce qui se traduit par une meilleure qualité de génération et une efficacité de formation améliorée.

InstantID : Méthodologie et Architecture

À la base, le framework InstantID s’inspire fortement des modèles de diffusion et des stratégies de vitesse d’échantillonnage. Les modèles de diffusion, également connus sous le nom de modèles génératifs basés sur des scores, ont démontré des capacités génératives d'images remarquables. Sous la direction de la direction des scores, la stratégie d'échantillonnage itérative mise en œuvre par les modèles de diffusion débruite progressivement les données corrompues par le bruit. L’efficacité des modèles de diffusion est l’une des principales raisons pour lesquelles ils sont utilisés par la majorité des pays. modèles de diffusion vidéo en s'entraînant sur des couches temporelles ajoutées. D’un autre côté, les stratégies de vitesse d’échantillonnage et d’accélération d’échantillonnage aident à lutter contre les vitesses de génération lentes dans les modèles de diffusion. La méthode d'accélération basée sur la distillation ajuste les poids de diffusion d'origine avec une architecture ou un planificateur raffiné pour améliorer la vitesse de génération.

En progressant, le framework InstantID est construit sur le modèle de diffusion stable qui permet à InstantID d'appliquer des notions pertinentes. Le modèle traite le processus de diffusion discrète vers l'avant comme un SDE à préservation de variance en temps continu. De plus, le modèle de diffusion stable est une extension du DDPM ou Denoising Diffusion Probabilistic Model, dans lequel le point de données d'entraînement est progressivement perturbé par la chaîne de Markov discrète avec un chenil de perturbation permettant la distribution de données bruyantes à différents pas de temps pour suivre la distribution.

Pour obtenir une génération vidéo haute fidélité avec un nombre minimal d'étapes, le framework AnimateLCM apprivoise les modèles vidéo stables basés sur la diffusion pour suivre la propriété d'auto-cohérence. La structure globale de formation du cadre AnimateLCM consiste en une stratégie d’apprentissage de cohérence découplée pour une adaptation libre de l’enseignant et un apprentissage de cohérence efficace.

Transition des modèles de diffusion aux modèles de cohérence

Le framework AnimateLCM introduit sa propre adaptation du modèle de diffusion stable ou DM au modèle de cohérence ou CM suite à la conception du modèle de cohérence latente ou LCM. Il convient de noter que même si les modèles de diffusion stable prédisent généralement le bruit ajouté aux échantillons, ils constituent des modèles sigma-diffusion essentiels. Cela contraste avec les modèles de cohérence qui visent à prédire directement la solution de la trajectoire PF-ODE. De plus, dans les modèles de diffusion stables avec certains paramètres, il est essentiel que le modèle utilise une stratégie de guidage sans classificateur pour générer des images de haute qualité. Le framework AnimateLCM utilise cependant un solveur ODE augmenté à guidage sans classificateur pour échantillonner les paires adjacentes dans les mêmes trajectoires, ce qui entraîne une meilleure efficacité et une qualité améliorée. De plus, les modèles existants ont indiqué que la qualité de la génération et l'efficacité de la formation sont fortement influencées par le nombre de points discrets dans la trajectoire. Un plus petit nombre de points discrets accélère le processus de formation, tandis qu'un nombre plus élevé de points discrets entraîne moins de biais pendant la formation.

Apprentissage de cohérence découplé

Pour le processus de distillation de cohérence, les développeurs ont observé que les données utilisées pour la formation influencent fortement la qualité de la génération finale des modèles de cohérence. Cependant, le problème majeur avec les ensembles de données accessibles au public actuellement est qu'ils sont souvent constitués de données filigranées, ou de mauvaise qualité, et peuvent contenir des légendes trop brèves ou ambiguës. De plus, entraîner le modèle directement sur des vidéos à grande résolution est coûteux en termes de calcul et prend du temps, ce qui en fait une option non réalisable pour la majorité des chercheurs.

Compte tenu de la disponibilité d'ensembles de données filtrés de haute qualité, le framework AnimateLCM propose de découpler la distillation des a priori de mouvement et des a priori de génération d'images. Pour être plus précis, le framework AnimateLCM distille d'abord les modèles de diffusion stables en modèles de cohérence d'image avec des ensembles de données de texte d'image filtrés de haute qualité avec une meilleure résolution. Le cadre entraîne ensuite les poids LoRA légers au niveau des couches du modèle de diffusion stable, gelant ainsi les poids du modèle stable. modèle de diffusion. Une fois que le modèle a réglé les poids LoRA, il fonctionne comme un module d'accélération polyvalent et a démontré sa compatibilité avec d'autres modèles personnalisés dans les communautés de diffusion stables. Pour l'inférence, le framework AnimateLCM fusionne les poids de la LoRA avec les poids d'origine sans corrompre la vitesse d'inférence. Une fois que le framework AnimateLCM a obtenu le modèle de cohérence au niveau de la génération d'images, il gèle les poids du modèle de diffusion stable et les poids LoRA dessus. De plus, le modèle gonfle les noyaux de convolution 2D en noyaux pseudo-3D pour former les modèles de cohérence pour la génération vidéo. Le modèle ajoute également des couches temporelles avec une initialisation nulle et une connexion résiduelle au niveau du bloc. La configuration globale permet de garantir que la sortie du modèle ne sera pas influencée lors de son premier entraînement. Le cadre AnimateLCM, sous la direction de modèles de diffusion vidéo open source, entraîne les couches temporelles étendues à partir des modèles de diffusion stables.

Il est important de reconnaître que même si les poids LoRA spatiaux sont conçus pour accélérer le processus d'échantillonnage sans prendre en compte la modélisation temporelle et que les modules temporels sont développés au moyen de techniques de diffusion standard, leur intégration directe a tendance à corrompre la représentation au début de la formation. Cela présente des défis importants pour les fusionner de manière efficace et efficiente avec un minimum de conflits. Grâce à des recherches empiriques, le cadre AnimateLCM a identifié une approche d'initialisation réussie qui utilise non seulement les priorités de cohérence des poids LoRA spatiaux, mais atténue également les effets négatifs de leur combinaison directe.

Au début de l'entraînement à la cohérence, les poids LoRA spatiaux pré-entraînés sont intégrés exclusivement dans le modèle de cohérence en ligne, épargnant ainsi l'insertion du modèle de cohérence cible. Cette stratégie garantit que le modèle cible, servant de guide pédagogique pour le modèle en ligne, ne génère pas de prédictions erronées qui pourraient nuire au processus d'apprentissage du modèle en ligne. Tout au long de la période d'entraînement, les poids LoRA sont progressivement incorporés dans le modèle de cohérence cible via un processus de moyenne mobile exponentielle (EMA), permettant d'obtenir l'équilibre de poids optimal après plusieurs itérations.

Adaptation gratuite pour les enseignants

Les modèles à diffusion stable et les adaptateurs plug and play vont souvent de pair. Cependant, il a été observé que même si les adaptateurs plug and play fonctionnent dans une certaine mesure, ils ont tendance à perdre le contrôle des détails même lorsqu'une majorité de ces adaptateurs sont formés avec des modèles de diffusion d'images. Pour contrer ce problème, le framework AnimateLCM opte pour une adaptation sans enseignant, une stratégie simple mais efficace qui soit s'adapte aux adaptateurs existants pour une meilleure compatibilité, soit forme les adaptateurs à partir de zéro ou. L'approche permet au cadre AnimateLCM de réaliser la génération vidéo contrôlable et la génération d'image en vidéo avec un nombre minimal d'étapes sans nécessiter de modèles d'enseignant.

AnimateLCM : expériences et résultats

Le framework AnimateLCM utilise Stable Diffusion v1-5 comme modèle de base et implémente le solveur DDIM ODE à des fins de formation. Le cadre applique également la diffusion stable v1-5 avec des poids de mouvement open source comme modèle de diffusion vidéo pour les enseignants, les expériences étant menées sur l'ensemble de données WebVid2M sans aucune donnée supplémentaire ou augmentée. De plus, le cadre utilise l'ensemble de données TikTok avec de brèves invites textuelles sous-titrées BLIP pour la génération de vidéos contrôlables.

Résultats qualitatifs

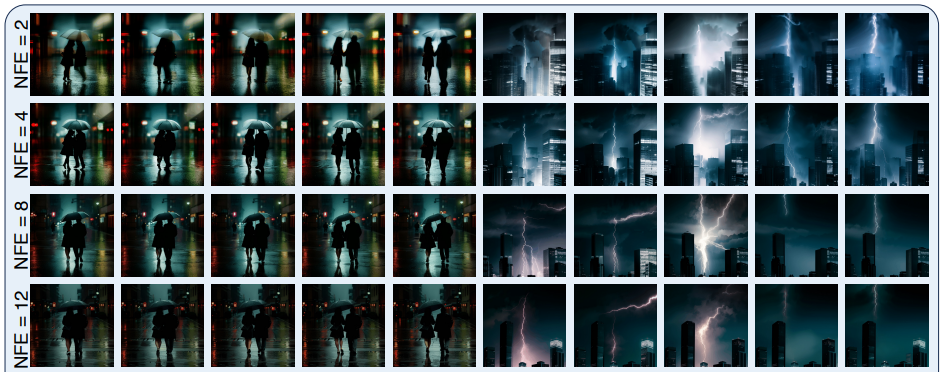

La figure suivante montre les résultats de la méthode de génération en quatre étapes mise en œuvre par le framework AnimateLCM dans la génération texte-vidéo, la génération image-vidéo et la génération vidéo contrôlable.

Comme on peut l'observer, les résultats fournis par chacun d'eux sont satisfaisants, les résultats générés démontrant la capacité du framework AnimateLCM à suivre la propriété de cohérence même avec différentes étapes d'inférence, en conservant un mouvement et un style similaires.

Résultats quantitatifs

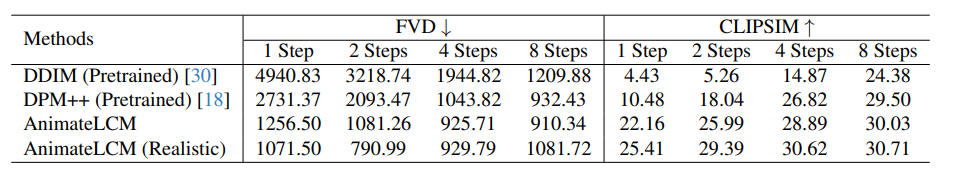

La figure suivante illustre les résultats quantitatifs et la comparaison du framework AnimateLCM avec les méthodes de pointe DDIM et DPM++.

Comme on peut l’observer, le framework AnimateLCM surpasse largement les méthodes existantes, en particulier dans le régime à faibles étapes allant de 1 à 4 étapes. De plus, les métriques AnimateLCM affichées dans cette comparaison sont évaluées sans utiliser le CFG ou les conseils gratuits du classificateur, ce qui permet au framework d'économiser près de 50 % du temps d'inférence et du coût maximal de la mémoire d'inférence. De plus, pour valider davantage ses performances, les pondérations spatiales dans le cadre AnimateLCM sont remplacées par un modèle réaliste personnalisé accessible au public qui établit un bon équilibre entre fidélité et diversité, ce qui contribue à améliorer davantage les performances.

Réflexions finales

Dans cet article, nous avons parlé d'AnimateLCM, un modèle de diffusion personnalisé avec des adaptateurs qui vise à générer des vidéos haute fidélité avec des étapes et des coûts de calcul minimes. Le cadre AnimateLCM s'inspire du modèle de cohérence qui accélère l'échantillonnage avec des étapes minimales en distillant des modèles de diffusion d'images pré-entraînés, et de l'extension réussie du modèle de cohérence, du modèle de cohérence latente ou LCM qui facilite la génération d'images conditionnelles. Au lieu de procéder directement à un apprentissage de cohérence sur l'ensemble de données vidéo brutes, le cadre AnimateLCM propose d'utiliser une stratégie d'apprentissage de cohérence découplée qui dissocie la distillation des a priori de génération de mouvement et des a priori de génération d'images, permettant au modèle d'améliorer la qualité visuelle du contenu généré, et améliorer simultanément l'efficacité de la formation.