Andersonin kulma

Ihmiskuvien palauttaminen ja muokkaaminen tekoälyn avulla

Kalifornian yliopiston Mercedin ja Adoben uusi yhteistyö tarjoaa edistysaskeleen huipputeknologiassa ihmisen kuvan täydentäminen – paljon tutkittu tehtävä ihmisten kuvien peitettyjen tai piilossa olevien osien "sumentamiseksi" esimerkiksi virtuaalinen kokeilu, animaatio ja kuvankäsittely.

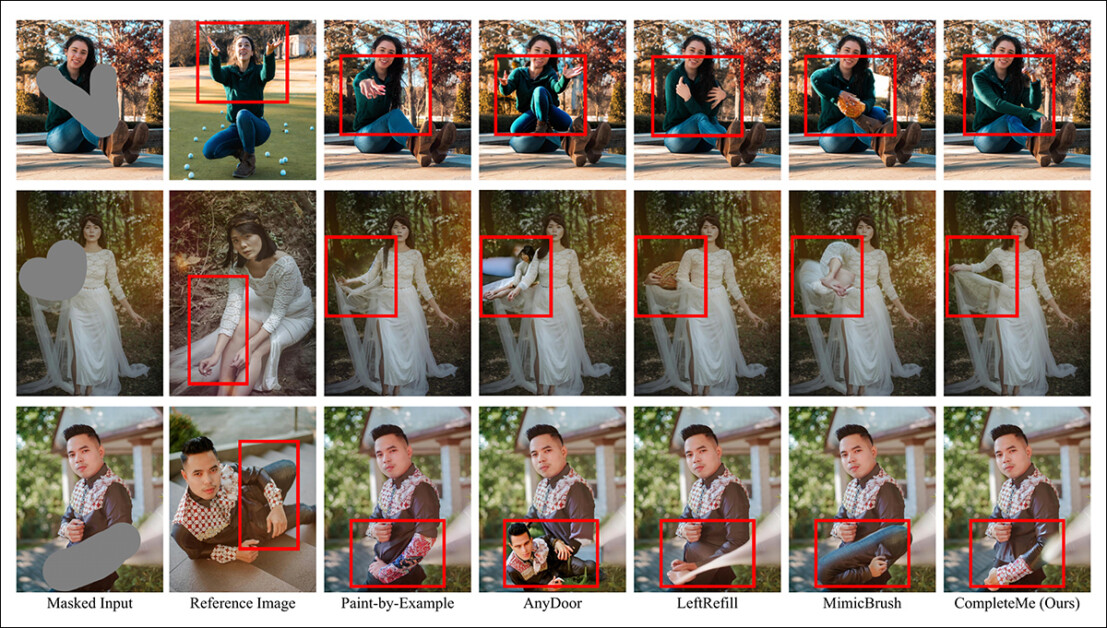

Vaurioituneiden kuvien korjaamisen tai niiden muuttamisen käyttäjän mielijohteesta lisäksi ihmisen tekemät kuvantäydennysjärjestelmät, kuten CompleteMe, voivat lisätä uusia vaatteita (lisäreferenssikuvan avulla, kuten näiden kahden esimerkin keskimmäisessä sarakkeessa) olemassa oleviin kuviin. Nämä esimerkit ovat uuden artikkelin laajasta PDF-lisätiedostosta. Lähde: https://liagm.github.io/CompleteMe/pdf/supp.pdf

- uusi lähestymistapa, nimeltään CompleteMe: Referenssipohjainen ihmiskuvan täydennys, käyttää täydentäviä syöttökuvia ehdottaakseen järjestelmälle, millä sisällöllä tulisi korvata ihmisen kuvauksen piilossa oleva tai puuttuva osa (tästä syystä sovellettavissa muotipohjaisiin sovituskehyksiin):

CompleteMe-järjestelmä voi mukauttaa viitesisällön ihmiskuvan peitettyyn tai peitettyyn osaan.

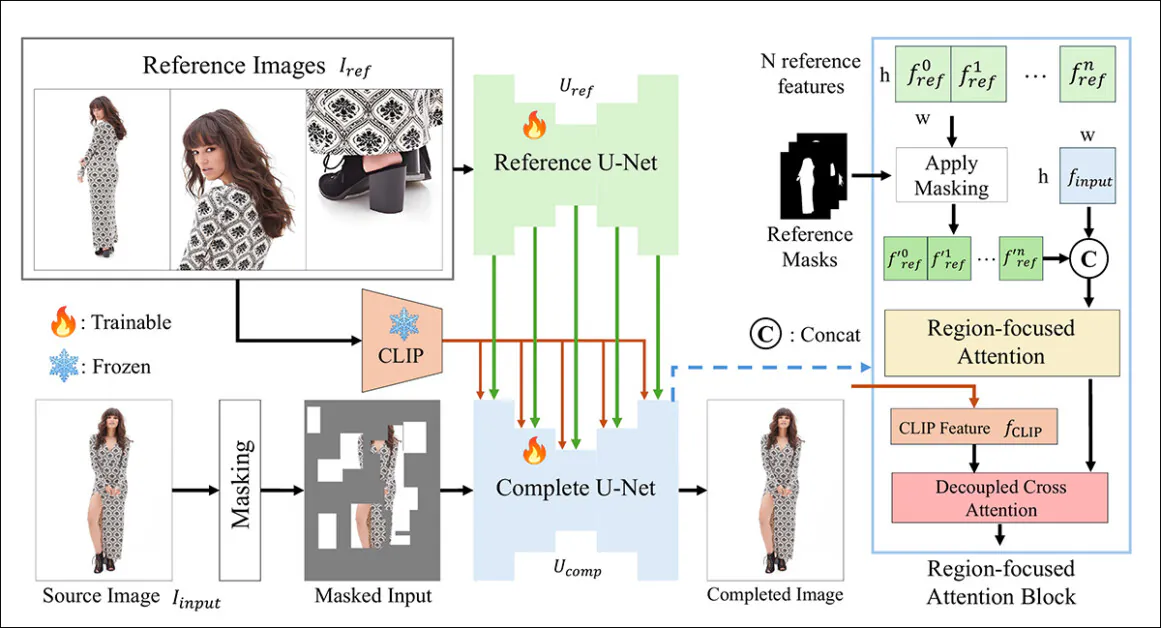

Uusi järjestelmä käyttää kaksois- U-Net arkkitehtuuri ja Aluekeskeinen huomio (RFA) -lohko, joka ohjaa resursseja kuvan palautusinstanssin asiaankuuluvalle alueelle.

Tutkijat tarjoavat myös uuden ja haastavan vertailujärjestelmän, joka on suunniteltu arvioimaan referenssipohjaisia suoritustehtäviä (koska CompleteMe on osa olemassa olevaa ja jatkuvaa konenäön tutkimuslinjaa, vaikkakin sellaista, jolla ei ole tähän asti ollut vertailujärjestelmää).

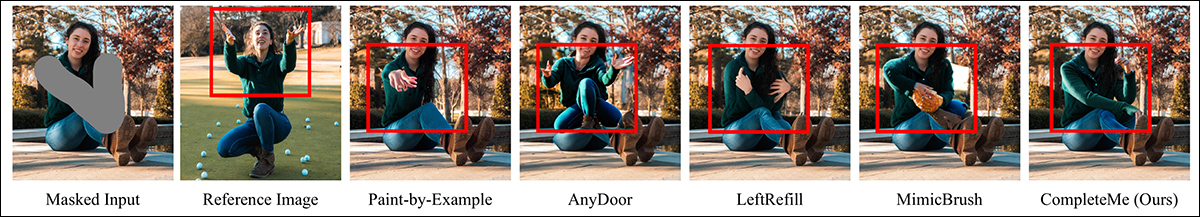

Testeissä ja laajasti skaalatussa käyttäjätutkimuksessa uusi menetelmä oli parempi useimmissa mittareissa ja kokonaisuudessaankin. Joissakin tapauksissa referenssipohjainen lähestymistapa peittosi kilpailevat menetelmät täysin:

Lisämateriaalista: AnyDoor-menetelmällä on erityisen vaikeaa päättää, miten referenssikuvaa tulisi tulkita.

Paperissa todetaan:

Laajat kokeet vertailuarvollamme osoittavat, että CompleteMe suoriutuu paremmin kuin huippuluokan menetelmät, sekä referenssipohjaiset että ei-referenssipohjaiset, kvantitatiivisten mittareiden, kvalitatiivisten tulosten ja käyttäjätutkimusten osalta.

"Erityisesti haastavissa tilanteissa, joissa on monimutkaisia asentoja, monimutkaisia vaatekuvioita ja omaleimaisia asusteita, mallimme saavuttaa jatkuvasti erinomaisen visuaalisen tarkkuuden ja semanttisen yhtenäisyyden."

Valitettavasti projektin GitHub-läsnäolo ei sisällä koodia eikä lupaa mitään, ja aloite, jolla on myös vaatimaton Hankkeen sivu, näyttää olevan kehystetty omaksi arkkitehtuuriksi.

Lisää esimerkkejä uuden järjestelmän subjektiivisesta suorituskyvystä aiempiin menetelmiin verrattuna. Lisätietoja myöhemmin artikkelissa.

Menetelmä

CompleteMe-kehystä tukee Reference U-Net, joka käsittelee apumateriaalien integroinnin prosessiin, sekä koheesiivinen U-Net, joka kattaa laajemman valikoiman prosesseja lopputuloksen saavuttamiseksi, kuten alla olevassa käsitteellisessä kaaviossa on esitetty:

CompleteMe:n käsitteellinen skeema. Lähde: https://arxiv.org/pdf/2504.20042

Järjestelmä koodaa ensin maskatun syötekuvan latenttimuotoon. Samaan aikaan Reference U-Net käsittelee useita referenssikuvia – joista jokainen näyttää eri kehon alueita – saadakseen yksityiskohtaisen spatiaalisen kuvan. piirteet.

Nämä ominaisuudet kulkevat aluekeskeisen huomiolohkon läpi, joka on upotettu "täydelliseen" U-Netiin, jossa ne ovat valikoivasti peitetty käyttämällä vastaavia aluemaskeja varmistaen, että malli huomioi vain referenssikuvien olennaisia alueita.

Peitetyt ominaisuudet integroidaan sitten globaaleihin CLIP-johdetut semanttiset piirteet irrotetun tiedon avulla ristiin huomiota, jolloin malli pystyy rekonstruoimaan puuttuvan sisällön sekä hienovaraisesti että semanttisesti yhtenäisesti.

Realismin ja luotettavuuden parantamiseksi syötteen peittämisprosessi yhdistää satunnaisia ruudukkopohjaisia peittoja ihmiskehon muodon peitteisiin, joita kutakin käytetään yhtä todennäköisesti, mikä lisää mallin täydentämien puuttuvien alueiden monimutkaisuutta.

Ainoastaan viitteellinen

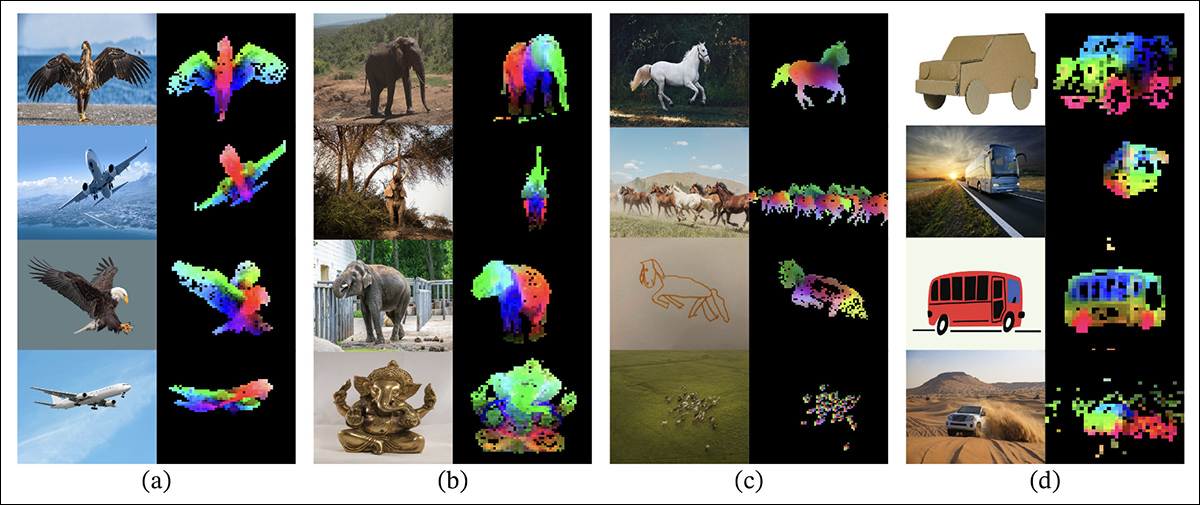

Aiemmat referenssipohjaisen kuvan päällemaalauksen menetelmät perustuivat tyypillisesti semanttisella tasolla kooderit. Tällaisia projekteja ovat itse CLIP ja DINOv2, jotka molemmat poimivat globaaleja piirteitä referenssikuvista, mutta usein menettävät tarkkoja paikkatietoja, joita tarvitaan identiteetin tarkkaan säilyttämiseen.

Vanhemman DINOV2-lähestymistavan julkaisuartikkelista, joka sisältyy uuden tutkimuksen vertailutesteihin: Värilliset päällekkäiskuvat näyttävät pääkomponenttianalyysin (PCA) kolme ensimmäistä pääkomponenttia, joita on sovellettu kunkin sarakkeen kuvapaikkoihin. Tämä korostaa, miten DINOV2 ryhmittelee samanlaisia objektin osia yhteen eri kuvissa. Asennon, tyylin tai renderöinnin eroista huolimatta vastaavat alueet (kuten siivet, raajat tai pyörät) vastaavat toisiaan johdonmukaisesti, mikä osoittaa mallin kyvyn oppia osapohjaista rakennetta ilman valvontaa. Lähde: https://arxiv.org/pdf/2304.07193

CompleteMe käsittelee tätä näkökohtaa erikoistuneen Reference U-Net -palvelun kautta, joka on alustettu Vakaa diffuusio 1.5, mutta toimii ilman diffuusiokohinan askel*.

Jokainen referenssikuva, joka kattaa eri kehon alueita, koodataan yksityiskohtaisiksi latenttisiksi ominaisuuksiksi tämän U-Netin kautta. Globaalit semanttiset ominaisuudet erotetaan myös erikseen CLIP:n avulla, ja molemmat ominaisuusjoukot tallennetaan välimuistiin tehokasta käyttöä varten tarkkaavaisuuspohjaisen integroinnin aikana. Näin järjestelmä voi joustavasti ottaa vastaan useita referenssituloja säilyttäen samalla hienojakoisen ulkonäkötiedon.

orkestrointi

Yhtenäinen U-Net hallinnoi valmistumisprosessin viimeisiä vaiheita. Mukailtu teoksesta sisäänmaalausvariantti Stable Diffusion 1.5:ssä se ottaa syötteeksi maskatun lähdekuvan latenttimuodossa sekä referenssikuvista johdetut yksityiskohtaiset spatiaaliset piirteet ja CLIP-kooderin poimimat globaalit semanttiset piirteet.

Nämä eri syötteet kootaan yhteen RFA-lohkon kautta, jolla on ratkaiseva rooli mallin painopisteen ohjaamisessa viitemateriaalin olennaisimpiin alueisiin.

Ennen huomiomekanismiin siirtymistä referenssiominaisuudet peitetään eksplisiittisesti toisiinsa liittymättömien alueiden poistamiseksi ja yhdistetään sitten lähdekuvan latenttiesitykseen varmistaen, että huomio kohdistuu mahdollisimman tarkasti.

Tämän integraation parantamiseksi CompleteMe sisältää irrotetun ristihuomiomekanismin, joka on mukautettu IP-sovitin puitteissa:

IP-Adapter, josta osa on integroitu CompleteMe:hen, on yksi onnistuneimmista ja usein hyödynnetyimmistä projekteista viimeisten kolmen myrskyisän latenttien diffuusiomalliarkkitehtuurien kehitysvuoden aikana. Lähde: https://ip-adapter.github.io/

Tämä mahdollistaa mallin käsitellä spatiaalisesti yksityiskohtaisia visuaalisia piirteitä ja laajempaa semanttista kontekstia erillisten huomiovirtojen kautta, jotka myöhemmin yhdistetään, jolloin tuloksena on koherentti rekonstruktio, joka kirjoittajien mukaan säilyttää sekä identiteetin että hienojakoiset yksityiskohdat.

benchmarking

Koska sopivaa referenssipohjaista ihmisen täydennystä varten tarkoitettua datajoukkoa ei ollut, tutkijat ovat ehdottaneet omaa. (Nimeämätön) vertailuarvo rakennettiin kuratoimalla valittuja kuvapareja WPose-datajoukosta, joka laadittiin Adobe Researchin vuoden 2023 tutkimuksessa. UniHuman projekti.

Esimerkkejä Adobe Research 2023 UniHuman -projektin asennoista. Lähde: https://github.com/adobe-research/UniHuman?tab=readme-ov-file#data-prep

Tutkijat piirsivät manuaalisesti lähdemaskeja osoittaakseen päällemaalatut alueet, jolloin saatiin lopulta 417 kolmiosaista kuvaryhmää, jotka muodostivat lähdekuvan, maskin ja vertailukuvan.

Kaksi esimerkkiä ryhmistä on alun perin johdettu WPose-referenssiaineistosta, ja uuden artikkelin tutkijat ovat kuratoineet niitä laajasti.

Kirjoittajat käyttivät LLaVA Large Language Model (LLM) lähdekuvia kuvaavien tekstikehotteiden luomiseen.

Käytetyt mittarit olivat tavallista laajempia; tavanomaisten lisäksi Huippusignaali-kohinasuhde (PSNR) Rakenteellisen samankaltaisuuden indeksi (SSIM) ja Opittu havainnollisen kuvan samankaltaisuus (LPIPS, tässä tapauksessa peitettyjen alueiden arviointiin), tutkijat käyttivät DINOa samankaltaisuuspisteiden saamiseksi; DreamSim sukupolven tulosten arviointia varten; ja CLIP.

Tiedot ja testit

Työn testaamiseksi kirjoittajat käyttivät sekä oletusarvoista Stable Diffusion V1.5 -mallia että 1.5-päällemaalausmallia. Järjestelmän kuvakooderi käytti CLIP-ominaisuutta. Visio malli yhdessä projektiokerrosten kanssa – vaatimattomien neuroverkkojen, jotka muokkaavat tai yhdenmukaistavat CLIP-lähtöjä vastaamaan mallin käyttämiä sisäisiä ominaisuusmittoja.

Koulutusta tehtiin 30,000 100 iteraation ajan kahdeksalla NVIDIA AXNUMX -näytönohjaimella.† Näytönohjaimet, joita valvoo Keskimääräinen neliövirhe (MSE) tappio erän koko 64 XNUMX ja a oppimisnopeus 2 x 10-5Harjoittelun aikana pudotettiin satunnaisesti erilaisia elementtejä järjestelmän estämiseksi. liikaa tietoja.

Aineistoa on muokattu Osia kokonaisuudeksi tietojoukko, joka itse perustuu DeepFashion-MultiModal aineisto.

Esimerkkejä Parts to Whole -aineistosta, jota käytettiin CompleteMe:n kuratoidun datan kehittämisessä. Lähde: https://huanngzh.github.io/Parts2Whole/

Kirjoittajat toteavat:

"Vaatimuksiemme täyttämiseksi [rakensimme] harjoitusparit uudelleen käyttämällä peitettyjä kuvia useilla referenssikuvilla, jotka tallentavat ihmisen ulkonäön eri puolia lyhyine tekstitunnisteineen."

Jokainen harjoitusdatan näyte sisältää kuusi ulkonäkötyyppiä: ylävartalon vaatteet, alavartalon vaatteet, kokovartalon vaatteet, hiukset tai päähine, kasvot ja kengät. Maskausstrategiassa käytämme 50 % satunnaista ruudukkomaskia 1–30 kertaa, kun taas lopuille 50 %:lle käytämme ihmiskehon muodon mukaista maskia maskauksen monimutkaisuuden lisäämiseksi.

"Rakennusputken jälkeen saimme 40,000 XNUMX kuvaparia koulutusta varten."

Kilpailija ennen ei-viittaus testattuja menetelmiä olivat Suuri peitetty ihmiskuva täydentyy (LOHC) ja plug-and-play-kuvan sisäänmaalausmalli BrushNettestattuja referenssipohjaisia malleja Maalaa esimerkin mukaan; AnyDoor; LeftRefill, Ja MimicBrush.

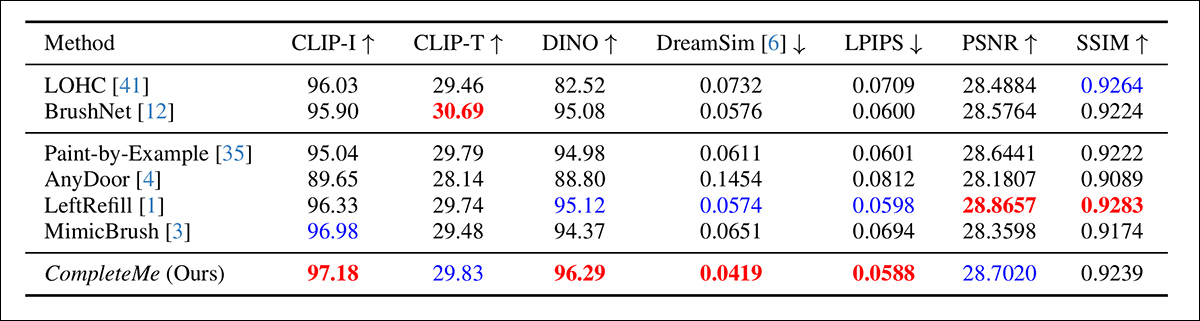

Kirjoittajat aloittivat aiemmin mainittujen mittareiden kvantitatiivisella vertailulla:

Alkuperäisen kvantitatiivisen vertailun tulokset.

Määrällisen arvioinnin osalta kirjoittajat huomauttavat, että CompleteMe saavuttaa korkeimmat pisteet useimmissa havaintomittareissa, mukaan lukien CLIP-I, DINO, DreamSim ja LPIPS, joiden tarkoituksena on tallentaa semanttinen kohdistus ja ulkonäön tarkkuus tulosteen ja vertailukuvan välillä.

Malli ei kuitenkaan päihitä kaikkia lähtötasoja kaikilla osa-alueilla. Huomionarvoista on, että BrushNet saa parhaat pisteet CLIP-T:ssä, LeftRefillin johdot SSIM:ssä ja PSNR:ssä, ja MimicBrush suoriutuu hieman paremmin CLIP-I:ssä.

Vaikka CompleteMe osoittaa yleisesti ottaen jatkuvasti vahvoja tuloksia, suorituskykyerot ovat joissakin tapauksissa maltillisia, ja tiettyjä mittareita johtavat edelleen kilpailevat aiemmat menetelmät. Ehkäpä eivät epäoikeudenmukaisestikaan kirjoittajat esittävät nämä tulokset todisteena CompleteMe:n tasapainoisesta vahvuudesta sekä rakenteellisissa että havaintokykyisissä ulottuvuuksissa.

Tutkimuksessa käytettyjen laadullisten testien kuvituksia on aivan liian paljon toistettavaksi tässä, ja viittaamme lukijaan paitsi lähdejulkaisuun myös laajaan... täydentävä PDF, joka sisältää monia muita laadullisia esimerkkejä.

Nostamme esiin pääartikkelissa esitetyt tärkeimmät laadulliset esimerkit sekä valikoiman lisätapauksia aiemmin tässä artikkelissa esitellystä täydentävästä kuvapankista:

Alustavat laadulliset tulokset on esitetty pääjulkaisussa. Katso lähdejulkaisusta parempi resoluutio.

Yllä esitetyistä laadullisista tuloksista kirjoittajat kommentoivat:

'Maskattujen syötteiden perusteella nämä ei-viittausmenetelmät luovat uskottavaa sisältöä maskatuille alueille käyttämällä kuvaprioreita tai tekstikehotteita.'

"Kuten punaisessa laatikossa on mainittu, ne eivät kuitenkaan pysty toistamaan tiettyjä yksityiskohtia, kuten tatuointeja tai ainutlaatuisia vaatekuvioita, koska niiltä puuttuu vertailukuvia, jotka ohjaisivat identtisten tietojen rekonstruointia."

Toinen vertailu, jonka osa on esitetty alla, keskittyy neljään referenssipohjaiseen menetelmään: Paint-by-Example, AnyDoor, LeftRefill ja MimicBrush. Tässä käytettiin vain yhtä referenssikuvaa ja tekstikehotetta.

Laadullinen vertailu referenssipohjaisiin menetelmiin. CompleteMe tuottaa realistisempia täydennyksiä ja säilyttää paremmin referenssikuvan tietyt yksityiskohdat. Punaiset laatikot korostavat erityisen kiinnostavia alueita.

Kirjoittajat toteavat:

"Maskatun ihmiskuvan ja vertailukuvan avulla muut menetelmät voivat tuottaa uskottavaa sisältöä, mutta usein ne eivät säilytä vertailukuvan kontekstuaalista tietoa tarkasti."

"Joissakin tapauksissa ne tuottavat epäolennaista sisältöä tai kartoittavat virheellisesti vastaavat osat vertailukuvasta. CompleteMe sitä vastoin täydentää peitetyn alueen tehokkaasti säilyttämällä identtiset tiedot tarkasti ja kartoittamalla ihmiskehon vastaavat osat oikein vertailukuvasta."

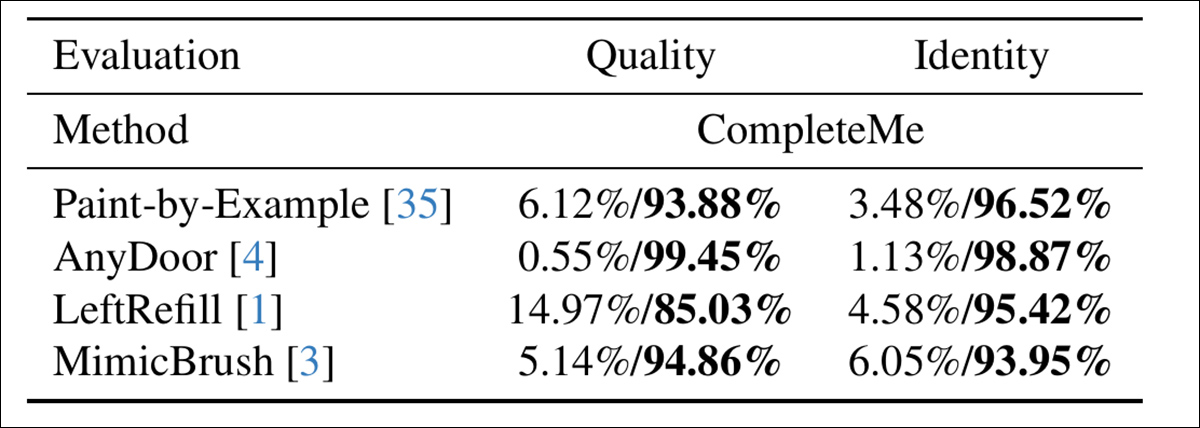

Arvioidakseen, kuinka hyvin mallit vastaavat ihmisen havainnointikykyä, kirjoittajat suorittivat käyttäjätutkimuksen, johon osallistui 15 annotaattoria ja 2,895 XNUMX näyteparia. Jokainen pari vertasi CompleteMe:n tuotosta yhteen neljästä referenssipohjaisesta lähtötasosta: Paint-by-Example, AnyDoor, LeftRefill tai MimicBrush.

Annotaattorit arvioivat kutakin tulosta valmiin alueen visuaalisen laadun ja sen perusteella, missä määrin se säilytti vertailualueen identiteettiominaisuudet – ja tässä arvioidessaan kokonaislaatua ja identiteettiä CompleteMe sai selkeämmän tuloksen:

Käyttäjätutkimuksen tulokset.

Yhteenveto

Jos mikään, niin tämän tutkimuksen laadullisia tuloksia heikentää niiden valtava määrä, sillä lähempi tarkastelu osoittaa, että uusi järjestelmä on erittäin tehokas lisä tälle suhteellisen kapealle, mutta kuumana tavoitellulle neurokuvanmuokkauksen alueelle.

Alkuperäisen PDF-tiedoston zoomaaminen ja sen ymmärtäminen, kuinka hyvin järjestelmä mukauttaa referenssimateriaalin peitettyyn alueeseen verrattuna (lähes kaikissa tapauksissa) aiempiin menetelmiin, vaatii kuitenkin hieman lisätarkennusta.

Suosittelemme vahvasti lukijaa tutkimaan huolellisesti lisämateriaalissa esitettyä aluksi hämmentävää, ellei jopa musertavaa, tulosten tulvaa.

* On mielenkiintoista huomata, kuinka nyt pahasti vanhentunut V1.5-julkaisu on edelleen tutkijoiden suosikki – osittain vanhan, samankaltaisen testauksen ansiosta, mutta myös siksi, että se on vähiten sensuroitu ja mahdollisesti helpoimmin koulutettava kaikista Stable Diffusion -iteraatioista, eikä siinä ole samaa sensuroiva ontuva FOSS Flux -julkaisuista.

† VRAM-muistin tietoja ei ole annettu – se olisi joko 40 Gt tai 80 Gt korttia kohden.

Julkaistu ensimmäisen kerran tiistaina 29