El ángulo de Anderson

Casi el 80% de los conjuntos de datos de entrenamiento pueden representar un riesgo legal para la IA empresarial

Un artículo reciente de LG AI Research sugiere que los conjuntos de datos supuestamente "abiertos" utilizados para entrenar modelos de IA pueden ofrecer una falsa sensación de seguridad, y descubrió que casi cuatro de cada cinco conjuntos de datos de IA etiquetados como "comercialmente utilizables" en realidad contienen riesgos legales ocultos.

Estos riesgos abarcan desde la inclusión de material protegido por derechos de autor no divulgado hasta condiciones de licencia restrictivas, profundamente arraigadas en las dependencias de un conjunto de datos. Si las conclusiones del artículo son correctas, las empresas que dependen de conjuntos de datos públicos podrían verse obligadas a reconsiderar sus procesos actuales de IA o arriesgarse a una exposición legal posterior.

Los investigadores proponen una solución radical y potencialmente controvertida: agentes de cumplimiento basados en IA capaces de escanear y auditar historiales de conjuntos de datos con mayor rapidez y precisión que los abogados humanos.

El documento dice:

'Este documento sostiene que el riesgo legal de los conjuntos de datos de entrenamiento de IA no se puede determinar únicamente revisando los términos de la licencia a nivel superficial; un análisis exhaustivo de extremo a extremo de la redistribución del conjunto de datos es esencial para garantizar el cumplimiento.

'Dado que este tipo de análisis está más allá de las capacidades humanas debido a su complejidad y escala, los agentes de IA pueden salvar esta brecha al realizarlo con mayor velocidad y precisión. Sin automatización, los riesgos legales críticos quedan en gran medida sin examinar, lo que pone en peligro el desarrollo ético de la IA y el cumplimiento de las normativas.

'Instamos a la comunidad de investigación de IA a reconocer el análisis legal de extremo a extremo como un requisito fundamental y a adoptar enfoques impulsados por IA como el camino viable hacia el cumplimiento escalable de los conjuntos de datos'.

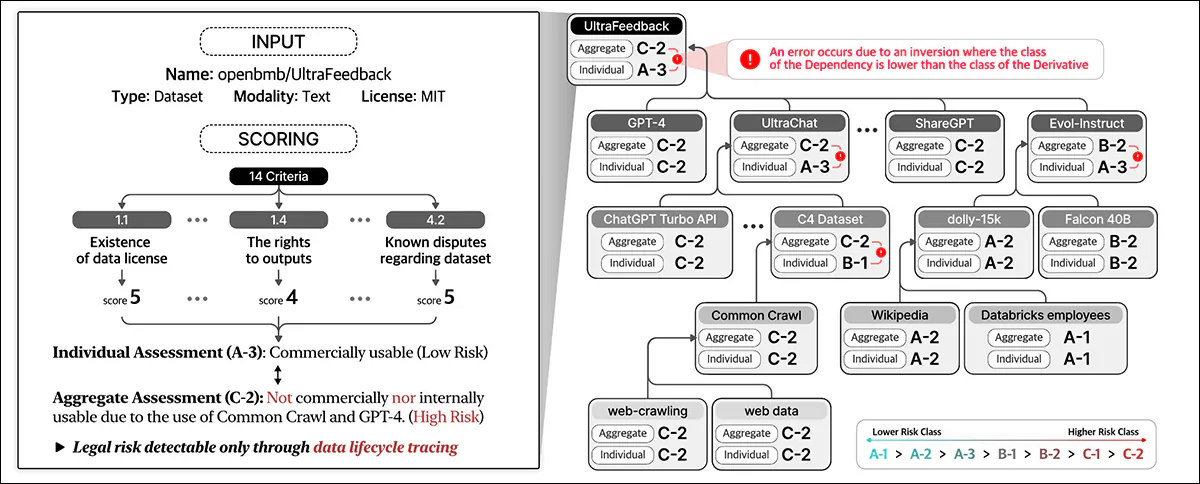

Al examinar 2,852 conjuntos de datos populares que parecían comercialmente utilizables según sus licencias individuales, el sistema automatizado de los investigadores descubrió que solo 605 (alrededor del 21 %) eran realmente seguros legalmente para su comercialización una vez que se rastrearon todos sus componentes y dependencias.

El nuevo documento se titula No confíe en las licencias que ve: el cumplimiento de los conjuntos de datos requiere un seguimiento del ciclo de vida a gran escala impulsado por IA, y proviene de ocho investigadores de LG AI Research.

Lo que está bien y lo que está mal

Los autores destacan la retos a las que se enfrentan las empresas que impulsan el desarrollo de IA en un panorama legal cada vez más incierto, ya que la antigua mentalidad académica de "uso justo" en torno al entrenamiento de conjuntos de datos da paso a un entorno fracturado donde las protecciones legales no son claras y el puerto seguro ya no está garantizado.

Como una publicación señaló Recientemente, las empresas se están poniendo cada vez más a la defensiva en lo que respecta a las fuentes de sus datos de formación. El autor Adam Buick comenta*:

'[Si bien] OpenAI reveló las principales fuentes de datos para GPT-3, el documento que presenta GPT-4 revelado Sólo que los datos con los que se había entrenado el modelo eran una mezcla de "datos disponibles públicamente (como datos de Internet) y datos licenciados por proveedores externos".

'Las motivaciones detrás de este alejamiento de la transparencia no han sido articuladas con ningún detalle particular por los desarrolladores de IA, quienes en muchos casos no han dado ninguna explicación en absoluto.

'Por su parte, OpenAI justificó su decisión de no publicar más detalles sobre GPT-4 basándose en preocupaciones sobre "el panorama competitivo y las implicaciones de seguridad de los modelos a gran escala", sin más explicaciones en el informe.'

La transparencia puede ser un término engañoso, o simplemente erróneo; por ejemplo, el producto estrella de Adobe Luciérnaga El modelo generativo, entrenado con datos de stock que Adobe tenía los derechos para explotar, supuestamente ofrecía a los clientes garantías sobre la legalidad de su uso del sistema. Más tarde, algunos surgió evidencia que el conjunto de datos de Firefly se había "enriquecido" con datos potencialmente sujetos a derechos de autor de otras plataformas.

Como hemos discutido a principios de esta semanaExisten cada vez más iniciativas diseñadas para garantizar el cumplimiento de las licencias en los conjuntos de datos, incluida una que solo extraerá videos de YouTube con licencias Creative Commons flexibles.

El problema es que las licencias en sí mismas pueden ser erróneas o haber sido otorgadas por error, como parece indicar la nueva investigación.

Análisis de conjuntos de datos de código abierto

Resulta difícil desarrollar un sistema de evaluación como el Nexus de los autores cuando el contexto cambia constantemente. Por lo tanto, el artículo afirma que el sistema del marco de Cumplimiento de Datos NEXUS se basa en diversos precedentes y fundamentos jurídicos en la actualidad.

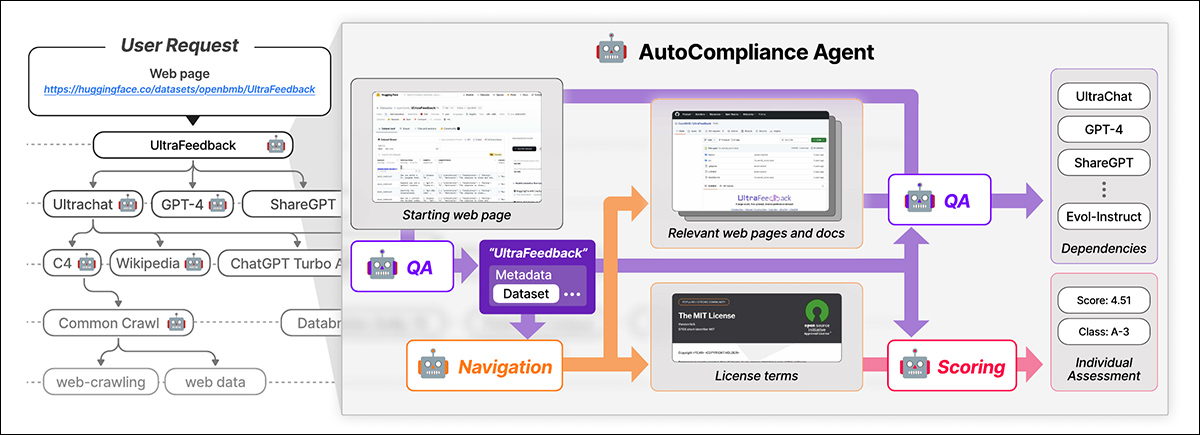

NEXUS utiliza un agente impulsado por IA llamado Cumplimiento automático para el cumplimiento automatizado de los datos. AutoCompliance consta de tres módulos clave: un módulo de navegación para la exploración web; un módulo de preguntas y respuestas (QA) para la extracción de información; y un módulo de puntuación para la evaluación de riesgos legales.

AutoCompliance comienza con una página web proporcionada por el usuario. La IA extrae detalles clave, busca recursos relacionados, identifica términos y dependencias de licencias y asigna una puntuación de riesgo legal.. Fuente: https://arxiv.org/pdf/2503.02784

Estos módulos están impulsados por modelos de IA perfeccionados, incluido el EXAONE-3.5-32B-Instruir modelo, entrenado con datos sintéticos y etiquetados por humanos. AutoCompliance también utiliza una base de datos para almacenar en caché los resultados y mejorar la eficiencia.

AutoCompliance comienza con la URL de un conjunto de datos proporcionado por el usuario y lo trata como entidad raíz, buscando sus términos de licencia y dependencias, y rastreando recursivamente los conjuntos de datos vinculados para crear un gráfico de dependencia de licencias. Una vez que se asignan todas las conexiones, calcula los puntajes de cumplimiento y asigna clasificaciones de riesgo.

El marco de cumplimiento de datos descrito en el nuevo trabajo identifica varios† tipos de entidades involucradas en el ciclo de vida de los datos, incluyendo conjuntos de datos, que constituyen la base de la información para el entrenamiento de la IA; Software de procesamiento de datos y modelos de IA, que se utilizan para transformar y utilizar los datos; y Proveedores de servicios de plataforma, que facilitan el manejo de datos.

El sistema evalúa de manera integral los riesgos legales al considerar estas diversas entidades y sus interdependencias, yendo más allá de la evaluación rutinaria de las licencias de los conjuntos de datos para incluir un ecosistema más amplio de los componentes involucrados en el desarrollo de la IA.

Data Compliance evalúa el riesgo legal durante todo el ciclo de vida de los datos. Asigna puntuaciones en función de los detalles del conjunto de datos y de 14 criterios, clasificando entidades individuales y agregando el riesgo en todas las dependencias.

Capacitación y métricas

Los autores extrajeron las URL de los 1,000 conjuntos de datos más descargados en Hugging Face, submuestreando aleatoriamente 216 elementos para constituir un conjunto de prueba.

El modelo EXAONE fue afinado en el conjunto de datos personalizado de los autores, con el módulo de navegación y el módulo de preguntas y respuestas utilizando datos sintéticosy el módulo de puntuación que utiliza datos etiquetados por humanos.

Cinco expertos legales capacitados durante al menos 31 horas en tareas similares crearon las etiquetas de verdad fundamental. Estos expertos humanos identificaron manualmente las dependencias y los términos de licencia para 216 casos de prueba y luego agregaron y refinaron sus hallazgos mediante un debate.

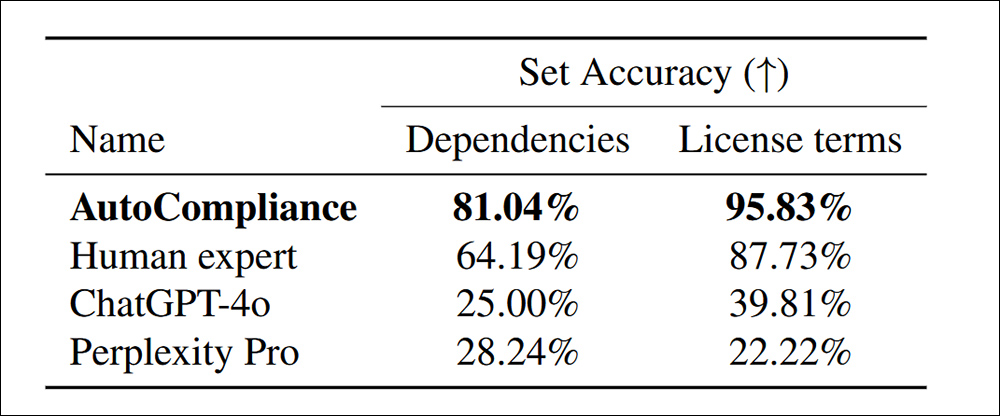

Con el sistema AutoCompliance entrenado y calibrado por humanos, probado contra ChatGPT-4o Perplexity Pro, se descubrieron notablemente más dependencias dentro de los términos de la licencia:

Precisión en la identificación de dependencias y términos de licencia para 216 conjuntos de datos de evaluación.

El documento dice:

'AutoCompliance supera significativamente a todos los demás agentes y al experto humano, logrando una precisión del 81.04 % y del 95.83 % en cada tarea. Por el contrario, tanto ChatGPT-4o como Perplexity Pro muestran una precisión relativamente baja para las tareas de origen y licencia, respectivamente.

'Estos resultados resaltan el desempeño superior de AutoCompliance, demostrando su eficacia en el manejo de ambas tareas con notable precisión, al tiempo que indican una brecha de desempeño sustancial entre los modelos basados en IA y los expertos humanos en estos dominios'.

En términos de eficiencia, el enfoque AutoCompliance tardó solo 53.1 segundos en ejecutarse, en contraste con los 2,418 segundos de una evaluación humana equivalente en las mismas tareas.

Además, la evaluación costó 0.29 USD, en comparación con los 207 USD que costó a los expertos humanos. Sin embargo, cabe señalar que esto se basa en el alquiler mensual de un nodo GCP a2-megagpu-16gpu a una tasa de 14,225 XNUMX USD por mes, lo que significa que este tipo de rentabilidad está relacionada principalmente con una operación a gran escala.

Investigación de conjuntos de datos

Para el análisis, los investigadores seleccionaron 3,612 conjuntos de datos que combinan los 3,000 conjuntos de datos más descargados de Hugging Face con 612 conjuntos de datos de 2023. Iniciativa de procedencia de datos.

El documento dice:

'A partir de las 3,612 entidades objetivo, identificamos un total de 17,429 entidades únicas, donde 13,817 entidades aparecieron como dependencias directas o indirectas de las entidades objetivo.

'Para nuestro análisis empírico, consideramos que una entidad y su gráfico de dependencia de licencia tienen una estructura de una sola capa si la entidad no tiene ninguna dependencia y una estructura de varias capas si tiene una o más dependencias.

'De los 3,612 conjuntos de datos de destino, 2,086 (57.8%) tenían estructuras de varias capas, mientras que los otros 1,526 (42.2%) tenían estructuras de una sola capa sin dependencias.'

Los conjuntos de datos protegidos por derechos de autor solo se pueden redistribuir con autorización legal, que puede provenir de una licencia, excepciones a la ley de derechos de autor o términos contractuales. La redistribución no autorizada puede generar consecuencias legales, incluidas infracciones de derechos de autor o violaciones contractuales. Por lo tanto, es esencial identificar claramente el incumplimiento.

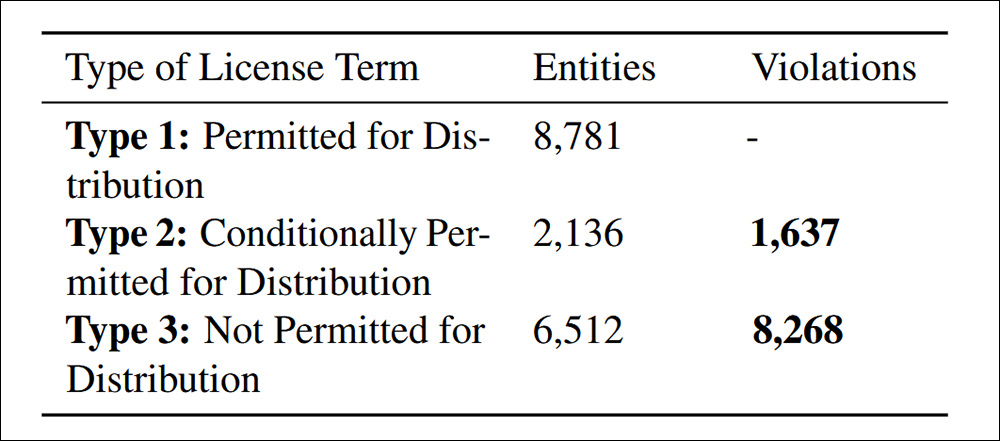

Violaciones de distribución encontradas según el Criterio 4.4 de Cumplimiento de Datos citado en el artículo.

El estudio encontró 9,905 casos de redistribución de conjuntos de datos que no cumplían con las normas, divididos en dos categorías: el 83.5 % estaban explícitamente prohibidos en los términos de la licencia, lo que hacía que la redistribución fuera una clara violación legal; y el 16.5 % involucraba conjuntos de datos con condiciones de licencia conflictivas, donde la redistribución estaba permitida en teoría pero no cumplía con los términos requeridos, lo que creaba un riesgo legal posterior.

Los autores admiten que los criterios de riesgo propuestos en NEXUS no son universales y pueden variar según la jurisdicción y la aplicación de la IA, y que las mejoras futuras deberían centrarse en adaptarse a las regulaciones globales cambiantes y al mismo tiempo refinar la revisión legal impulsada por la IA.

Conclusión

Se trata de un documento prolijo y en gran medida hostil, pero que aborda quizás el mayor factor que retrasa la adopción actual de la IA en la industria: la posibilidad de que datos aparentemente "abiertos" sean posteriormente reclamados por diversas entidades, individuos y organizaciones.

Según la DMCA, las infracciones pueden implicar legalmente multas masivas. por caso Cuando las violaciones pueden ascender a millones, como en los casos descubiertos por los investigadores, la responsabilidad legal potencial es verdaderamente significativa.

Además, las empresas de las que se pueda demostrar que se han beneficiado de los datos anteriores no pueden (como de costumbre) alegan ignorancia como excusa, al menos en el influyente mercado estadounidense. Tampoco cuentan actualmente con herramientas realistas con las que penetrar en las laberínticas implicaciones enterradas en los supuestos acuerdos de licencia de conjuntos de datos de código abierto.

El problema de formular un sistema como NEXUS es que sería bastante difícil calibrarlo a nivel de cada estado dentro de los EE. UU., o a nivel de cada nación dentro de la UE; la perspectiva de crear un marco verdaderamente global (una especie de "Interpol para la procedencia de conjuntos de datos") se ve socavada no sólo por los motivos conflictivos de los diversos gobiernos involucrados, sino por el hecho de que tanto estos gobiernos como el estado de sus leyes actuales a este respecto cambian constantemente.

* Mi sustitución de hipervínculos por las citas de los autores.

† En el documento se prescriben seis tipos, pero los dos últimos no están definidos.

Publicado por primera vez el viernes 7 de marzo de 2025