El ángulo de Anderson

Cómo añadir diálogos a vídeos reales con IA

Un nuevo marco de inteligencia artificial puede reescribir, eliminar o agregar las palabras de una persona en un video sin tener que volver a filmarlo, en un único sistema de extremo a extremo.

Hace tres años, Internet se habría quedado atónito con cualquiera de los 20 o 30 marcos de alteración de videos con IA que se publican en portales académicos semanalmente; tal como están las cosas, esta popular línea de investigación se ha vuelto tan prolífica que casi constituye otra rama de 'AI Slop', y cubro muchos menos lanzamientos de este tipo de los que hubiera cubierto hace dos o tres años.

Sin embargo, un lanzamiento actual en esta línea me llamó la atención: un sistema integrado que puede intervenir en videoclips reales e interponer un nuevo discurso en el video existente (en lugar de crear un clip generativo completo a partir de una cara o un cuadro, lo que es mucho más común).

En los ejemplos a continuación, que edité a partir de una multitud de videos de muestra disponibles en el sitio de lanzamiento, página web del proyecto, primero vemos el clip fuente real y luego, debajo, el discurso de IA impuesto en el medio del clip, incluida la síntesis de voz y la sincronización de labios:

Dele "click" para jugar. Edición local con costura: una de las diversas modalidades que ofrece FacEDiT. Consulte el sitio web original para obtener una mejor resolución. Fuente: https://facedit.github.io/

Este enfoque es uno de los tres desarrollados para el nuevo método, titulado "edición local con costura", y el que más interesa a los autores (y a mí también). En esencia, el clip se amplía utilizando uno de los fotogramas centrales como punto de partida para una nueva interpretación de IA, y su fotograma posterior (real) como objetivo que el clip generativo insertado debe intentar alcanzar. En los clips mostrados arriba, estos fotogramas "semilla" y "objetivo" están representados por la pausa del vídeo superior, mientras que el vídeo modificado inferior proporciona relleno generativo.

Los autores enmarcan este enfoque de síntesis facial y vocal como el primer método de extremo a extremo totalmente integrado para ediciones de video de IA de este tipo, y observan el potencial de un marco completamente desarrollado como este para la producción de televisión y películas:

Los cineastas y productores de medios a menudo necesitan revisar partes específicas de los videos grabados; quizás se dijo mal una palabra o se cambió el guion después de la filmación. Por ejemplo, en la icónica escena de Titanic (1997) donde Rose dice, "Nunca te dejaré ir, Jack" El director podría decidir más tarde que debería ser “Nunca te olvidaré, Jack”.

Tradicionalmente, estos cambios requieren volver a filmar toda la escena, lo cual es costoso y requiere mucho tiempo. La síntesis de rostros parlantes ofrece una alternativa práctica al modificar automáticamente el movimiento facial para que coincida con el discurso revisado, eliminando así la necesidad de volver a filmar.

Aunque las interposiciones de IA de este tipo pueden enfrentar cultural O la resistencia de la industria, también podrían constituir un nuevo tipo de funcionalidad en sistemas y conjuntos de herramientas de efectos visuales controlados por humanos. En cualquier caso, por el momento, los desafíos son estrictamente técnicos.

Además de ampliar un clip a través de un diálogo adicional generado por IA, el nuevo sistema también puede alterar el diálogo existente:

Dele "click" para jugar. Un ejemplo de cómo modificar un diálogo existente en lugar de interponer diálogo adicional. Consulte el sitio web de origen para obtener una mejor resolución.

Estado del arte

Actualmente no existen sistemas de extremo a extremo que ofrezcan este tipo de capacidad de síntesis, aunque un número creciente de plataformas de IA generativa, como la de Google, Serie Veo, puede generar audio y otros marcos diversos pueden crear audio falsificado, actualmente es necesario crear una línea de producción bastante compleja de diversas arquitecturas y trucos para poder interferir con el metraje real de la forma en que lo hace el nuevo sistema, titulado Edición facial – puede lograr.

El sistema utiliza Transformadores de difusión (DiT) en combinación con Coincidencia de flujo Para crear movimientos faciales condicionados a los movimientos circundantes (contextuales) y al contenido de audio del habla. El sistema aprovecha los paquetes populares existentes que se ocupan de la reconstrucción facial, incluyendo Retrato en vivo (recientemente adquirida por Kling).

Además de este método, dado que su enfoque es el primero en integrar estos desafíos en una única solución, los autores han creado un novedoso punto de referencia denominado Banco de edición facial, junto con varias métricas de evaluación completamente nuevas apropiadas para esta tarea tan específica.

La sección nuevo trabajo se titula FacEDiT: Edición y generación unificada de rostros parlantes mediante relleno de movimiento facial, y proviene de cuatro investigadores de la Universidad de Ciencia y Tecnología de Pohang de Corea (POSTECH), el Instituto Avanzado de Ciencia y Tecnología de Corea (KAIST) y la Universidad de Texas en Austin.

Método

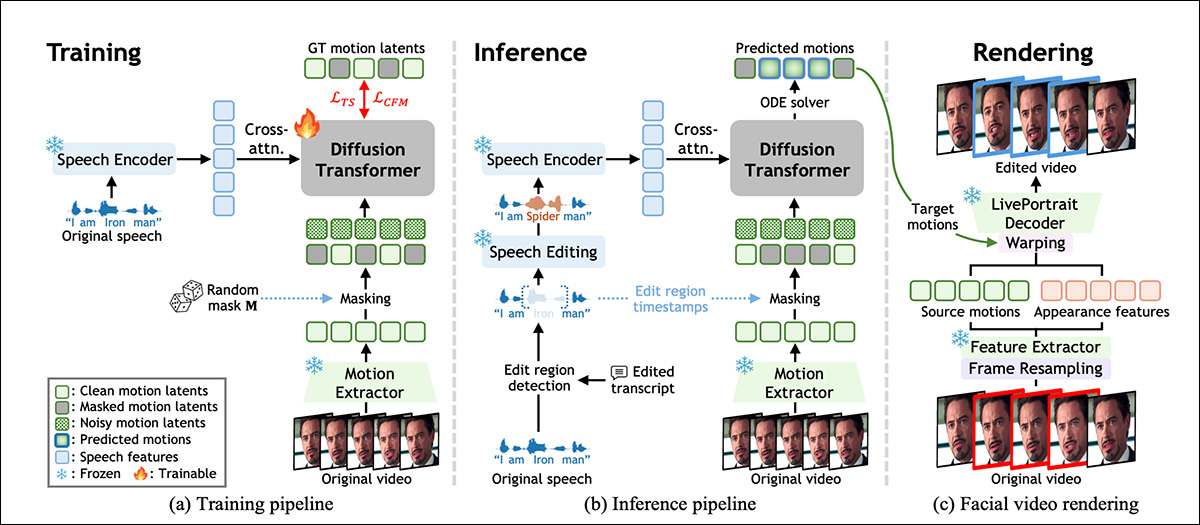

FacEDiT está entrenado para reconstruir el movimiento facial aprendiendo a completar las partes faltantes de la actuación original de un actor, basándose en el movimiento circundante y el audio del habla. Como se muestra en el esquema a continuación, este proceso permite al modelo actuar como un rellenador de huecos durante el entrenamiento, prediciendo movimientos faciales que coinciden con la voz y se mantienen consistentes con el video original.

Descripción general del sistema FacEDiT, que muestra cómo se aprende el movimiento facial a través del relleno autosupervisado durante el entrenamiento, guiado por el habla editada en la inferencia y, finalmente, se vuelve a convertir en video reutilizando la apariencia del metraje original, mientras se reemplaza solo el movimiento objetivo. Fuente

En el momento de la inferencia, la misma arquitectura admite dos salidas diferentes dependiendo de qué parte del video esté enmascarada: ediciones parciales, donde solo se altera una frase y el resto se deja intacto; o generación de oraciones completas, donde el nuevo movimiento se sintetiza completamente desde cero.

El modelo se entrena a través de coincidencia de flujo, que trata las ediciones de vídeo como una especie de camino entre dos versiones de movimiento facial.

En lugar de aprender a adivinar desde cero el aspecto que debería tener un rostro editado, la coincidencia de flujo aprende a moverse de forma gradual y fluida entre un marcador de posición con ruido y el movimiento correcto. Para facilitar esto, el sistema representa el movimiento facial como un conjunto compacto de números extraídos de cada fotograma mediante una versión del sistema LivePortrait mencionado anteriormente (véase el esquema anterior).

Estos vectores de movimiento están diseñados para describir expresiones y posturas de la cabeza sin enredando identidad, de modo que los cambios en el habla puedan localizarse sin afectar la apariencia general de la persona.

Capacitación en FaceDIT

Para entrenar FacEDiT, cada videoclip se dividió en una serie de instantáneas de movimiento facial, y cada fotograma se emparejó con su fragmento de audio correspondiente. Se ocultaron partes aleatorias de los datos de movimiento, y el modelo solicitó adivinar cómo deberían ser esos movimientos faltantes, utilizando el habla y el movimiento circundante sin máscara como contexto.

Debido a que los intervalos enmascarados y sus posiciones varían de un ejemplo de entrenamiento al siguiente, el modelo aprende gradualmente cómo manejar tanto pequeñas ediciones internas como espacios más largos para la generación de una secuencia completa, de acuerdo con la cantidad de información que se le proporciona.

El Transformador de Difusión del sistema, mencionado anteriormente, aprende a recuperar el movimiento enmascarado refinando las entradas ruidosas con el tiempo. En lugar de introducir voz y movimiento en el modelo simultáneamente, el audio se integra en cada bloque de procesamiento a través de... atención cruzada, ayudando al sistema a adaptar con mayor precisión los movimientos de los labios al habla.

Para preservar el realismo en las ediciones, la atención se centra en los fotogramas adyacentes en lugar de en toda la línea de tiempo, lo que obliga al modelo a centrarse en la continuidad local y evita parpadeos o saltos de movimiento en los bordes de las regiones alteradas. Las incrustaciones posicionales (que indican al modelo dónde aparece cada fotograma en la secuencia) ayudan al modelo a mantener un flujo temporal y un contexto naturales.

Durante el entrenamiento, el sistema aprende a predecir el movimiento facial faltante reconstruyendo intervalos enmascarados basándose en el habla y el movimiento cercano sin enmascarar. En el momento de la inferencia, se reutiliza esta misma configuración, pero con las máscaras ahora guiadas por las ediciones del habla.

Al insertar, eliminar o modificar una palabra o frase, el sistema localiza la región afectada, la enmascara y regenera el movimiento que coincide con el nuevo audio. La generación de secuencia completa se considera un caso especial, donde toda la región se enmascara y se sintetiza desde cero.

Datos y Pruebas

La columna vertebral del sistema consta de 22 capas para el Transformador de Difusión, cada una con 16 cabezas de atencion y dimensiones de avance de 1024 y 2024 px. Las características de movimiento y apariencia se extraen utilizando frozen Componentes de LivePortrait y voz codificada a través de WavLM y modificado usando VozCraft.

Una capa de proyección dedicada mapea las características del habla de 786 dimensiones en el espacio latente del DiT, con solo los módulos DiT y de proyección entrenados desde cero.

La capacitación se realizó bajo la AdánW optimizador a una tasa de aprendizaje objetivo de 1e‑4, para un millón de pasos, en dos GPU A6000 (cada una con 48 GB de VRAM), con un total tamaño del lote de ocho.

Banco de edición facial

El conjunto de datos FacEDiTBench contiene 250 ejemplos, cada uno con un videoclip del discurso original y editado, y sus transcripciones. Los videos provienen de tres fuentes, con 100 clips de HDTF, 100 de Hallo3, y 50 de CelebV-DubCada uno fue revisado manualmente para confirmar que tanto el audio como el video fueran lo suficientemente claros para la evaluación.

GPT‑4o Se utilizó para revisar cada transcripción y crear ediciones gramaticalmente válidas. Estas transcripciones revisadas, junto con el discurso original, se enviaron a VoiceCraft para producir nuevo audio; y en cada etapa, tanto la transcripción como el discurso generado se revisaron manualmente para garantizar su calidad.

Cada muestra fue etiquetada con el tipo de edición, el momento del cambio y la longitud del período modificado, y las ediciones se clasificaron como inserciones, eliminaciones o sustitucionesEl número de palabras modificadas varió desde ediciones cortas de 1 a 3 palabras, ediciones medianas de 4 a 6 palabras y ediciones más largas de 7 a 10 palabras.

Se definieron tres métricas personalizadas para evaluar la calidad de la edición. Continuidad fotométrica, para medir qué tan bien la iluminación y el color de un segmento editado se combinan con el video circundante, comparando las diferencias a nivel de píxel en los límites; continuidad del movimiento, para evaluar la consistencia del movimiento facial, midiendo los cambios en el flujo óptico en fotogramas editados y sin editar; y Preservación de la identidad, para estimar si la apariencia del sujeto permanece consistente después de la edición, comparando las incrustaciones faciales de las secuencias originales y generadas utilizando el Cara de arco modelo de reconocimiento facial.

Examenes

El modelo de prueba se entrenó con material de los tres conjuntos de datos mencionados anteriormente, con un total de alrededor de 200 horas de contenido de video, incluidos vlogs y películas, así como videos de YouTube de alta resolución.

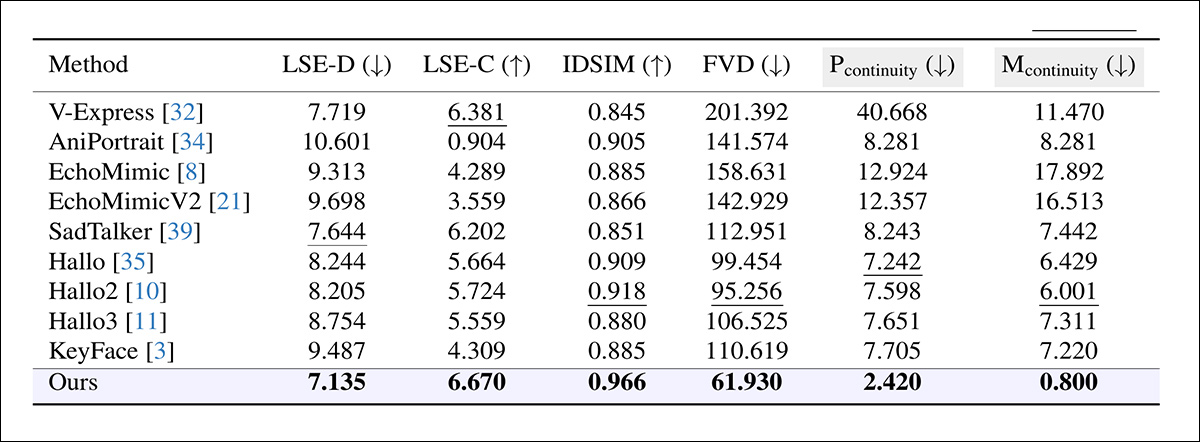

Para evaluar la edición de caras parlantes, se utilizó FacEDiTBench, además de la división de pruebas HDTF, que se ha convertido en un estándar de evaluación comparativa para este conjunto de tareas.

Dado que no existían sistemas directamente comparables capaces de encapsular este tipo de funcionalidad de extremo a extremo, los autores eligieron una variedad de marcos que reproducían al menos parte de la funcionalidad objetivo y podían funcionar como líneas de base, a saber: KeyFace; EchoMimic; EchoMimic V2; Hola; Hallo2; Hallo3; V-Express; AniRetrato; y Hablador triste.

También se utilizaron varias métricas establecidas para evaluar la calidad de generación y edición, y la precisión de sincronización de labios se evaluó a través de SyncNet, informando tanto el error absoluto entre los movimientos de los labios y el audio (LSE-D) como una puntuación de confianza (LSE-C); Distancia del vídeo de Fréchet (FVD) cuantificar qué tan realista parecía el video en general; y Métricas de similitud perceptual aprendidas (LPIPS), que mide la similitud perceptiva entre los fotogramas generados y los originales.

Para la edición, todas las métricas excepto LPIPS se aplicaron solo al segmento modificado; para la generación, se evaluó todo el video, excluida la continuidad de los límites.

Cada modelo se diseñó para sintetizar un segmento de vídeo coincidente, que posteriormente se fusionó con el clip original (los investigadores señalan que este método introducía con frecuencia discontinuidades visibles, donde la sección editada se unía con el metraje circundante). También se probó un segundo enfoque, en el que se regeneró todo el vídeo a partir del audio modificado; sin embargo, esto inevitablemente sobrescribió las regiones sin editar y no logró preservar la calidad original.

Comparación del rendimiento de edición entre sistemas diseñados originalmente para la generación de rostros parlantes. FacEDiT supera todas las referencias en todas las métricas, logrando un menor error de sincronización labial (LSE-D), una mayor confianza de sincronización (LSE-C), una mayor preservación de la identidad (IDSIM), un mayor realismo perceptual (FVD) y transiciones más fluidas entre los límites de edición (Pcontinuidad, Mcontinuidad). Las columnas sombreadas en gris resaltan los criterios clave para evaluar la calidad de los límites; los valores en negrita y subrayado indican los mejores y los segundos mejores resultados, respectivamente.

Respecto a estos resultados, los autores comentan:

Nuestro modelo supera significativamente a los métodos existentes en la edición. Logra una sólida continuidad de límites y una alta preservación de la identidad, lo que demuestra su capacidad para mantener la consistencia temporal y visual durante la edición. Además, su superior precisión de sincronización labial y su bajo FVD reflejan el realismo del vídeo sintetizado.

Dele "click" para jugar. Resultados recopilados por este autor a partir de los videos publicados en el sitio web del proyecto. Para una mejor resolución, consulte el sitio web de origen.

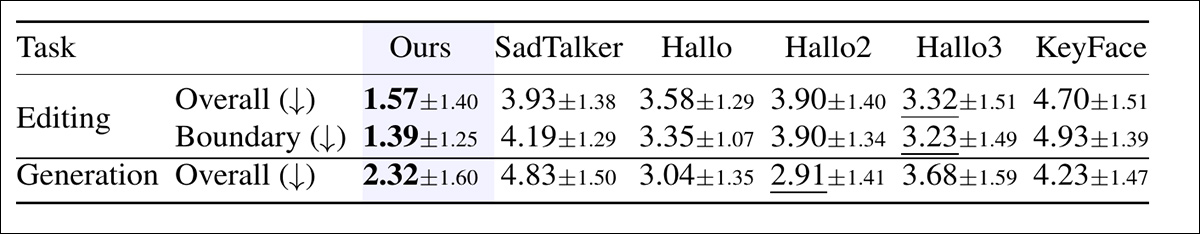

Además, se realizó un estudio en humanos para evaluar la calidad percibida tanto en la edición como en la generación.

Para cada comparación, los participantes visualizaron seis videos y los clasificaron según su calidad general, considerando la precisión de la sincronización labial, la naturalidad y el realismo del movimiento de la cabeza. En las pruebas de edición, los participantes también calificaron la fluidez de las transiciones entre los segmentos editados y sin editar:

Calificaciones promedio asignadas por evaluadores humanos, donde menor significa mejor. Tanto en la edición como en la generación, los participantes evaluaron la naturalidad y la sincronización de cada video. En la edición, también calificaron la fluidez de la transición entre el diálogo editado y el original. Los números en negrita y subrayado indican las dos puntuaciones más altas.

En el estudio, FacEDiT fue clasificado constantemente como el más alto con una clara ventaja, tanto en calidad de edición como en fluidez de transición, y también recibió puntajes altos en la configuración de generación, lo que sugiere que sus ventajas medidas se traducen en resultados perceptualmente preferidos.

Por falta de espacio, remitimos al lector al artículo original para obtener más detalles sobre los estudios de ablación y las pruebas adicionales realizadas e informadas en el nuevo trabajo. En realidad, las propuestas de investigación prototípicas de este tipo tienen dificultades para generar secciones de resultados de pruebas significativas, ya que la oferta principal en sí misma constituye inevitablemente una posible base para trabajos posteriores.

Conclusión

Incluso para la inferencia, sistemas como este pueden requerir importantes recursos computacionales en el momento de la inferencia, lo que dificulta que los usuarios finales (en este caso, presumiblemente, los estudios de efectos visuales) mantengan el trabajo en las instalaciones. Por lo tanto, los proveedores, que tienen la obligación legal de proteger las grabaciones y la propiedad intelectual general de sus clientes, siempre preferirán los enfoques adaptables a recursos locales realistas.

No se trata de criticar la nueva oferta, que muy bien puede funcionar perfectamente con pesos cuantificados u otras optimizaciones, y que es la primera oferta de su tipo que me atrae nuevamente a esta línea de investigación en bastante tiempo.

Primera publicación: miércoles 17 de diciembre de 202. Editado 20.10 EET, mismo día, para espacio adicional en el primer párrafo del cuerpo.