Andersons vinkel

'Beskyttede' billeder er lettere, ikke vanskeligere, at stjæle med AI

Ny forskning tyder på, at vandmærkningsværktøjer, der er beregnet til at blokere AI-billedredigeringer, kan give bagslag. I stedet for at forhindre modeller som Stable Diffusion i at foretage ændringer, findes der faktisk nogle beskyttelser, der hjælpe AI'en følger redigeringsprompts nøje, hvilket gør uønskede manipulationer endnu nemmere.

Der er en bemærkelsesværdig og robust tråd i computer vision-litteraturen dedikeret til at beskytte ophavsretligt beskyttede billeder mod at blive trænet ind i AI-modeller eller blive brugt i direkte billede>billede AI-processer. Systemer af denne art er generelt rettet mod Latent diffusionsmodeller (LDM'er) som f.eks Stabil diffusion og Flux, som bruger støjbaseret procedurer til kodning og afkodning af billeder.

By indsættelse af fjendtlig støj i ellers normalt udseende billeder, kan det være muligt at få billeddetektorer til at gæt billedindholdet forkertog hindre billedgenererende systemer i at udnytte ophavsretligt beskyttede data:

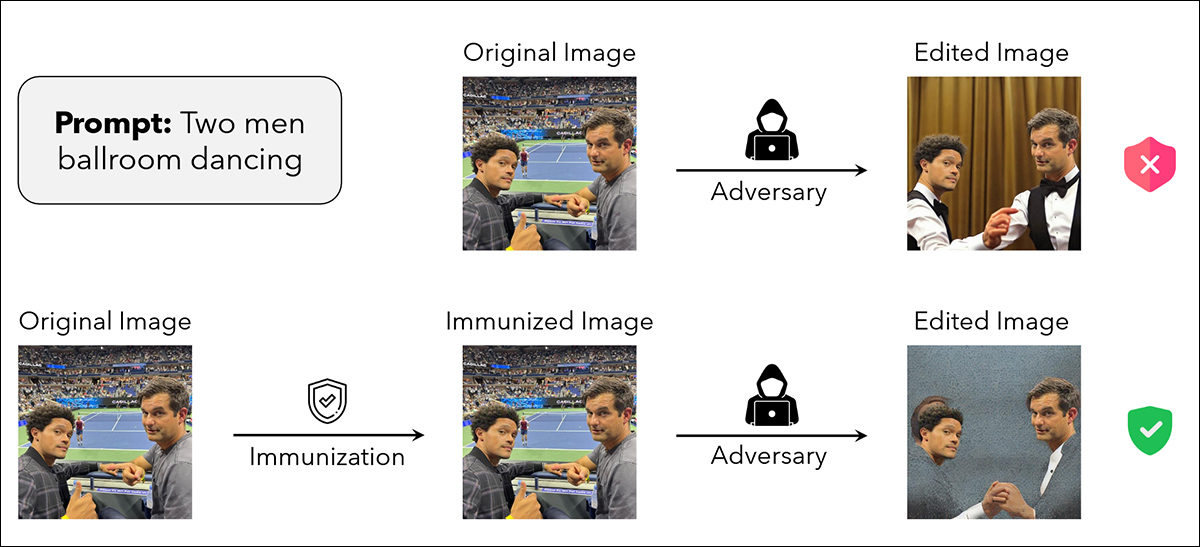

Fra MIT-artiklen 'Raising the Cost of Malicious AI-Powered Image Editing', eksempler på et kildebillede, der er 'immuniseret' mod manipulation (nederste række). Kilde: https://arxiv.org/pdf/2302.06588

Siden en kunstneres modreaktion I modsætning til Stable Diffusions liberale brug af web-scraped billeder (inklusive ophavsretligt beskyttede billeder) i 2023 har forskningsmiljøet produceret flere variationer over det samme tema – ideen om, at billeder usynligt kan 'forgiftes' mod at blive trænet ind i AI-systemer eller suget ind i generative AI-pipelines uden at påvirke billedets kvalitet negativt for den gennemsnitlige seer.

I alle tilfælde er der en direkte sammenhæng mellem intensiteten af den påførte forstyrrelse, i hvilken grad billedet efterfølgende er beskyttet, og i hvilken grad billedet ikke ser helt så godt ud, som det burde:

Selvom kvaliteten af forsknings-PDF'en ikke fuldt ud illustrerer problemet, ofrer større mængder af modstridende forstyrrelser kvalitet til fordel for sikkerhed. Her ser vi spektret af kvalitetsforstyrrelser i 'Fawkes'-projektet fra 2020, ledet af University of Chicago. Kilde: https://arxiv.org/pdf/2002.08327

Af særlig interesse for kunstnere, der søger at beskytte deres stilarter mod uautoriseret tilegnelse, er sådanne systemers evne til ikke blot at tilsløre identitet og andre oplysninger, men for at 'overbevise' en AI-træningsproces om, at den ser noget andet, end den faktisk ser, så der ikke dannes forbindelser mellem semantiske og visuelle domæner for 'beskyttede' træningsdata (dvs. en prompt som f.eks. 'I Paul Klees stil').

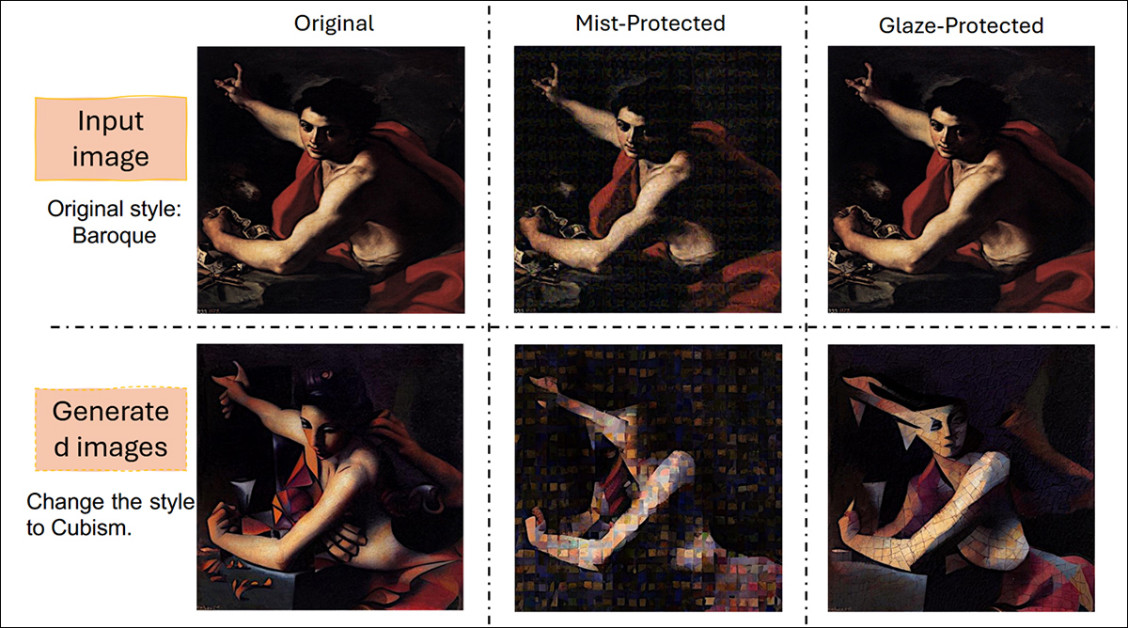

Mist og Glaze er to populære injektionsmetoder, der er i stand til at forhindre eller i det mindste alvorligt hæmme forsøg på at bruge ophavsretligt beskyttede stilarter i AI-arbejdsgange og træningsrutiner. Kilde: https://arxiv.org/pdf/2506.04394

Eget mål

Nu har ny forskning fra USA ikke blot vist, at forstyrrelser ikke kan beskytte et billede, men at tilføjelse af forstyrrelser faktisk kan Forbedre billedets udnyttelsesmulighed i alle de AI-processer, som perturbation har til formål at immunisere imod.

Papiret siger:

I vores eksperimenter med forskellige perturbationsbaserede billedbeskyttelsesmetoder på tværs af flere domæner (naturlige scenebilleder og kunstværker) og redigeringsopgaver (billede-til-billede-generering og stilredigering) opdager vi, at en sådan beskyttelse ikke fuldt ud opnår dette mål.

I de fleste scenarier genererer diffusionsbaseret redigering af beskyttede billeder et ønskeligt outputbillede, der præcist overholder vejledningsprompten.

Vores resultater tyder på, at tilføjelse af støj til billeder paradoksalt nok kan øge deres association med givne tekstprompter under genereringsprocessen, hvilket fører til utilsigtede konsekvenser såsom bedre resulterende redigeringer.

"Derfor argumenterer vi for, at perturbationsbaserede metoder muligvis ikke giver en tilstrækkelig løsning til robust billedbeskyttelse mod diffusionsbaseret redigering."

I test blev de beskyttede billeder udsat for to velkendte AI-redigeringsscenarier: ligetil billede-til-billede-generering og stiloverførselDisse processer afspejler de almindelige måder, hvorpå AI-modeller kan udnytte beskyttet indhold, enten ved direkte at ændre et billede eller ved at låne dets stilistiske træk til brug andre steder.

De beskyttede billeder, hentet fra standardkilder inden for fotografi og kunst, blev kørt gennem disse pipelines for at se, om de tilføjede forstyrrelser kunne blokere eller forringe redigeringerne.

I stedet syntes tilstedeværelsen af beskyttelse ofte at skærpe modellens tilpasning til prompterne og producere rene og præcise output, hvor man havde forventet en vis fejl.

Forfatterne anbefaler i realiteten, at denne meget populære beskyttelsesmetode kan give en falsk følelse af sikkerhed, og at sådanne forstyrrelsesbaserede immuniseringsmetoder bør testes grundigt mod forfatternes egne metoder.

Metode

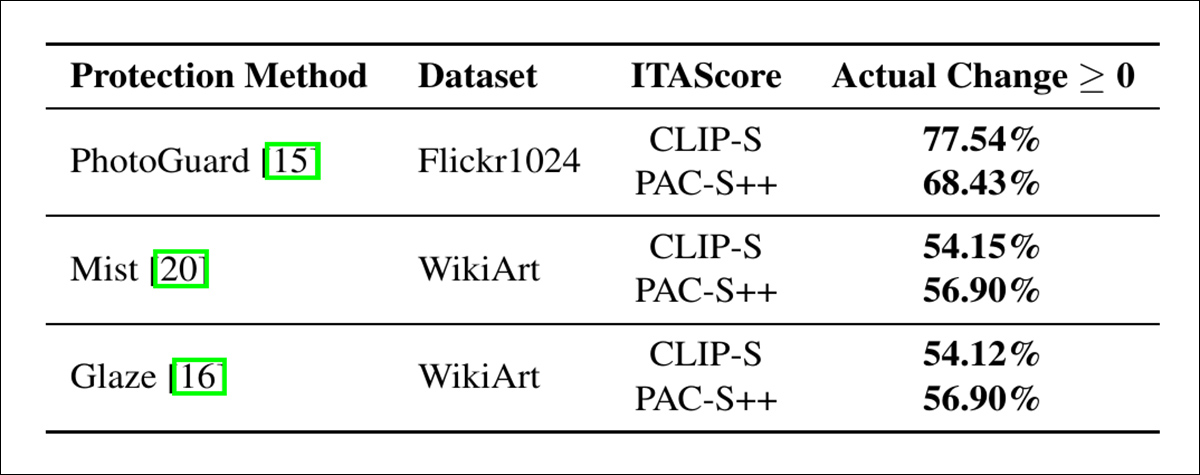

Forfatterne udførte eksperimenter ved hjælp af tre beskyttelsesmetoder, der anvender omhyggeligt designede adversarielle forstyrrelser: PhotoGuard; TågeOg Glaze.

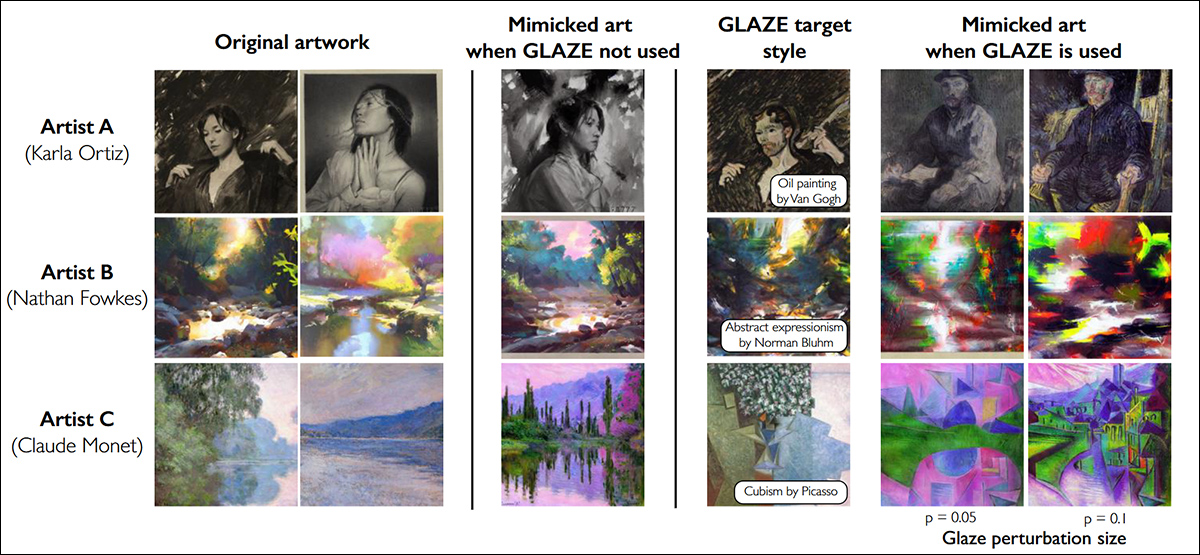

Glaze, et af de frameworks, som forfatterne har testet, illustrerer eksempler på Glaze-beskyttelse for tre kunstnere. De første to kolonner viser de originale kunstværker; den tredje kolonne viser mimikresultater uden beskyttelse; den fjerde, stiloverførte versioner brugt til cloaking-optimering, sammen med navnet på den ønskede stil. Den femte og sjette kolonne viser mimikresultater med cloaking anvendt på perturbationsniveauer. p = 0.05 og p = 0.1. Alle resultater bruger stabile diffusionsmodeller. https://arxiv.org/pdf/2302.04222

PhotoGuard blev anvendt på naturlige scenebilleder, mens Mist og Glaze blev brugt på kunstværker (dvs. 'kunstnerisk stylede' domæner).

Testene dækkede både naturlige og kunstneriske billeder for at afspejle mulige anvendelser i den virkelige verden. Effektiviteten af hver metode blev vurderet ved at kontrollere, om en AI-model stadig kunne producere realistiske og prompt-relevante redigeringer, når der arbejdedes på beskyttede billeder. Hvis de resulterende billeder virkede overbevisende og matchede instruktionerne, blev beskyttelsen vurderet som mislykket.

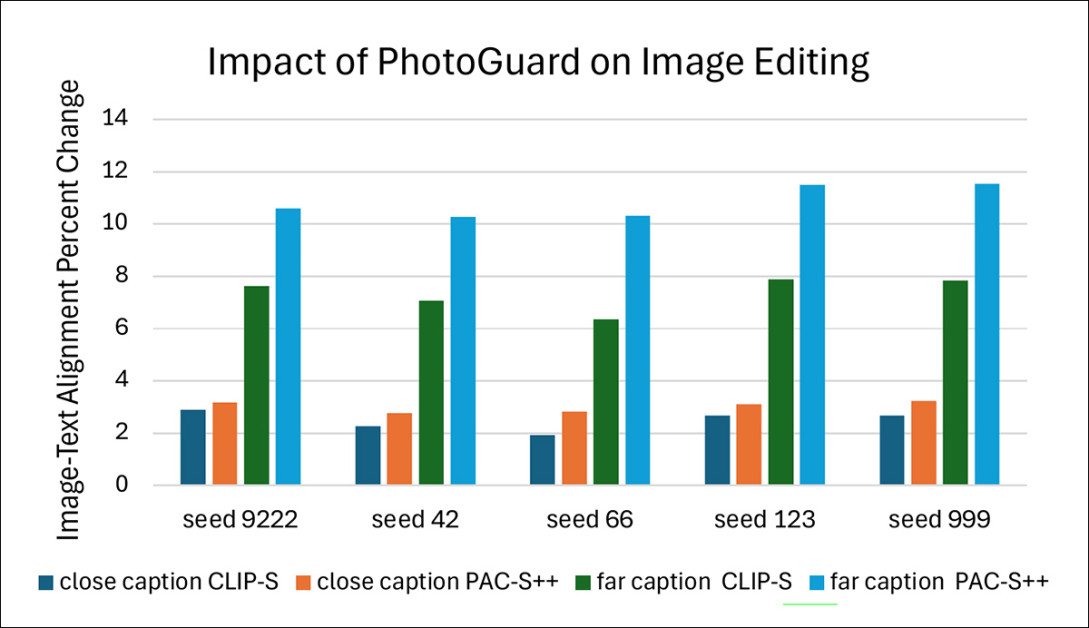

Stabil diffusion v1.5 blev brugt som den præ-trænede billedgenerator til forskernes redigeringsopgaver. Fem frø blev valgt for at sikre reproducerbarhed: 9222, 999, 123, 66 og 42. Alle andre generationsindstillinger, såsom vejledningsskala, styrke og samlede antal trin, fulgte standardværdierne, der blev brugt i PhotoGuard-eksperimenterne.

PhotoGuard blev testet på billeder af naturlige scener ved hjælp af Flickr8k datasæt, som indeholder over 8,000 billeder parret med op til fem billedtekster hver.

Modsatrettede tanker

To sæt modificerede billedtekster blev oprettet ud fra den første billedtekst på hvert billede ved hjælp af Claude Sonnet 3.5Et sæt indeholdt prompts, der var kontekstuelt tæt på til de originale billedtekster; det andet sæt indeholdt prompts, der var kontekstuelt fjernt.

For eksempel fra den originale billedtekst En ung pige i en lyserød kjole går ind i en træhytte, en afsluttende prompt ville være En ung dreng i en blå skjorte går ind i et murstenshusI modsætning hertil en fjernt prompten ville være To katte slapper af på en sofa.

Lukkede prompts blev konstrueret ved at erstatte substantiver og adjektiver med semantisk lignende termer; fjernprompts blev genereret ved at instruere modellen til at oprette billedtekster, der var kontekstuelt meget forskellige.

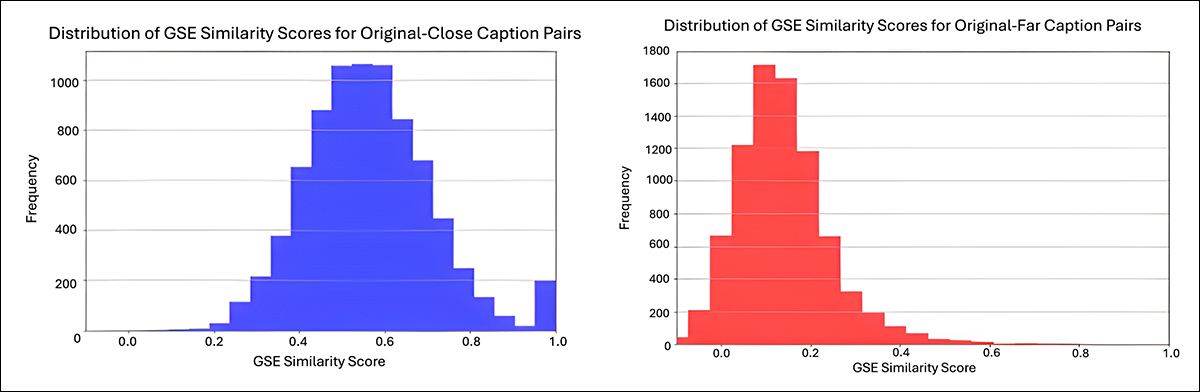

Alle genererede undertekster blev manuelt kontrolleret for kvalitet og semantisk relevans. Googles Universel sætningskode blev brugt til at beregne semantiske lighedsscorer mellem de originale og modificerede billedtekster:

Fra det supplerende materiale, semantiske lighedsfordelinger for de modificerede billedtekster brugt i Flickr8k-tests. Grafen til venstre viser lighedsscorerne for tæt modificerede billedtekster, med et gennemsnit på omkring 0.6. Grafen til højre viser de omfattende modificerede billedtekster, med et gennemsnit på omkring 0.1, hvilket afspejler en større semantisk afstand fra de originale billedtekster. Værdierne blev beregnet ved hjælp af Googles Universal Sentence Encoder. Kilde: https://sigport.org/sites/default/files/docs/IncompleteProtection_SM_0.pdf

Hvert billede, sammen med dets beskyttede version, blev redigeret ved hjælp af både nær- og fjernprompten. Evaluatoren for rumlig kvalitet for blinde/referenceløse billeder (BRISKE) blev brugt til at vurdere billedkvaliteten:

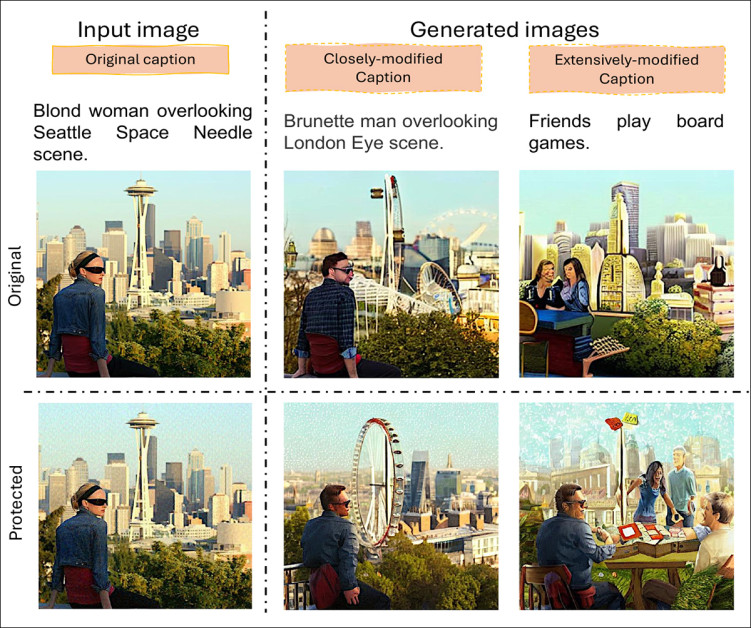

Billed-til-billed-generering resulterer i naturlige fotografier beskyttet af PhotoGuard. Trods tilstedeværelsen af forstyrrelser fulgte Stable Diffusion v1.5 med succes både små og store semantiske ændringer i redigeringsprompterne og producerede realistiske output, der matchede de nye instruktioner.

De genererede billeder scorede 17.88 på BRISQUE, med 17.82 for nære prompts og 17.94 for fjernprompts, mens de originale billeder scorede 22.27. Dette viser, at de redigerede billeder forblev tæt på originalernes kvalitet.

Metrics

For at bedømme, hvor godt beskyttelserne interfererede med AI-redigering, målte forskerne, hvor tæt de endelige billeder matchede de instruktioner, de fik, ved hjælp af scoringssystemer, der sammenlignede billedindholdet med tekstprompten for at se, hvor godt de justerede sig.

Til dette formål CLIP-S metric bruger en model, der kan forstå både billeder og tekst for at kontrollere, hvor ens de er, mens PAC-S++, tilføjer ekstra prøver oprettet af AI for at justere sin sammenligning tættere på et menneskeligt estimat.

Disse billed-tekstjusteringsscorer (ITA) angiver, hvor præcist AI'en fulgte instruktionerne, da den ændrede et beskyttet billede: hvis et beskyttet billede stadig førte til et meget justeret output, betyder det, at beskyttelsen blev anset for at have mislykkedes at blokere redigeringen.

Effekt af beskyttelse på Flickr8k-datasættet på tværs af fem seeds, ved hjælp af både tætte og fjerne prompts. Billed-tekst-justering blev målt ved hjælp af CLIP-S- og PAC-S++-scorer.

Forskerne sammenlignede, hvor godt AI'en fulgte instruktionerne, når de redigerede beskyttede billeder versus ubeskyttede billeder. De undersøgte først forskellen mellem de to, kaldet Faktisk ændringDerefter blev forskellen skaleret for at skabe en Procentvis ændringhvilket gør det nemmere at sammenligne resultater på tværs af mange tests.

Denne proces afslørede, om beskyttelserne gjorde det sværere eller lettere for AI'en at matche prompterne. Testene blev gentaget fem gange ved hjælp af forskellige tilfældige seeds, der dækkede både små og store ændringer i de originale billedtekster.

Kunstangreb

Til testene af naturfotografier blev Flickr1024-datasættet, der indeholdt over tusind billeder af høj kvalitet, brugt. Hvert billede blev redigeret med prompts, der fulgte mønsteret: 'ændre stilen til [V]'Hvor [V] repræsenterede en af syv berømte kunststilarter: kubisme, postimpressionisme, impressionisme, surrealisme, barok, fauvisme og renæssance.

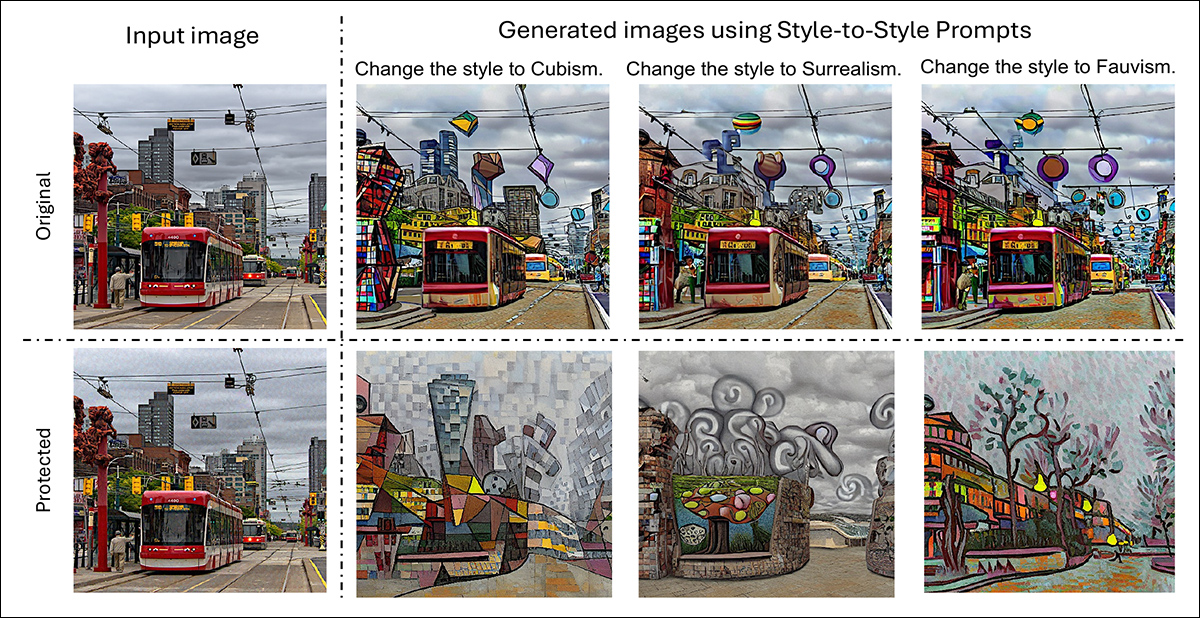

Processen involverede at anvende PhotoGuard på de originale billeder, generere beskyttede versioner og derefter køre både beskyttede og ubeskyttede billeder gennem det samme sæt af stiloverførselsredigeringer:

Originale og beskyttede versioner af et naturscenebillede, hver redigeret for at anvende kubisme, surrealisme og fauvisme.

For at teste beskyttelsesmetoder på kunstværker blev der udført stiloverførsel på billeder fra WikiArt datasæt, som kuraterer en bred vifte af kunstneriske stilarter. Redigeringsprompterne fulgte samme format som før og instruerede AI'en i at ændre stilen til en tilfældigt valgt, ikke-relateret stil hentet fra WikiArt-etiketterne.

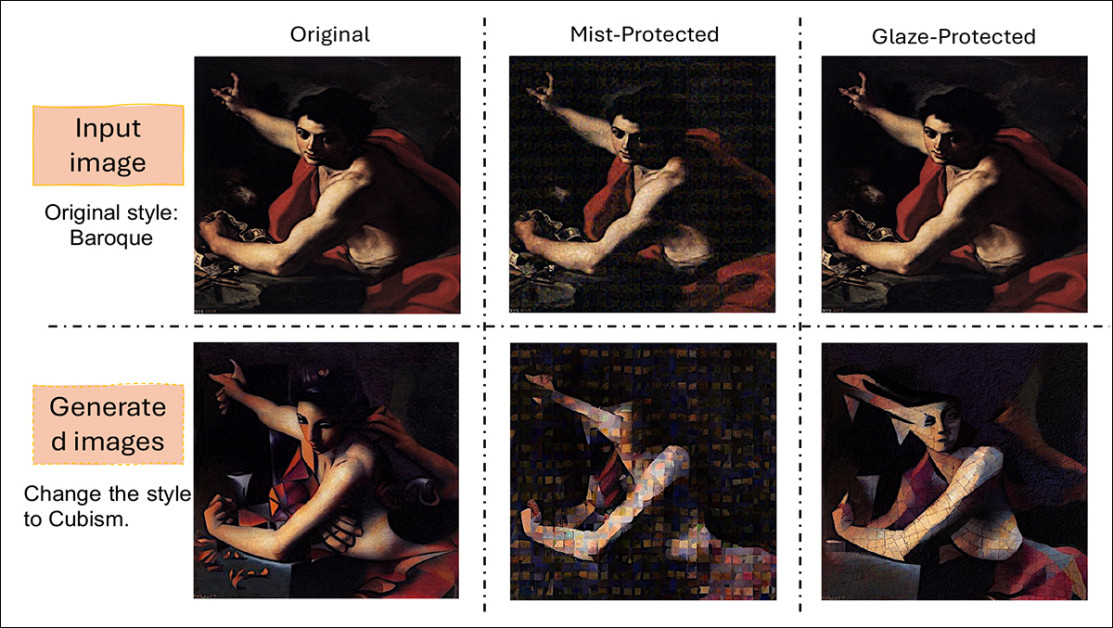

Både glasur- og dugbeskyttelsesmetoderne blev anvendt på billederne før redigeringerne, hvilket gjorde det muligt for forskerne at observere, hvor godt hvert forsvar kunne blokere eller forvrænge resultaterne af stiloverførslen:

Eksempler på, hvordan beskyttelsesmetoder påvirker stiloverførsel på kunstværker. Det originale barokbillede vises sammen med versioner beskyttet af Mist og Glaze. Efter anvendelse af kubistisk stiloverførsel kan man se forskelle i, hvordan hver beskyttelse ændrer det endelige resultat.

Forskerne testede også sammenligningerne kvantitativt:

Ændringer i justeringsscorer for billede og tekst efter redigering af stiloverførsel.

Af disse resultater kommenterer forfatterne:

Resultaterne fremhæver en betydelig begrænsning af adversarielle forstyrrelser for beskyttelse. I stedet for at hæmme tilpasningen forbedrer adversarielle forstyrrelser ofte den generative models respons på prompts, hvilket utilsigtet gør det muligt for udnyttere at producere output, der er bedre i overensstemmelse med deres mål. En sådan beskyttelse forstyrrer ikke billedredigeringsprocessen og er muligvis ikke i stand til at forhindre ondsindede agenter i at kopiere uautoriseret materiale.

"De utilsigtede konsekvenser af at bruge modstridende forstyrrelser afslører sårbarheder i eksisterende metoder og understreger det presserende behov for mere effektive beskyttelsesteknikker."

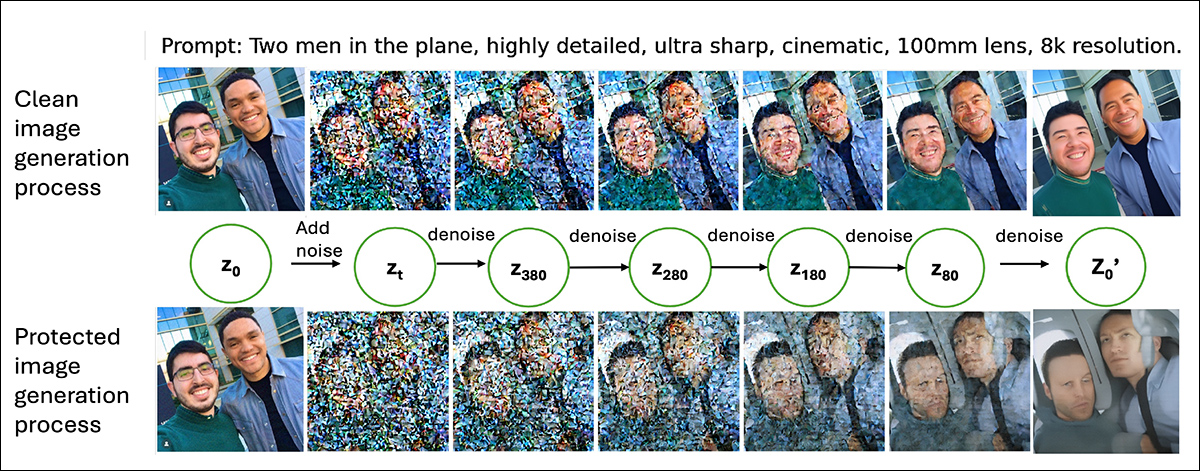

Forfatterne forklarer, at de uventede resultater kan spores tilbage til, hvordan diffusionsmodeller fungerer: LDM'er redigerer billeder ved først at konvertere dem til en komprimeret version kaldet en latentstøj tilføjes derefter til denne latente gennem mange trin, indtil dataene bliver næsten tilfældige.

Modellen vender denne proces om under genereringen og fjerner støjen trin for trin. I hvert trin af denne vending hjælper tekstprompten med at guide, hvordan støjen skal renses ud, og former gradvist billedet, så det matcher prompten:

Sammenligning mellem generationer fra et ubeskyttet billede og et PhotoGuard-beskyttet billede, med mellemliggende latente tilstande konverteret tilbage til billeder til visualisering.

Beskyttelsesmetoder tilføjer små mængder ekstra støj til det originale billede, før det går ind i denne proces. Selvom disse forstyrrelser er små i starten, akkumuleres de, efterhånden som modellen anvender sine egne lag af støj.

Denne ophobning efterlader flere dele af billedet 'usikre', når modellen begynder at fjerne støj. Med større usikkerhed læner modellen sig mere op ad tekstprompten for at udfylde de manglende detaljer, hvilket giver prompten endnu mere indflydelse end den normalt ville have.

I realiteten gør beskyttelserne det lettere for AI'en at omforme billedet, så det matcher prompten, snarere end sværere.

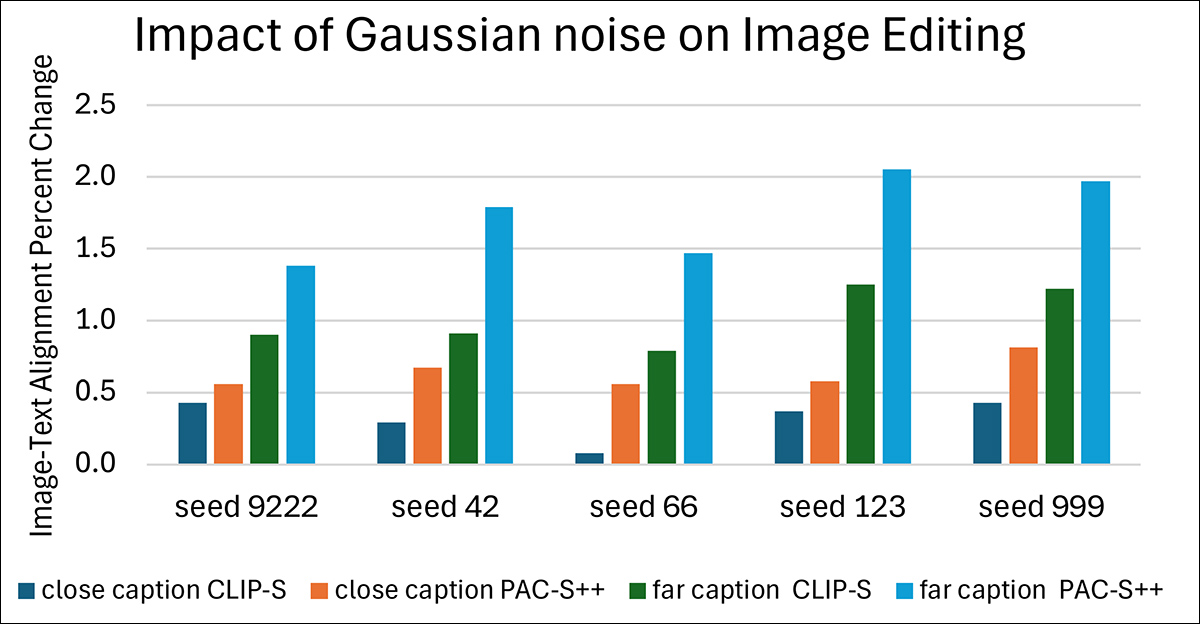

Endelig udførte forfatterne en test, der erstattede fremstillede forstyrrelser fra Øger omkostningerne ved ondsindet AI-drevet billedredigering paper for ren Gaussisk støj.

Resultaterne fulgte det samme mønster, der blev observeret tidligere: På tværs af alle tests forblev værdierne for procentvis ændring positive. Selv denne tilfældige, ustrukturerede støj førte til en stærkere overensstemmelse mellem de genererede billeder og prompterne.

Effekt af simuleret beskyttelse ved hjælp af Gaussisk støj på Flickr8k-datasættet.

Dette understøttede den underliggende forklaring om, at enhver ekstra støj, uanset dens design, skaber større usikkerhed for modellen under genereringen, hvilket giver tekstprompten mulighed for at udøve endnu mere kontrol over det endelige billede.

Konklusion

Forskningsmiljøet har fremmet en modstridende forstyrrelse af LDM-ophavsretsspørgsmålet næsten lige så længe som LDM'er har eksisteret; men der er ikke opstået robuste løsninger ud fra det ekstraordinære antal artikler, der er offentliggjort på dette område.

Enten forringer de påførte forstyrrelser billedets kvalitet i overdreven grad, eller også viser mønstrene sig ikke at være modstandsdygtige over for manipulation og transformative processer.

Det er dog en svær drøm at opgive, da alternativet synes at være tredjepartsovervågnings- og proveniensframeworks som f.eks. det Adobe-ledede. C2PA-ordning, som søger at opretholde en sporbarhedskæde for billeder fra kamerasensoren og frem, men som ikke har nogen iboende forbindelse til det afbildede indhold.

Under alle omstændigheder, hvis adversarial forstyrrelse faktisk forværrer problemet, hvilket den nye artikel indikerer kan være sandt i mange tilfælde, så undrer man sig over, om søgen efter ophavsretsbeskyttelse via sådanne midler falder ind under 'alkymi'.

Først udgivet mandag den 9. juni 2025