Kunstig intelligens

AI Image Matting, der forstår scener

I den ekstra dokumentar, der ledsager DVD-udgivelsen fra 2003 af Alien3 (1992) mindedes Richard Edlund, legende inden for visuelle effekter, med rædsel om den 'sumobrydning', der involverede fotokemisk matteekstraktion, som dominerede arbejdet med visuelle effekter mellem sene 1930'er og slutningen af 1980'erne. Edlund beskrev processens uforudsete karakter som 'sumobrydning' i sammenligning med de digitale blå/grønne skærm-teknikker, der tog over i begyndelsen af 1990'erne (og han har vendt tilbage til metaforen siden).

Udtrækning af et forgrundselement (såsom en person eller en rumskibsmodel) fra en baggrund, så det udskårne billede kan sammensættes til en baggrundsplade, blev oprindeligt opnået ved at filme forgrundsobjektet mod en ensartet blå eller grøn baggrund.

Omstændelige fotokemiske ekstraktionsprocesser til en VFX optaget af ILM til 'Return of the Jedi' (1983). Kilde: https://www.youtube.com/watch?v=qwMLOjqPmbQ

I de resulterende optagelser vil baggrundsfarven efterfølgende blive isoleret kemisk og brugt som skabelon til at genudskrive forgrundsobjektet (eller personen) i en optisk printer som et 'svævende' objekt i en ellers gennemsigtig filmcelle.

Processen blev kendt som farveseparationsoverlejring (CSO) - selvom dette udtryk i sidste ende ville blive mere forbundet med råolie 'Chromakey' videoeffekter i lavere budgetteret tv-udgang i 1970'erne og 1980'erne, som blev opnået med analoge frem for kemiske eller digitale midler.

En demonstration af farveseparationsoverlay i 1970 til det britiske børneprogram 'Blue Peter'. Kilde: https://www.bbc.co.uk/archive/blue_peter_noakes_CSO/zwb9vwx

Under alle omstændigheder, hvad enten det drejer sig om film- eller videoelementer, kunne de udtrukne optagelser derefter indsættes i enhver anden optagelse.

Selvom Disney er markant dyrere og mere proprietære natrium-damp proces (som har valgt gul, specifikt, og var også anvendte til Alfred Hitchcocks gyser fra 1963 Fuglene) gav bedre definition og sprødere matte, fotokemisk ekstraktion forblev omhyggelig og upålidelig.

Disneys proprietære natriumdampekstraktionsproces krævede baggrunde nær den gule ende af spektret. Her hænger Angela Lansbury på wirer under produktionen af en VFX-fyldt sekvens til 'Bedknobs and Broomsticks' (1971). Kilde

Beyond Digital Matting

I 1990'erne undlod den digitale revolution kemikalierne, men ikke behovet for grønne skærme. Det var nu muligt at fjerne den grønne (eller hvilken som helst farve) baggrund blot ved at søge efter pixels inden for et toleranceområde for den farve, i pixelredigeringssoftware som Photoshop og en ny generation af videokompositeringspakker, der automatisk kunne taste ud de farvede baggrunde. Næsten natten over, tres år af den optiske trykkeriindustri blev overgivet til historien.

De sidste ti års GPU-accelereret computersynsforskning indleder matudvinding i en tredje alder, og giver forskere til opgave at udvikle systemer, der kan udvinde matte af høj kvalitet uden behov for grønne skærme. Alene hos Arxiv er artikler relateret til innovationer inden for maskinlæringsbaseret forgrundsekstraktion en ugentlig funktion.

Sætter os i billedet

Dette sted for akademisk og industriinteresse i AI-udvinding har allerede påvirket forbrugerområdet: rå, men brugbare implementeringer er velkendte for os alle i form af linse zoom og Skype filtre, der kan erstatte vores stuebaggrunde med tropiske øer, et al., i videokonferenceopkald.

De bedste måtter kræver dog stadig en grøn skærm, som Zoom noteret i onsdags.

Til venstre en mand foran en green screen med hår, der er klippet godt ud via Zooms virtuelle baggrundsfunktion. Til højre en kvinde foran en normal hjemmescene med hår, der er klippet ud algoritmisk, mindre præcist og med højere computerkrav. Kilde: https://support.zoom.us/hc/en-us/articles/210707503-Changing-your-Virtual-Background-image

A yderligere indlæg fra Zoom Support-platformen advarer om, at udtrækning af ikke-grøn skærm også kræver større computerkraft i optagelsesenheden.

Behovet for at skære det ud

Forbedringer i kvalitet, bærbarhed og ressourceøkonomi for "i praksis"-matteekstraktionssystemer (dvs. isolering af mennesker uden behov for grønne skærme) er relevante for mange flere sektorer og formål end blot videokonferencefiltre.

For udvikling af datasæt giver forbedret ansigts-, hoved- og kropsgenkendelse mulighed for at sikre, at fremmede baggrundselementer ikke trænes ind i computervisionsmodeller af mennesker; mere præcis isolering ville forbedre semantisk segmentering teknikker designet til at skelne og assimilere domæner (dvs 'kat', 'person', 'båd'), og forbedre VAE og transformer-baserede billedsyntesesystemer såsom OpenAI's nye DALL-E2; og bedre ekstraktionsalgoritmer ville skære ned på behovet for dyre manualer rotoscoping i kostbare VFX-pipelines.

Faktisk overstiger multimodalt (normalt tekst/billede) metoder, hvor et domæne som 'kat' er kodet både som et billede og med tilhørende tekstreferencer, gør allerede indtog i billedbehandling. Et nyligt eksempel er Text2Live arkitektur, som bruger multimodal (tekst/billede) træning til at skabe videoer af blandt utallige andre muligheder, krystalsvaner og glasgiraffer.

Scene-Aware AI Matting

En hel del forskning i AI-baseret automatisk matting har fokuseret på grænsegenkendelse og evaluering af pixelbaserede grupperinger inde i en billed- eller videoramme. Ny forskning fra Kina tilbyder imidlertid en ekstraktionspipeline, der forbedrer afgrænsningen og matkvaliteten ved at udnytte tekstbaserede beskrivelser af en scene (en multimodal tilgang, der har vundet indpas i computersynsforskningssektoren i løbet af de sidste 3-4 år), der hævder at have forbedret tidligere metoder på en række måder.

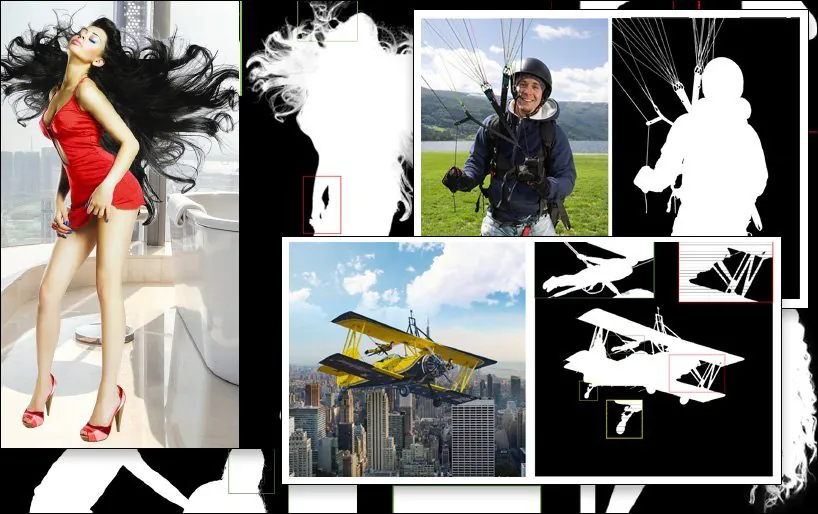

Et eksempel på SPG-IM-ekstraktion (sidste billede, nederst til højre), sammenlignet med konkurrerende tidligere metoder. Kilde: https://arxiv.org/pdf/2204.09276.pdf

Udfordringen for udvindingsforskningsundersektoren er at producere arbejdsgange, der kræver et minimum af manuel annotering og menneskelig indgriben – ideelt set ingen. Ud over omkostningsimplikationerne observerer forskerne i det nye papir, at annoteringer og manuelle segmenteringer foretaget af outsourcede crowdworkers på tværs af forskellige kulturer kan forårsage, at billeder bliver mærket eller endda segmenteret på forskellige måder, hvilket fører til inkonsekvente og utilfredsstillende algoritmer.

Et eksempel på dette er den subjektive fortolkning af, hvad der definerer et 'forgrundsobjekt':

Fra det nye papir: tidligere metoder L.F.M. og MODNet ('GT' står for Ground Truth, et 'ideelt' resultat, der ofte opnås manuelt eller ved ikke-algoritmiske metoder), har forskellige og varierende effektive tolkninger af definitionen af forgrundsindhold, hvorimod den nye SPG-IM-metode mere effektivt afgrænser 'nært indhold' gennem scenekontekst.

For at løse dette har forskerne udviklet en to-trins pipeline med titlen Situationsbestemt Perception Guided Image Matting (SPG-IM). To-trins encoder/dekoder-arkitekturen omfatter Situational Perception Destillation (SPD) og Situational Perception Guided Matting (SPGM).

For det første fortræner SPD visuelle-til-tekstuelle funktionstransformationer, og genererer billedtekster, der svarer til deres tilknyttede billeder. Herefter aktiveres forudsigelsen af forgrundsmaske ved at forbinde rørledningen til en roman saliency forudsigelse teknik.

Derefter udsender SPGM en estimeret alpha-matte baseret på det rå RGB-billedinput og den genererede maske opnået i det første modul.

Målet er situationsbestemt perceptionsvejledning, hvor systemet har en kontekstuel forståelse af, hvad billedet består af, så det kan ramme – for eksempel – udfordringen med at udvinde komplekst hår fra en baggrund mod kendte karakteristika ved en sådan specifik opgave.

I eksemplet nedenfor forstår SPG-IM, at snorene er en uundværlig del af en 'faldskærm', hvor MODNet ikke formår at bevare og definere disse detaljer. Ligeledes ovenfor går hele legepladsens struktur vilkårligt tabt i MODNet.

Den nye papir er titlen Situationsbestemt Perception Guided Image Matting, og kommer fra forskere ved OPPO Research Institute, PicUp.ai og Xmotors.

Intelligente automatiserede måtter

SPG-IM tilbyder også et Adaptive Focal Transformation (AFT) Refinement Network, der kan behandle lokale detaljer og global kontekst separat, hvilket muliggør 'intelligente matter'.

Forståelse af scenekontekst, i dette tilfælde 'pige med hest', kan potentielt gøre udtrækning af forgrunden nemmere end tidligere metoder.

Papiret siger:

'Vi mener, at visuelle repræsentationer fra den visuelle-til-tekstuelle opgave, f.eks billedtekster, fokus på mere semantisk omfattende signaler mellem a) objekt til objekt og b) objekt til det omgivende miljø for at generere beskrivelser, der kan dække både global information og lokale detaljer. Sammenlignet med den dyre pixelannotering ved billedmatting kan tekstlige etiketter desuden indsamles massivt til en meget lav pris.

SPD-grenen af arkitektur er foruddannet i samarbejde med University of Michigans VirTex transformer-baseret tekst-dekoder, som lærer visuelle repræsentationer fra semantisk tætte billedtekster.

VirTex træner i fællesskab et ConvNet og Transformers via billedtekstkupletter og overfører den opnåede indsigt til downstream-visionsopgaver såsom objektdetektering. Kilde: https://arxiv.org/pdf/2006.06666.pdf

Blandt andre tests og ablationsundersøgelser testede forskerne SPG-IM i forhold til state-of-the-art trimap-baserede metoder Deep Image Matting (DIM), IndexNet, Kontekstbevidst billedmatning (CAM), Vejledt kontekstuel opmærksomhed (GCA), FBA, og semantisk billedkortlægning (JA).

Andre tidligere testede rammer inkluderede trimap-fri tilgange L.F.M., HAttMattingog MODNetFor at sikre en rimelig sammenligning blev testmetoderne tilpasset baseret på de forskellige metoder; hvor kode ikke var tilgængelig, blev artiklens teknikker reproduceret fra den beskrevne arkitektur.

I det nye blad står der:

"Vores SPG-IM overgår alle konkurrerende trimap-fri metoder ([LFM], [HAttMatting] og [MODNet]) med en stor margin. Samtidig viser vores model også bemærkelsesværdig overlegenhed i forhold til de avancerede (SOTA) trimap-baserede og maskestyrede metoder med hensyn til alle fire metrikker på tværs af de offentlige datasæt (dvs. Composition-1K, Distinction-646 og Human-2K) og vores Multi-Object-1K benchmark."

Og fortsætter:

"Det kan tydeligt observeres, at vores metode bevarer fine detaljer (f.eks. hårspidser, transparente teksturer og grænser) uden vejledning fra trimap. Desuden kan vores SPG-IM, sammenlignet med andre konkurrerende trimap-fri modeller, bevare en bedre global semantisk fuldstændighed."

Først offentliggjort 24. april 2022.