Grafy jsou datové struktury, které představují složité vztahy napříč širokou škálou domén, včetně sociálních sítí, znalostních bází, biologických systémů a mnoha dalších. V těchto grafech jsou entity reprezentovány jako uzly a jejich vztahy jsou znázorněny jako hrany.

Schopnost efektivně reprezentovat a uvažovat o těchto složitých relačních strukturách je zásadní pro umožnění pokroku v oblastech, jako je síťová věda, cheminformatika a systémy doporučování.

Grafové neuronové sítě (GNN) se ukázaly jako výkonný rámec pro hluboké učení pro úlohy grafického strojového učení. Začleněním topologie grafu do architektury neuronové sítě prostřednictvím agregace sousedství nebo konvolucí grafů se GNN mohou naučit nízkorozměrné vektorové reprezentace, které kódují jak vlastnosti uzlů, tak jejich strukturální role. To umožňuje GNN dosáhnout nejmodernějšího výkonu při úkolech, jako je klasifikace uzlů, predikce spojení a klasifikace grafů v různých aplikačních oblastech.

Zatímco GNN přinesly značný pokrok, některé klíčové problémy přetrvávají. Získání vysoce kvalitních označených dat pro trénování kontrolovaných modelů GNN může být nákladné a časově náročné. Kromě toho mohou GNN bojovat s heterogenními strukturami grafů a situacemi, kdy se rozložení grafu v době testu výrazně liší od trénovacích dat (zobecnění mimo distribuci).

Paralelně, velké jazykové modely (LLM) jako GPT-4 a Lama vzali svět útokem svým neuvěřitelným porozuměním přirozenému jazyku a generačními schopnostmi. LLM, trénované na masivních textových korpusech s miliardami parametrů, vykazují pozoruhodné schopnosti učení, zobecňování napříč úkoly a logické uvažování, které byly kdysi považovány za extrémně náročné pro systémy AI.

Obrovský úspěch LLMs katalyzoval průzkumy k využití jejich výkonu pro úlohy grafického strojového učení. Na jedné straně znalosti a schopnosti uvažování LLM představují příležitosti k vylepšení tradičních modelů GNN. Naopak, strukturované reprezentace a faktické znalosti obsažené v grafech by mohly být nápomocné při řešení některých klíčových omezení LLM, jako jsou halucinace a nedostatečná interpretovatelnost.

V tomto článku se ponoříme do nejnovějších výzkumů na pomezí grafového strojového učení a velkých jazykových modelů. Prozkoumáme, jak lze LLM využít k vylepšení různých aspektů grafového ML, přezkoumáme přístupy k začlenění znalostí o grafech do LLM a prodiskutujeme vznikající aplikace a budoucí směřování této vzrušující oblasti.

Graf Neuronové sítě a samokontrolované učení

Abychom poskytli potřebný kontext, nejprve stručně zopakujeme základní koncepty a metody v grafových neuronových sítích a učení grafové reprezentace s vlastním dohledem.

Graf architektury neuronových sítí

Graf Architektura neuronové sítě – zdroj

Klíčový rozdíl mezi tradičními hlubokými neuronovými sítěmi a GNN spočívá v jejich schopnosti pracovat přímo s grafově strukturovanými daty. GNN se řídí schématem agregace sousedství, kde každý uzel agreguje vektory od svých sousedů, aby vypočítal svou vlastní reprezentaci.

Bylo navrženo mnoho architektur GNN s různými konkretizacemi zpráv a aktualizačních funkcí, jako např Graf Konvoluční sítě (GCN), GraphSAGE, Graf Attention Networks (GATs) a Graf sítě izomorfismu (GIN) mimo jiné.

V poslední době si grafové transformátory získaly oblibu přizpůsobením mechanismu sebepozorování z transformátorů přirozeného jazyka tak, aby fungovaly na grafově strukturovaných datech. Některé příklady zahrnují Graphormer Transformer, a GraphFormers. Tyto modely jsou schopny zachytit závislosti na dlouhé vzdálenosti napříč grafem lépe než čistě sousedské GNN.

Samokontrolované učení na grafech

Zatímco GNN jsou výkonné reprezentativní modely, jejich výkon je často omezen nedostatkem velkých označených datových sad potřebných pro školení pod dohledem. Samokontrolované učení se ukázalo jako slibné paradigma pro předtrénování GNN na neoznačených grafových datech využitím pretextových úloh, které vyžadují pouze vnitřní strukturu grafu a funkce uzlů.

Některé běžné úkoly se záminkou používané pro předškolení GNN s vlastním dohledem zahrnují:

- Predikce vlastností uzlu: Náhodné maskování nebo poškození části atributů/funkcí uzlu a zadání úkolu GNN je rekonstruovat.

- Edge/Link Prediction: Naučit se předpovídat, zda mezi párem uzlů existuje hrana, často na základě náhodného maskování hran.

- Kontrastivní učení: Maximalizace podobnosti mezi zobrazeními grafu stejného vzorku grafu při současném oddělování pohledů z různých grafů.

- Vzájemná informační maximalizace: Maximalizace vzájemné informace mezi reprezentacemi lokálních uzlů a cílovou reprezentací, jako je vkládání globálního grafu.

Úkoly se záminkou, jako jsou tyto, umožňují GNN extrahovat smysluplné strukturní a sémantické vzory z neoznačených grafových dat během předběžného školení. Předtrénované GNN pak lze doladit na relativně malé označené podmnožiny, aby vynikaly v různých následných úkolech, jako je klasifikace uzlů, predikce spojení a klasifikace grafů.

Díky využití samodohledu vykazují GNN předem vycvičené na velkých neoznačených souborech dat lepší zobecnění, odolnost vůči distribučním posunům a efektivitu ve srovnání s tréninkem od nuly. Některá klíčová omezení tradičních samokontrolovaných metod založených na GNN však zůstávají, na jejichž řešení se dále budeme zabývat využitím LLM.

Vylepšení Graph ML pomocí velkých jazykových modelů

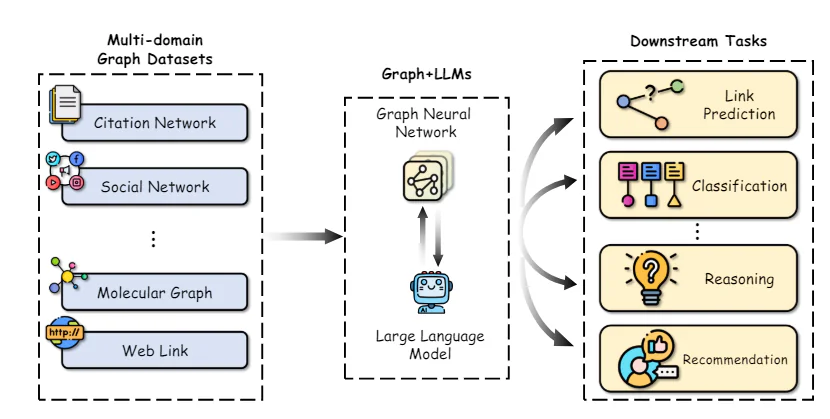

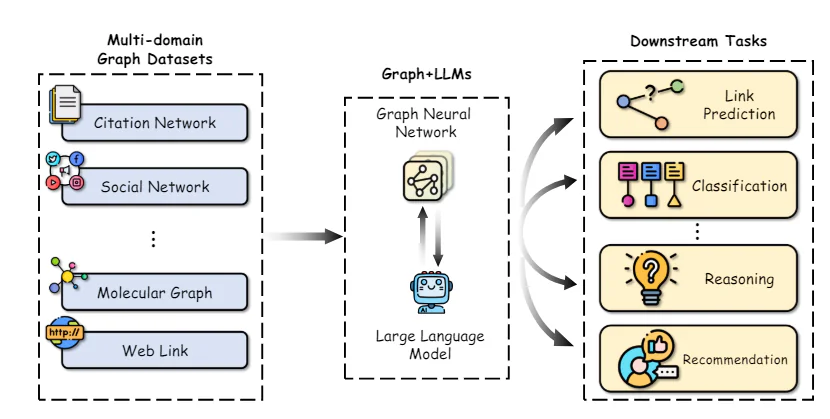

Integrace grafů a LLM – zdroj

Pozoruhodné schopnosti LLM v chápání přirozeného jazyka, uvažování a učení několika záběrů představují příležitosti k vylepšení mnoha aspektů kanálů grafického strojového učení. Prozkoumáme některé klíčové směry výzkumu v tomto prostoru:

Klíčovou výzvou při aplikaci GNN je získání vysoce kvalitních reprezentací prvků pro uzly a hrany, zejména pokud obsahují bohaté textové atributy, jako jsou popisy, názvy nebo abstrakty. Tradičně se používají jednoduché modely sáčků nebo předem trénované modely vkládání slov, které často nedokážou zachytit nuanční sémantiku.

Nedávné práce prokázaly sílu využití velkých jazykových modelů jako textových kodérů ke konstrukci lepších reprezentací uzlových/hranových prvků před jejich předáním GNN. Například, Chen a kol. využívat LLM jako GPT-3 ke kódování textových atributů uzlů, což ukazuje na výrazné zvýšení výkonu oproti tradičnímu vkládání slov v úlohách klasifikace uzlů.

Kromě lepších textových kodérů lze LLM použít ke generování rozšířených informací z původních textových atributů polořízeným způsobem. PÁSKA generuje potenciální popisky/vysvětlení pro uzly pomocí LLM a používá je jako další rozšířené funkce. KEA extrahuje termíny z textových atributů pomocí LLM a získává podrobné popisy těchto termínů pro rozšíření funkcí.

Zlepšením kvality a expresivity vstupních funkcí mohou LLM přenést své vynikající schopnosti porozumění přirozenému jazyku GNN a zvýšit výkon při navazujících úkolech.

Zmírnění závislosti na označených datech

Klíčovou výhodou LLM je jejich schopnost provádět přiměřeně dobře nové úkoly s malým množstvím nebo žádnými označenými daty, a to díky jejich předběžnému školení na rozsáhlých textových korpusech. Tuto schopnost několikanásobného učení lze využít ke zmírnění závislosti GNN na velkých označených souborech dat.

Jedním z přístupů je použití LLM k přímému předpovídání úloh v grafu popisem struktury grafu a informací o uzlech pomocí výzev v přirozeném jazyce. Metody jako InstruujteGLM a GPT4Graph dolaďte LLM jako LLaMA a GPT-4 pomocí pečlivě navržených výzev, které zahrnují detaily topologie grafu, jako jsou připojení uzlů, sousedství atd. Vyladěné LLM pak mohou generovat předpovědi pro úkoly, jako je klasifikace uzlů a predikce spojů, způsobem nulového záběru během vyvozování.

I když se použití LLM jako prediktorů černé skříňky ukázalo jako slibné, jejich výkon klesá u složitějších úloh s grafy, kde je výhodné explicitní modelování struktury. Některé přístupy tak využívají LLM ve spojení s GNN – GNN kóduje grafovou strukturu, zatímco LLM poskytuje lepší sémantické pochopení uzlů z jejich textových popisů.

Porozumění grafu s LLM Framework – Zdroj

GraphLLM zkoumá dvě strategie: 1) LLMs-as-Enhancers, kde LLM kódují atributy textových uzlů před předáním do GNN, a 2) LLMs-as-Predictory, kde LLM bere přechodné reprezentace GNN jako vstup pro vytváření konečných předpovědí.

GLEM jde dále tím, že navrhuje variační EM algoritmus, který střídavě aktualizuje komponenty LLM a GNN pro vzájemné vylepšení.

Snížením spoléhání se na označená data prostřednictvím funkcí několika snímků a částečně kontrolovaného rozšiřování mohou metody učení grafů vylepšené LLM odemknout nové aplikace a zlepšit efektivitu dat.

Vylepšení LLM pomocí grafů

Zatímco LLM byly ohromně úspěšné, stále trpí klíčovými omezeními, jako jsou halucinace (generování nefaktických prohlášení), nedostatečná interpretovatelnost v procesu uvažování a neschopnost udržovat konzistentní faktické znalosti.

Grafy, zejména znalostní grafy, které představují strukturované faktické informace ze spolehlivých zdrojů, představují slibné cesty k řešení těchto nedostatků. Zkoumáme některé nové přístupy v tomto směru:

Knowledge Graph Enhanced LLM Pre-školení

Podobně jako jsou LLM předem vyškoleni na velkých textových korpusech, nedávné práce prozkoumali jejich předškolení na znalostních grafech, aby získali lepší faktické povědomí a schopnosti uvažování.

Některé přístupy upravují vstupní data jednoduchým zřetězením nebo zarovnáním faktických trojic KG s textem v přirozeném jazyce během předtréninku. E-BERT zarovná vektory entit KG s vloženými slovy BERT, zatímco K-BERT konstruuje stromy obsahující původní větu a příslušné trojice KG.

Role LLM v grafovém strojovém učení:

Výzkumníci prozkoumali několik způsobů, jak integrovat LLM do procesu učení grafů, z nichž každý má své jedinečné výhody a aplikace. Zde jsou některé z významných rolí, které mohou LLM hrát:

- LLM jako Enhancer: V tomto přístupu se LLM používají k obohacení textových atributů spojených s uzly v TAG. Schopnost LLM generovat vysvětlení, znalostní entity nebo pseudonávěsky může rozšířit sémantické informace dostupné pro GNN, což vede k lepší reprezentaci uzlů a následnému výkonu úkolů.

Například model TAPE (Text Augmented Pre-trained Encoders) využívá ChatGPT ke generování vysvětlení a pseudooznačení pro články citační sítě, které se pak používají k doladění jazykového modelu. Výsledná vložení jsou přiváděna do GNN pro klasifikaci uzlů a úlohy predikce propojení, čímž se dosahují nejmodernější výsledky.

- LLM jako prediktor: Spíše než vylepšování vstupních funkcí některé přístupy přímo využívají LLM jako prediktorovou komponentu pro úlohy související s grafy. To zahrnuje převod struktury grafu na textovou reprezentaci, kterou lze zpracovat LLM, která pak generuje požadovaný výstup, jako jsou popisky uzlů nebo predikce na úrovni grafu.

Jedním z pozoruhodných příkladů je model GPT4Graph, který představuje grafy pomocí jazyka pro modelování grafů (GML) a využívá výkonné GPT-4 LLM pro úlohy uvažování o grafech s nulovým záběrem.

- Zarovnání GNN-LLM: Další linie výzkumu se zaměřuje na zarovnání vnořovacích prostorů GNN a LLM, což umožňuje bezproblémovou integraci strukturálních a sémantických informací. Tyto přístupy zacházejí s GNN a LLM jako se samostatnými modalitami a využívají techniky, jako je kontrastivní učení nebo destilace, aby sladily jejich reprezentace.

Projekt MoleculeSTM model například používá kontrastivní cíl ke sladění vložení GNN a LLM, což umožňuje LLM začlenit strukturální informace z GNN, zatímco GNN těží ze sémantických znalostí LLM.

Výzvy a řešení

Zatímco integrace LLM a učení grafů je nesmírně slibná, je třeba vyřešit několik problémů:

- Účinnost a škálovatelnost: LLM jsou notoricky náročné na zdroje, často vyžadují miliardy parametrů a nesmírný výpočetní výkon pro školení a vyvozování. To může být významnou překážkou pro nasazení LLM-vylepšených modelů učení grafů v aplikacích v reálném světě, zejména na zařízeních s omezenými zdroji.

Jedno slibné řešení je znalostní destilace, kde se znalosti z velkého LLM (model učitele) přenášejí do menšího, efektivnějšího GNN (model studenta).

- Únik dat a vyhodnocení: LLM jsou předem vyškoleni na obrovském množství veřejně dostupných dat, která mohou zahrnovat testovací sady z běžných referenčních datových sad, což vede k potenciálnímu úniku dat a nadhodnocenému výkonu. Výzkumníci začali shromažďovat nové datové sady nebo vzorkovat testovací data z časových období po ukončení školení LLM, aby tento problém zmírnili.

Kromě toho je stanovení spravedlivých a komplexních hodnotících měřítek pro modely grafového učení vylepšené LLM zásadní pro měření jejich skutečných schopností a umožnění smysluplného srovnání.

- Přenositelnost a vysvětlitelnost: Zatímco LLM vynikají ve výuce nulových a několika výstřelů, jejich schopnost přenášet znalosti napříč různými doménami a strukturami grafů zůstává otevřenou výzvou. Zlepšení přenositelnosti těchto modelů je kritickým směrem výzkumu.

Kromě toho je zlepšení vysvětlitelnosti modelů učení grafů založených na LLM zásadní pro budování důvěry a umožnění jejich přijetí ve vysoce sázkových aplikacích. Využití inherentních rozumových schopností LLM prostřednictvím technik, jako je např nabádání myšlenkového řetězce může přispět ke zlepšení vysvětlitelnosti.

- Multimodální integrace: Grafy často obsahují více než jen textové informace, s uzly a okraji potenciálně spojenými s různými modalitami, jako jsou obrázky, zvuk nebo číselná data. Rozšíření integrace LLM na tato nastavení multimodálních grafů představuje vzrušující příležitost pro budoucí výzkum.

Reálné aplikace a případové studie

Integrace LLM a strojového učení grafů již ukázala slibné výsledky v různých aplikacích v reálném světě:

- Predikce molekulárních vlastností: V oblasti výpočetní chemie a objevování léků byly LLM použity ke zlepšení predikce molekulárních vlastností začleněním strukturních informací z molekulárních grafů. The Model LLM4Mol, například využívá ChatGPT ke generování vysvětlení pro SMILES (Simplified Molecular-Input Line-Entry System) reprezentace molekul, které se pak používají ke zlepšení přesnosti úloh predikce vlastností.

- Dokončení a zdůvodnění znalostního grafu: Znalostní grafy jsou speciálním typem grafové struktury, která představuje entity reálného světa a jejich vztahy. LLM byly prozkoumány pro úkoly, jako je dokončování znalostního grafu a uvažování, kde je třeba strukturu grafu a textové informace (např. popisy entit) posuzovat společně.

- Doporučující systémy: V oblasti doporučujících systémů se k reprezentaci interakcí uživatele a položky často používají grafové struktury, přičemž uzly představují uživatele a položky a hrany označují interakce nebo podobnosti. LLM lze využít k vylepšení těchto grafů generováním informací na straně uživatele/položky nebo posílením interakčních hran.

Proč investovat do čističky vzduchu?

Synergie mezi Large Language Models a Graph Machine Learning představuje vzrušující hranici ve výzkumu umělé inteligence. Kombinací strukturní induktivní zaujatosti GNN s výkonnými schopnostmi sémantického porozumění LLM můžeme odemknout nové možnosti v úlohách učení grafů, zejména pro textově přiřazené grafy.

I když bylo dosaženo významného pokroku, přetrvávají problémy v oblastech, jako je efektivita, škálovatelnost, přenositelnost a vysvětlitelnost. Techniky, jako je destilace znalostí, spravedlivé hodnotící benchmarky a multimodální integrace, dláždí cestu pro praktické nasazení modelů učení grafů vylepšených LLM v aplikacích v reálném světě.