Umělá inteligence

Lepší výkon strojového učení díky změně velikosti obrazu na bázi CNN

Google Research navrhl novou metodu pro zlepšení efektivity a přesnosti tréninkových pracovních postupů počítačového vidění založených na obrázcích tím, že zlepší způsob, jakým jsou obrázky v sadě dat zmenšovány ve fázi předběžného zpracování.

v papír Naučte se měnit velikost obrázků pro úlohy počítačového vidění, výzkumníci Hossein Talebi a Peyman Milanfar využívají CNN k vytvoření nové hybridní architektury pro změnu velikosti obrazu, která přináší pozoruhodné zlepšení výsledků rozpoznávání získaných přes čtyři populární datové sady počítačového vidění.

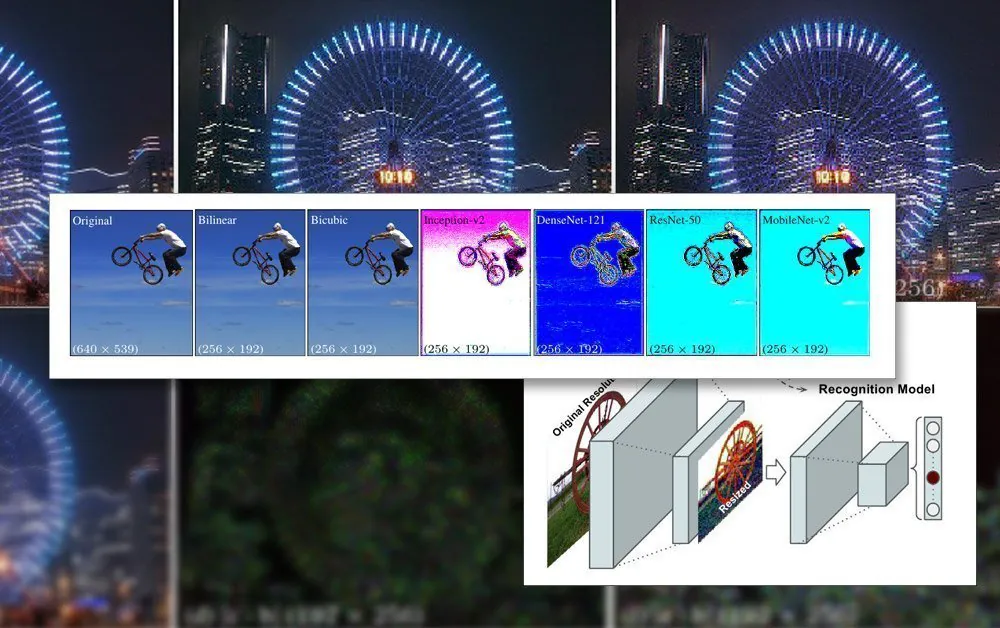

Navrhovaný společný rámec pro uznávání a změnu velikosti. Zdroj: https://arxiv.org/pdf/2103.09950.pdf

Článek poznamenává, že metody změny měřítka/změny velikosti, které se v současnosti používají v automatizovaných kanálech strojového učení, jsou desítky let zastaralé a často používají pouze základní bilineární, bikubický a nejbližší soused. změna velikosti – metody, které zacházejí se všemi pixely bez rozdílu.

Na rozdíl od toho navrhovaná metoda rozšiřuje obrazová data prostřednictvím CNN a začleňuje tento vstup do obrázků se změněnou velikostí, které nakonec projdou architekturou modelu.

Omezení obrazu ve školení AI

Aby bylo možné trénovat model, který se zabývá obrázky, bude rámec strojového učení zahrnovat fázi předběžného zpracování, kde je systematicky ořezávána různorodá řada obrázků různých velikostí, barevných prostorů a rozlišení (které přispějí k trénovací datové sadě). upravena do konzistentních rozměrů a stabilního jediného formátu.

Obecně to bude zahrnovat určitý kompromis založený na formátu PNG, kde bude stanoven kompromis mezi dobou zpracování/zdroji, velikostí souboru a kvalitou obrazu.

Ve většině případů jsou konečné rozměry zpracovávaného obrazu velmi malé. Níže vidíme příklad obrázku s rozlišením 80×80, na kterém jsou některé z prvních deepfake datových sad byly vytvořeny:

Vzhledem k tomu, že obličeje (a další možné objekty) se zřídka vejdou do požadovaného čtvercového poměru, může být nutné přidat černé pruhy (nebo povolit plýtvání prostorem), aby se snímky homogenizovaly, což dále snižuje skutečně použitelná obrazová data:

Zde byl obličej vyjmut z větší oblasti obrazu, dokud není oříznut tak hospodárně, jak jen to může být, aby zahrnoval celou oblast obličeje. Jak je však vidět napravo, velká část zbývající plochy nebude během tréninku využita, což zvyšuje důležitost kvality obrazu dat se změněnou velikostí.

S tím, jak se v posledních letech zlepšily možnosti GPU s novou generací karet NVIDIA vybavených zvyšující se částky video-RAM (VRAM), průměrné velikosti přispívajících obrázků se začínají zvětšovat, i když 224×224 pixelů je stále docela standardní (například je to velikost ResNet-50 datová sada).

Obrázek bez velikosti 224 × 244 pixelů.

Montáž dávek do VRAM

Důvodem, proč musí mít všechny obrázky stejnou velikost, je to gradientní sestup, metoda, kterou se model postupem času zlepšuje, vyžaduje jednotná trénovací data.

Důvodem, proč musí být obrázky tak malé, je to, že musí být načteny (plně dekomprimovány) do VRAM během tréninku v malých dávkách, obvykle mezi 6-24 obrázky na dávku. Příliš málo obrázků na dávku a není dostatek skupinového materiálu pro dobré zobecnění, navíc se prodlužuje doba školení; příliš mnoho a model nemusí získat potřebné charakteristiky a podrobnosti (viz níže).

Tato sekce „živého načítání“ školicí architektury se nazývá latentní prostor. Zde jsou vlastnosti opakovaně extrahovány ze stejných dat (tj. stejných obrázků), dokud model nekonverguje do stavu, kdy má všechny zobecněné znalosti, které potřebuje k provádění transformací na pozdějších, neviditelných datech podobného typu.

Tento proces obvykle trvá dny, i když může trvat i měsíc nebo více neustálého a neústupného přemýšlení o velkém objemu 24/7, než se dosáhne užitečného zobecnění. Zvětšení velikosti VRAM je užitečné pouze do určité míry, protože i malé přírůstky v rozlišení obrazu mohou mít řádový vliv na kapacitu zpracování a související účinky na přesnost, která nemusí být vždy příznivá.

Použití větší kapacity VRAM pro přizpůsobení se vyšším velikostem dávek je také smíšeným požehnáním, protože vyšší tréninkové rychlosti jsou díky tomu pravděpodobně bude kompenzován méně přesnými výsledky.

Vzhledem k tomu, že architektura školení je tak omezená, je pozoruhodným úspěchem cokoli, co může ovlivnit zlepšení v rámci stávajících omezení potrubí.

Jak pomáhá vynikající zmenšení velikosti

Bylo prokázáno, že konečná kvalita obrazu, který bude zahrnut do tréninkové datové sady, má zlepšující účinek na výsledek školení, zejména v úlohách rozpoznávání objektů. V roce 2018 výzkumníci z Institutu Maxe Plancka pro inteligentní systémy tvrdil že výběr metody převzorkování výrazně ovlivňuje výkonnost a výsledky tréninku.

Předchozí práce od společnosti Google (spolunapsané autory nového článku) navíc zjistily, že přesnost klasifikace lze zlepšit udržení kontroly přes kompresní artefakty v obrazech datové sady.

Model CNN vestavěný do nového resampleru kombinuje bilineární změnu velikosti s funkcí „přeskočit připojení“, která může začlenit výstup z trénované sítě do obrazu se změněnou velikostí.

Na rozdíl od typické architektury kodéru/dekodéru může nový návrh fungovat nejen jako dopředné úzké hrdlo, ale také jako inverzní úzké hrdlo pro upscaling na jakoukoli cílovou velikost a/nebo poměr stran. Navíc lze „standardní“ metodu převzorkování zaměnit za jakoukoli jinou vhodnou tradiční metodu, jako je např. spustí.

Podrobnosti o vysoké frekvenci

Nová metoda vytváří obrázky, které ve skutečnosti „zapékají“ klíčové vlastnosti (které nakonec pozná trénovací proces) přímo do zdrojového obrázku. Z estetického hlediska jsou výsledky nekonvenční:

Nová metoda aplikovaná ve čtyřech sítích – Inception V2; DenseNet-121; ResNet-50; a MobileNet-V2. Výsledky metody převzorkování/změny velikosti obrázků v Google Research vytvářejí obrázky se zřejmou agregací pixelů, což předvídá klíčové funkce, které budou rozpoznány během tréninkového procesu.

Výzkumníci poznamenávají, že tyto počáteční experimenty jsou výhradně optimalizovány pro úlohy rozpoznávání obrazu a že v testech jejich „naučený resizer“ napájený CNN dokázal v takových úlohách dosáhnout lepší chybovosti. Výzkumníci hodlají v budoucnu použít metodu i na jiné typy aplikací počítačového vidění založených na obrazu.