زاوية أندرسون

إضافة حوار إلى فيديو حقيقي باستخدام الذكاء الاصطناعي

يمكن لإطار عمل جديد للذكاء الاصطناعي إعادة كتابة كلمات الشخص أو إزالتها أو إضافتها في الفيديو دون إعادة التصوير، وذلك في نظام واحد متكامل.

قبل ثلاث سنوات، كان الإنترنت سيندهش من أي من أطر تعديل الفيديو بالذكاء الاصطناعي التي يتراوح عددها بين 20 و30 والتي يتم نشرها في البوابات الأكاديمية أسبوعيًا؛ أما الآن، فقد أصبح هذا الفرع الشائع من البحث غزير الإنتاج لدرجة أنه يشكل تقريبًا فرعًا آخر من "هراء الذكاء الاصطناعي"، وأنا أغطي عددًا أقل بكثير من هذه الإصدارات مقارنة بما كنت سأغطيه قبل عامين أو ثلاثة أعوام.

ومع ذلك، لفت انتباهي إصدار حالي واحد في هذا الخط: نظام متكامل يمكنه التدخل في مقاطع الفيديو الحقيقية وإدخال كلام جديد في الفيديو الحالي (بدلاً من إنشاء مقطع توليدي كامل من وجه أو إطار، وهو أمر أكثر شيوعًا).

في الأمثلة أدناه، والتي قمت بتجميعها من مجموعة كبيرة من مقاطع الفيديو التجريبية المتاحة في الإصدار موقع المشروعنرى أولاً المقطع الأصلي، ثم نرى أسفله الكلام المُضاف بواسطة الذكاء الاصطناعي في منتصف المقطع، بما في ذلك توليف الصوت ومزامنة حركة الشفاه:

انقر للعب. التحرير الموضعي مع دمج الصور - إحدى الطرق العديدة التي يقدمها موقع FacEDiT. يرجى الرجوع إلى الموقع الإلكتروني المصدر للحصول على دقة أفضل. المصدر – https://facedit.github.io/

يُعدّ هذا النهج أحد ثلاثة مناهج طُوّرت للطريقة الجديدة، وهذه المرة بعنوان "التحرير الموضعي مع دمج المقاطع"، وهو الأكثر إثارة لاهتمام المؤلفين (وأنا منهم). تتلخص الفكرة في توسيع المقطع باستخدام إحدى الإطارات الوسطى كنقطة انطلاق لتفسير الذكاء الاصطناعي، والإطار التالي (الحقيقي) كهدف يسعى المقطع المُضاف المُولّد إلى مطابقته. في المقاطع الموضحة أعلاه، يُمثّل إطارا "البذرة" و"الهدف" بتوقف الفيديو العلوي مؤقتًا، بينما يُوفّر الفيديو المُعدّل في الأسفل تعبئةً توليدية.

يصف المؤلفون هذا النهج في توليف تعابير الوجه والصوت بأنه أول طريقة متكاملة تمامًا من البداية إلى النهاية لتحرير الفيديو باستخدام الذكاء الاصطناعي من هذا النوع، مشيرين إلى إمكانات إطار عمل متطور بالكامل كهذا في إنتاج التلفزيون والأفلام:

غالباً ما يحتاج صانعو الأفلام ومنتجو الوسائط إلى مراجعة أجزاء محددة من مقاطع الفيديو المسجلة - ربما تم نطق كلمة بشكل خاطئ أو تم تغيير النص بعد التصوير. على سبيل المثال، في المشهد الشهير من جبار (1997) حيث تقول روز، "لن أتركك أبداً يا جاك." قد يقرر المخرج لاحقاً أنه ينبغي أن يكون لن أنساك أبداً يا جاك..

تقليدياً، تتطلب هذه التغييرات إعادة تصوير المشهد بأكمله، وهو أمر مكلف ويستغرق وقتاً طويلاً. يوفر توليف الوجه الناطق بديلاً عملياً من خلال تعديل حركة الوجه تلقائياً لتتوافق مع الكلام المعدل، مما يلغي الحاجة إلى إعادة التصوير.

على الرغم من أن تدخلات الذكاء الاصطناعي من هذا النوع قد تواجه ثقافي أو مقاومة الصناعة، قد تشكل هذه التحديات أيضاً نوعاً جديداً من الوظائف في أنظمة وأدوات المؤثرات البصرية التي يقودها البشر. على أي حال، في الوقت الراهن، تقتصر التحديات على الجوانب التقنية فقط.

إلى جانب إمكانية تمديد المقطع من خلال حوار إضافي مُولّد بالذكاء الاصطناعي، يمكن للنظام الجديد أيضًا تغيير الكلام الموجود:

انقر للعب. مثال على تغيير الحوار القائم بدلاً من إضافة حوار جديد. يُرجى الرجوع إلى الموقع الإلكتروني الأصلي للحصول على دقة أفضل.

مثال رائع من الفن

لا توجد حاليًا أنظمة متكاملة توفر هذا النوع من إمكانيات التركيب؛ على الرغم من وجود عدد متزايد من منصات الذكاء الاصطناعي التوليدي مثل منصة جوجل. سلسلة فيويمكنها توليد الصوت، ويمكن لأطر عمل أخرى متنوعة إنشاء صوت مُزيّف بتقنية التزييف العميقيتعين على المرء حاليًا إنشاء سلسلة معقدة من البنى والحيل المتنوعة للتدخل في اللقطات الحقيقية بالطريقة التي يعمل بها النظام الجديد - المسمى تعديل الوجه – يمكن إنجازه.

يستخدم النظام محولات الانتشار (DiT) بالاشتراك مع مطابقة التدفق لإنشاء حركات الوجه بناءً على الحركات المحيطة (السياقية) ومحتوى الصوت الكلامي. يستفيد النظام من الحزم الشائعة الموجودة التي تتعامل مع إعادة بناء الوجه، بما في ذلك صورة حية (استحوذت عليها شركة كلينغ مؤخراً).

بالإضافة إلى هذه الطريقة، ونظرًا لأن نهجهم هو الأول الذي يدمج هذه التحديات في حل واحد، فقد ابتكر المؤلفون معيارًا جديدًا يسمى FaceDeBenchبالإضافة إلى العديد من مقاييس التقييم الجديدة تمامًا والمناسبة لهذه المهمة المحددة للغاية.

أكثر من عمل جديد بعنوان FaceEDiT: تحرير وتوليد الوجوه الناطقة بشكل موحد عبر ملء حركة الوجهوتأتي هذه الدراسة من أربعة باحثين من جامعة بوهانغ للعلوم والتكنولوجيا (POSTECH) في كوريا، والمعهد الكوري المتقدم للعلوم والتكنولوجيا (KAIST)، وجامعة تكساس في أوستن.

الأسلوب

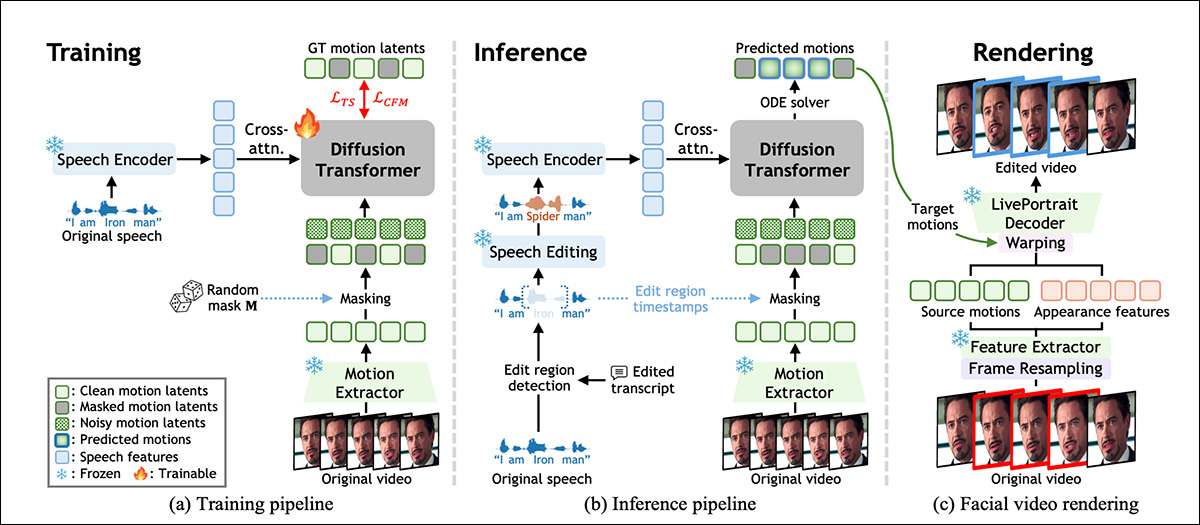

يتم تدريب نموذج FacEDiT على إعادة بناء حركة الوجه من خلال تعلم كيفية ملء الأجزاء المفقودة من أداء الممثل الأصلي، بناءً على الحركة المحيطة والصوت. وكما هو موضح في الرسم التخطيطي أدناه، تسمح هذه العملية للنموذج بالعمل كأداة لملء الفجوات أثناء التدريب، حيث يتنبأ بحركات الوجه التي تتطابق مع الصوت مع الحفاظ على التناسق مع الفيديو الأصلي.

نظرة عامة على نظام FacEDiT، توضح كيفية تعلم حركة الوجه من خلال التعبئة الذاتية أثناء التدريب، والاسترشاد بالكلام المحرر عند الاستدلال، ثم إعادة عرضها في الفيديو عن طريق إعادة استخدام مظهر اللقطات الأصلية، مع استبدال الحركة المستهدفة فقط. مصدر

في وقت الاستدلال، يدعم نفس التصميم مخرجين مختلفين اعتمادًا على مقدار الفيديو الذي تم إخفاؤه: تعديلات جزئية، حيث يتم تغيير عبارة واحدة فقط ويترك الباقي دون تغيير؛ أو توليد جملة كاملة، حيث يتم توليف حركة جديدة بالكامل من الصفر.

يتم تدريب النموذج عبر مطابقة التدفق، والتي تتعامل مع تعديلات الفيديو كنوع من المسار بين نسختين من حركة الوجه.

بدلاً من تعلم تخمين شكل الوجه المُعدَّل من الصفر، يتعلم نظام مطابقة التدفق الانتقال تدريجياً وبسلاسة بين صورة مؤقتة غير دقيقة والحركة الصحيحة. ولتسهيل ذلك، يُمثِّل النظام حركة الوجه كمجموعة مُختصرة من الأرقام المُستخرجة من كل إطار باستخدام نسخة من نظام LivePortrait المذكور سابقاً (انظر المخطط أعلاه).

صُممت متجهات الحركة هذه لوصف تعابير الوجه ووضعية الرأس بدون متشابك الهوية، بحيث يمكن تحديد التغيرات في الكلام بشكل موضعي دون التأثير على المظهر العام للشخص.

تدريب FaceDet

لتدريب نموذج FacEDiT، تم تقسيم كل مقطع فيديو إلى سلسلة من لقطات حركة الوجه، وتم ربط كل إطار بجزء صوتي مطابق. ثم تم إخفاء أجزاء عشوائية من بيانات الحركة، وطُلب من النموذج تخمين شكل تلك الحركات المفقودة، باستخدام كل من الكلام والحركة المحيطة غير المخفية للسياق.

نظراً لأن النطاقات المقنعة ومواقعها تختلف من مثال تدريبي إلى آخر، فإن النموذج يتعلم تدريجياً كيفية التعامل مع كل من التعديلات الداخلية الصغيرة والفجوات الأطول، لتوليد التسلسل الكامل، وفقاً لكمية المعلومات التي يتم إعطاؤها له.

يتعلم مُحوِّل الانتشار المذكور في النظام استعادة الحركة المُقنّعة من خلال تحسين المدخلات المشوّشة بمرور الوقت. وبدلاً من إدخال الكلام والحركة إلى النموذج دفعة واحدة، يتم تمرير الصوت إلى كل وحدة معالجة من خلال الاهتمام المتبادلمما يساعد النظام على مطابقة حركات الشفاه بدقة أكبر مع الكلام الصوتي.

للحفاظ على الواقعية بين التعديلات، يُوجَّه الانتباه نحو الإطارات المجاورة بدلاً من التسلسل الزمني بأكمله، مما يُجبر النموذج على التركيز على الاستمرارية المحلية، ويمنع حدوث ومضات أو قفزات في الحركة عند حواف المناطق المُعدَّلة. كما تُساعد التضمينات الموضعية (التي تُحدد للنموذج مكان ظهور كل إطار في التسلسل) النموذج على الحفاظ على التدفق الزمني والسياق الطبيعيين.

أثناء التدريب، يتعلم النظام التنبؤ بحركات الوجه المفقودة من خلال إعادة بناء أجزاء الوجه المقنعة بناءً على الكلام والحركات غير المقنعة المجاورة. وعند الاستدلال، يُعاد استخدام نفس الإعداد، ولكن مع توجيه الأقنعة الآن بتعديلات في الكلام.

عند إدخال كلمة أو عبارة أو حذفها أو تغييرها، يحدد النظام المنطقة المتأثرة، ويخفيها، ثم يعيد توليد حركة تتطابق مع الصوت الجديد. أما توليد التسلسل الكامل فيُعامل كحالة خاصة، حيث تُخفى المنطقة بأكملها ويُعاد توليدها من الصفر.

البيانات والاختبارات

يتألف العمود الفقري للنظام من 22 طبقة لمحول الانتشار، كل منها يحتوي على 16 رؤوس الانتباه وأبعاد التغذية الأمامية 1024 و2024 بكسل. يتم استخراج ميزات الحركة والمظهر باستخدام مجمد مكونات LivePortrait، والكلام المشفر عبر واف إل إم وتم تعديله باستخدام حرفة صوتية.

تقوم طبقة إسقاط مخصصة برسم ميزات الكلام ذات الأبعاد 786 في الفضاء الكامن لـ DiT، مع تدريب وحدات DiT والإسقاط فقط من الصفر.

تم إجراء التدريب تحت إشراف آدم دبليو مُحسِّن بمعدل تعلّم مستهدف قدره 1e-4، لمليون خطوة، على وحدتي معالجة رسومية A6000 (كل منهما بذاكرة وصول عشوائي للفيديو سعتها 48 جيجابايت)، بإجمالي حجم الدفعة من ثمانية.

FaceDeBench

تحتوي مجموعة بيانات FacEDiTBench على 250 مثالًا، كل منها مزود بمقطع فيديو للخطاب الأصلي والمعدل، بالإضافة إلى نصوص مكتوبة لكليهما. تأتي مقاطع الفيديو من ثلاثة مصادر، مع 100 مقطع من HDTF، 100 من هلو 3، و 50 من CelebV-Dubتم فحص كل منها يدويًا للتأكد من أن الصوت والفيديو واضحان بما يكفي للتقييم.

GPT‑4o استُخدمت هذه التقنية لمراجعة كل نص مكتوب بهدف إنشاء تعديلات صحيحة نحوياً. ثم أُرسلت هذه النصوص المُعدّلة، بالإضافة إلى الكلام الأصلي، إلى برنامج VoiceCraft لإنتاج صوت جديد؛ وفي كل مرحلة، خضع كل من النص المكتوب والكلام المُنتج لمراجعة يدوية للتأكد من جودتهما.

تم تصنيف كل عينة بنوع التعديل، وتوقيت التغيير، وطول النطاق المعدل، وتم تصنيف التعديلات على النحو التالي: الإدراج, الحذف أو بدائلتراوح عدد الكلمات التي تم تغييرها بين تعديلات قصيرة من 1 إلى 3 كلمات، وتعديلات متوسطة من 4 إلى 6 كلمات، وتعديلات أطول من 7 إلى 10 كلمات.

تم تحديد ثلاثة مقاييس مخصصة لتقييم جودة التحرير. الاستمرارية الضوئية، لقياس مدى اندماج الإضاءة واللون في مقطع تم تحريره مع الفيديو المحيط، من خلال مقارنة الاختلافات على مستوى البكسل عند الحدود؛ استمرارية الحركةلتقييم اتساق حركة الوجه، من خلال قياس تغيرات التدفق البصري عبر الإطارات المعدلة وغير المعدلة؛ و الحفاظ على الهويةلتقدير ما إذا كان مظهر الشخص يظل متسقًا بعد التحرير، من خلال مقارنة تمثيلات الوجه من التسلسلات الأصلية والمولدة باستخدام قوس الوجه نموذج التعرف على الوجوه.

اختبارات

تم تدريب نموذج الاختبار على مواد من مجموعات البيانات الثلاث المذكورة أعلاه، والتي يبلغ مجموعها حوالي 200 ساعة من محتوى الفيديو، بما في ذلك مدونات الفيديو والأفلام، بالإضافة إلى مقاطع فيديو يوتيوب عالية الدقة.

لتقييم تحرير الوجه الناطق، تم استخدام FacEDiTBench، بالإضافة إلى تقسيم اختبار HDTF، والذي أصبح معيارًا مرجعيًا لهذه المجموعة من المهام.

نظراً لعدم وجود أنظمة قابلة للمقارنة بشكل مباشر قادرة على تغليف هذا النوع من الوظائف الشاملة، فقد اختار المؤلفون مجموعة متنوعة من الأطر التي تعيد إنتاج بعض الوظائف المستهدفة على الأقل، ويمكن أن تعمل كخطوط أساسية؛ وهي: كي فيس; إيكوميميك; إيكو ميميك الإصدار 2; مرحباً; هلو 2; هلو 3; في-إكسبريس; AniPortrait، و حزين.

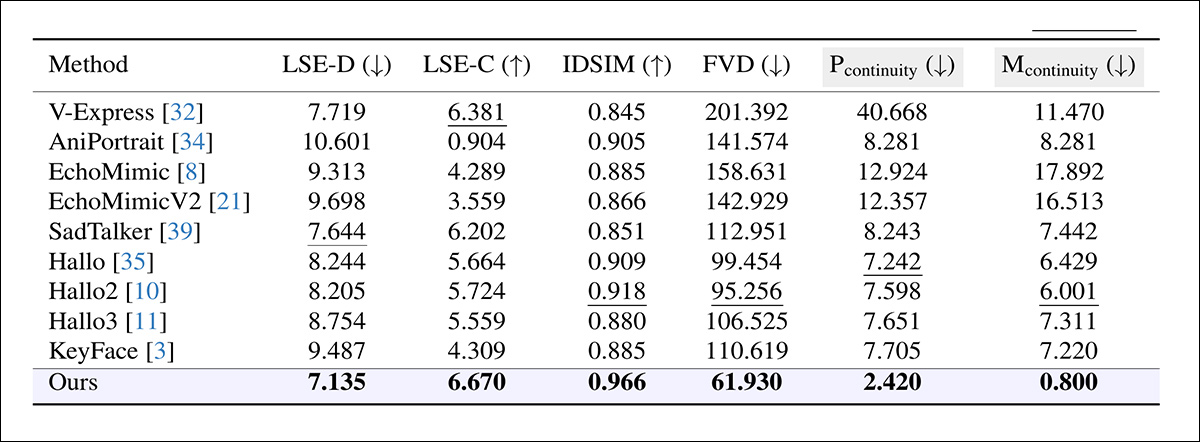

كما تم استخدام العديد من المقاييس المعتمدة لتقييم جودة الإنتاج والتحرير، مع تقييم دقة مزامنة الشفاه من خلال سينك نت، حيث يتم الإبلاغ عن كل من الخطأ المطلق بين حركات الشفاه والصوت (LSE-D) ودرجة الثقة (LSE-C)؛ مسافة فيديو فريشيت (FVD) تحديد مدى واقعية الفيديو بشكل عام؛ و مقاييس التشابه الإدراكي المكتسبة (LPIPS)، قياس التشابه الإدراكي بين الإطارات المُنشأة والإطارات الأصلية.

لأغراض التحرير، تم تطبيق جميع المقاييس باستثناء LPIPS فقط على الجزء المعدل؛ أما بالنسبة للإنشاء، فقد تم تقييم الفيديو بأكمله، مع استبعاد استمرارية الحدود.

صُمم كل نموذج لتوليد مقطع فيديو مطابق، ثم دُمج هذا المقطع في المقطع الأصلي (يشير الباحثون إلى أن هذه الطريقة غالبًا ما تُحدث فواصل مرئية، حيث يلتقي الجزء المُعدّل مع اللقطات المحيطة). كما جُرّب نهج ثانٍ، حيث أُعيد توليد الفيديو بالكامل من الصوت المُعدّل، لكن هذا أدى حتمًا إلى استبدال المناطق غير المُعدّلة، وفشل في الحفاظ على الأداء الأصلي.

مقارنة أداء التحرير بين الأنظمة المصممة أصلاً لتوليد وجوه ناطقة، حيث يتفوق نظام FacEDiT على جميع الأنظمة الأساسية في كل مقياس، محققاً خطأً أقل في مزامنة حركة الشفاه (LSE-D)، وثقة أعلى في المزامنة (LSE-C)، وحفظاً أقوى للهوية (IDSIM)، وواقعية إدراكية أكبر (FVD)، وانتقالات أكثر سلاسة عبر حدود التحرير (Pcontinuity، Mcontinuity). تُبرز الأعمدة المظللة باللون الرمادي المعايير الرئيسية لتقييم جودة الحدود؛ وتشير القيم المكتوبة بخط غامق والمسطرة إلى أفضل النتائج وثاني أفضلها، على التوالي.

وفيما يتعلق بهذه النتائج، يعلق المؤلفون بما يلي:

يتفوق نموذجنا بشكل ملحوظ على الطرق الحالية في مهمة التحرير. فهو يحقق استمرارية قوية للحدود والحفاظ على الهوية بدرجة عالية، مما يدل على قدرته على الحفاظ على التناسق الزمني والبصري أثناء التحرير. بالإضافة إلى ذلك، تعكس دقة مزامنة الشفاه الفائقة وانخفاض قيمة FVD واقعية الفيديو المُصنّع.

انقر للعب. النتائج التي جمعها هذا المؤلف من مقاطع الفيديو المنشورة على موقع المشروع الداعم. يرجى الرجوع إلى الموقع الأصلي للحصول على دقة أفضل.

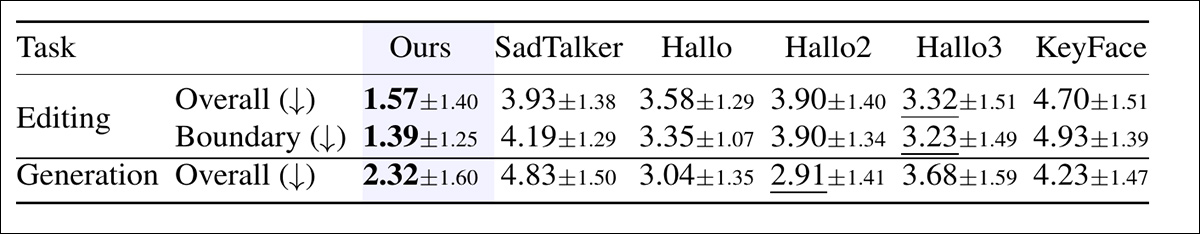

علاوة على ذلك، تم إجراء دراسة بشرية لتقييم الجودة المتصورة في كل من التحرير والإنتاج.

في كل مقارنة، شاهد المشاركون ستة مقاطع فيديو وقاموا بترتيبها حسب الجودة الإجمالية، مع مراعاة دقة مزامنة حركة الشفاه، والطبيعية، وواقعية حركة الرأس. وفي تجارب التحرير، قيّم المشاركون أيضًا سلاسة الانتقالات بين المقاطع المُحرَّرة وغير المُحرَّرة.

متوسط التقييمات التي منحها مقيّمون بشريون، حيث يشير الرقم الأقل إلى جودة أفضل. في كلٍ من التحرير والإنتاج، قيّم المشاركون مدى طبيعية وتناسق كل فيديو. بالنسبة للتحرير، قيّموا أيضًا مدى سلاسة الانتقال بين الكلام المحرر وغير المحرر. تشير الأرقام المكتوبة بخط غامق والمسطرة إلى أعلى درجتين.

في الدراسة، احتل برنامج FacEDiT المرتبة الأولى باستمرار بفارق واضح، وذلك من حيث جودة التحرير وسلاسة الانتقال، كما حصل على درجات قوية في إعداد التوليد، مما يشير إلى أن مزاياه المقاسة تترجم إلى مخرجات مفضلة إدراكياً.

نظراً لضيق المساحة، نحيل القارئ إلى الورقة البحثية الأصلية للاطلاع على مزيد من التفاصيل حول دراسات الاستئصال، والاختبارات الإضافية التي أُجريت ووُثِّقت في هذا العمل الجديد. في الواقع، غالباً ما تُعاني الأبحاث النموذجية من هذا النوع من صعوبة في تضمين أقسام نتائج اختبارات ذات مغزى، لأنّ البحث الأساسي نفسه يُشكّل بالضرورة أساساً محتملاً للأبحاث اللاحقة.

الخاتمة

حتى في مرحلة الاستدلال، قد تتطلب أنظمة كهذه موارد حاسوبية كبيرة أثناء الاستدلال، مما يُصعّب على المستخدمين النهائيين - هنا، على الأرجح، شركات المؤثرات البصرية - الاحتفاظ بالعمل داخل مقراتهم. لذلك، ستُفضّل الشركات دائمًا الأساليب التي يُمكن تكييفها مع الموارد المحلية الواقعية، فهي مُلزمة قانونًا بحماية لقطات العميل وحقوق الملكية الفكرية العامة.

لا يعني ذلك انتقاد العرض الجديد، الذي قد يعمل بشكل مثالي في ظل الأوزان الكمية أو التحسينات الأخرى، وهو أول عرض من نوعه يجذبني للعودة إلى هذا المجال البحثي منذ فترة طويلة.

نُشر لأول مرة يوم الأربعاء 17 ديسمبر 202. تم التحرير في الساعة 20:10 بتوقيت شرق أوروبا، في نفس اليوم، لإضافة مساحة إضافية في الفقرة الأولى من النص.