الذكاء الاصطناعي

GOTCHA- نظام CAPTCHA لتزييف عميق مباشر

يضيف بحث جديد من جامعة نيويورك إلى المؤشرات المتزايدة على أننا قد نضطر قريبًا إلى الخضوع لما يعادل "اختبار السكر" من أجل التحقق من هويتنا، قبل بدء مكالمة فيديو حساسة - مثل مؤتمر فيديو متعلق بالعمل، أو أي سيناريو حساس آخر قد يجذب المحتالين باستخدام التزييف العميق في الوقت الحقيقي برامج التدفق.

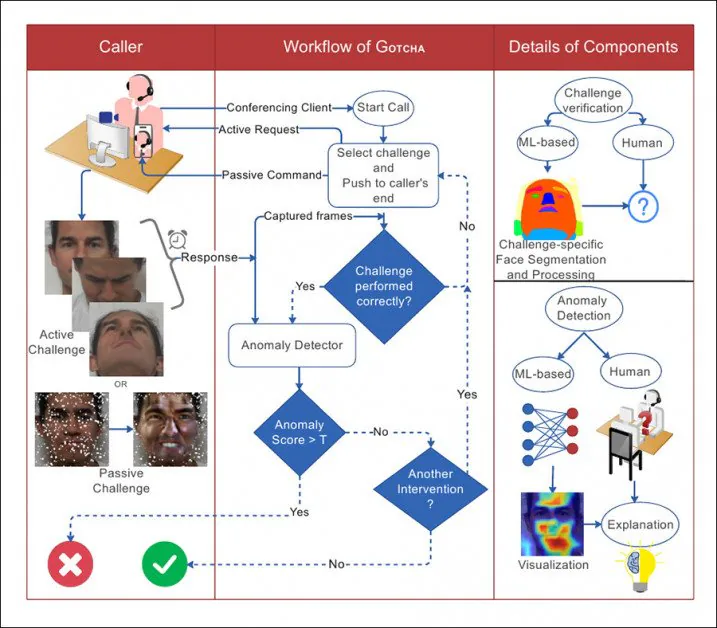

بعض التحديات النشطة والسلبية المُطبقة على سيناريوهات مكالمات الفيديو في GOTCHA. يجب على المستخدم الامتثال للتحديات واجتيازها، بينما تُستخدم أساليب "سلبية" إضافية (مثل محاولة زيادة تحميل نظام التزييف العميق المُحتمل) لا يملك المشارك أي تأثير عليها. المصدر: http://export.arxiv.org/pdf/2210.06186

يُطلق على النظام المقترح اسم GOTCHA - تكريمًا لأنظمة CAPTCHA التي أصبحت عقبة متزايدة أمام تصفح الويب على مدى السنوات العشر إلى الخمس عشرة الماضية ، حيث تتطلب الأنظمة الآلية من المستخدم أداء المهام التي لا تقوم بها الآلات ، مثل تحديد الحيوانات أو فك رموز النص المشوه (والمفارقة ، هذه التحديات غالبًا ما يتحول المستخدم في AMTالمعلق على غرار الاستعانة بمصادر خارجية).

في الأساس ، تمدد GOTCHA في أغسطس 2022 DF- كابتشا ورقة بحثية من جامعة بن غوريون ، والتي كانت أول من اقترح جعل الشخص في الطرف الآخر من المكالمة يقفز من خلال بعض الأطواق الدلالية بصريًا لإثبات صحتها.

اقترحت الورقة البحثية الصادرة في أغسطس 2022 من جامعة بن غوريون لأول مرة مجموعة من الاختبارات التفاعلية للمستخدم ، بما في ذلك تغطية الوجه ، أو حتى الضغط على بشرته - وهي مهام ربما لم تتوقعها أنظمة التزييف العميق الحية المدربة جيدًا أو لم تكن قادرة على التعامل معها بشكل واقعي. . المصدر: https://arxiv.org/pdf/2208.08524.pdf

يُذكر أن GOTCHA يضيف منهجيات "سلبية" إلى سلسلة من الاختبارات المقترحة، بما في ذلك التراكب التلقائي لعناصر وهمية على وجه المستخدم، و"التحميل الزائد" للإطارات التي تمر عبر النظام المصدر. مع ذلك، لا يمكن تقييم سوى المهام المستجيبة للمستخدم دون أذونات خاصة للوصول إلى نظامه المحلي - والذي يُفترض أن يأتي على شكل وحدات أو إضافات محلية لأنظمة شائعة مثل Skype وZoom، أو حتى على شكل برامج خاصة مخصصة مُخصصة للكشف عن المُزيفين.

من الورقة ، توضيح للتفاعل بين المتصل والنظام في GOTCHA ، مع خطوط منقطة مع تدفق القرار.

تحقق الباحثون من صحة النظام باستخدام مجموعة بيانات جديدة تحتوي على أكثر من 2.5 مليون إطار فيديو من 47 مشاركًا، خاض كل منهم 13 تحديًا من برنامج GOTCHA. ويزعمون أن هذا الإطار يُحدث انخفاضًا "مستمرًا وقابلًا للقياس" في جودة محتوى التزييف العميق للمستخدمين المُحتالين، مما يُرهق النظام المحلي حتى تظهر آثار واضحة تُوضح الخداع للعين المجردة (مع أن برنامج GOTCHA يتضمن أيضًا بعض أساليب التحليل الخوارزمي الأكثر دقة).

أكثر من ورقة جديدة بعنوان مسكتك: نظام الاستجابة للتحدي لاكتشاف التزييف العميق في الوقت الحقيقي (اسم النظام مكتوب بحرف كبير في النص ولكن ليس في عنوان المنشور، على الرغم من أنه ليس اختصارًا).

مجموعة من التحديات

وفقًا لورقة بن غوريون ، يتم تقسيم التحديات الفعلية التي تواجه المستخدم إلى عدة أنواع من المهام.

في حالة إنسدادفي هذه التقنية، يُطلب من المستخدم إما إخفاء وجهه بيده، أو بأشياء أخرى، أو تقديم وجهه بزاوية من غير المرجح أن يتم تدريبه عليها في نموذج مزيف عميق (عادةً بسبب نقص بيانات التدريب للوضعيات "الغريبة" - انظر مجموعة الصور في الرسم التوضيحي الأول أعلاه).

إلى جانب الإجراءات التي قد يقوم بها المستخدم بنفسه وفقًا للتعليمات، يمكن لـ GOTCHA إضافة مقاطع وجه عشوائية وملصقات وفلاتر واقع معزز، بهدف "إفساد" تدفق الوجوه الذي قد يتوقعه نموذج التزييف العميق المحلي المُدرَّب، مما يؤدي إلى فشله. وكما ذُكر سابقًا، مع أن هذه العملية "سلبية" بالنسبة للمستخدم، إلا أنها عملية تدخلية بالنسبة للبرنامج، الذي يجب أن يكون قادرًا على التدخل مباشرةً في تدفق بيانات الطرف الآخر.

بعد ذلك، قد يُطلب من المستخدم وضع وجهه في تعبيرات وجهية غير عادية من المرجح أن تكون غائبة أو غير ممثلة بشكل كافٍ في أي مجموعة بيانات تدريبية، مما يتسبب في انخفاض جودة الناتج المزيف (الصورة "ب"، العمود الثاني من اليسار، في الرسم التوضيحي الأول أعلاه).

كجزء من سلسلة الاختبارات هذه ، قد يُطلب من المستخدم قراءة نص أو إجراء محادثة مصممة لتحدي نظام التزييف العميق المحلي ، والذي قد لا يكون قد درب مجموعة كافية من الصوتيات أو أنواع أخرى من بيانات الفم إلى مستوى حيث يمكن إعادة بناء حركة الشفاه بدقة تحت هذا الفحص.

أخيرًا (وهذا يبدو تحديًا لمواهب التمثيل لدى المراسل النهائي)، في هذه الفئة، قد يُطلب من المستخدم أداء تعبير دقيق - تعبير وجهي قصير لا إرادي يُخفي عاطفة. وعن هذا، تقول الورقة البحثية "يستمر عادةً لمدة 0.5-4.0 ثانية، ومن الصعب تزييفه".

ورغم أن الورقة البحثية لا تصف كيفية استخراج تعبير مجهري، فإن المنطق يشير إلى أن الطريقة الوحيدة للقيام بذلك هي خلق عاطفة مناسبة لدى المستخدم النهائي، ربما من خلال تقديم نوع من المحتوى المذهل له كجزء من روتين الاختبار.

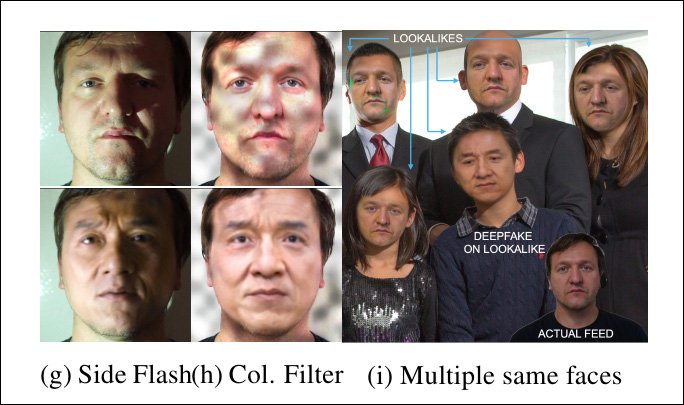

تشويه الوجه والإضاءة و ضيوف غير متوقعين

بالإضافة إلى ذلك، تمشيا مع الاقتراحات الواردة في ورقة أغسطس، يقترح العمل الجديد مطالبة المستخدم النهائي بإجراء تشوهات وتلاعبات غير عادية في الوجه، مثل الضغط بإصبعه على خده، والتفاعل مع وجهه و/أو شعره، وأداء حركات أخرى من غير المرجح أن يكون أي نظام Deepfake حي حالي قادرًا على التعامل معها بشكل جيد، نظرًا لأن هذه إجراءات هامشية - حتى لو كانت موجودة في مجموعة بيانات التدريب، فمن المرجح أن تكون إعادة إنتاجها ذات جودة منخفضة، بما يتماشى مع بيانات "القيم الشاذة" الأخرى.

ابتسامة، لكن هذا "الوجه المكتئب" لا يتم ترجمته بشكل جيد بواسطة نظام التزييف المباشر المحلي.

ويتمثل التحدي الإضافي في تغيير ظروف الإضاءة التي يتواجد فيها المستخدم النهائي، حيث من الممكن أن يكون تدريب نموذج Deepfake قد تم تحسينه لمواقف الإضاءة القياسية لمؤتمرات الفيديو، أو حتى ظروف الإضاءة الدقيقة التي تتم فيها المكالمة.

وبالتالي قد يُطلب من المستخدم أن يضيء المصباح على هاتفه المحمول على وجهه ، أو بطريقة أخرى يغير الإضاءة (وتجدر الإشارة إلى أن هذا المسار هو الاقتراح المركزي لـ ورقة أخرى للكشف عن التزييف العميق التي خرجت هذا الصيف).

تواجه أنظمة التزييف العميق المباشر تحديات بسبب الإضاءة غير المتوقعة - وحتى من قِبل العديد من الأشخاص في البث ، حيث كانت تتوقع شخصًا واحدًا فقط.

في حالة قدرة النظام المقترح على التدخل في مجرى المستخدم المحلي (والذي يُشتبه في أنه يؤوي وسيطًا مزيفًا عميقًا)، فإن إضافة أنماط غير متوقعة (انظر العمود الأوسط في الصورة أعلاه) يمكن أن تؤثر سلبًا على قدرة خوارزمية التزييف العميق على الحفاظ على المحاكاة.

بالإضافة إلى ذلك، على الرغم من أنه من غير المعقول أن نتوقع من المراسل أن يكون لديه أشخاص إضافيون في متناول اليد لمساعدته في التحقق من صحتهم، يمكن للنظام إدخال وجوه إضافية (الصورة في أقصى اليمين أعلاه)، ومعرفة ما إذا كان أي نظام تزييف عميق محلي يرتكب خطأ تحويل الانتباه - أو حتى محاولة تزييفهم جميعًا (لا تحتوي أنظمة التزييف العميق ذات التشفير التلقائي على قدرات "التعرف على الهوية" التي يمكن أن تبقي الانتباه مركّزًا على فرد واحد في هذا السيناريو).

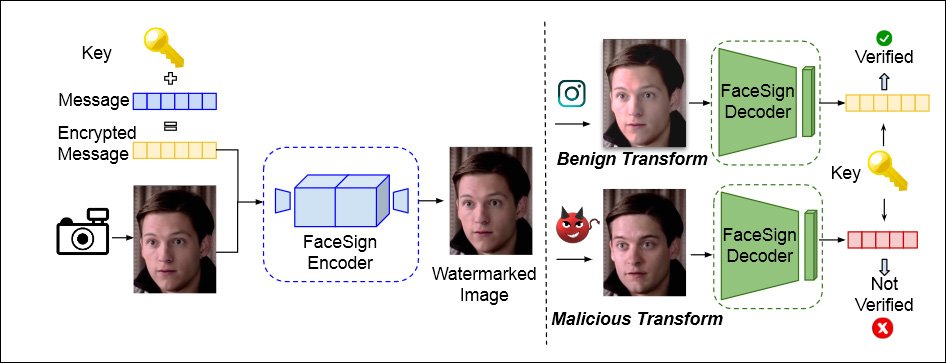

إخفاء المعلومات والحمل الزائد

يدمج GOTCHA أيضًا نهجًا اقترح لأول مرة أُنشئت هذه التقنية من قِبل جامعة كاليفورنيا في سان دييغو في أبريل من هذا العام، وتستخدم تقنية التخفي لتشفير رسالة في بث فيديو محلي للمستخدم. ستؤدي إجراءات التزييف العميق إلى تدمير هذه الرسالة تمامًا، مما يؤدي إلى فشل المصادقة.

من ورقة بحثية صدرت في أبريل 2022 من جامعة كاليفورنيا في سان دييغو وجامعة ولاية سان دييغو، هناك طريقة لتحديد الهوية الحقيقية من خلال معرفة ما إذا كانت الإشارة الخفية المرسلة إلى تيار فيديو المستخدم تنجو من الحلقة المحلية سليمة - إذا لم يحدث ذلك، فقد يكون الغش العميق وشيكًا. المصدر: https://arxiv.org/pdf/2204.01960.pdf

بالإضافة إلى ذلك، فإن GOTCHA قادر على زيادة تحميل النظام المحلي (مع توفير الوصول والإذن)، عن طريق تكرار تدفق وتقديم بيانات "زائدة" إلى أي نظام محلي، وهو مصمم للتسبب في فشل التكرار في نظام deepfake محلي.

يحتوي النظام على مزيد من الاختبارات (انظر الورقة للحصول على التفاصيل) ، بما في ذلك التحدي ، في حالة المراسل عبر الهاتف الذكي ، لقلب هاتفه رأسًا على عقب ، مما يؤدي إلى تشويه نظام التزييف العميق المحلي:

مرة أخرى، هذا النوع من الأشياء لن يعمل إلا مع حالة استخدام مقنعة، حيث يضطر المستخدم إلى منح حق الوصول المحلي إلى البث، ولا يمكن تنفيذه من خلال التقييم السلبي البسيط لفيديو المستخدم، على عكس الاختبارات التفاعلية (مثل الضغط بإصبع على وجه الشخص).

التطبيق العملي

تتطرق الورقة بإيجاز إلى المدى الذي يمكن أن تزعج فيه الاختبارات من هذا النوع المستخدم النهائي ، أو تزعجه بطريقة ما - على سبيل المثال ، من خلال إلزام المستخدم بوجود عدد من العناصر التي قد تكون مطلوبة للاختبارات ، مثل النظارات الشمسية.

كما تقر بأنه قد يكون من الصعب إقناع مراسلين أقوياء بالامتثال لإجراءات الاختبار الروتينية. فيما يتعلق بحالة مكالمة فيديو مع رئيس تنفيذي ، ذكر المؤلفان:

قد تكون سهولة الاستخدام عاملاً أساسياً هنا، لذا قد لا تكون التحديات غير الرسمية أو التافهة (مثل تشوهات الوجه أو تعابير الوجه) مناسبة. قد لا تكون التحديات التي تستخدم أدوات مادية خارجية مرغوبة. تم تعديل السياق هنا بشكل مناسب، ويُكيّف GOTCHA مجموعة تحدياته وفقًا لذلك.

البيانات والاختبارات

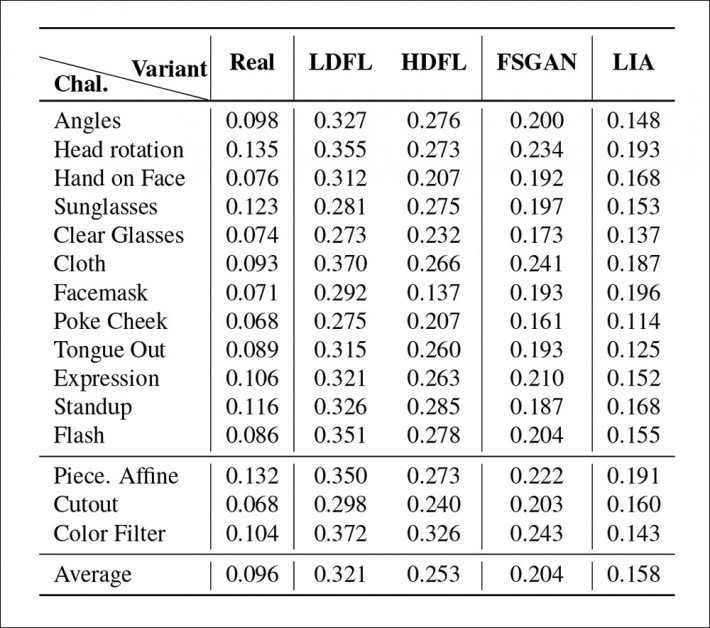

تم اختبار GOTCHA مقابل أربع سلالات من نظام التزييف العميق المباشر المحلي، بما في ذلك نوعان مختلفان من منشئ التزييف العميق ذو التشفير التلقائي الشهير جدًا ديب فيس لاب (على الرغم من ذلك، ومن المثير للدهشة، أن الصحيفة لم تذكر "DFL"). ديب فيس لايف، الذي كان، منذ أغسطس 2021، وهو تنفيذ "مباشر" لـ DeepFaceLab، ويبدو أنه المصدر الأولي الأكثر احتمالاً للمزور المحتمل).

تم تدريب الأنظمة الأربعة باستخدام DFL بشكل "خفيف" على شخص غير مشهور يشارك في الاختبارات، وشخصية مشهورة مقترنة؛ وتم تدريب DFL بشكل أكثر اكتمالاً، لأكثر من 2 مليون تكرار أو خطوة، حيث يتوقع المرء نموذجًا أكثر أداءً؛ مؤثر للصور الكامنة (LIA) ؛ و شبكة الخصومة التوليدية لمبادلة الوجه (FSGAN).

بالنسبة للبيانات ، قام الباحثون بالتقاط وتنظيم مقاطع الفيديو المذكورة أعلاه ، والتي تضم 47 مستخدمًا يؤدون 13 تحديًا نشطًا ، مع إخراج كل مستخدم حوالي 5-6 دقائق من فيديو 1080 بكسل بمعدل 60 إطارًا في الثانية. يذكر المؤلفون أيضًا أن هذه البيانات سيتم نشرها علنًا في النهاية.

يمكن إجراء اكتشاف الشذوذ إما بواسطة مراقب بشري أو باستخدام الخوارزميات. بالنسبة للخيار الأخير ، تم تدريب النظام على 600 وجه من مجموعة بيانات FaceForensics. كانت وظيفة فقدان الانحدار هي تشابه تصحيح الصورة الإدراكية المتعلم القوي (LPIPS) ، بينما تم استخدام الانتروبيا الثنائية لتدريب المصنف. إيجينكام تم استخدامه لتوضيح أوزان الكاشف.

النتائج الأولية من اختبارات GOTCHA.

وجد الباحثون أنه بالنسبة للتسلسل الكامل للاختبارات عبر الأنظمة الأربعة ، تم الحصول على أقل عدد وشدة من الحالات الشاذة (أي القطع الأثرية التي من شأنها أن تكشف عن وجود نظام التزييف العميق) من خلال توزيع DFL عالي التدريب. كافحت النسخة الأقل تدريبًا على وجه الخصوص لإعادة إنشاء حركات الشفاه المعقدة (التي تشغل القليل جدًا من الإطار ، ولكنها تحظى باهتمام بشري كبير) ، بينما احتلت FSGAN الوسط بين نسختين من DFL ، وأثبت LIA أنه غير مناسب تمامًا للمهمة ، مع رأي الباحثين أن LIA ستفشل في نشر حقيقي.

نُشر لأول مرة في 17 أكتوبر 2022.