人工智能

RigNeRF:一种使用神经辐射场的新 Deepfakes 方法

Adobe 开发的新研究提供了第一个可行且有效的 Deepfakes 方法,该方法基于 神经辐射场 (NeRF)——也许是自 2017 年 Deepfakes 出现以来五年来在架构或方法方面的首次真正创新。

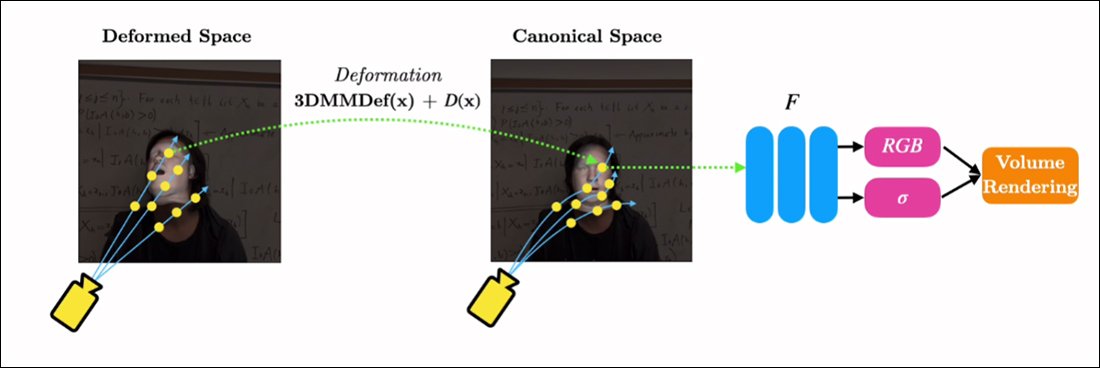

该方法的标题为 RigNeRF,用途 3D 可变形脸部模型 (3DMM)作为所需输入(即要强加到 NeRF 渲染中的身份)和神经空间之间的工具间隙层,这种方法已被 近年来被广泛采用 通过生成对抗网络(GAN)人脸合成方法,这些方法还没有为视频产生功能性和有用的人脸替换框架。

与传统的深度伪造视频不同,这里拍摄的移动内容绝对不是“真实的”,而是一个经过简短镜头训练的可探索的神经空间。 在右侧,我们看到 3D 变形人脸模型 (3DMM) 充当所需操作(“微笑”、“向左看”、“向上看”等)和神经辐射场的通常难以处理的参数之间的接口可视化。 有关此剪辑的高分辨率版本以及其他示例,请参阅 项目页,或本文末尾的嵌入式视频。 来源:https://shahrukhathar.github.io/2022/06/06/RigNeRF.html

3DMM 是有效的面部 CGI 模型,其参数可以适应更抽象的图像合成系统,例如 NeRF 和 GAN,否则这些系统很难控制。

您在上图中(中图,穿蓝色衬衫的男人)以及正下方的图像(左图,穿蓝色衬衫的男人)看到的内容不是“真实”视频,其中有一小部分“假脸已被叠加,但完全合成的场景仅作为体积神经渲染存在 - 包括身体和背景:

在上面的例子中,右侧的真实视频(穿红裙子的女人)被用来通过 RigNeRF“操纵”左侧捕获的身份(穿蓝色衬衫的男人),这是第一个(作者声称)基于 NeRF 的系统可实现姿势和表情的分离,同时能够执行新颖的视图合成。

上图中左侧的男性人物是从一段 70 秒的智能手机视频中“捕获”的,输入数据(包括整个场景信息)随后在 4 个 V100 GPU 上进行训练以获得场景。

由于 3DMM 式参数化装置也可用作 全身参数化 CGI 代理 (而不仅仅是面部装备),RigNeRF 潜在地开辟了全身深度伪造的可能性,其中真实的人体运动、纹理和表情被传递到基于 CGI 的参数层,然后该参数层会将动作和表情转换为渲染的 NeRF 环境和视频。

至于 RigNeRF——从目前头条新闻对这个术语的理解来看,它是否符合深度伪造方法的资格? 或者它只是 DeepFaceLab 和其他劳动密集型 2017 时代自动编码器 Deepfake 系统的另一个半跛脚失败者?

新论文的研究人员在这一点上毫不含糊:

“作为一种能够使人脸复活的方法,RigNeRF 很容易被不良行为者滥用来生成深度赝品。”

新的 纸 标题为 RigNeRF:完全可控的神经 3D 肖像,来自 Stonybrook 大学的 ShahRukh Atha(RigNeRF 开发期间在 Adobe 实习),以及 Adobe Research 的其他四位作者。

超越基于自动编码器的 Deepfakes

过去几年占据头条新闻的大多数病毒式深度假货都是由 自动编码器基于 的系统,源自于 2017 年在被立即禁止的 r/deepfakes Reddit 子版块上发布的代码——尽管不是在被禁止之前 复制过来 到 GitHub,目前已分叉 超过一千次,尤其是流行(如果 争议) 深度人脸实验室 分布,还有 换脸 项目。

除了 GAN 和 NeRF 之外,自动编码器框架还尝试使用 3DMM 作为改进面部合成框架的“指南”。 这方面的一个例子是 HifiFace项目 从 2021 年 XNUMX 月开始。然而,迄今为止,这种方法似乎还没有开发出可用或受欢迎的举措。

RigNeRF 场景的数据是通过捕捉智能手机短视频获得的。 在该项目中,RigNeRF 的研究人员使用 iPhone XR 或 iPhone 12 进行所有实验。 在拍摄的前半部分,拍摄对象被要求做出各种面部表情和言语,同时在相机在他们周围移动时保持头部静止。

在拍摄的后半部分,相机保持固定位置,而拍摄对象必须转动头部,同时表现出各种表情。 生成的 40-70 秒的镜头(大约 1200-2100 帧)代表将用于训练模型的整个数据集。

减少数据收集

相比之下,像 DeepFaceLab 这样的自动编码器系统需要相对费力地收集和整理数千张不同的照片,这些照片通常取自 YouTube 视频和其他社交媒体渠道,以及电影(在名人深度假货的情况下)。

由此产生的经过训练的自动编码器模型通常旨在用于各种情况。 然而,最挑剔的“名人”深度造假者可能会为一个视频从头开始训练整个模型,尽管训练可能需要一周或更长时间。

尽管新论文的研究人员发出了警告,但为 AI 色情以及流行的 YouTube/TikTok“深度伪造重铸”提供支持的“拼凑”和广泛组装的数据集似乎不太可能在 RigNeRF 等深度伪造系统中产生可接受且一致的结果,它具有特定于场景的方法。 考虑到新工作中概述的数据捕获限制,这在某种程度上可能证明是防止恶意深度造假者随意盗用身份的额外保障。

将 NeRF 应用于 Deepfake 视频

NeRF 是一种基于摄影测量的方法,将从不同视点拍摄的少量源图片组合成可探索的 3D 神经空间。 今年早些时候,当 NVIDIA 推出其 即时神经射频 系统,能够将 NeRF 的过高训练时间缩短至几分钟,甚至几秒:

即时 NeRF。 来源:https://www.youtube.com/watch?v=DJ2hcC1orc4

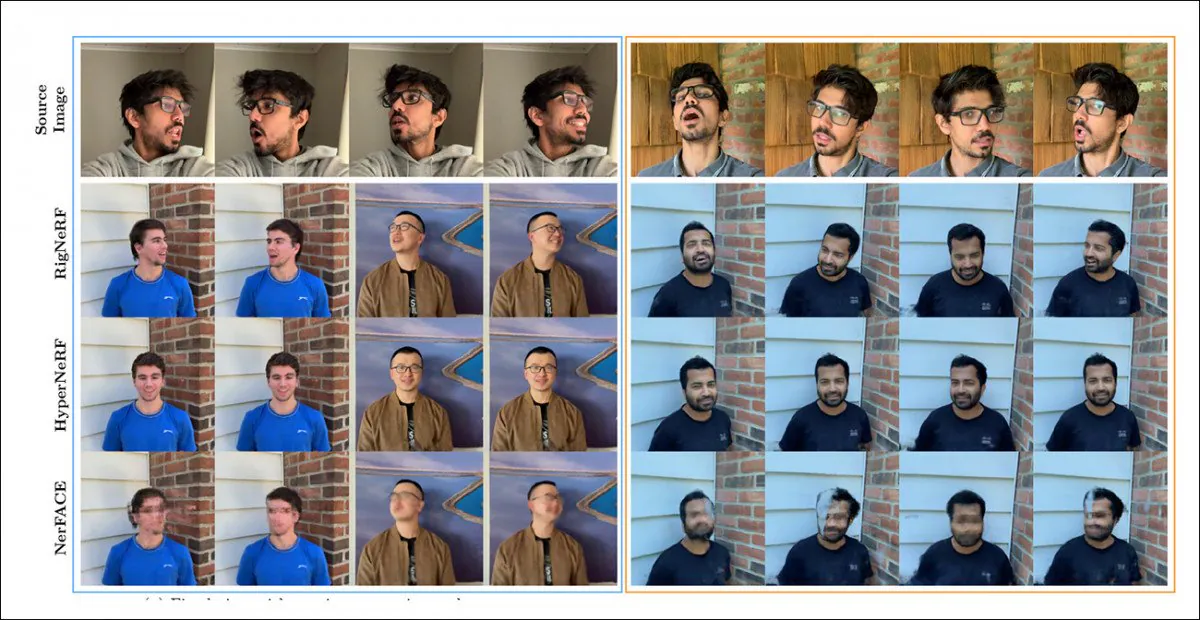

由此产生的神经辐射场场景本质上是一个可以探索的静态环境,但它是 难以编辑。 研究人员指出,之前的两项基于 NeRF 的举措 – HyperNeRF + E/P 和 纳菲斯 – 尝试了面部视频合成,并且(显然是为了完整性和勤勉性)在一轮测试中针对这两个框架设置了 RigNeRF:

RigNeRF、HyperNeRF 和 NerFACE 之间的定性比较。 请参阅链接的源视频和 PDF 以获取更高质量的版本。 静态图来源:https://arxiv.org/pdf/2012.03065.pdf

然而,在这种情况下,有利于 RigNeRF 的结果相当反常,原因有两个:首先,作者观察到“没有现有的工作可以进行苹果与苹果的比较”; 其次,这需要限制 RigNeRF 的功能,以至少部分匹配先前系统的更受限制的功能。

由于结果并不是对先前工作的增量改进,而是代表了 NeRF 可编辑性和实用性的“突破”,因此我们将把测试放在一边,而是看看 RigNeRF 与之前的版本相比有何不同。

综合优势

NerFACE 可以在 NeRF 环境中创建姿势/表情控制,其主要限制是它假设源镜头将使用静态摄像机捕获。 这实际上意味着它无法产生超出其捕获限制的新颖视图。 这产生了一个可以创建“移动肖像”的系统,但不适合深度伪造风格的视频。

另一方面,HyperNeRF 虽然能够生成新颖且超真实的视图,但没有允许其改变头部姿势或面部表情的工具,这也不会导致基于自动编码器的深度伪造品的任何竞争对手。

RigNeRF 能够通过创建“规范空间”来组合这两个独立的功能,这是一个默认基线,可以通过 3DMM 模块的输入来执行偏差和变形。

创建一个“规范空间”(无姿势,无表情),通过 3DMM 产生的变形(即姿势和表情)可以在该空间上起作用。

由于 3DMM 系统不会与捕获的主体完全匹配,因此在此过程中对此进行补偿非常重要。 RigNeRF 通过先验变形场来实现这一点,该变形场是根据 多层感知器 (MLP)源自源素材。

计算变形所需的相机参数通过以下方式获得 科尔图,而每帧的表情和形状参数是从 德卡.

定位进一步优化 地标拟合 和 COLMAP 的相机参数,并且由于计算资源限制,视频输出被下采样到 256×256 分辨率进行训练(硬件约束的收缩过程也困扰着自动编码器 Deepfake 场景)。

此后,变形网络在四台 V100 上进行训练——这些强大的硬件不太可能是业余爱好者所能承受的(但是,就机器学习训练而言,通常可以用重量换取时间,并简单地接受该模型)培训将需要几天甚至几周的时间)。

总之,研究人员指出:

“与其他方法相比,RigNeRF 由于使用了 3DMM 引导变形模块,能够以高保真度对头部姿势、面部表情和完整 3D 肖像场景进行建模,从而提供具有清晰细节的更好重建。”

请参阅下面的嵌入视频了解更多详细信息和结果片段。

首次发布于 15 年 2022 月 XNUMX 日。