Trí tuệ nhân tạo

AI đa phương thức phát triển khi ChatGPT có được tầm nhìn với GPT-4V(ision)

Trong nỗ lực không ngừng nhằm làm cho AI giống con người hơn, các mô hình GPT của OpenAI đã liên tục vượt qua các ranh giới. GPT-4 hiện có thể chấp nhận lời nhắc của cả văn bản và hình ảnh.

Tính đa phương thức trong AI tổng quát biểu thị khả năng của mô hình trong việc tạo ra các kết quả đầu ra khác nhau như văn bản, hình ảnh hoặc âm thanh dựa trên đầu vào. Những mô hình này, được đào tạo về dữ liệu cụ thể, tìm hiểu các mẫu cơ bản để tạo ra dữ liệu mới tương tự, làm phong phú thêm các ứng dụng AI.

Những bước tiến gần đây trong AI đa phương thức

Một bước nhảy vọt đáng chú ý gần đây trong lĩnh vực này được thể hiện qua việc tích hợp DALL-E 3 vào ChatGPT, một bản nâng cấp đáng kể trong công nghệ chuyển văn bản thành hình ảnh của OpenAI. Sự kết hợp này cho phép tương tác mượt mà hơn trong đó ChatGPT hỗ trợ tạo ra các lời nhắc chính xác cho DALL-E 3, biến ý tưởng của người dùng thành tác phẩm nghệ thuật sống động do AI tạo ra. Vì vậy, mặc dù người dùng có thể tương tác trực tiếp với DALL-E 3, nhưng việc kết hợp ChatGPT giúp quá trình tạo tác phẩm nghệ thuật AI thân thiện hơn nhiều với người dùng.

Tìm hiểu thêm về DALL-E 3 và sự tích hợp của nó với ChatGPT tại đây. Sự hợp tác này không chỉ cho thấy sự tiến bộ của AI đa phương thức mà còn giúp người dùng dễ dàng sáng tạo nghệ thuật bằng AI.

Mặt khác, sức khỏe của Google được giới thiệu Med-PaLM M vào tháng 1 năm nay. Nó là một mô hình sinh học đa phương thức có khả năng mã hóa và diễn giải dữ liệu y sinh đa dạng. Điều này đạt được bằng cách tinh chỉnh PaLM-E, một mô hình ngôn ngữ, để phục vụ các lĩnh vực y tế bằng cách sử dụng điểm chuẩn nguồn mở MultiMedBench. Điểm chuẩn này bao gồm hơn 7 triệu mẫu trên 14 loại dữ liệu y sinh và XNUMX nhiệm vụ như trả lời câu hỏi y tế và tạo báo cáo X quang.

Nhiều ngành công nghiệp khác nhau đang áp dụng các công cụ AI đa phương thức cải tiến để thúc đẩy mở rộng kinh doanh, hợp lý hóa hoạt động và nâng cao mức độ tương tác của khách hàng. Sự tiến bộ về khả năng AI thoại, video và văn bản đang thúc đẩy sự phát triển của AI đa phương thức.

Các doanh nghiệp tìm kiếm các ứng dụng AI đa phương thức có khả năng cải tổ các mô hình và quy trình kinh doanh, mở ra con đường tăng trưởng trên toàn hệ sinh thái AI tổng quát, từ các công cụ dữ liệu đến các ứng dụng AI mới nổi.

Sau khi GPT-4 ra mắt vào tháng XNUMX, một số người dùng đã nhận thấy chất lượng phản hồi của nó giảm dần theo thời gian, mối lo ngại này được lặp lại bởi các nhà phát triển đáng chú ý và trên các diễn đàn của OpenAI. Ban đầu bị OpenAI loại bỏ, sau đó nghiên cứu đã xác nhận vấn đề. Nó cho thấy độ chính xác của GPT-4 đã giảm từ 97.6% xuống 2.4% trong khoảng thời gian từ tháng XNUMX đến tháng XNUMX, cho thấy chất lượng câu trả lời đã giảm sút với các bản cập nhật mẫu tiếp theo.

Sự cường điệu xung quanh Mở AI ChatGPT đã trở lại. Bây giờ nó đi kèm với một tính năng tầm nhìn GPT-4V, cho phép người dùng có GPT-4 phân tích hình ảnh do họ cung cấp. Đây là tính năng mới nhất được mở ra cho người dùng.

Việc thêm phân tích hình ảnh vào các mô hình ngôn ngữ lớn (LLM) như GPT-4 được một số người coi là một bước tiến lớn trong nghiên cứu và phát triển AI. Loại LLM đa phương thức này mở ra những khả năng mới, đưa các mô hình ngôn ngữ vượt ra ngoài văn bản để cung cấp các giao diện mới và giải quyết các loại nhiệm vụ mới, tạo ra những trải nghiệm mới mẻ cho người dùng.

Quá trình đào tạo GPT-4V đã kết thúc vào năm 2022 và quyền truy cập sớm được triển khai vào tháng 2023 năm 4. Tính năng hình ảnh trong GPT-4V được hỗ trợ bởi công nghệ GPT-XNUMX. Quá trình đào tạo vẫn như cũ. Ban đầu, mô hình được đào tạo để dự đoán từ tiếp theo trong văn bản bằng cách sử dụng tập dữ liệu khổng lồ gồm cả văn bản và hình ảnh từ nhiều nguồn khác nhau, bao gồm cả internet.

Sau đó, nó được tinh chỉnh với nhiều dữ liệu hơn, sử dụng một phương pháp có tên là học tăng cường từ phản hồi của con người (RLHF), để tạo ra kết quả đầu ra mà con người ưa thích.

Cơ chế thị giác GPT-4

Khả năng ngôn ngữ hình ảnh đáng chú ý của GPT-4, mặc dù rất ấn tượng nhưng vẫn có những phương pháp cơ bản vẫn còn ẩn giấu.

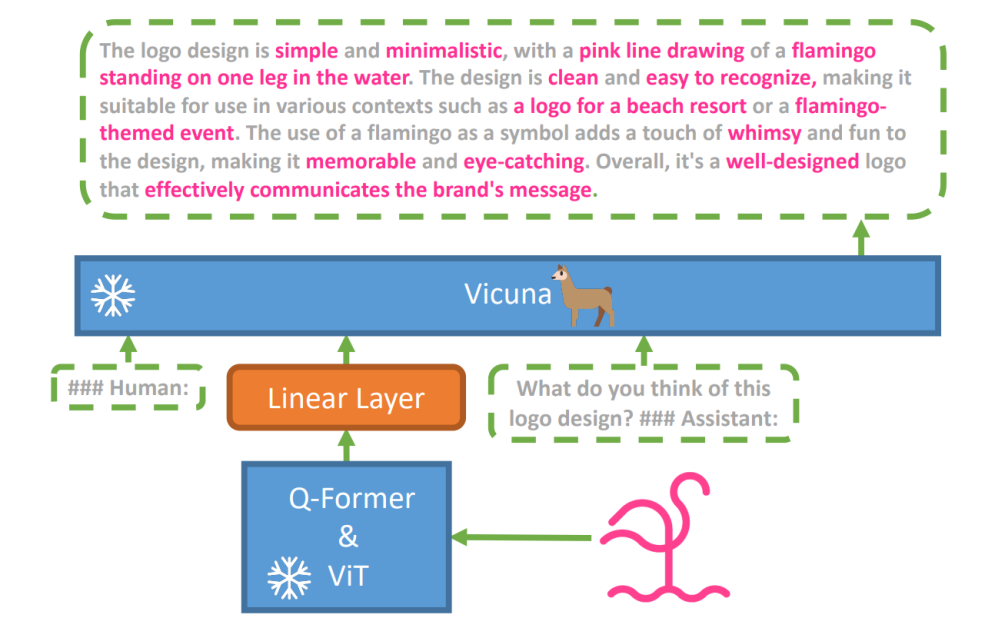

Để khám phá giả thuyết này, một mô hình ngôn ngữ tầm nhìn mới, miniGPT-4 đã được giới thiệu, sử dụng LLM nâng cao có tên Vicuna. Mô hình này sử dụng bộ mã hóa tầm nhìn với các thành phần được đào tạo trước để nhận thức thị giác, căn chỉnh các đặc điểm hình ảnh được mã hóa với mô hình ngôn ngữ Vicuna thông qua một lớp chiếu duy nhất. Kiến trúc của MiniGPT-4 đơn giản nhưng hiệu quả, tập trung vào việc sắp xếp các tính năng hình ảnh và ngôn ngữ để cải thiện khả năng hội thoại bằng hình ảnh.

Kiến trúc của MiniGPT-4 bao gồm bộ mã hóa tầm nhìn với ViT và Q-Former được đào tạo trước, một lớp chiếu tuyến tính duy nhất và mô hình ngôn ngữ lớn Vicuna tiên tiến.

Xu hướng mô hình ngôn ngữ tự hồi quy trong các nhiệm vụ ngôn ngữ thị giác cũng phát triển, tận dụng khả năng chuyển giao đa phương thức để chia sẻ kiến thức giữa các lĩnh vực ngôn ngữ và đa phương thức.

MiniGPT-4 kết nối các miền hình ảnh và ngôn ngữ bằng cách căn chỉnh thông tin hình ảnh từ bộ mã hóa hình ảnh được đào tạo trước với LLM nâng cao. Mô hình sử dụng Vicuna làm bộ giải mã ngôn ngữ và tuân theo phương pháp đào tạo hai giai đoạn. Ban đầu, nó được đào tạo trên một tập dữ liệu lớn gồm các cặp văn bản-hình ảnh để nắm bắt kiến thức về ngôn ngữ hình ảnh, sau đó là tinh chỉnh trên tập dữ liệu nhỏ hơn, chất lượng cao để nâng cao độ tin cậy và khả năng sử dụng của thế hệ.

Để cải thiện tính tự nhiên và khả năng sử dụng của ngôn ngữ được tạo trong MiniGPT-4, các nhà nghiên cứu đã phát triển quy trình căn chỉnh hai giai đoạn, giải quyết tình trạng thiếu bộ dữ liệu căn chỉnh ngôn ngữ thị giác đầy đủ. Họ đã tuyển chọn một bộ dữ liệu chuyên biệt cho mục đích này.

Ban đầu, mô hình tạo ra các mô tả chi tiết về hình ảnh đầu vào, nâng cao chi tiết bằng cách sử dụng lời nhắc đàm thoại phù hợp với định dạng của mô hình ngôn ngữ Vicuna. Giai đoạn này nhằm mục đích tạo ra các mô tả hình ảnh toàn diện hơn.

Lời nhắc mô tả hình ảnh ban đầu:

###Nhân loại: Mô tả chi tiết hình ảnh này. Cung cấp càng nhiều chi tiết càng tốt. Nói tất cả những gì bạn nhìn thấy ###Trợ lý:

Để xử lý hậu kỳ dữ liệu, mọi sự không nhất quán hoặc lỗi trong mô tả được tạo đều được sửa bằng ChatGPT, sau đó là xác minh thủ công để đảm bảo chất lượng cao.

Lời nhắc tinh chỉnh giai đoạn thứ hai:

###Nhân loại: ###Trợ lý:

Cuộc khám phá này mở ra cơ hội hiểu biết cơ chế của AI tạo ra đa phương thức như GPT-4, làm sáng tỏ cách có thể tích hợp hiệu quả các phương thức thị giác và ngôn ngữ để tạo ra kết quả đầu ra mạch lạc và phong phú theo ngữ cảnh.

Khám phá tầm nhìn GPT-4

Xác định nguồn gốc hình ảnh với ChatGPT

GPT-4 Vision nâng cao khả năng phân tích hình ảnh và xác định nguồn gốc địa lý của ChatGPT. Tính năng này chuyển đổi tương tác của người dùng từ chỉ văn bản sang kết hợp văn bản và hình ảnh, trở thành một công cụ hữu ích cho những ai tò mò về các địa điểm khác nhau thông qua dữ liệu hình ảnh.

Khái niệm toán học phức tạp

GPT-4 Vision vượt trội trong việc đi sâu vào các ý tưởng toán học phức tạp bằng cách phân tích các biểu thức đồ họa hoặc viết tay. Tính năng này hoạt động như một công cụ hữu ích cho những cá nhân muốn giải các bài toán phức tạp, đánh dấu GPT-4 Vision là một trợ giúp đáng chú ý trong các lĩnh vực giáo dục và học thuật.

Chuyển đổi đầu vào viết tay thành mã LaTeX

Một trong những khả năng vượt trội của GPT-4V là khả năng dịch các đầu vào viết tay thành mã LaTeX. Tính năng này mang lại lợi ích cho các nhà nghiên cứu, học giả và sinh viên, những người thường xuyên cần chuyển đổi các biểu thức toán học viết tay hoặc thông tin kỹ thuật khác sang định dạng kỹ thuật số. Việc chuyển đổi từ viết tay sang LaTeX mở rộng phạm vi số hóa tài liệu và đơn giản hóa quy trình viết kỹ thuật.

Trích xuất chi tiết bảng

GPT-4V thể hiện kỹ năng trích xuất chi tiết từ bảng và giải quyết các câu hỏi liên quan, một tài sản quan trọng trong phân tích dữ liệu. Người dùng có thể sử dụng GPT-4V để sàng lọc các bảng, thu thập thông tin chi tiết quan trọng và giải quyết các câu hỏi dựa trên dữ liệu, khiến GPT-XNUMXV trở thành công cụ mạnh mẽ cho các nhà phân tích dữ liệu và các chuyên gia khác.

Hiểu cách chỉ thị trực quan

Khả năng độc đáo của GPT-4V trong việc hiểu cách trỏ trực quan sẽ bổ sung thêm một khía cạnh mới cho tương tác của người dùng. Bằng cách hiểu các tín hiệu trực quan, GPT-4V có thể trả lời các truy vấn với mức độ hiểu biết theo ngữ cảnh cao hơn.

Xây dựng trang web mô phỏng đơn giản bằng bản vẽ

Có động lực vì điều này kêu riu ríu, Tôi đã cố gắng tạo một bản mô phỏng cho trang web unity.ai.

Mặc dù kết quả không hoàn toàn phù hợp với tầm nhìn ban đầu của tôi nhưng đây là kết quả tôi đạt được.

Hạn chế và sai sót của GPT-4V(ision)

Để phân tích GPT-4V, nhóm Open AI đã thực hiện các đánh giá định tính và định lượng. Các bài kiểm tra định tính bao gồm các bài kiểm tra nội bộ và đánh giá của chuyên gia bên ngoài, trong khi các bài kiểm tra định lượng đo lường mức độ từ chối và độ chính xác của mô hình trong các tình huống khác nhau như xác định nội dung có hại, nhận dạng nhân khẩu học, lo ngại về quyền riêng tư, định vị địa lý, an ninh mạng và bẻ khóa đa phương thức.

Vẫn là mô hình không hoàn hảo.

Sản phẩm giấy nêu bật những hạn chế của GPT-4V, như suy luận không chính xác và thiếu văn bản hoặc ký tự trong hình ảnh. Nó có thể gây ảo giác hoặc bịa ra sự thật. Đặc biệt, nó không phù hợp để xác định các chất nguy hiểm trong hình ảnh, thường xác định nhầm chúng.

Trong hình ảnh y tế, GPT-4V có thể đưa ra những phản hồi không nhất quán và thiếu nhận thức về các phương pháp thực hành tiêu chuẩn, dẫn đến khả năng chẩn đoán sai.

Hiệu suất không đáng tin cậy cho mục đích y tế (nguồn)

Nó cũng không nắm bắt được sắc thái của một số biểu tượng căm thù nhất định và có thể tạo ra nội dung không phù hợp dựa trên thông tin đầu vào trực quan. OpenAI khuyên không nên sử dụng GPT-4V cho những diễn giải quan trọng, đặc biệt là trong bối cảnh y tế hoặc nhạy cảm.

Tổng kết

Được tạo bằng cách sử dụng Khuếch tán ổn định nhanh XL https://huggingface.co/spaces/google/sdxl

Sự xuất hiện của GPT-4 Vision (GPT-4V) mang đến nhiều khả năng thú vị và những rào cản mới để bạn vượt qua. Trước khi triển khai, chúng tôi đã nỗ lực rất nhiều để đảm bảo rằng các rủi ro, đặc biệt là khi liên quan đến ảnh chụp người, được xem xét kỹ lưỡng và giảm thiểu. Thật ấn tượng khi thấy GPT-4V đã phát triển như thế nào, cho thấy nhiều hứa hẹn trong các lĩnh vực khó khăn như y học và khoa học.

Bây giờ, có một số câu hỏi lớn trên bàn. Ví dụ: liệu những người mẫu này có thể xác định được người nổi tiếng qua ảnh không? Họ có nên đoán giới tính, chủng tộc hoặc cảm xúc của một người từ một bức ảnh không? Và liệu có nên có những cải tiến đặc biệt để hỗ trợ những người khiếm thị không? Những câu hỏi này mở ra nhiều vấn đề về quyền riêng tư, sự công bằng và cách AI phù hợp với cuộc sống của chúng ta, đó là điều mà mọi người nên có tiếng nói.