Trí tuệ nhân tạo

Hiệu suất học máy tốt hơn thông qua thay đổi kích thước hình ảnh dựa trên CNN

Google Research đã đề xuất một phương pháp mới để cải thiện hiệu quả và độ chính xác của quy trình đào tạo thị giác máy tính dựa trên hình ảnh bằng cách cải thiện cách thu nhỏ hình ảnh trong tập dữ liệu ở giai đoạn tiền xử lý.

Trong tạp chí giấy Học cách thay đổi kích thước hình ảnh cho các tác vụ thị giác máy tính, các nhà nghiên cứu Hossein Talebi và Peyman Milanfar sử dụng CNN để tạo ra một kiến trúc thay đổi kích thước hình ảnh kết hợp mới tạo ra sự cải thiện đáng chú ý trong kết quả nhận dạng thu được trên bốn bộ dữ liệu thị giác máy tính phổ biến.

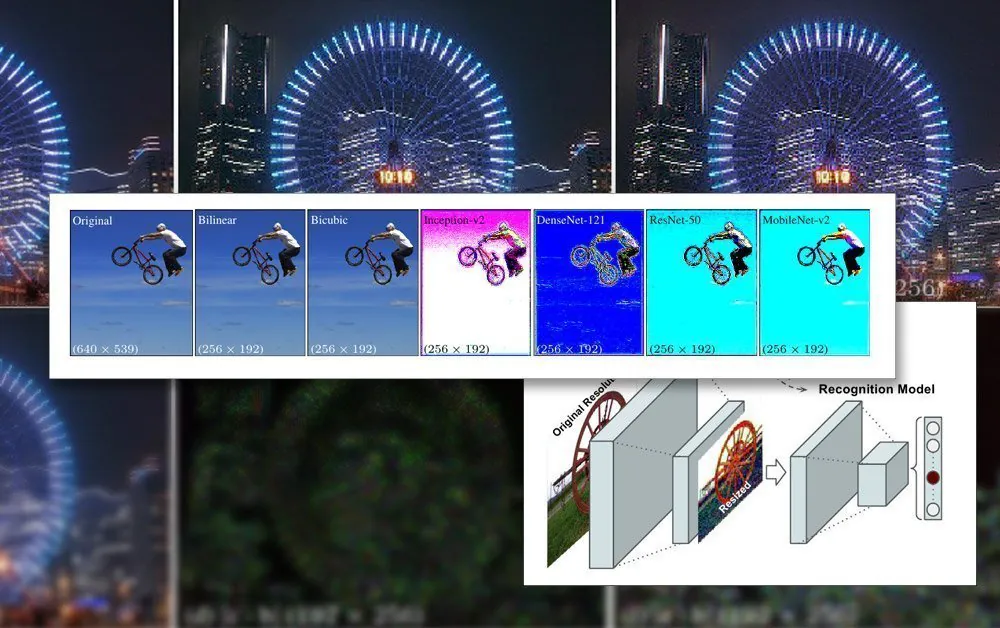

Khung chung được đề xuất để công nhận và thay đổi kích thước. Nguồn: https://arxiv.org/pdf/2103.09950.pdf

Bài viết nhận thấy rằng các phương pháp thay đổi kích thước/thay đổi kích thước hiện đang được sử dụng trong các quy trình học máy tự động đã lỗi thời hàng thập kỷ và thường chỉ sử dụng các phương pháp song tuyến tính, nhị phân và lân cận gần nhất cơ bản. thay đổi kích thước – các phương pháp xử lý tất cả các pixel một cách bừa bãi.

Ngược lại, phương pháp được đề xuất tăng cường dữ liệu hình ảnh thông qua CNN và kết hợp đầu vào đó vào các hình ảnh đã thay đổi kích thước mà cuối cùng sẽ đi qua kiến trúc của mô hình.

Các ràng buộc về hình ảnh trong đào tạo AI

Để đào tạo một mô hình liên quan đến hình ảnh, khung học máy sẽ bao gồm giai đoạn tiền xử lý, trong đó nhiều hình ảnh khác nhau có kích thước, không gian màu và độ phân giải khác nhau (sẽ đóng góp vào tập dữ liệu đào tạo) được cắt một cách có hệ thống và thay đổi kích thước thành các kích thước nhất quán và một định dạng duy nhất, ổn định.

Nói chung, điều này sẽ liên quan đến một số thỏa hiệp dựa trên định dạng PNG, trong đó sự đánh đổi giữa thời gian/tài nguyên xử lý, kích thước tệp và chất lượng hình ảnh sẽ được thiết lập.

Trong hầu hết các trường hợp, kích thước cuối cùng của hình ảnh được xử lý là rất nhỏ. Dưới đây chúng ta thấy một ví dụ về hình ảnh có độ phân giải 80 × 80 mà tại đó một số bộ dữ liệu deepfakes sớm nhất đã được tạo ra:

Vì khuôn mặt (và các đối tượng có thể khác) hiếm khi vừa với tỷ lệ hình vuông bắt buộc, nên có thể cần thêm các thanh màu đen (hoặc cho phép không gian bị lãng phí) để đồng nhất hóa hình ảnh, tiếp tục cắt giảm dữ liệu hình ảnh có thể sử dụng thực tế:

Ở đây, khuôn mặt đã được trích xuất từ một khu vực hình ảnh lớn hơn cho đến khi nó được cắt một cách tiết kiệm nhất có thể để bao gồm toàn bộ khu vực khuôn mặt. Tuy nhiên, như đã thấy ở bên phải, phần lớn diện tích còn lại sẽ không được sử dụng trong quá trình đào tạo, làm tăng thêm tầm quan trọng của chất lượng hình ảnh của dữ liệu đã thay đổi kích thước.

Khi khả năng của GPU đã được cải thiện trong những năm gần đây, với thế hệ thẻ NVIDIA mới được trang bị tăng số tiền của video-RAM (VRAM), kích thước hình ảnh đóng góp trung bình đang bắt đầu tăng lên, mặc dù 224×224 pixel vẫn còn khá chuẩn (ví dụ: đó là kích thước của ResNet-50 tập dữ liệu).

Một hình ảnh 224 × 244 pixel chưa được thay đổi kích thước.

Lắp hàng loạt vào VRAM

Lý do tất cả các hình ảnh phải có cùng kích thước là vì xuống dốc, phương pháp mà mô hình cải thiện theo thời gian, yêu cầu dữ liệu đào tạo thống nhất.

Lý do hình ảnh phải quá nhỏ là do chúng phải được tải (giải nén hoàn toàn) vào VRAM trong quá trình đào tạo theo lô nhỏ, thường là từ 6-24 hình ảnh mỗi đợt. Quá ít hình ảnh mỗi đợt và không có đủ tài liệu nhóm để khái quát tốt, ngoài việc kéo dài thời gian đào tạo; quá nhiều và mô hình có thể không đạt được các đặc điểm và chi tiết cần thiết (xem bên dưới).

Phần 'tải trực tiếp' này của kiến trúc đào tạo được gọi là không gian tiềm ẩn. Đây là nơi các tính năng được trích xuất lặp đi lặp lại từ cùng một dữ liệu (tức là cùng một hình ảnh) cho đến khi mô hình hội tụ đến trạng thái có tất cả kiến thức tổng quát mà nó cần để thực hiện các phép biến đổi trên dữ liệu chưa nhìn thấy thuộc loại tương tự sau này.

Quá trình này thường mất nhiều ngày, mặc dù có thể mất cả tháng hoặc hơn với khối lượng lớn liên tục và kiên cường suy nghĩ 24/7 để đạt được sự khái quát hóa hữu ích. Việc tăng kích thước VRAM chỉ hữu ích ở một mức độ nào đó, vì ngay cả những mức tăng nhỏ trong độ phân giải hình ảnh cũng có thể có tác động theo thứ tự cường độ đối với khả năng xử lý và các tác động liên quan đến độ chính xác có thể không phải lúc nào cũng thuận lợi.

Việc sử dụng dung lượng VRAM lớn hơn để đáp ứng kích thước lô cao hơn cũng là một điều may mắn lẫn lộn, vì tốc độ đào tạo lớn hơn đạt được nhờ điều này là có khả năng được bù đắp bởi kết quả ít chính xác hơn.

Do đó, vì kiến trúc đào tạo rất hạn chế nên bất cứ điều gì có thể tạo ra sự cải thiện trong các giới hạn hiện có của đường ống đều là một thành tựu đáng chú ý.

Làm thế nào Superior Downsizing giúp

Chất lượng cuối cùng của một hình ảnh sẽ được đưa vào tập dữ liệu đào tạo đã được chứng minh là có tác dụng cải thiện kết quả đào tạo, đặc biệt trong các nhiệm vụ nhận dạng đối tượng. Năm 2018, các nhà nghiên cứu từ Viện Hệ thống thông minh Max Planck tranh cãi rằng việc lựa chọn phương pháp lấy mẫu lại ảnh hưởng đáng kể đến hiệu suất và kết quả đào tạo.

Ngoài ra, nghiên cứu trước đây của Google (do các tác giả của bài báo mới đồng viết) đã phát hiện ra rằng độ chính xác của phân loại có thể được cải thiện bằng cách duy trì kiểm soát qua các vật phẩm nén trong hình ảnh tập dữ liệu.

Mô hình CNN được tích hợp trong bộ lấy mẫu lại mới kết hợp thay đổi kích thước song tuyến tính với tính năng 'bỏ qua kết nối' có thể kết hợp đầu ra từ mạng được đào tạo vào hình ảnh đã thay đổi kích thước.

Không giống như kiến trúc bộ mã hóa/bộ giải mã thông thường, đề xuất mới không chỉ có thể hoạt động như nút cổ chai chuyển tiếp nguồn cấp dữ liệu mà còn là nút cổ chai nghịch đảo để mở rộng quy mô theo bất kỳ kích thước mục tiêu và/hoặc tỷ lệ khung hình nào. Ngoài ra, phương pháp lấy mẫu lại 'tiêu chuẩn' có thể được hoán đổi cho bất kỳ phương pháp truyền thống phù hợp nào khác, chẳng hạn như ra mắt.

Chi tiết tần số cao

Phương pháp mới tạo ra những hình ảnh có hiệu lực dường như 'nướng' các tính năng chính (cuối cùng sẽ được quá trình đào tạo nhận ra) trực tiếp vào hình ảnh nguồn. Về mặt thẩm mỹ, kết quả là khác thường:

Phương pháp mới được áp dụng trên bốn mạng – Inception V2; Mật Độ Mạng-121; ResNet-50; và MobileNet-V2. Kết quả của phương pháp lấy mẫu/thay đổi kích thước hình ảnh của Google Research tạo ra hình ảnh có tập hợp pixel rõ ràng, dự đoán các tính năng chính sẽ được phân biệt trong quá trình đào tạo.

Các nhà nghiên cứu lưu ý rằng những thử nghiệm ban đầu này được tối ưu hóa riêng cho các tác vụ nhận dạng hình ảnh và trong các thử nghiệm, 'trình thay đổi kích thước đã học' do CNN cung cấp có thể đạt được tỷ lệ lỗi được cải thiện trong các tác vụ đó. Các nhà nghiên cứu dự định trong tương lai sẽ áp dụng phương pháp này cho các loại ứng dụng thị giác máy tính dựa trên hình ảnh khác.