Yapay Zeka

Yüksek Lisans'ta Kara Kutu Sorunu: Zorluklar ve Ortaya Çıkan Çözümler

Yapay zekanın bir alt kümesi olan makine öğrenimi üç bileşenden oluşur: algoritmalar, eğitim verileri ve ortaya çıkan model. Esas olarak bir dizi prosedürden oluşan bir algoritma, geniş bir örnek kümesinden (eğitim verileri) kalıpları tanımlamayı öğrenir. Bu eğitimin doruk noktası bir makine öğrenimi modelidir. Örneğin, köpek görüntüleri ile eğitilen bir algoritma, görüntülerdeki köpekleri tanımlayabilen bir modelle sonuçlanacaktır.

Makine Öğreniminde Kara Kutu

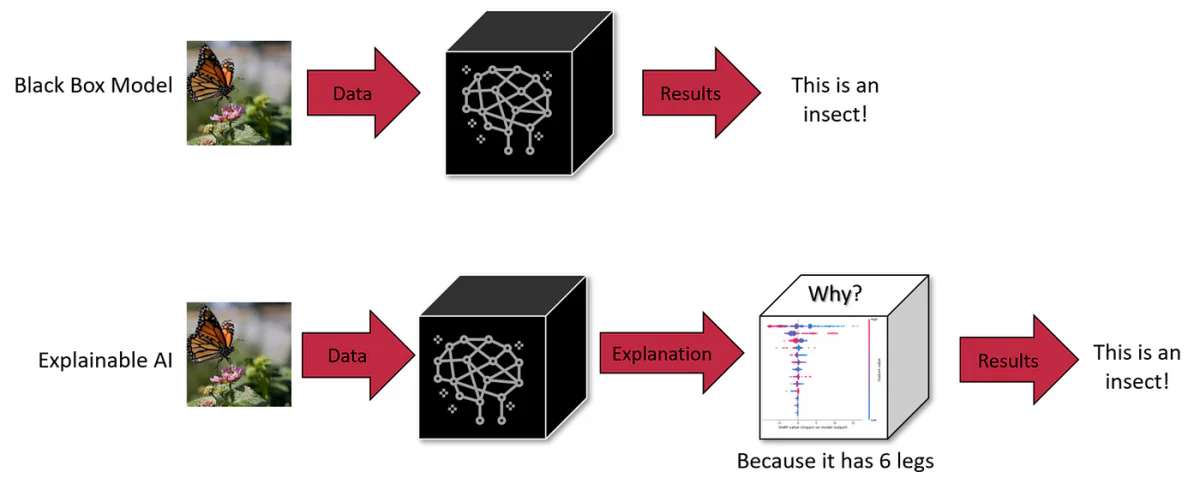

Makine öğreniminde, algoritma, eğitim verileri veya model olmak üzere üç bileşenden herhangi biri kara kutu olabilir. Algoritmalar genellikle herkes tarafından bilinse de, geliştiriciler fikri mülkiyeti korumak için modeli veya eğitim verilerini gizli tutmayı tercih edebilirler. Bu belirsizlik, yapay zekanın karar alma sürecini anlamayı zorlaştırır.

Yapay zeka kara kutuları, iç işleyişi kullanıcılar için opak veya görünmez kalan sistemlerdir. Kullanıcılar veri girebilir ve çıktı alabilir, ancak çıktıyı üreten mantık veya kod gizli kalır. Bu, ChatGPT ve DALL-E 3 gibi gelişmiş üretken modeller de dahil olmak üzere birçok yapay zeka sisteminde ortak bir özelliktir.

GPT-4 gibi Yüksek Lisans'lar önemli bir zorluk teşkil ediyor: iç işleyişi büyük ölçüde şeffaf değil, bu da onları "kara kutu" haline getiriyor. Böyle bir şeffaflık yalnızca teknik bir bilmece değildir; gerçek dünyadaki güvenlik ve etik kaygıları doğurur. Mesela bu sistemlerin nasıl sonuca vardığını anlayamıyorsak, tıbbi teşhis veya mali değerlendirme gibi kritik konularda onlara güvenebilir miyiz?

Yüksek Lisans'ın Ölçeği ve Karmaşıklığı

Bu modellerin ölçeği onların karmaşıklığını artırmaktadır. Örneğin 3 milyar parametresi olan GPT-175'ü ve trilyonlarca parametreye sahip yeni modellerini ele alalım. Her parametre, sinir ağı içinde karmaşık şekillerde etkileşime girerek, tek tek bileşenlerin tek başına incelenmesiyle tahmin edilemeyen yeni ortaya çıkan yeteneklere katkıda bulunur. Bu ölçek ve karmaşıklık, iç mantıklarını tam olarak kavramayı neredeyse imkansız hale getirerek, bu modellerdeki önyargıların veya istenmeyen davranışların teşhis edilmesinde engel teşkil etmektedir.

Takas: Ölçek ve Yorumlanabilirlik

Yüksek Lisans'ın ölçeğinin küçültülmesi yorumlanabilirliği artırabilir, ancak bu onların gelişmiş yetenekleri pahasına olabilir. Ölçek, daha küçük modellerin başaramayacağı davranışları mümkün kılan şeydir. Bu, ölçek, yetenek ve yorumlanabilirlik arasında doğal bir değiş tokuş sunar.

LLM Kara Kutu Sorununun Etkisi

1. Kusurlu Karar Verme

GPT-3 veya BERT gibi Yüksek Lisans'ların karar verme sürecindeki şeffaflık, tespit edilemeyen önyargılara ve hatalara yol açabilir. Kararların geniş kapsamlı sonuçlara yol açtığı sağlık hizmetleri veya ceza adaleti gibi alanlarda, yüksek lisans eğitimlerinin etik ve mantıksal sağlamlık açısından denetlenememesi büyük bir endişe kaynağıdır. Örneğin, güncelliğini kaybetmiş veya taraflı verilere dayanan bir tıbbi teşhis Yüksek Lisansı, zararlı önerilerde bulunabilir. Benzer şekilde, işe alım süreçlerinde Yüksek Lisans'lar istemeden de olsa cinsiyet önyargılarını sürdürebilir. Dolayısıyla kara kutunun doğası yalnızca kusurları gizlemekle kalmaz, aynı zamanda onları potansiyel olarak güçlendirebilir ve şeffaflığı artırmak için proaktif bir yaklaşım gerektirir.

2. Farklı Bağlamlarda Sınırlı Uyarlanabilirlik

Yüksek Lisans'ların iç işleyişine ilişkin içgörü eksikliği, onların uyarlanabilirliğini kısıtlamaktadır. Örneğin, işe alım yapan bir LLM, değerlendirme kriterlerini ayarlayamamasından dolayı, akademik yeterliliklerden ziyade pratik becerilere değer veren bir pozisyon için adayları değerlendirmede yetersiz kalabilir. Benzer şekilde, tıbbi bir Yüksek Lisans veri dengesizlikleri nedeniyle nadir hastalık teşhisleriyle mücadele edebilir. Bu esneklik, belirli görevler ve bağlamlar için LLM'lerin yeniden kalibre edilmesinde şeffaflık ihtiyacını vurgulamaktadır.

3. Önyargı ve Bilgi Eksiklikleri

Hukuk alanındaki yüksek lisans programlarının (LL.M.) geniş kapsamlı eğitim verilerini işleme süreçleri, algoritmaları ve model mimarilerinin getirdiği sınırlamalara tabidir. Örneğin, bir tıp LLM'si, dengesiz veri kümeleri üzerinde eğitim alırsa demografik önyargılar gösterebilir. Ayrıca, bir LLM'nin niş konulardaki uzmanlığı yanıltıcı olabilir ve aşırı özgüvenli, hatalı çıktılara yol açabilir. Bu önyargıların ve bilgi eksikliklerinin giderilmesi, yalnızca ek veri gerektirmez; modelin işleme mekanizmasının incelenmesini de gerektirir.

4. Yasal ve Etik Sorumluluk

Hukuk alanında Yüksek Lisans (LLM) programlarının belirsiz yapısı, kararlarının neden olduğu herhangi bir zarardan doğan sorumluluk konusunda yasal bir gri alan yaratmaktadır. Tıbbi bir ortamda çalışan bir LLM, hastaya zarar veren hatalı tavsiyelerde bulunursa, modelin şeffaf olmaması nedeniyle hesap verebilirliği belirlemek zorlaşır. Bu yasal belirsizlik, hassas alanlarda LLM programları yürüten kuruluşlar için riskler oluşturmakta ve net bir yönetişim ve şeffaflık ihtiyacını vurgulamaktadır.

5. Hassas Uygulamalarda Güven Sorunları

Sağlık ve finans gibi kritik alanlarda kullanılan yüksek lisans kurumları için şeffaflığın olmayışı onların güvenilirliğini zedeliyor. Kullanıcıların ve düzenleyicilerin, bu modellerin önyargı içermediğinden veya adil olmayan kriterlere dayalı kararlar vermediğinden emin olmaları gerekir. Yüksek Lisans'larda önyargının olmadığını doğrulamak, etik dağıtım için açıklanabilirliğin önemini vurgulayarak karar verme süreçlerinin anlaşılmasını gerektirir.

6. Kişisel Verilerle İlgili Riskler

Yüksek Lisans'lar, hassas kişisel bilgileri içerebilecek kapsamlı eğitim verilerine ihtiyaç duyar. Bu modellerin kara kutu yapısı, bu verilerin nasıl işlendiği ve kullanıldığı konusunda endişeleri artırıyor. Örneğin, hasta kayıtları üzerine eğitim almış bir tıbbi yüksek lisans, veri gizliliği ve kullanımına ilişkin soruları gündeme getiriyor. Kişisel verilerin kötüye kullanılmamasını veya istismar edilmemesini sağlamak, bu modeller kapsamında şeffaf veri işleme süreçlerini gerektirir.

Yorumlanabilirlik için Gelişen Çözümler

Bu zorlukların üstesinden gelmek için yeni teknikler geliştirilmektedir. Bunlar karşıolgusal (CF) yaklaşım yöntemlerini içerir. İlk yöntem, diğer kavramları sabit tutarken Yüksek Lisans'tan belirli bir metin kavramını değiştirmesini istemeyi içerir. Bu yaklaşım, etkili olmasına rağmen, çıkarım zamanında kaynak yoğundur.

İkinci yaklaşım, eğitim sırasında Yüksek Lisans tarafından yönlendirilen özel bir yerleştirme alanı oluşturmayı içerir. Bu alan nedensel bir grafikle hizalanır ve CF'lere yaklaşan eşleşmelerin belirlenmesine yardımcı olur. Bu yöntemin test sırasında daha az kaynak gerektirdiği ve milyarlarca parametreye sahip LLM'lerde bile model tahminlerini etkili bir şekilde açıkladığı gösterilmiştir.

Bu yaklaşımlar, güvenliği sağlamak ve güven oluşturmak için NLP sistemlerinde nedensel açıklamaların önemini vurgulamaktadır. Karşıolgusal yaklaşımlar, belirli bir metnin kendi üretim sürecindeki belirli bir kavramın farklı olması durumunda nasıl değişeceğini hayal etmenin bir yolunu sağlar ve NLP modellerinde üst düzey kavramların pratik nedensel etki tahminine yardımcı olur.

Derinlemesine İnceleme: Yüksek Lisans'ta Açıklama Yöntemleri ve Nedensellik

Problama ve Özellik Önemi Araçları

Araştırma, modellerde hangi iç temsillerin kodlandığını çözmek için kullanılan bir tekniktir. Denetimli veya denetimsiz olabilir ve belirli kavramların bir ağdaki belirli yerlere kodlanıp kodlanmadığını belirlemeyi amaçlar. Bir dereceye kadar etkili olmakla birlikte, Geiger ve ark.'nın vurguladığı gibi, araştırmalar nedensel açıklamalar sağlamada yetersiz kalmaktadır. (2021).

Açıklama yönteminin başka bir biçimi olan özellik önemi araçları, genellikle giriş özelliklerine odaklanır, ancak bazı gradyan tabanlı yöntemler bunu gizli durumlara kadar genişletir. Bunun bir örneği, temel (karşıolgusal, CF) girdileri keşfederek nedensel bir yorum sunan Entegre Gradyanlar yöntemidir. Kullanışlı olmalarına rağmen bu yöntemler, analizlerini basit girdi özelliklerinin ötesinde gerçek dünya kavramlarıyla bağlantılandırmakta hala zorluk çekiyor.

Müdahaleye Dayalı Yöntemler

Müdahaleye dayalı yöntemler, model davranışı üzerindeki etkileri incelemek için girdilerin veya iç temsillerin değiştirilmesini içerir. Bu yöntemler nedensel etkileri tahmin etmek için CF durumları oluşturabilir, ancak dikkatli bir şekilde kontrol edilmedikçe genellikle mantıksız girdiler veya ağ durumları üretirler. S-öğrenen kavramından ilham alan Nedensel Proxy Modeli (CPM), bu alanda yeni bir yaklaşımdır ve açıklanan modelin CF girdileri altındaki davranışını taklit eder. Ancak her model için ayrı bir açıklayıcıya ihtiyaç duyulması önemli bir sınırlamadır.

Karşı Olgusallara Yaklaşım

Karşıt olgular, çeşitli faktör veya etiketlerde bozulmalar içeren veri artırma için makine öğreniminde yaygın olarak kullanılır. Bunlar, manuel düzenleme, sezgisel anahtar kelime değiştirme veya otomatik metin yeniden yazma yoluyla oluşturulabilir. Manuel düzenleme doğru olsa da, aynı zamanda kaynak yoğundur. Anahtar kelime tabanlı yöntemlerin sınırlamaları vardır ve üretken yaklaşımlar akıcılık ve kapsam arasında bir denge sunar.

Aslına Uygun Açıklamalar

Açıklamalarda sadakat, modelin altında yatan mantığı doğru bir şekilde tasvir etmeyi ifade eder. Sadakat için evrensel olarak kabul görmüş bir tanım bulunmamakla birlikte, Duyarlılık, Tutarlılık, Özellik Önem Uyumu, Sağlamlık ve Simüle Edilebilirlik gibi çeşitli ölçütler aracılığıyla nitelendirilmesine yol açar. Bu yöntemlerin çoğu özellik düzeyindeki açıklamalara odaklanır ve genellikle korelasyonu nedensellikle karıştırır. Çalışmamız, nedensellik literatüründen yararlanarak sezgisel bir ölçüt olan Sıra Sadakatini önererek üst düzey kavram açıklamaları sağlamayı amaçlamaktadır.

Hukuk alanında lisans programlarının (LLM) içsel karmaşıklıklarını derinlemesine inceledik, "kara kutu" doğalarını ve bunun yarattığı önemli zorlukları anladık. Sağlık ve finans gibi hassas alanlardaki hatalı karar alma risklerinden, önyargı ve adaleti çevreleyen etik ikilemlere kadar, LLM'lerde şeffaflığa duyulan ihtiyaç hiç bu kadar belirgin olmamıştı.

Yüksek Lisans'ların geleceği ve bunların günlük yaşamlarımıza ve kritik karar alma süreçlerimize entegrasyonu, bu modelleri yalnızca daha gelişmiş değil, aynı zamanda daha anlaşılır ve hesap verebilir hale getirme becerimize bağlıdır. Açıklanabilirlik ve yorumlanabilirlik arayışı yalnızca teknik bir çaba değil, aynı zamanda yapay zeka sistemlerine güven oluşturmanın temel bir yönüdür. Yüksek Lisans'lar toplumla daha entegre hale geldikçe, yalnızca yapay zeka uygulayıcılarından değil, bu sistemlerle etkileşime giren her kullanıcıdan gelen şeffaflık talebi de artacaktır.