Anderson'ın Açısı

Yapay Zeka ile İnsan Görüntülerinin Geri Kazanılması ve Düzenlenmesi

California Üniversitesi Merced ile Adobe arasındaki yeni bir iş birliği, en son teknolojiye yönelik bir ilerleme sunuyor insan imajının tamamlanması – insanların görüntülerindeki örtülü veya gizli kısımların 'gizlenmesinin kaldırılması' gibi çok çalışılan bir görev, örneğin sanal deneme, animasyon ve fotoğraf düzenleme.

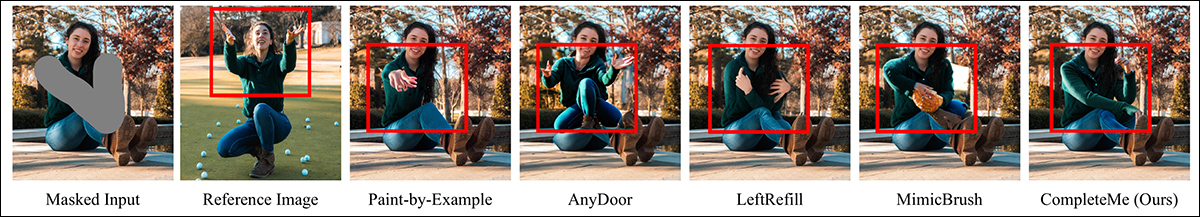

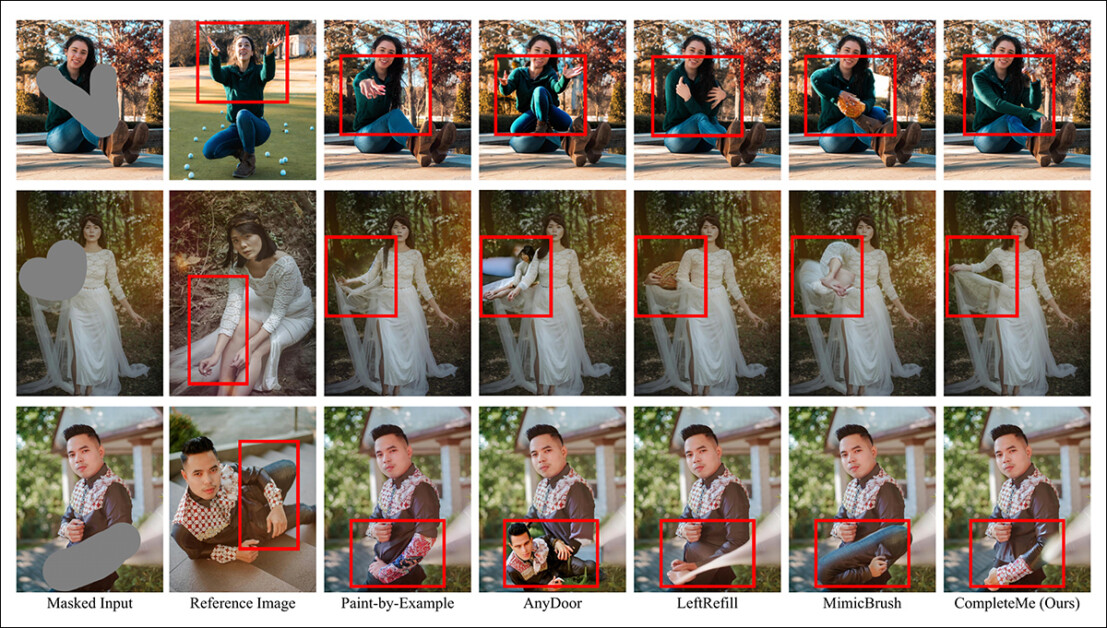

CompleteMe gibi insan görüntü tamamlama sistemleri, hasarlı görüntüleri onarmanın veya kullanıcının isteğine göre değiştirmenin yanı sıra, mevcut görüntülere (bu iki örnekteki orta sütunda olduğu gibi, ek bir referans görüntü aracılığıyla) yeni giysiler de ekleyebilir. Bu örnekler, yeni makalenin kapsamlı ek PDF dosyasından alınmıştır. Kaynak: https://liagm.github.io/CompleteMe/pdf/supp.pdf

The yeni yaklaşımbaşlıklı CompleteMe: Referans Tabanlı İnsan Görüntüsü Tamamlama, sisteme, insan tasvirinin gizli veya eksik bölümünün yerine hangi içeriğin konulması gerektiğini 'önermek' için ek giriş görüntüleri kullanır (bu nedenle moda tabanlı deneme çerçevelerine uygulanabilirlik):

CompleteMe sistemi referans içeriğini insan görüntüsünün belirsiz veya örtülü kısmına uyarlayabilir.

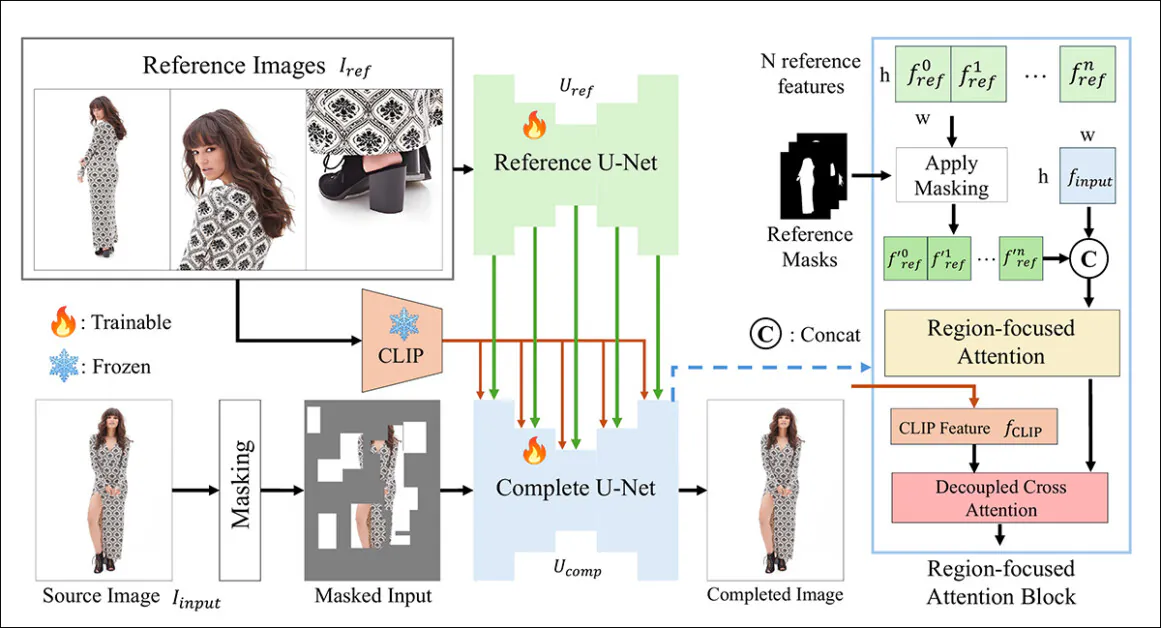

Yeni sistem ikili bir sistem kullanıyor U-Net mimarlık ve bir Bölge Odaklı Dikkat (RFA) Görüntü restorasyon örneğinin ilgili alanına kaynakları yönlendiren blok.

Araştırmacılar ayrıca referans tabanlı tamamlama görevlerini değerlendirmek için tasarlanmış yeni ve zorlu bir kıyaslama sistemi sunuyorlar (CompleteMe, bilgisayar görüşünde mevcut ve devam eden bir araştırma dalının parçası olmasına rağmen, şu ana kadar bir kıyaslama şeması yoktu).

Testlerde ve iyi ölçeklendirilmiş bir kullanıcı çalışmasında, yeni yöntem çoğu metrikte ve genel olarak önde çıktı. Bazı durumlarda, rakip yöntemler referans tabanlı yaklaşım tarafından tamamen kandırıldı:

Ek materyalden: AnyDoor yöntemi, bir referans görüntüsünün nasıl yorumlanacağına karar vermede özellikle zorluk yaşar.

Kağıt şöyle diyor:

'Kıyaslama ölçütümüz üzerinde yaptığımız kapsamlı deneyler, CompleteMe'nin niceliksel ölçümler, nitel sonuçlar ve kullanıcı çalışmaları açısından hem referans tabanlı hem de referans tabanlı olmayan en son yöntemlerden daha üstün performans gösterdiğini ortaya koymaktadır.

'Özellikle karmaşık pozlar, incelikli giyim desenleri ve özgün aksesuarlar içeren zorlu senaryolarda, modelimiz sürekli olarak üstün görsel sadakat ve anlamsal tutarlılık elde ediyor.'

Ne yazık ki, projenin GitHub varlığı hiçbir kod içermiyor ve herhangi bir vaatte bulunmuyor ve mütevazı bir girişim de var proje sayfası, tescilli bir mimari olarak çerçevelenmiş gibi görünüyor.

Yeni sistemin önceki yöntemlere kıyasla öznel performansının bir başka örneği. Daha fazla ayrıntı makalenin ilerleyen kısımlarında.

Yöntem

CompleteMe çerçevesi, yardımcı malzemenin sürece entegrasyonunu ele alan bir Referans U-Net ve aşağıdaki kavramsal şemada gösterildiği gibi, nihai sonucu elde etmek için daha geniş bir yelpazede süreci barındıran tutarlı bir U-Net tarafından desteklenmektedir:

CompleteMe için kavramsal şema. Kaynak: https://arxiv.org/pdf/2504.20042

Sistem ilk olarak maskelenmiş giriş görüntüsünü gizli bir gösterime kodlar. Aynı zamanda, Referans U-Net, her biri farklı vücut bölgelerini gösteren birden fazla referans görüntüsünü işleyerek ayrıntılı mekansal Özellikler.

Bu özellikler, 'tam' U-Net'e yerleştirilmiş Bölge odaklı Dikkat bloğundan geçer ve burada seçici olarak maskelenmiş İlgili bölge maskelerini kullanarak, modelin yalnızca referans görüntülerdeki ilgili alanlara odaklanmasını sağlayın.

Maskelenmiş özellikler daha sonra küresel özelliklerle bütünleştirilir CLIP-ayrıştırılmış anlamsal özellikler yoluyla türetilmiş çapraz dikkatBu, modelin eksik içeriği hem ince ayrıntılarla hem de anlamsal tutarlılıkla yeniden oluşturmasına olanak tanır.

Gerçekçiliği ve sağlamlığı artırmak için, giriş maskeleme süreci rastgele ızgara tabanlı tıkanıklıkları insan vücudu şekil maskeleriyle birleştirir; her biri eşit olasılıkla uygulanır ve modelin tamamlaması gereken eksik bölgelerin karmaşıklığını artırır.

Sadece referans için

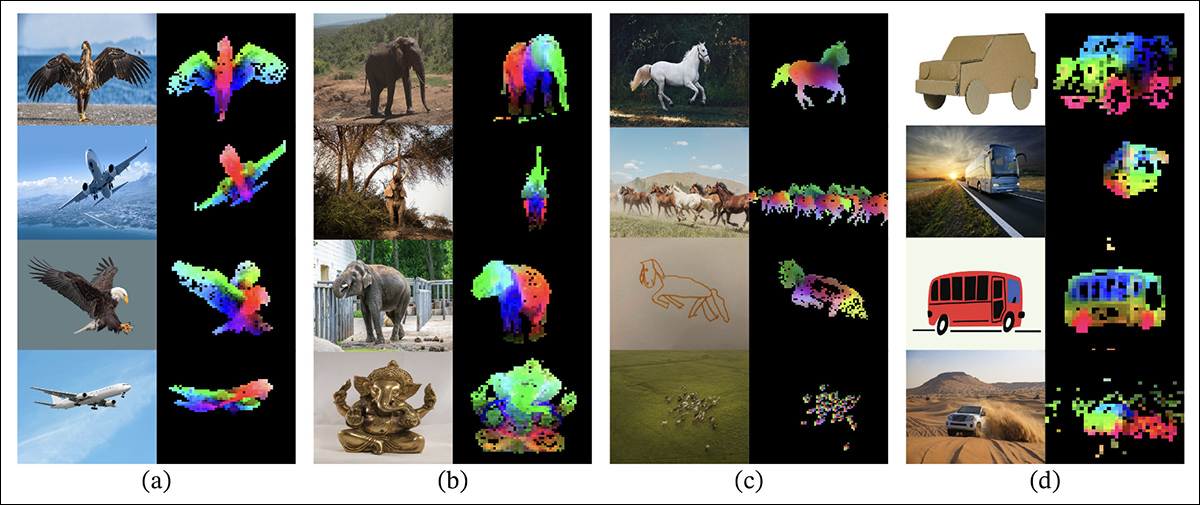

Referans tabanlı görüntü boyama için önceki yöntemler genellikle şunlara dayanıyordu: anlamsal düzey kodlayıcılar. Bu tür projeler CLIP'in kendisini ve DINOv2Her ikisi de referans görüntülerden küresel özellikleri çıkarır, ancak doğru kimlik koruması için gereken ince mekansal ayrıntıları sıklıkla kaybeder.

Yeni çalışmada karşılaştırma testlerine dahil edilen eski DINOV2 yaklaşımının yayın belgesinden: Renkli katmanlar, her sütundaki görüntü parçalarına uygulanan Temel Bileşen Analizi'nin (PCA) ilk üç temel bileşenini gösteriyor ve DINOv2'nin farklı görüntülerde benzer nesne parçalarını nasıl gruplandırdığını vurguluyor. Poz, stil veya işlemedeki farklılıklara rağmen, karşılık gelen bölgeler (kanatlar, uzuvlar veya tekerlekler gibi) tutarlı bir şekilde eşleştiriliyor ve bu da modelin gözetim olmadan parça tabanlı yapıyı öğrenme yeteneğini gösteriyor. Kaynak: https://arxiv.org/pdf/2304.07193

CompleteMe, bu yönü, başlatılan özel bir Referans U-Net aracılığıyla ele alır. Kararlı Difüzyon 1.5, ancak olmadan çalışır difüzyon gürültü adımı*.

Farklı vücut bölgelerini kapsayan her referans görüntü, bu U-Net aracılığıyla ayrıntılı gizli özelliklere kodlanır. Küresel anlamsal özellikler de CLIP kullanılarak ayrı ayrı çıkarılır ve her iki özellik seti de dikkat tabanlı entegrasyon sırasında verimli kullanım için önbelleğe alınır. Böylece sistem, ince taneli görünüm bilgilerini korurken birden fazla referans girişini esnek bir şekilde barındırabilir.

orkestrasyon

Tutarlı U-Net, tamamlanma sürecinin son aşamalarını yönetir. boyama varyantı Stable Diffusion 1.5'in girdisi olarak, referans görüntülerden çizilen ayrıntılı mekansal özellikler ve CLIP kodlayıcısı tarafından çıkarılan küresel anlamsal özelliklerle birlikte, gizli formdaki maskelenmiş kaynak görüntü alınır.

Bu çeşitli girdiler, referans materyalinin en ilgili alanlarına doğru modelin odağını yönlendirmede kritik bir rol oynayan RFA bloğu aracılığıyla bir araya getirilir.

Dikkat mekanizmasına girmeden önce, referans özellikleri ilgisiz bölgeleri kaldırmak için açıkça maskelenir ve daha sonra kaynak görüntünün gizli temsiliyle birleştirilir, böylece dikkatin mümkün olduğunca hassas bir şekilde yönlendirilmesi sağlanır.

Bu entegrasyonu geliştirmek için CompleteMe, aşağıdakilerden uyarlanmış, ayrıştırılmış bir çapraz dikkat mekanizmasını içerir: IP-Adaptör çerçeve:

CompleteMe'ye bir kısmı dahil edilen IP-Adapter, gizli yayılma modeli mimarilerindeki son üç çalkantılı geliştirme yılının en başarılı ve sıklıkla yararlanılan projelerinden biridir. Kaynak: https://ip-adapter.github.io/

Bu, modelin ayrı dikkat akışları aracılığıyla uzamsal olarak ayrıntılı görsel özellikleri ve daha geniş anlamsal bağlamı işlemesine olanak tanır; bunlar daha sonra birleştirilir ve yazarların iddia ettiği gibi hem kimliği hem de ince ayrıntılı ayrıntıları koruyan tutarlı bir yeniden yapılandırma ile sonuçlanır.

Kıyaslama

Referans tabanlı insan tamamlama için uygun bir veri kümesinin bulunmaması nedeniyle, araştırmacılar kendi veri kümelerini önerdiler. (İsimsiz) kıyaslama ölçütü, Adobe Research'ün 2023 için tasarladığı WPose veri kümesinden seçilmiş görüntü çiftlerinin düzenlenmesiyle oluşturuldu. Uniİnsan projesi.

Adobe Research 2023 UniHuman projesinden poz örnekleri. Kaynak: https://github.com/adobe-research/UniHuman?tab=readme-ov-file#data-prep

Araştırmacılar, boyama alanlarını belirtmek için kaynak maskelerini elle çizdiler ve sonuçta kaynak görüntü, maske ve referans görüntüden oluşan 417 üçlü görüntü grubu elde ettiler.

Başlangıçta referans WPose veri setinden türetilen ve yeni makalenin araştırmacıları tarafından kapsamlı bir şekilde düzenlenen iki grup örneği.

Yazarlar, LLaVA Kaynak görselleri tanımlayan metin istemleri oluşturmak için Büyük Dil Modeli (LLM).

Kullanılan metrikler normalden daha kapsamlıydı; normalin yanı sıra Tepe Sinyal-Gürültü Oranı (PSNR), Yapısal Benzerlik Endeksi (SSIM) ve Öğrenilmiş Algısal Görüntü Yama Benzerliği (LPIPS, bu durumda maskeli bölgeleri değerlendirmek için), araştırmacılar benzerlik puanları için DINO'yu kullandılar; RüyaSim üretim sonuçlarının değerlendirilmesi ve CLIP için.

Veriler ve Testler

Çalışmayı test etmek için yazarlar hem varsayılan Stable Diffusion V1.5 modelini hem de 1.5 iç boyama modelini kullandılar. Sistemin görüntü kodlayıcısı CLIP'i kullandı. Vizyon model, projeksiyon katmanlarıyla birlikte – CLIP çıktılarını modelin kullandığı dahili özellik boyutlarına uyacak şekilde yeniden şekillendiren veya hizalayan mütevazı sinir ağları.

Sekiz NVIDIA A30,000 üzerinde 100 yineleme için eğitim gerçekleştirildi† GPU'lar, tarafından denetlenir Ortalama Kare Hatası (MSE) kaybı, Parti boyutu 64 ve bir öğrenme oranı 2 × 10-5Eğitim boyunca çeşitli öğeler rastgele düşürüldü, böylece sistem engellendi. aşırı oturma verilerde.

Veri seti şu şekilde değiştirildi: Parçalardan Bütüne veri kümesi, kendisi temel alınarak DeepFashion-ÇokluModal Veri kümesi.

CompleteMe için düzenlenmiş verilerin geliştirilmesinde kullanılan Parçalardan Bütüne veri setinden örnekler. Kaynak: https://huanngzh.github.io/Parts2Whole/

Yazarlar şunları belirtiyor:

'İhtiyaçlarımızı karşılamak için, insan görünümünün çeşitli yönlerini ve bunların kısa metinsel etiketlerini yakalayan çoklu referans görüntüleri içeren örtülü görüntüleri kullanarak eğitim çiftlerini [yeniden oluşturduk].

'Eğitim verilerimizdeki her örnek altı görünüm türünü içerir: üst vücut kıyafetleri, alt vücut kıyafetleri, tüm vücut kıyafetleri, saç veya başlık, yüz ve ayakkabılar. Maskeleme stratejisi için, 50 ila 1 kez arasında %30 rastgele ızgara maskeleme uygularız, diğer %50 için ise maskeleme karmaşıklığını artırmak için insan vücudu şekilli bir maske kullanırız.

'İnşaat boru hattının tamamlanmasının ardından eğitim için 40,000 adet görüntü çifti elde ettik.'

Rakip önceki referans dışı test edilen yöntemler Büyük örtülü insan görüntüsü tamamlama (LOHC) ve tak-çalıştır görüntü boyama modeli FırçaNet; test edilen referans tabanlı modeller Örnekle Boyama; Herhangi bir kapı; SolYeniden Doldurma; Ve Taklit Fırçası.

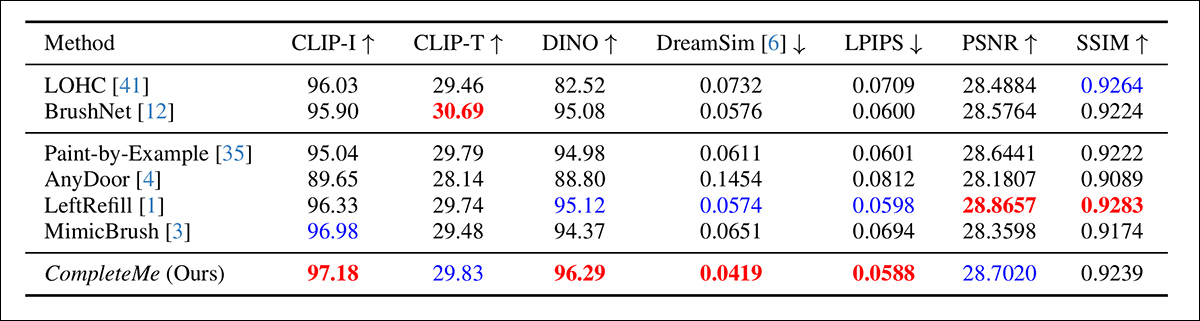

Yazarlar daha önce belirtilen ölçütler üzerinde niceliksel bir karşılaştırmayla başladılar:

İlk nicel karşılaştırmanın sonuçları.

Yazarlar, nicel değerlendirmeye ilişkin olarak, CompleteMe'nin çıktı ile referans görüntü arasındaki anlamsal uyumu ve görünüm doğruluğunu yakalamayı amaçlayan CLIP-I, DINO, DreamSim ve LPIPS dahil olmak üzere çoğu algısal metrikte en yüksek puanları elde ettiğini belirtmektedir.

Ancak, model tüm temel çizgileri genel olarak geride bırakmıyor. Özellikle, BrushNet CLIP-T'de en yüksek puanı alıyor, LeftRefill SSIM ve PSNR'de önde gidiyor ve MimicBrush CLIP-I'de biraz geride kalıyor.

CompleteMe genel olarak tutarlı bir şekilde güçlü sonuçlar gösterse de, bazı durumlarda performans farkları mütevazıdır ve belirli metrikler rekabet eden önceki yöntemler tarafından yönetilmeye devam etmektedir. Belki de haksız bir şekilde değil, yazarlar bu sonuçları CompleteMe'nin hem yapısal hem de algısal boyutlarda dengeli gücünün kanıtı olarak çerçevelendiriyorlar.

Çalışma için yapılan nitel testlere ait çizimler burada yeniden üretilemeyecek kadar çoktur ve okuyucuyu yalnızca kaynak makaleye değil, aynı zamanda kapsamlı ek PDFİçerisinde çok sayıda nitel ek örnekler barındıran.

Bu makalede daha önce tanıtılan tamamlayıcı görüntü havuzundan alınan ek vaka örneklerinin yanı sıra, ana makalede sunulan birincil nitel örnekleri vurguluyoruz:

Ana makalede sunulan ilk nitel sonuçlar. Daha iyi çözünürlük için lütfen kaynak makaleye bakın.

Yukarıda gösterilen nitel sonuçlar hakkında yazarlar şu yorumu yapmaktadır:

'Maskelenmiş girdiler verildiğinde, bu referans dışı yöntemler, görüntü ön bilgilerini veya metin istemlerini kullanarak maskelenmiş bölgeler için makul içerik üretir.

'Ancak, Kırmızı kutuda belirtildiği gibi, aynı bilgilerin yeniden oluşturulmasına rehberlik edecek referans görsellerden yoksun oldukları için dövmeler veya benzersiz giyim desenleri gibi belirli ayrıntıları yeniden üretemezler.'

Aşağıda bir kısmı gösterilen ikinci bir karşılaştırma, Paint-by-Example, AnyDoor, LeftRefill ve MimicBrush olmak üzere dört referans tabanlı yönteme odaklanır. Burada yalnızca bir referans resmi ve bir metin istemi sağlanmıştır.

Referans tabanlı yöntemlerle nitel karşılaştırma. CompleteMe daha gerçekçi tamamlamalar üretir ve referans görüntüden belirli ayrıntıları daha iyi korur. Kırmızı kutular belirli ilgi alanlarını vurgular.

Yazarlar şunları belirtiyor:

'Maskelenmiş bir insan görüntüsü ve bir referans görüntü verildiğinde, diğer yöntemler makul içerik üretebilir ancak çoğu zaman referans görüntüden gelen bağlamsal bilgileri doğru bir şekilde korumada başarısız olur.

'Bazı durumlarda, alakasız içerikler üretiyorlar veya referans görüntüden ilgili kısımları yanlış bir şekilde eşliyorlar. Buna karşılık, CompleteMe, aynı bilgileri doğru bir şekilde koruyarak ve insan vücudunun ilgili kısımlarını referans görüntüden doğru bir şekilde eşleyerek maskelenmiş bölgeyi etkili bir şekilde tamamlıyor.'

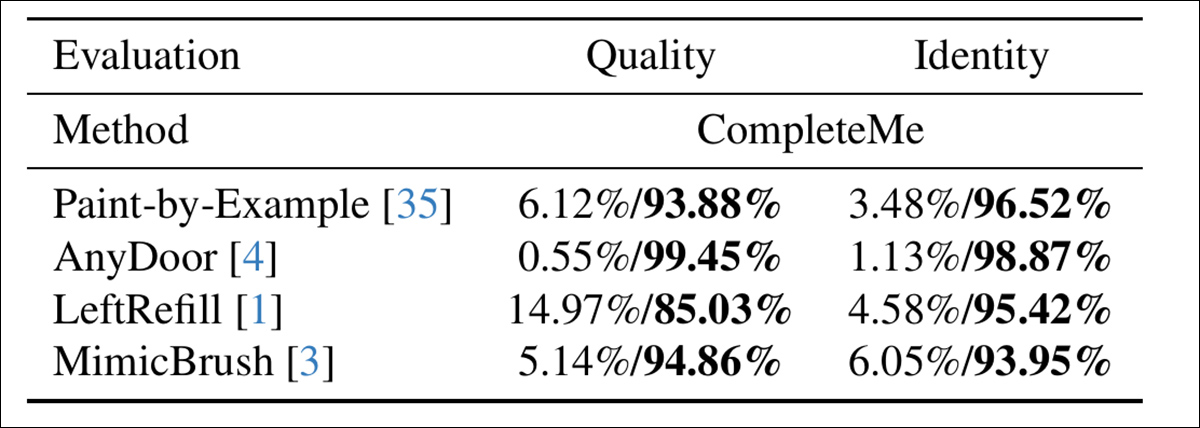

Modellerin insan algısıyla ne kadar iyi uyumlu olduğunu değerlendirmek için yazarlar, 15 açıklayıcı ve 2,895 örnek çifti içeren bir kullanıcı çalışması yürüttüler. Her çift, CompleteMe'nin çıktısını dört referans tabanlı temel çizgiden biriyle karşılaştırdı: Paint-by-Example, AnyDoor, LeftRefill veya MimicBrush.

Açıklayıcılar her sonucu, tamamlanan bölgenin görsel kalitesine ve referanstan gelen kimlik özelliklerini ne ölçüde koruduğuna göre değerlendirdi ve burada, genel kaliteyi ve kimliği değerlendiren CompleteMe daha kesin bir sonuç elde etti:

Kullanıcı çalışmasının sonuçları.

Sonuç

Bu çalışmadaki nitel sonuçlar, çok sayıda olması nedeniyle zayıflıyor; çünkü yakından yapılan inceleme, yeni sistemin, nöral görüntü düzenleme gibi nispeten dar bir alanda yer alan ancak ilgiyle takip edilen bu alanda en etkili giriş olduğunu gösteriyor.

Ancak, sistemin referans materyalini örtülü alana (neredeyse tüm durumlarda) önceki yöntemlere kıyasla ne kadar iyi uyarladığını takdir etmek için orijinal PDF'e biraz daha fazla özen gösterilmesi ve yakınlaştırılması gerekiyor.

Okuyucuya, ek materyalde sunulan başlangıçta kafa karıştırıcı, hatta bunaltıcı sonuç çığını dikkatlice incelemesini şiddetle tavsiye ediyoruz.

* Artık ciddi anlamda eskimiş olan V1.5 sürümünün araştırmacıların favorisi olmaya devam etmesi ilginçtir; kısmen eski benzer testlerden dolayı, ama aynı zamanda tüm Kararlı Difüzyon yinelemelerinin en az sansürlü ve muhtemelen en kolay eğitilebilir olanı olması ve kınayan topallama FOSS Flux sürümlerinin.

† VRAM özelliği belirtilmemiş - kart başına 40 GB veya 80 GB olması gerekiyor.

İlk yayın tarihi Salı, 29 Nisan 2025