Yapay Zeka

LoReFT: Dil Modelleri için Temsil İnce Ayarı

Parametre açısından verimli ince ayar veya PeFT yöntemleri, büyük dil modellerini güncellemeler yoluyla az sayıda ağırlığa uyarlamayı amaçlamaktadır. Bununla birlikte, mevcut yorumlanabilirlik çalışmalarının çoğunluğu, temsillerin anlamsal açıdan zengin bilgileri kodladığını gösterdi ve bu temsilleri düzenlemenin daha iyi ve daha güçlü bir alternatif olabileceğini öne sürdü. Önceden eğitilmiş büyük modeller genellikle yeni alanlar veya görevler için kullanılmak üzere ince ayar yapılır ve ince ayar süreci sırasında, tek bir temel model, yalnızca küçük miktarda alan içi veri mevcut olsa bile çok çeşitli görevlere uyarlanabilir. modele. Bununla birlikte, bir modelin tamamında ince ayar yapma süreci, özellikle çok daha yüksek sayıda boyut ve parametreye sahip dil modelleri için kaynak tüketir ve pahalıdır.

Parametre açısından verimli ince ayar veya PeFT yöntemleri, mevcut toplam ağırlıkların yalnızca küçük bir kısmını güncelleyerek tüm modelde ince ayar yapılmasıyla ilişkili yüksek maliyetlerin üstesinden gelmeyi önerir; bu süreç, bellek kullanımıyla birlikte eğitim süresinin de azaltılmasına yardımcı olur. Daha da önemlisi, Parametre açısından verimli ince ayar veya PeFT yöntemlerinin, çeşitli pratik ayarlarda ince ayara benzer performans göstermiş olmasıdır. Parametre açısından verimli ince ayar veya PeFT yöntemlerinin ortak bir ailesi olan adaptörler, donmuş temel modelin yanında çalışan ek ağırlık setine eklenebilecek bir düzenlemeyi öğrenir; LoRA gibi yeni adaptörler, öğrenilenlerdeki eğitilebilir parametrelerin sayısını azaltır. Bağdaştırıcıları eğitirken tam ağırlıklı matrisler yerine düşük dereceli yaklaşımlar kullanarak ağırlık güncellemelerini yapın.

Gösterimleri düzenlemeyi gösteren önceki çalışmalar, Parametre verimli ince ayar veya PeFT yöntemlerine daha iyi bir alternatif olabilir; bu makalede, donmuş bir model üzerinde çalışan Temsil İnce Ayarı veya ReFT yöntemlerinden bahsedeceğiz ve göreve özel bilgi edineceğiz. Gizli temsillere müdahaleler. Bu makale, ReFt veya Temsil İnce Ayar çerçevesini derinlemesine ele almayı amaçlamaktadır ve çerçevenin mekanizmasını, metodolojisini, mimarisini ve bunun en son teknoloji çerçevelerle karşılaştırmasını araştırıyoruz. Öyleyse başlayalım.

ReFT: Dil Modelleri için Temsil İnce Ayarı

Önceden eğitilmiş dil modellerini yeni alanlara ve görevlere uyarlama girişiminde, mevcut çerçeveler, uygulanan ince ayar sürecinde olduğu gibi bu önceden eğitilmiş dil modellerine sıklıkla ince ayar yapar; tek bir temel model, çeşitli görevlere bile uyarlanabilir. az miktarda alan içi veriyle çalışırken. İnce ayar işlemi genel performansı artırsa da, özellikle dil modeli önemli ölçüde yüksek sayıda parametreye sahipse pahalı bir işlemdir. Bu sorunun üstesinden gelmek ve ilgili maliyetleri azaltmak için PeFT veya Parametre açısından verimli ince ayar çerçeveleri toplam ağırlıkların yalnızca küçük bir kısmını günceller; bu süreç yalnızca eğitim süresini azaltmakla kalmaz, aynı zamanda bellek kullanımını da azaltarak PeFT çerçevelerinin pratik senaryolardaki tam ince ayar yaklaşımlarıyla karşılaştırıldığında benzer performans elde etmesine olanak tanır. Yaygın bir PeFT ailesi olan adaptörler, donmuş ağırlıklara sahip temel modelle uyum içinde çalışan bir ağırlık alt kümesinin yanı sıra ek bir ağırlık kümesine eklenebilecek bir düzenlemeyi öğrenerek çalışır. Son adaptör çerçeveleri gibi LoRA ve QLoRA Performansı etkilemeden azaltılmış duyarlıklı modellerin üzerinde tam duyarlıklı bağdaştırıcıları eğitmenin mümkün olduğunu gösterdik. Adaptörler genellikle yeni model bileşenleri sunan diğer yöntemlerle karşılaştırıldığında daha verimli ve etkilidir.

Mevcut son teknoloji Parametre verimli ince ayar çerçevelerinin önemli bir özelliği, gösterimleri değiştirmek yerine ağırlıkları değiştirmeleridir. Bununla birlikte, yorumlanabilirlik ile ilgilenen çerçeveler, temsillerin zengin anlamsal bilgileri kodladığını göstermiştir; bu da, temsil düzenlemenin, ağırlık güncellemeleriyle karşılaştırıldığında daha iyi ve daha güçlü bir yaklaşım olabileceğini düşündürmektedir. Gösterim düzenlemenin daha iyi bir yaklaşım olduğu varsayımı, model ağırlıklarını uyarlamak yerine müdahaleleri eğiten ve model davranışlarını yönlendirme girişiminde modelin tüm temsillerin küçük bir kısmını manipüle etmesine olanak tanıyan ReFT veya Temsil İnce Ayarlama çerçevesinin temelini oluşturan şeydir. çıkarım sırasında aşağı yönlü görevleri çözmek için. ReFT veya Temsil İnce ayar yöntemleri, ağırlığa dayalı PeFT veya Parametre açısından verimli ince ayar çerçeveleri için anında değiştirmelerdir. ReFT yaklaşımı, sadık nedensel mekanizmaları bulmak için temsillere müdahale eden ve çıkarım sırasında modelin davranışını yönlendiren geniş model yorumlanabilirliğiyle çalışan son modellerden ilham alır ve bu nedenle temsil-düzenleme modellerinin bir genellemesi olarak görülebilir. Aynı temele dayanan LoReFT veya Düşük Sıralı Alt Uzay ReFT, ReFT'nin güçlü ve etkili bir örneğidir ve düşük dereceli projeksiyon matrisi tarafından yayılan doğrusal uzaydaki gizli temsillere müdahale eden ve doğrudan DAS üzerine inşa edilen ReFT'nin bir parametreleştirmesidir. veya Dağıtılmış Hizalama Arama çerçevesi.

PeFT veya Parametre verimli ince ayar çerçevesi, tam ince ayarın aksine, modelin parametrelerinin yalnızca küçük bir kısmını eğitir ve modeli alt görevlere uyarlamayı başarır. Parametre açısından verimli ince ayar çerçevesi üç ana kategoriye ayrılabilir:

- Bağdaştırıcı tabanlı yöntemler: Bağdaştırıcı tabanlı yöntemler, donmuş ağırlıklarla önceden eğitilmiş modelin üzerine tam bağlı katmanlar gibi ek modülleri eğitir. Seri bağdaştırıcılar, çok katmanlı algılayıcı veya MLP ile LM veya büyük model dikkat katmanları arasına bileşenler eklerken paralel bağdaştırıcılar, mevcut bileşenlerin yanına modüller ekler. Adaptörler mevcut model ağırlıklarına kolayca katlanamayan yeni bileşenler eklediğinden çıkarım sırasında ek yük oluşturur.

- - LoRA: LoRA ve en yeni çeşitleri, düşük dereceli matrisler kullanarak eğitim sırasındaki toplam ağırlıkları yaklaşık olarak tahmin eder ve ağırlık güncellemeleri modelle birleştirilebildiğinden çıkarım sırasında ek yük gerektirmezler ve bu da bunların mevcut olarak kabul edilmesinin nedenidir. en güçlü PeFT çerçeveleri.

- İsteme dayalı yöntemler: İsteme dayalı yöntemler, girdiye rastgele başlatılan yazılım belirteçleri ekler ve dil modelinin ağırlıklarını dondurarak bunların yerleştirmelerini eğitir. Bu yöntemlerin sunduğu performans, diğer PeFT yaklaşımlarıyla karşılaştırıldığında genellikle tatmin edici değildir ve aynı zamanda önemli bir çıkarım maliyeti de taşırlar.

ReFT çerçevesi, ağırlıkları güncellemek yerine toplam temsillerin küçük bir kısmını değiştirmeye yönelik müdahaleleri öğrenir. Ayrıca, temsil mühendisliği ve aktivasyon yönlendirmesi üzerine yapılan son çalışmalar, artık akışa sabit yönlendirme vektörlerinin eklenmesinin, yoğun kaynak gerektirmeden önceden eğitilmiş büyük model nesilleri üzerinde bir dereceye kadar kontrolü kolaylaştırabileceğini göstermiştir. ince ayar. Diğer çerçeveler, temsillerin öğrenilmiş bir ölçeklendirme ve çeviri işlemiyle düzenlenmesinin, daha az öğrenilmiş parametreye sahip çok çeşitli görevlerde LoRA bağdaştırıcılarının sunduğu performansı yakalamaya çalışabileceğini ancak bu performansı geçemeyeceğini göstermiştir. Ayrıca, bu çerçevelerin bir dizi görevdeki başarısı, önceden eğitilmiş dil modelleri tarafından sunulan temsillerin zengin anlambilim taşıdığını, ancak bu modellerin performansının optimalin altında olduğunu ve PeFT'lerin en son teknoloji yaklaşımı olarak devam etmesine neden olduğunu göstermiştir. hiçbir ek çıkarım yükü olmadan.

ReFT : Metodoloji ve Mimari

Stil koruma sürecini basit tutmak için ReFT çerçevesi, token dizisinin bağlamsallaştırılmış temsilini üretebilen hedef modeli olarak transformatör tabanlı büyük bir modeli varsayar. N sayıda giriş jetonu ile belirli bir dizi için, ReFT çerçevesi ilk önce bu giriş jetonlarını bir temsiller listesine yerleştirir, ardından m katman, önceki gizli temsiller listesinin bir fonksiyonu olarak gizli temsiller listesini art arda hesaplar. Her gizli gösterim bir vektördür ve dil modeli, tahminleri üretmek için son gizli gösterimleri kullanır. ReFT çerçevesi hem maskelenmiş dil modellerini hem de otoregresif dil modellerini dikkate alır. Artık doğrusal temsil hipotezine göre, sinir ağlarında kavramlar, temsillerin doğrusal altuzayları içinde kodlanmaktadır. Son modeller, diğer girdi dağıtımlarıyla birlikte doğal dil üzerinde eğitilmiş sinir ağı modellerinde bu iddianın doğru olduğunu buldu.

Ayrıca, yorumlanabilirlik çalışmalarında, gündelik soyutlama çerçevesi, belirli davranışları uygularken sinir ağı bileşenlerinin rolünü gelişigüzel bir şekilde belirlemek için değişim müdahalelerini kullanır. Değişim müdahalesinin ardındaki mantık, bir temsilin karşı-olgusal bir girdi için ne olacağına sabitlenmesi durumunda ve bu müdahalenin, ReFT çerçevesi tarafından üretimden sorumlu bileşen hakkında öne sürülen iddiaların tutarlı bir şekilde modelin çıktısını etkilemesidir. Bu temsil, o zaman bileşen davranışta nedensel bir rol oynar. Birkaç yöntem olmasına rağmen, doğrusal temsil hipotezinin iddia ettiği gibi, bir kavramın bir temsilin doğrusal alt uzayında kodlanıp kodlanmadığını test etmek için dağıtılmış değişim müdahalesi ideal bir yaklaşımdır. Ayrıca DAS yöntemi daha önce varlık niteliklerinin, duyarlılığın, dilsel özelliklerin ve matematiksel akıl yürütmenin dil modellerinde doğrusal temsilini bulmak için kullanılmıştı. Bununla birlikte, çeşitli deneyler, DAS yönteminin son derece ifade edici olduğunu ve dönüştürücü dil modeli rastgele başlatıldığında bile nedensel etkili alt uzayları bulma yeteneğine sahip olduğunu ve bu nedenle henüz göreve özgü herhangi bir temsili öğrenmediğini göstermiştir. DAS'ın yorumlanabilirlik görevleri için yeterince etkili ve sorumlu olup olmadığını tartışın.

DAS'ın sunduğu ifadesellik, yaklaşımın, kontrol edilebilir üretim ve sorumlu düzenleme konusundaki çalışmalarının yanı sıra dil modelinin davranışını kontrol etmek için ideal bir araç olabileceğini öne sürüyor. Bu nedenle, dil modellerini aşağı akış görevlerine uyarlamak için ReFT çerçevesi, yeni bir parametre verimli yöntem oluşturmak için dağıtılmış değişim müdahale işlemini kullanır. Ayrıca, ReFT yöntemi bir dizi müdahaledir ve çerçeve, aynı katmanda çalışan herhangi iki müdahale için müdahale konumlarının ayrık olması ve tüm müdahale fonksiyonlarının parametrelerinin bağımsız kalması gerektiğini zorunlu kılar. Sonuç olarak ReFT, modelin ileri geçişi sırasında gizli gösterimlere müdahaleleri kapsayan genel bir çerçevedir.

ReFT: Deneyler ve Sonuçlar

Performansını mevcut PEFT çerçevelerine göre değerlendirmek için ReFT çerçevesi, dört farklı doğal dil işleme kriterinde deneyler yürütür ve 20'den fazla veri kümesini kapsar; temel amaç, LoReFT çerçevesinin farklı senaryolarda nasıl performans gösterdiğine dair zengin bir resim sağlamaktır. Ayrıca, LoReFT çerçevesi gerçek hayatta uygulandığında geliştiricilerin, her birinin uygulanacağı giriş konumları ve katmanlarıyla birlikte kaç müdahalenin öğrenileceğine karar vermesi gerekir. Görevi tamamlamak için ReFT çerçevesi dört hiper parametreyi ayarlar.

- Müdahale edilecek önek konumlarının sayısı.

- Müdahale edilecek son ek konumlarının sayısı.

- Hangi katmanlara müdahale edileceği.

- Müdahale parametrelerinin aynı katmandaki farklı konumlara bağlanıp bağlanmayacağı.

Bunu yaparak, ReFT çerçevesi hiperparametre arama alanını basitleştirir ve yalnızca istemin uzunluğuyla ölçeklenmeyen sabit bir ek çıkarım maliyeti sağlar.

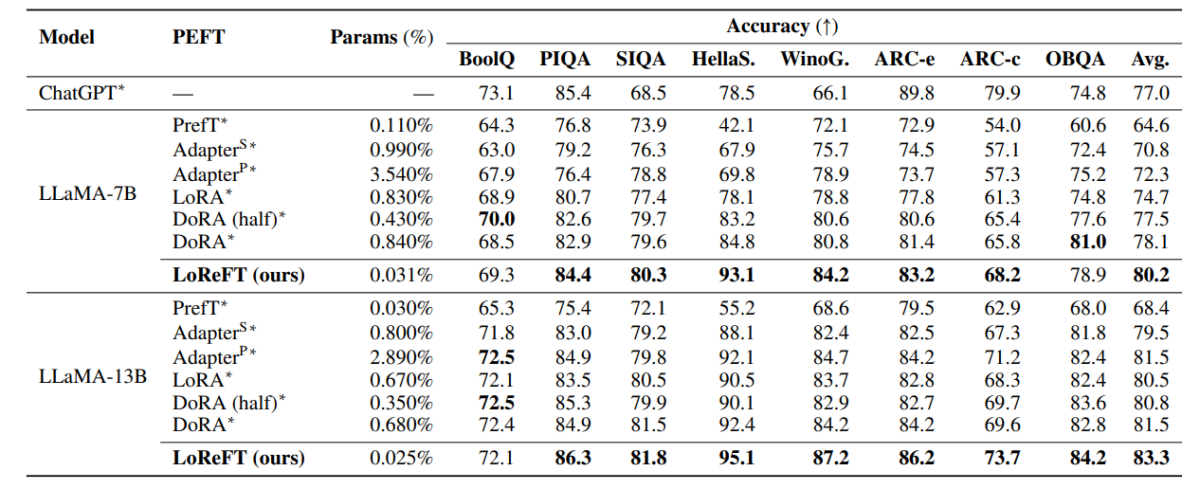

Yukarıdaki tablo, LLaMA-7B ve LLaMA-13B çerçevelerinin doğruluğunu, 8 sağduyulu muhakeme veri kümesinde mevcut PEFT modelleriyle karşılaştırmaktadır. Görülebileceği gibi, LoReFT modeli, çok daha az parametreye sahip olmasına rağmen, mevcut PEFT yaklaşımlarını iyi bir farkla geride bırakıyor; LoReFT modeli için farklı parametre tohumlarıyla üç çalıştırmanın ortalama performansı rapor ediliyor. Param(%), eğitilebilir parametre sayısının temel büyük modelin toplam parametre sayısına bölünmesiyle hesaplanır.

Yukarıdaki tablo, LLaMA-7B ve LLaMA-13B çerçevelerinin 4 farklı aritmetik akıl yürütme veri kümesinde mevcut PEFT modelleriyle doğruluk karşılaştırmasını özetlemektedir; çerçeve, farklı rastgele tohumlarla üç çalıştırmanın ortalama performansını rapor etmektedir. Görülebileceği gibi, çok daha az parametreye (%) sahip olmasına rağmen, LoReFT çerçevesi mevcut PEFT çerçevelerinden önemli ölçüde daha iyi performans göstermektedir.

Yukarıdaki tablo, RoBERTa-base ve RoBERTa-large çerçevelerinin, GLUE kıyaslaması genelinde mevcut PEFT modelleriyle doğruluk karşılaştırmasını özetlemektedir; çerçeve, farklı rastgele tohumlarla beş çalıştırmanın ortalama performansını rapor etmektedir. Görülebileceği gibi, çok daha az parametreye (%) sahip olmasına rağmen, LoReFT çerçevesi mevcut PEFT çerçevelerinden önemli ölçüde daha iyi performans göstermektedir.

Son Düşüncelerimiz

Bu makalede, mevcut PEFT çerçevelerine güçlü bir alternatif olan, dört farklı alandaki kıyaslamalarda güçlü performansa ulaşan ve aynı zamanda önceki son teknoloji PEFT modellerinin sunduğu verimliliğin 50 katına kadar sunan LoReFT'ten bahsettik. Önceden eğitilmiş büyük modellere genellikle yeni alanlar veya görevler için kullanılmak üzere ince ayar yapılır ve ince ayar işlemi sırasında, tek bir temel model, yalnızca az miktarda alan içi veri mevcut olsa bile çok çeşitli görevlere uyarlanabilir. modele. Bununla birlikte, bir modelin tamamında ince ayar yapma süreci, özellikle çok daha yüksek sayıda boyut ve parametreye sahip dil modelleri için kaynak tüketir ve pahalıdır. Parametre açısından verimli ince ayar veya PeFT yöntemleri, mevcut toplam ağırlıkların yalnızca küçük bir kısmını güncelleyerek tüm modelde ince ayar yapılmasıyla ilişkili yüksek maliyetlerin üstesinden gelmeyi önerir; bu süreç, bellek kullanımıyla birlikte eğitim süresinin de azaltılmasına yardımcı olur. Özellikle LoReFT, en güçlü PEFT'lere karşı sağduyulu muhakeme, talimat izleme ve doğal dil anlayışı konusunda yeni ve son teknoloji ürünü bir performans ortaya koyuyor.