Artificiell intelligens

NeRF tar ytterligare ett steg närmare att ersätta CGI

Forskare vid MIT och Google har tagit ett stort steg för att lösa ett av de mest grundläggande hindren för en framväxande AI-driven teknologi som så småningom kan ersätta CGI – separera neural radiance field (NeRF)-bilder i dess visuella komponenter, så att bilderna kan omstruktureras och tänds på nytt.

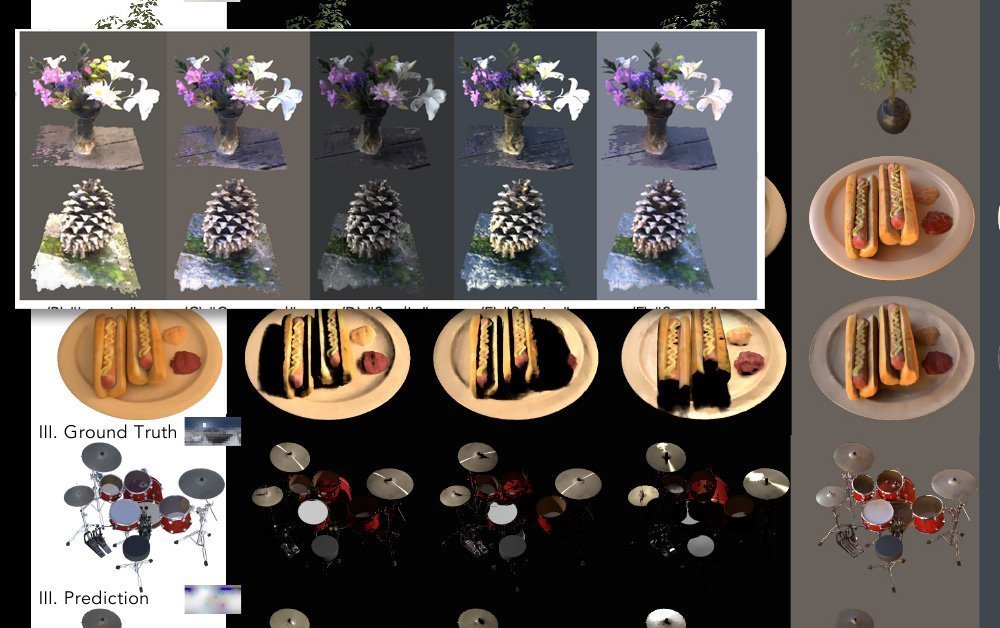

Det nya tillvägagångssättet, kallas NeRFactor, delar effektivt upp tagna bilder i normaler per objekt (till vilka texturer kan tilldelas), ljussynlighet, albedo (andelen infallande ljus som reflekteras bort från en yta) och Bidirectional Reflectance Distribution Functions (BRDF).

Med dessa aspekter isolerade är det möjligt att inte bara byta texturer för enskilda objekt eller objektgrupper, utan också att lägga till nya och unika ljuskällor och skuggimplementeringar, med avdrag för alla som fångades av flerkameror som genererar input för NeRF-bilder.

Normaler, synlighet, albedo och BRDF separerade under NeRFactor. Källa: https://www.youtube.com/watch?v=UUVSPJlwhPg

Modellen stöder mjuka eller hårda skuggor från godtyckliga, användardefinierade ljuskällor och separerar de fyra aspekterna av infångad video programmatiskt, med hjälp av en rekonstruktionsförlust, data från tidigare beräkningar av BRDF och grundläggande enkel jämnhetsregularisering.

NeRFactors arbetsflöde, extraherar separata handlingsbara aspekter av bilder härledda från arrayer med flera kameror. Källa: https://arxiv.org/pdf/2106.01970.pdf

NeRFactor använder en HDR-ljussond, ett väletablerat tillvägagångssätt som har genomsyrat den visuella industri- och konstscenen sedan dess introduktion 1998, för att utvärdera möjliga vägar för strålar, vilket möjliggör godtycklig belysning. Eftersom detta genererar ett okontrollerbart antal möjliga parametrar, filtreras ljussonden genom en multi-layer perceptron (MLP), som kartlägger den upplevda geometrin till sonden utan att försöka beräkna en fullständig ljusvolymkarta för modellutrymmet.

Två neurala strålningsfältmodeller används för att demonstrera fem möjliga belysningsmodeller under NeRFactor. Klicka på bilden för högre upplösning.

Anledning till eftertanke

Den nya forskningen är kanske mest betydelsefull när det gäller att separera lagren av tagna bilder som styr reflektion. Detta är fortfarande en av de största utmaningarna för neurala strålningsfältbilder, eftersom ett verkligt nytt och flexibelt NeRF-system inte bara kommer att behöva kunna ersätta texturer, utan också kommer att behöva något sätt att reflektera rörliga objekt (förutom bara den allmänna fasta miljön) som normalt skulle tas med i ett CGI-arbetsflöde.

Detta problem noterades nyligen med avseende på Intels imponerande ny forskning till att omvandla videospelsmaterial till fotorealistisk video via konvolutionerande neurala nätverk. I sådana arbetsflöden skulle många "bakade" aspekter av källmaterialet behöva bli diskreta och utbytbara, och detta är utan tvekan lättare att lösa för återbelysning (vilket är en funktion av geometrin som återges i NeRF) än för reflektioner (som använder ' off-screen' geometri som ligger helt utanför modellens ram).

Därför tar isolering av lagren i NeRF-video som underlättar reflektion NeRF ett steg närmare att lösa sin "reflektionsutmaning".

Användningen av en HDR-miljö löser redan problemet med att generera världsreflexioner (dvs. himmel, landskap och andra "fasta" omgivningsfaktorer), men nya tillvägagångssätt kommer att behövas för att introducera rörliga och dynamiska reflektioner.

Fotogrammetri med NeRF

Neural Radiance Field-bilder använder maskininlärningsanalys för att utveckla ett helt volymetriskt utrymme från en scen eller ett objekt som har fångats från ett antal vinklar.

Olika NeRF-baserade system som har dykt upp under det senaste året har använt ett varierat antal bidragande kameraenheter; vissa använder 16 eller fler kameror, andra så få som en eller två. I alla fall är de mellanliggande synpunkterna "utfyllda" (dvs tolkade) så att scenen eller objektet kan navigeras smidigt.

Den resulterande enheten är ett helt volymetriskt utrymme, med en inneboende 3D-förståelse som kan utnyttjas på många sätt, inklusive förmågan att generera traditionella CG-nät från den 3D-parsade summan av ingångsbilderna.

NeRF i samband med en "ny CGI"

Neurala strålningsfältbilder är dras direkt från bilder av den verkliga världen, inklusive rörliga bilder av människor, föremål och scener. Däremot "studerar" och tolkar en CGI-metod världen, vilket kräver att kvalificerade arbetare bygger maskor, riggar och texturer som använder verkliga bilder (dvs. ansikts- och miljöbilder). Det förblir ett i grunden tolkande och hantverksmässigt tillvägagångssätt som är dyrt och mödosamt.

Dessutom har CGI haft pågående problem med den "uncanny valley"-effekten i sina ansträngningar att återskapa mänskliga likheter, vilket inte utgör några begränsningar för ett NeRF-drivet tillvägagångssätt, som helt enkelt fångar video eller bilder av riktiga människor och manipulerar det.

Vidare kan NeRF generera traditionell nätgeometri i CGI-stil direkt från foton vid behov och i praktiken ersätta många av de manuella procedurer som alltid har varit nödvändiga i datorgenererade bilder.

Utmaningar för NeRF

Den här senaste forskningen från MIT och Google kommer i samband med en veritabel flod av NeRF-papper under det senaste året, av vilka många har erbjudit lösningar på de olika utmaningarna som det första 2020-dokumentet gav upphov till.

I april gav innovation från ett kinesiskt forskningskonsortium ett sätt att diskret isolera de individuella tidslinjerna för fasetter i en NeRF-scen, inklusive människor.

Den kinesiska forskningen tillåter slutanvändare att kopiera, klistra in och ändra storlek på fångade element, och ta bort dem från den linjära tidslinjen för den ursprungliga källvideon. Källa: https://www.youtube.com/watch?v=Wp4HfOwFGP4

Detta tillvägagångssätt möjliggör inte bara att ombilda scenen från vilken vinkel som helst som fångas av kamerauppsättningen (och inte bara den enda vy som representeras i en typisk videoinspelning), utan möjliggör också mångsidig kompositering – och till och med möjligheten att representera två aspekter från samma filmer som körs inom sina egna individuella tidsramar (eller till och med går baklänges, vid behov).

Den kinesiska forskningen tillåter slutanvändare att kopiera, klistra in och ändra storlek på fångade element, och ta bort dem från den linjära tidslinjen för den ursprungliga källvideon. Källa: https://www.youtube.com/watch?v=Wp4HfOwFGP4

En av de största utmaningarna för NeRF är att sänka de avsevärda resurser som behövs för att träna en scen, och detta har tagits upp i ett antal nya tidningar. Till exempel introducerades nyligen Max Planck Institute for Intelligent Systems KiloNeRF, som inte bara snabbar upp renderingstiderna med en faktor 1000, utan även gör det möjligt för NeRF att fungera interaktivt.

KiloNeRF kör en interaktiv miljö med 50 fps på en GTX 1080ti. Källa: https://github.com/creiser/kilonerf

Men NeRF-hastighetsinnovationen som verkligen fångade både forskares och allmänhetens fantasi 2021 har varit PlenOctrees samarbete, ledd av UC Berkeley, som erbjuder realtidsrendering av Neural Radiance Fields:

Effekten av PlenOctrees interaktiva funktioner har återgivits i en live, webbaserat gränssnitt.

Live interaktiv rörelse av ett PlenOctrees-objekt i Firefox (rörelsen är smidigare och mer dynamisk än vad denna GIF representerar). Källa: http://alexyu.net/plenoctrees/demo/

Dessutom används Rekursiv-NeRF (från en uppsats från maj 2021 av forskare vid Tsinghua University) erbjuder högkvalitativ rekursiv rendering på begäran. Istället för att tvinga användaren att återge hela scener, inklusive delar som kanske inte syns, tillhandahåller Recursive-NeRF något som liknar JPEG:s förlustkompression och kan generera diskreta sub-NeRF:er för att hantera extra bilder på begäran – vilket ger en enorm besparing i beräkningsresurser .

Behåller detaljer samtidigt som man dumpar onödiga renderingsberäkningar med Rekursiv-NeRF. Klicka på bilden för högre upplösning. Källa: https://arxiv.org/pdf/2105.09103.pdf

Andra tillvägagångssätt inkluderar FastNeRF, som påstår sig uppnå neural rendering med hög kvalitet vid 200 fps.

Det har noterats att många av optimeringsteknikerna för NeRF involverar "bakar" scenen, genom att engagera sig i aspekter som önskas återges och förkasta andra aspekter, vilket begränsar utforskningen men avsevärt påskyndar interaktiviteten.

Nackdelen med detta är att stressen flyttas från GPU:n till lagringen, eftersom bakade scener tar upp orimligt mycket diskutrymme; i viss mån kan detta mildras genom att nedsampla de bakade data, även om detta också innebär ett visst engagemang, när det gäller att stänga av vägar för utforskning eller interaktivitet.

När det gäller motion capture och riggning, ett nytt tillvägagångssätt från universiteten i Zheijang och Cornell, avslöjades i maj, erbjöd en metod för att återskapa animerbara människor med hjälp av blandade viktfält och skelettstrukturer tolkade från ingångsvideo:

Härledd skelettstruktur i Animatable NeRF. Källa: https://www.youtube.com/watch?v=eWOSWbmfJo4

När kommer NeRF att ha sitt "Jurassic Park"-ögonblick?

Trots den snabba framstegen med bildsyntes via neurala strålningsfält, är det först under denna period som någon form av "termodynamikens lag" kommer att etableras för hur utplacerbar NeRF kan bli. När det gäller en tidslinje analog med CGI:s historia, svävar NeRF för närvarande runt 1973, strax före första användningen av CGI i Westworld.

Det betyder inte att NeRF nödvändigtvis behöver vänta nio år på sin motsvarighet Khans vrede milstolpe, eller årtionden för liknande genombrott som CGI uppnådde under James Camerons entusiastiska beskydd på 1989-talet The Abyss eller 1991-talet Terminator 2 – och sedan är tekniken verkligen revolutionerande breakout ögonblick under 1993-talet Jurassic Park.

Bildscenen har förändrats mycket sedan den långa stagnationsperioden för fotokemiska visuella effekter, som dominerade film- och tv-produktion från biografens födelse till tidigt 1990-tal. Tillkomsten av PC-revolutionen och accelerationen av Moores lag ledde till CGI-revolutionen, som annars kunde tänkas ha ägt rum redan på 1960-talet.

Det återstår att se om det finns någon barriär som är så oförsonlig att den skulle kunna hålla uppe NeRFs framsteg så länge – och om efterföljande innovationer inom datorseende kanske inte under tiden helt överträffar NeRF som den viktigaste utmanaren för CGI:s krona, som kännetecknar neurala strålningsfält som den kortlivade "faxmaskinen" för neural bildsyntes.

Än så länge har NeRF inte använts i något sammanhang utanför akademisk forskning; men det är anmärkningsvärt att stora aktörer som Google Research och många av de mest framstående forskningslabben för datorseende tävlar om det senaste NeRF-genombrottet.

Många av NeRFs största hinder har börjat åtgärdas direkt i år; om efterföljande forskning erbjuder en lösning på "reflektionsfrågan", och de många delarna av NeRF-optimerande forskning smälter samman till en avgörande lösning på teknikens betydande bearbetnings- och/eller lagringskrav, har NeRF verkligen en chans att bli "den nya CGI:n" ' under de kommande fem åren.